Act 25. 主成分分析(PCA)について学ぶ

はじめに

Act 01. AIで外国為替を自動売買するまでの道のりをベースに学習を進めて行く。

前回は教師なし学習のk平均法について勉強した。

今回は、同じ教師なし学習の主成分分析(PCA)について学習していく。

今後学習する内容は以下の通り。

学習はChatGTPさん考案の以下の順序で進めて行く。

学習順序

教師あり学習

- 線形回帰: 基本的な回帰問題を学ぶ。 2024/11/13 学習済み

- ロジスティック回帰: 分類問題の基本を理解する。 2024/11/17 学習済み

- 決定木: シンプルで直感的なモデル。 2024/11/20 学習済み

- ランダムフォレスト: 決定木のアンサンブル学習。 2024/11/22 学習済み

教師なし学習

- k平均法: クラスタリングの基本。 2024/11/24 学習済み

- 主成分分析(PCA): 次元削減の手法。

強化学習

- 基本的な概念: エージェント、環境、報酬の関係を理解する。

-

Q学習: 簡単な強化学習アルゴリズム。

※強化学習は重要だと判断したため、概念から再度学習する。

この記事で主成分分析について学習して、次の記事でpythonを使って主成分分析の実装を行う。

それが終わったらついに強化学習だー!

早くこの記事を書き終えたい気持ちが強いけど、きっと主成分分析は役に立つ内容だと思うので、自分のためにもしっかりと学習していく。

主成分分析

ChatGPTさんの回答

いつものごとく、ChatGTPさんにどんな物なのか聞いてみた。

以下はその回答。

主成分分析(PCA, Principal Component Analysis)は、次元削減のための統計的手法です。データの情報をなるべく失わずに、少ない次元で表現することを目的としています。以下にPCAについて詳細に説明します。

PCAの目的

- 高次元データ(例:特徴量が多いデータ)を、より少ない次元に圧縮する。

- データの変動(情報)を最大限保持する。

これにより、計算効率が向上し、データの可視化が容易になります。また、ノイズを減らす効果もあります。

PCAの基本的な流れ

-

データの標準化

-

データを標準化(平均0、分散1)します。

ここで、

は平均、 は標準偏差です。

-

-

共分散行列の計算

データの分布を把握するため、共分散行列を計算します。共分散行列は次のように定義されます:ここで、

はデータ行列(各行がデータサンプル、各列が特徴量)、 は共分散行列です。 -

固有値と固有ベクトルの計算

共分散行列の固有値と固有ベクトルを計算します。- 固有ベクトルはデータの主成分を表します。

- 固有値は主成分の「重要度」(分散の大きさ)を表します。

-

次元削減

固有値が大きい順に固有ベクトルを選びます。その選ばれた固有ベクトルにデータを射影することで、次元を削減します。次元削減後のデータは次のように計算されます:ここで、

は選ばれた固有ベクトルを列に持つ行列です。

数式の詳細な説明

1. 共分散行列

共分散行列の各要素

-

は特徴量 の平均値。 - 共分散が大きいほど、2つの特徴量が互いに強い線形関係を持つことを意味します。

2. 固有値と固有ベクトル

共分散行列

- 固有値

は、対応する固有ベクトルがデータの分散をどれだけ説明できるかを示します。 - 固有ベクトルは次元削減後の新しい軸(主成分)を表します。

3. 次元削減の射影

選ばれた

ここで、

具体例

例えば、2次元データを1次元に圧縮する場合:

- データを標準化する。

- 共分散行列を計算し、2×2の行列を得る。

- 固有値と固有ベクトルを求める。

- 大きい固有値に対応する固有ベクトルを選び、データをその方向に射影する。

PCAのポイント

- 主成分は「データの分散を最大化する方向」を表します。

- データの次元を削減しながら、情報(分散)の多くを保持します。

- PCAは線形変換に基づいており、非線形な関係を扱いたい場合は「カーネルPCA」が必要になります。

応用例

- データの前処理(特徴量削減、ノイズ除去)。

- データの可視化(2次元または3次元にプロット)。

- モデルの学習効率向上(高次元データの計算負荷を軽減)。

自分なりに解説

ChatGTPさんの回答のPCAの目的に記載されている以下の内容について。

個人的に、これはめちゃくちゃ重要な内容なのでは?と読んでいて思った。

- 高次元データ(例:特徴量が多いデータ)を、より少ない次元に圧縮する。

- データの変動(情報)を最大限保持する。

今後、FXの相場予想をするAIを作りたいわけだが、特徴量がどのくらいになるかあまり想像できていない。

もしかしたら

データが多いということは、分析や学習に時間がかかってしまうため、インフラリソースのコストもその分増えると考えている。

次元削減の流れ、絶対に身に着けよう!

ということで、ChatGTPさんの回答について補足を加えながら記載していこうと思う。

以降は以下のデータを使って説明していくので良しなに。

| データ番号 | 身長 (cm) | 体重 (kg) |

|---|---|---|

| 1 | 155 | 48 |

| 2 | 162 | 55 |

| 3 | 168 | 67 |

| 4 | 174 | 72 |

| 5 | 185 | 85 |

1. データの標準化

まず初めに、データの標準化を行う。

なぜデータの標準化を行うのかというと、それぞれの特徴量の単位やスケールの違いを調整するため。

単位やスケールの違いとは、例えば 体重(kg)や 身長(cm)、髪の毛の本数(本)など。

表にしてみると以下のようなイメージ。

| 名前 | 体重(kg) | 身長(cm) | 髪の毛の本数(本) |

|---|---|---|---|

| 田中 | 60 | 160 | 100,000,000 |

| 佐藤 | 100 | 190 | 80,000,000 |

| 高橋 | 40 | 140 | 130,000,000 |

恐らくだが、標準化せずにこのデータで次元を削減しようとすると、"髪の毛の本数"の影響をかなり受けることになると思う。

そのため、それぞれの値に対して標準化を行うことで調整を行おうというわけだ。

標準化の公式については以下の通り。

-

: 標準化後のデータ -

: 元のデータ -

: 平均値 -

: 標準偏差

標準偏差については以前やったが、少し頭から抜けていたので再度学習することに決定!

そもそも標準偏差とは?

標準偏差はデータが平均値からどの程度離れているか、つまり、データのバラつきを表す指標となる。

値が小さいほど平均値に近い位置に集まっており、値が大きいほど平均値から広がっていることを意味する。

最初に記載した下記のデータを使って、標準化を行うまでの流れを記載していく。

| データ番号 | 身長 (cm) | 体重 (kg) |

|---|---|---|

| 1 | 155 | 48 |

| 2 | 162 | 55 |

| 3 | 168 | 67 |

| 4 | 174 | 72 |

| 5 | 185 | 85 |

1. 平均を求める

まずは平均を求める。

-

身長

-

体重

同じ方程式なので途中は省略する。

平均を含めると以下のような感じになる。

| データ番号 | 身長 (cm) | 体重 (kg) |

|---|---|---|

| 1 | 155 | 48 |

| 2 | 162 | 55 |

| 3 | 168 | 67 |

| 4 | 174 | 72 |

| 5 | 185 | 85 |

|

|

168.8 | 65.4 |

2. 平均との誤差(偏差)を計算

各データに対してデータと平均の差である偏差を求める。

これに関してはただ引き算を行うだけ。

| データ番号 | 身長 (cm) | 体重 (kg) | 身長の偏差 | 体重の偏差 |

|---|---|---|---|---|

| 1 | 155 | 48 | -13.8 | -17.4 |

| 2 | 162 | 55 | -6.8 | -10.4 |

| 3 | 168 | 67 | -0.8 | 1.6 |

| 4 | 174 | 72 | 5.2 | 6.6 |

| 5 | 185 | 85 | 16.2 | 19.6 |

|

|

168.8 | 65.4 | - | - |

3. 偏差の二乗を求める

偏差でマイナスになっているものがあるので、二乗することで全て正の値にする。

| データ番号 | 身長 (cm) | 体重 (kg) | 身長の偏差の二乗 | 体重の偏差の二乗 |

|---|---|---|---|---|

| 1 | 155 | 48 | 190.44 | 302.76 |

| 2 | 162 | 55 | 46.24 | 108.16 |

| 3 | 168 | 67 | 0.64 | 2.56 |

| 4 | 174 | 72 | 27.04 | 43.56 |

| 5 | 185 | 85 | 262.44 | 384.16 |

|

|

168.8 | 65.4 | - | - |

4. 偏差の二乗の平均を求める(分散)

偏差の二乗が求められたのでそれの平均を求める。

ちなみに、3 ~ 5 の手順を数式にすると以下の通り。

偏差の二乗の平均値を追加すると以下になる。

| データ番号 | 身長 (cm) | 体重 (kg) | 身長の偏差の二乗 | 体重の偏差の二乗 |

|---|---|---|---|---|

| 1 | 155 | 48 | 190.44 | 302.76 |

| 2 | 162 | 55 | 46.24 | 108.16 |

| 3 | 168 | 67 | 0.64 | 2.56 |

| 4 | 174 | 72 | 27.04 | 43.56 |

| 5 | 185 | 85 | 262.44 | 384.16 |

|

|

168.8 | 65.4 | 105.36 | 168.24 |

5. 分散の平方根を取る(標準偏差)

偏差を二乗した値の平方根を取る。

ここまでの全てを数式にすると以下の通り。

それぞれの標準偏差を求める。

算出した平均と標準偏差を表に追加する。

| データ番号 | 身長 (cm) | 体重 (kg) |

|---|---|---|

| 1 | 155 | 48 |

| 2 | 162 | 55 |

| 3 | 168 | 67 |

| 4 | 174 | 72 |

| 5 | 185 | 85 |

|

|

168.8 | 65.4 |

|

|

10.26 | 12.97 |

6. 標準化を行う

1 ~ 5 までの流れで

ということで次は各パラメータを標準化していこうと思う。

標準化の公式を再度載せておく。

ここまで学んできた我らに怖いものはない。

それぞれのデータを標準化すると以下のようになる。

全ての値が

| データ番号 | 身長 (cm) | 体重 (kg) | 身長の標準化 | 体重の標準化 |

|---|---|---|---|---|

| 1 | 155 | 48 | -1.34 | -1.34 |

| 2 | 162 | 55 | -0.66 | -0.8 |

| 3 | 168 | 67 | -0.08 | 0.12 |

| 4 | 174 | 72 | 0.5 | 0.51 |

| 5 | 185 | 85 | 1.58 | 1.51 |

|

|

168.8 | 65.4 | 0 | 0 |

|

|

10.26 | 12.97 | 1 | 1 |

補足だが、標準化を行ったデータの平均値は

ここまでで、まず一つ目のステップである標準化が完了した。

長くなってしまったが、重要だからきちんと解説するということで…。

後

2. 共分散行列の計算

続いてが共分散行列(Covariance Matrix)について。

共分散行列とは、データセットの異なる特徴量間の関係(相関)を表すための行列。

今回例として使っているデータセットの場合は、身長と体重の相関を表している行列になる。

主成分分析(PCA)では、この共分散行列を使ってデータの分散や相関関係を分析し、主成分を見つけるらしい。

共分散とは

そもそも共分散って何ぞや!となったので調べた。

共分散(Covariance) は、二つの特徴量がどの程度一緒に変動するかを示す値とのこと。

2つの特徴量

それぞれの記号については以下の通り。

-

: それぞれの特徴量(身長や体重) -

: それぞれの特徴量の平均値 -

: データ総数

と言うことで先ほど標準化した以下のデータで計算してみる。

| データ番号 | 身長 (cm) | 体重 (kg) | 身長の標準化 | 体重の標準化 |

|---|---|---|---|---|

| 1 | 155 | 48 | -1.34 | -1.34 |

| 2 | 162 | 55 | -0.66 | -0.8 |

| 3 | 168 | 67 | -0.08 | 0.12 |

| 4 | 174 | 72 | 0.5 | 0.51 |

| 5 | 185 | 85 | 1.58 | 1.51 |

|

|

168.8 | 65.4 | 0 | 0 |

|

|

10.26 | 12.97 | 1 | 1 |

標準化したデータの平均値は

と言うことで身長と体重の共分散は

この結果が何を表すのかというとこんな感じ。

-

: 2つの変数は同じ方向に変動する -

: 2つの変数は逆方向に変動する -

: 2つの変数が無関係(直線的な関係がない)

つまり、体重と身長は同じ方向に変動すると言うことがわかり、実際その結果は正しい。

ここまでが共分散。

共分散行列とは

次に共分散行列(Covariance Matrix) について。

共分散行列は、データセットが複数の特徴量を持つ場合、すべての特徴量の共分散を計算して行列として表したもの。

まずは共分散の公式についておさらい。

これを脳裏に焼き付けておく。

焼き付けたところで共分散行列の定義について紹介する。

データセット

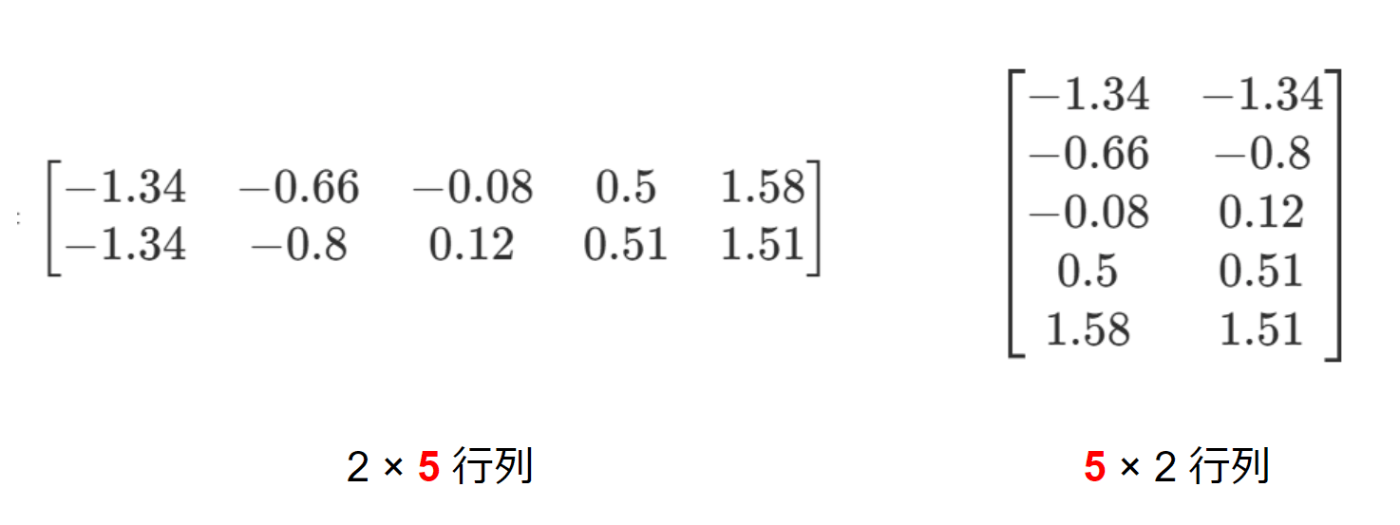

はいはい、転置行列ね。そんなん忘れた。という人に向けて。

例えば

これの転置行列は以下の通り。

先ほど求めた身長と体重の標準化を行ったデータで具体的に説明する。

| データ番号 | 身長 (cm) | 体重 (kg) | 身長の標準化 | 体重の標準化 |

|---|---|---|---|---|

| 1 | 155 | 48 | -1.34 | -1.34 |

| 2 | 162 | 55 | -0.66 | -0.8 |

| 3 | 168 | 67 | -0.08 | 0.12 |

| 4 | 174 | 72 | 0.5 | 0.51 |

| 5 | 185 | 85 | 1.58 | 1.51 |

まず、このデータセット

それを式として表すと以下の通り。

転置行列はこれをパタンとひっくり返したもの。

具体的には以下のような感じ。

そして

ここで行列の積についておさらい。

行列の積は 1つ目の行列の列と2つ目の行列の行が同じ数字じゃないと掛け算できない。

そして積は以下の様に同じ矢印の色同士で行う。

実際に式にすると以下の通り。

つまり、共分散行列

今回は特徴量が

共分散行列を求めることで、次の固有値と固有ベクトルの計算が行えるのかな?と予想して次の内容へ。

あと少し頑張ろう。

3. 固有値と固有ベクトルの計算

固有値と固有ベクトルの計算については、ChatGTPさんに質問したが理解できなかった。

なのでChatGTPさんの回答をそのまま載せておく…。

ここで挫折しては意味がないので、何となく概要を頭に入れたし次へ進む。

固有値と固有ベクトルの計算について詳しく解説

固有値と固有ベクトルは、線形代数において非常に重要な概念で、主成分分析(PCA)やデータ解析の基礎となります。以下に、これらの計算方法や具体例を詳しく説明します。

3-1. 固有値と固有ベクトルの定義

固有値・固有ベクトルの式

行列

-

: 固有値(eigenvalue)

ベクトルの伸縮率を表します。 -

: 固有ベクトル(eigenvector)

行列によって変換されても方向が変わらないベクトルです。

簡単なイメージ

- 固有ベクトルは「行列が引っ張ったり押し縮めたりしても向きが変わらない方向」。

- 固有値は、その方向でベクトルがどれだけ伸びたり縮んだりするかを表します。

3-2. 固有値と固有ベクトルを求める手順

固有値と固有ベクトルを計算するには、次の手順を行います。

ステップ1: 固有値を求める

固有値は次の「固有値方程式」を解くことで得られます:

ここで:

-

:対象の行列(サイズ ) -

:単位行列(同じサイズ ) -

:固有値 -

:行列式を計算する記号

意味:

-

: から固有値 を引いた行列 -

:行列が特異行列(逆行列が存在しない)になる条件

具体的な計算:

- 行列式を計算し、

に関する多項式(固有方程式)が得られる。 - 固有方程式を解いて、

(固有値)を求める。

ステップ2: 固有ベクトルを求める

固有値が求まったら、それぞれの固有値に対して次の式を解きます:

ここで:

-

:固有ベクトル

意味:

- 固有値

に対応する行列 のカーネル(零空間)を求める操作。 - 零空間に属するベクトル(固有ベクトル)は無数に存在するため、通常は「正規化」(長さを1に揃える)して1つに固定します。

3-3. 具体例

行列

ステップ1: 固有値の計算

固有値方程式:

-

を計算: -

行列式を計算:

展開すると:

-

固有値

を求める:

ステップ2: 固有ベクトルの計算

固有値ごとに固有ベクトルを計算します。

固有値

-

行列

を計算: -

連立方程式を解く:

\begin{bmatrix} -1 & 2 \\ 1 & -2 \end{bmatrix} \begin{bmatrix} v_1 \\ v_2 \end{bmatrix} = \begin{bmatrix} 0 \\ 0 \end{bmatrix} 1行目より:

-1v_1 + 2v_2 = 0 \quad \Rightarrow \quad v_1 = 2v_2 固有ベクトル(任意定数を

t \mathbf{v} = \begin{bmatrix} 2 \\ 1 \end{bmatrix} 固有値

\lambda = 2

同様の手順で計算:\mathbf{A} - 2\mathbf{I} = \begin{bmatrix} 2 & 2 \\ 1 & 1 \end{bmatrix} 固有ベクトル:

\mathbf{v} = \begin{bmatrix} -1 \\ 1 \end{bmatrix}

3-4. 固有値と固有ベクトルの結果

-

固有値:

\lambda = 5, \, 2 -

対応する固有ベクトル:

\lambda = 5 \quad \Rightarrow \quad \mathbf{v} = \begin{bmatrix} 2 \\ 1 \end{bmatrix}, \quad \lambda = 2 \quad \Rightarrow \quad \mathbf{v} = \begin{bmatrix} -1 \\ 1 \end{bmatrix}

3-5. 固有値と固有ベクトルの重要性

- 固有値:主成分分析(PCA)では、データの分散を説明する主成分の重要度を示します(大きいほど重要)。

- 固有ベクトル:主成分(新しい軸)を表し、データの方向を決定します。

このように、固有値と固有ベクトルの計算は、線形代数を基にデータ解析や次元削減の基礎を作る非常に重要なステップです!

4. 次元削減

固有値が大きい順に固有ベクトルを選び、その選ばれた固有ベクトルにデータを射影することで、次元を削減する。

さいごに

後半が分からなかった。

ただ、計算式を理解しなくても概要だけ理解していれば、今後は困らないんじゃ?精神でやっていく。

もしここら辺の詳しい知識が必要になったら未来の自分に任せようと思う。

次回はPythonで主成分分析を行ってみる。

ではまた。

Discussion