Beyond LLM > GoogleColabにComfyUIをインストールする

環境の準備

まずはじめに、環境の構築を行う必要があります。

Comfy UIを手元で動作させるためには大きく分けて下記の3種類あります。

-

Mac(ローカル)にインストール

データの完全なプライバシー(画像がローカルに保存される)

インターネット接続なしでも使用可能

処理速度が安定している(他のユーザーの影響を受けない)

長時間の処理でもセッション切れの心配がない -

Google Colab

初期費用不要で高性能GPU(T4、V100など)が使える

セットアップが比較的簡単

ブラウザがあればどこからでもアクセス可能

定期的にランタイムがリセットされるため、環境が清潔に保たれる -

クラウドサービス(Runpod、Vast.ai など)

高性能GPU(RTX 4090、A100など)を時間課金で利用

環境構築済みのテンプレートが豊富

必要な時だけ課金

動画生成においては、GPUのリソースが非常に重要となっておきます。

例えば、AppleInteligenceに対応したMac Mini M4で今回、記事の中で紹介するWan2.1の動画を2秒作成するために、およそ20分程度の時間がかかりました。同様の作業をGoogleColabのT4スペックで実行した時は5分程度で実行が終了するようなイメージです。もちろんGPUをたくさん積んでいるマシンであれば、自前の環境で構築できますが、今回は、GoogleColabを活用したインストールの方法をご紹介したいと思います。

事前準備

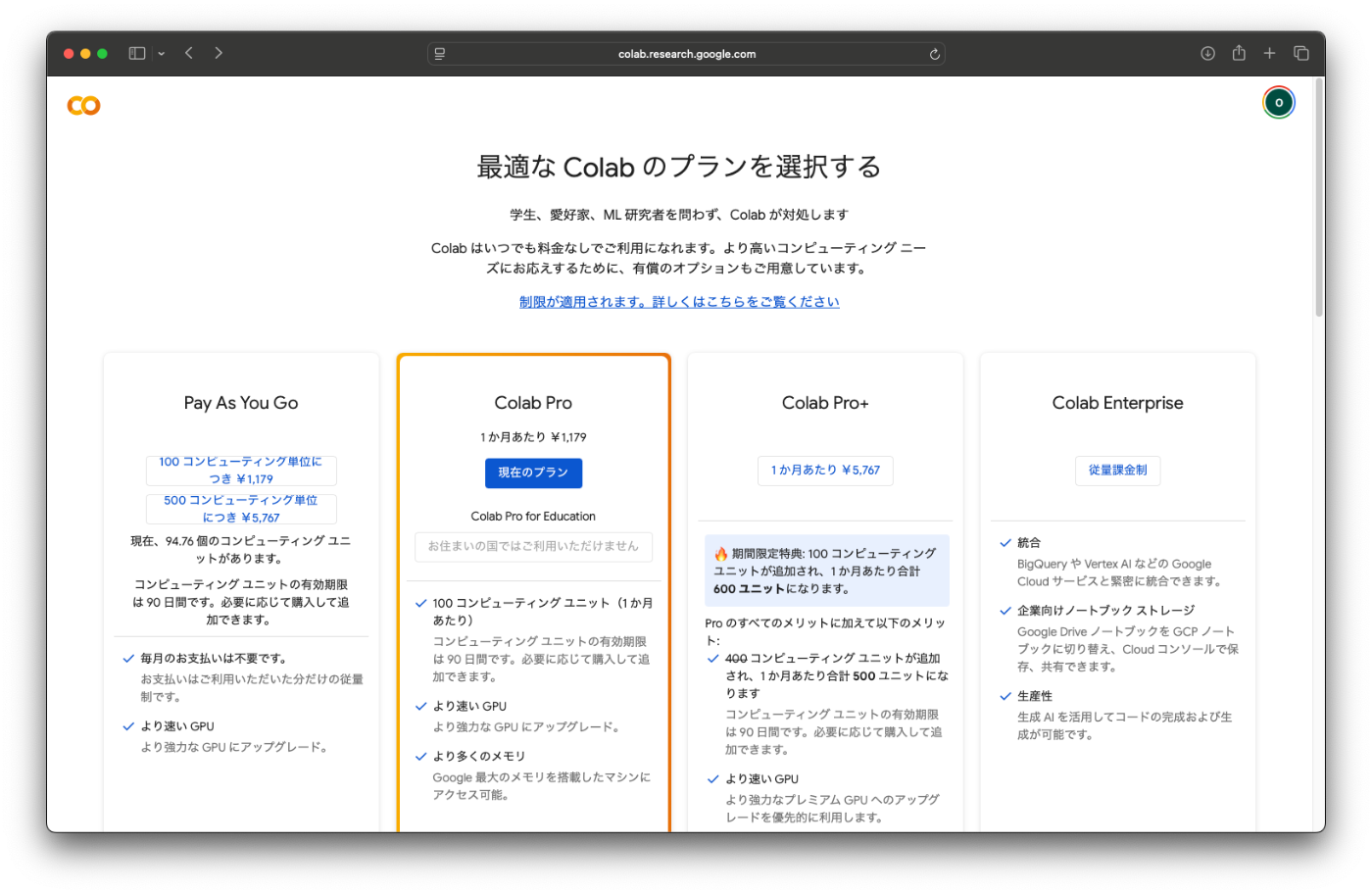

まず事前準備として、GoogleColabにまずは、ColabProに契約を行う必要があるのですが、リソースによる課金の考え方について知っておく必要があります。

GoogleColabの課金の考え方

ColabProの場合、コンピューティング ユニットは1ヶ月あたり100あります。

マシンスペックは下記のようになっていて、

「A100 GPU」>>「L4 GPU」>「T4 GPU」です。

およそ100ユニットで計算すると

A100→1時間あたり約7.62 (約13時間と少し)

L4 →1時間あたり約2.09 (約48時間)

T4→1時間あたり約1.44 (約70時間)

程度が一月に利用できる計算なります。

どのような動画を生成するかにもよるのですが、最もスペックが低いマシンでも70時間程度が限界であるため、例えば、1動画に1時間かかるとして70本程度の動画が生成できる、という計算が必要となります。

ちなみに、現在の使用量はリソースのところから確認することができますので、確認しながら利用できます。

このような制限をまず、知っておき、今後用途が増えた場合に、自前でマシンを用意するのか、または従量課金のサービスに変更するのかなどの選択肢があると安心です。

Google Colabに契約を行う

課金について理解できたところで、実際にGoogle Colabに契約を行います。

コードを取得する

コードの中身

このJupyter NotebookはGoogle ColabでComfyUIを実行するための環境構築スクリプトです。確かに大きく5つのブロックに分かれています。今回の事例は、1−3までの手順を利用しますので、4、5の手順は不要となります。

1. 環境設定ブロック(最初のセル)

Google Driveのマウント、ComfyUIのクローン、依存関係のインストール、ComfyUI-Managerの設定を行います。

- Google Driveを

/content/drive/MyDriveにマウント - ComfyUIをGitHubからクローン

- PyTorch、torchvision、各種ライブラリをインストール

- ComfyUI-Manager(拡張機能管理ツール)をセットアップ

2. モデルダウンロードブロック(2番目のセル)

ComfyUIで使用する各種AIモデルをダウンロードします。大部分はコメントアウトされており、必要に応じて有効化する仕組みです。

- Checkpointモデル(SD1.5、SDXL、アニメ系など)

- VAE(Variational Autoencoder)

- LoRA(Low-Rank Adaptation)モデル

- ControlNet、T2I-Adapter

- アップスケールモデル(ESRGAN)

3. Cloudflared起動ブロック(3番目のセル)

Cloudflareのトンネリングサービスを使ってComfyUIを外部からアクセス可能にします。

- Cloudflaredをダウンロードしてインストール

- ローカルサーバーの起動を監視

- 外部アクセス用のURLを生成・表示

4. Localtunnel起動ブロック(4番目のセル)

代替手段としてlocaltunnelを使用したアクセス方法です。

- npmでlocaltunnelをインストール

- IPアドレスを取得してパスワードとして表示

- 外部アクセス用のトンネルを作成

5. Colab iframe起動ブロック(5番目のセル)

最後の手段として、Colab内のiframeでComfyUIを実行します。

- WebSocketが制限されるため機能が限定的

- ライブプレビューなど一部機能が動作しない

- 直接Colab内で表示するため最も確実

1つ目を実行する

チェックボックス

USE_GOOGLE_DRIVE:ON

UPDATE_COMFY_UI:OFF

USE_COMFYUI_MANAGER:ON

INSTALL_CUSTOM_NODES_DEPENDENCIES:OFF

!git pull

!pip install -r requirements.txt

!pip install av

!pip install uv

実行中

2つ目を実行する

下記のスクリプトを実行する

basic 画像生成

!wget -c https://huggingface.co/Comfy-Org/stable-diffusion-v1-5-archive/resolve/main/v1-5-pruned-emaonly-fp16.safetensors -P ./models/checkpoints/

ControlNet 2 Paass Pose Worship

!wget -c https://huggingface.co/comfyanonymous/ControlNet-v1-1_fp16_safetensors/resolve/main/control_v11p_sd15_openpose_fp16.safetensors -P ./models/controlnet/

!wget -c https://civitai.com/api/download/models/176425?type=Model&format=SafeTensor&size=pruned&fp=fp16 -P ./models/checkpoints/

!wget -c https://civitai.com/api/download/models/85426?type=Model&format=SafeTensor&size=pruned&fp=fp16 -P ./models/checkpoints/

video_Wan2.2 14B Text to Video

!wget -c https://huggingface.co/Comfy-Org/Wan_2.2_ComfyUI_Repackaged/resolve/main/split_files/vae/wan_2.1_vae.safetensors -P ./models/vae/

!wget -c https://huggingface.co/Comfy-Org/Wan_2.2_ComfyUI_Repackaged/resolve/main/split_files/diffusion_models/wan2.2_t2v_low_noise_14B_fp8_scaled.safetensors -P ./models/diffusion_models/

!wget -c https://huggingface.co/Comfy-Org/Wan_2.2_ComfyUI_Repackaged/resolve/main/split_files/diffusion_models/wan2.2_t2v_high_noise_14B_fp8_scaled.safetensors -P ./models/diffusion_models/

!wget -c https://huggingface.co/Comfy-Org/Wan_2.2_ComfyUI_Repackaged/resolve/main/split_files/loras/wan2.2_t2v_lightx2v_4steps_lora_v1.1_high_noise.safetensors -P ./models/loras/

Wan2.2 5b

!wget -c https://huggingface.co/Comfy-Org/Wan_2.2_ComfyUI_Repackaged/resolve/main/split_files/diffusion_models/wan2.2_ti2v_5B_fp16.safetensors -P ./models/diffusion_models/

!wget -c https://huggingface.co/Comfy-Org/Wan_2.2_ComfyUI_Repackaged/resolve/main/split_files/vae/wan2.2_vae.safetensors -P ./models/vae/

実行中

GoogleDriveにファイルが作成されます

3つ目を実行する

リソースの残量を確認する

今後の展望と書籍のご紹介

フィジカルAIと世界モデルの発展により、AIは単なる情報処理システムから、物理世界を理解し、相互作用できる存在へと進化しつつあります。

この技術の進展は、ロボティクス、自動運転、製造業、さらにはエンターテインメント分野まで、幅広い産業に革新をもたらす可能性を秘めています。

この記事では、世界モデルを紹介する書籍の一部をご紹介しました。

これまでに書いた記事は本としてまとめておりますので、ぜひ下記のリンクからお読みください。 (すべての情報は無料で公開されています)

皆様の新しい発見へのお手伝いができれば、幸いです。

Beyond LLM:世界モデルが切り拓くフィジカルAIの時代

Discussion