GPT-5 vs Claude Opus 4.1!Cursor AgentとClaude Codeで同じアプリを作って比較してみた

はじめに

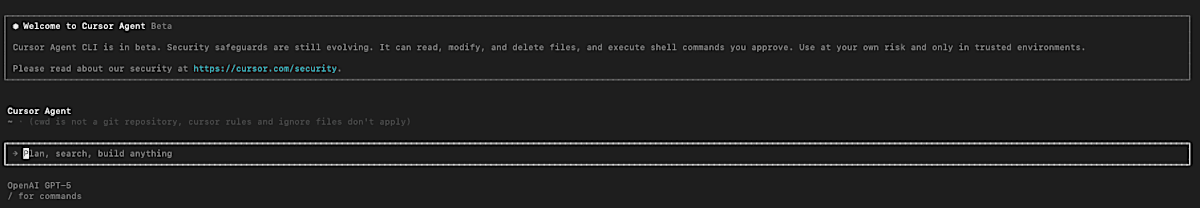

最近、AI支援の開発ツールが急速に進化しており、その中でも特に注目されているのがCLIベースのAIアシスタントです。そして、つい先日(2025年8月)、Cursor社から待望の「Cursor Agent CLI」のベータ版がリリースされました!🎉

リリースされたばかりのホヤホヤな状態で、まだ情報も少ない中、早速インストールして試してみました。今回は、このCursor Agent CLIとAnthropicの「Claude Code」を実際に使い比べて、それぞれの特徴や違いを探ってみたいと思います。

両ツールとも、ターミナルから直接AIアシスタントを呼び出してコーディング支援を受けられる点で共通していますが、実際に使ってみると、それぞれに明確な設計思想の違いがあることがわかりました。新しいツールを試すワクワク感と共に、その発見をお伝えします!

Cursor Agent CLIのインストール

Cursor Agent CLIは現在ベータ版として提供されています。公式サイトの手順に従えば、驚くほど簡単にインストールできます。自動インストーラーが用意されているので、コマンド一つで環境構築が完了します。

インストール完了後は、PATHの設定が必要です:

echo 'export PATH="$HOME/.local/bin:$PATH"' >> ~/.zshrc

source ~/.zshrc

その後、cursor-agentコマンドで起動できます。

そして、なんと起動画面を見てください!デフォルトで「OpenAI GPT-5」が選択されています!リリースされたばかりの最新モデルGPT-5がデフォルトで使えるなんて、これだけでもワクワクしますね。Cursorならではの最先端の体験です。

機能比較:Cursor Agent vs Claude Code

Claude Codeで使える機能がCursor Agentにも実装されているか、実際にCursor Agentに質問して確認してみました。

「Claude.md相当の機能」について質問

まず、「Claude.mdに相当するものがありますか?」という質問をCursor Agentに投げかけてみました。

Cursor Agentの回答:

- いいえ、特定の予約ファイル名(Claude.md相当)はありません

- ただし、リポジトリ直下に任意ファイルを置いて、これを手動ルールとして使うことで代替可能

- 提案されたファイル名例:

-

AI_GUIDELINES.md、assistant.md、CONTRIBUTING-AI.md

-

- 運用方法:ファイルを作成後、「私にこのガイドに従って」と一言いえばルールとして適用される

-

補足:Cursor Agentからはこのような回答をいただきましたが、

.cursorディレクトリ内のファイルを自動的に読み込んでいる可能性もありそうです(ただし、公式ドキュメントでの明確な記載は見つからず、未確認情報です)

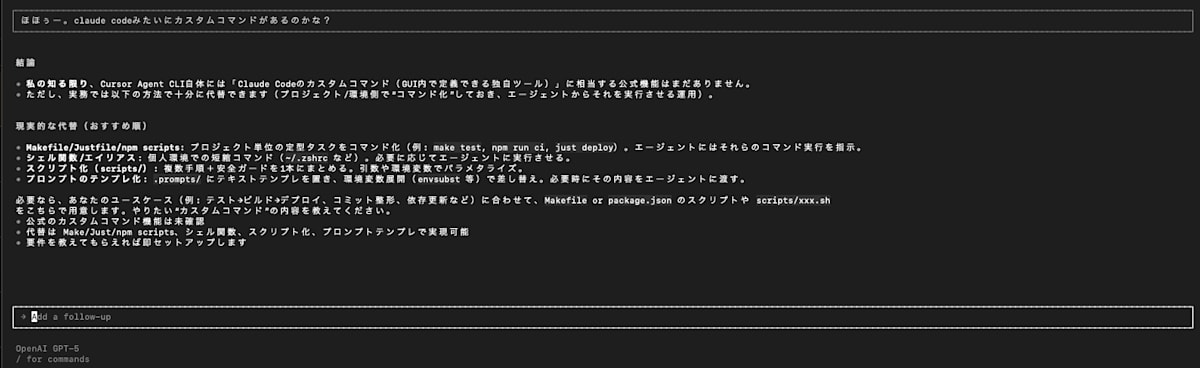

「カスタムコマンド機能」について質問

次に、Cursor Agentに「Claude Codeのカスタムコマンドがあるのか?」と質問してみました。

Cursor Agentの現実的な代替案:

- Makefile/npm scripts:プロジェクトの定番タスクをコマンド化(例:make test, npm run ci, just deploy)

- シェル関数/エイリアス:個人環境での繰り返しコマンド(~/.zshrcなど)

-

スクリプトディレクトリ:

bin/やscripts/フォルダに実行可能スクリプトを配置 -

プロンプトのテンプレ化:

.prompts/にテキストテンプレを置き、環境変数で差し替え(.envsubst等) - カスタムコマンド機能は未実装:現時点では、Makefileやpackage.jsonのスクリプトをそのまま実行することはできない

これらの回答から、Cursor Agentはまだベータ版ということもあり、Claude Codeのような機能の多くは今後実装されていく予定のようです。現時点では、既存のツールを組み合わせた代替案を提案してくれる形になっています。

使用感の比較

実際に両ツールを使ってみた感想を以下にまとめます。

Cursor Agent CLI

メリット:

- シンプルで直感的なインターフェース

- Gitリポジトリやファイルの操作に制限があるため、安全性が高い

- 話題のGPT-5が簡単に使える!

- Cursorエディタとの連携を前提とした設計

デメリット:

- 現在ベータ版のため機能が限定的

- ファイルの直接編集や実行には制限がある

- 回答速度が遅い

- 日本語の回答精度がやや劣る場合がある

セキュリティとプライバシー

Cursor Agentは起動時に以下のような警告を表示します:

Cursor Agent CLI is in beta. Security safeguards are still evolving. It can read, modify, and delete files, and execute shell commands you approve. Use at your own risk and only in trusted environments.

両ツールともファイルシステムへのアクセス権限を持っていますが、以下の点で異なります:

- Cursor Agent: ユーザーの承認が必要な操作が多い

- Claude Code: より自律的に動作し、ファイルの編集や実行を直接行える

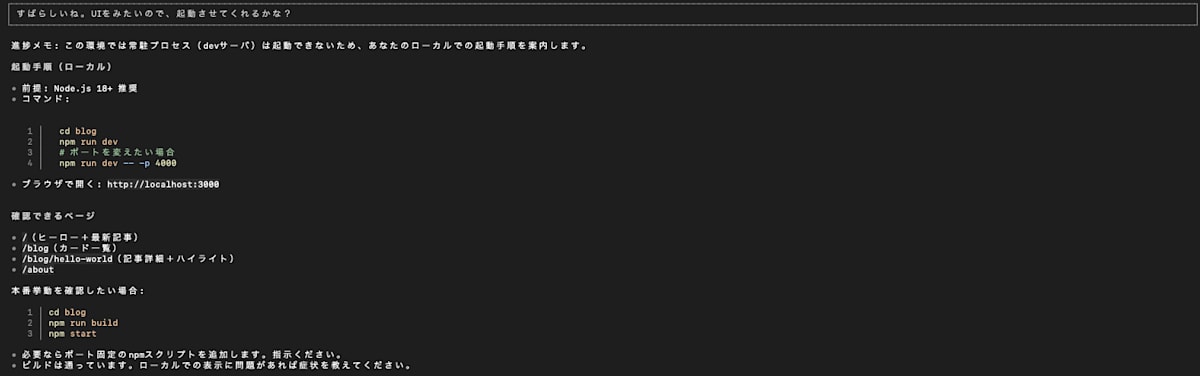

Cursor Agentの実行制限

実際にCursor Agentでnpm run devのようなローカル開発サーバーを起動しようとすると、以下のような制限に直面します:

Cursor Agentの回答:

- 常駐プロセス(devサーバー)は起動できないため、あなたのローカルでの起動手順を案内します

- 提案される起動手順(ローカル):

cd blognpm run dev- ポートを変えたい場合:

npm run dev -- -p 4000

- ブラウザで開く:

http://localhost:3000

必要なポート固定のnpmスクリプトを追加する提案もしてくれますが、結局ローカルでの実行は拒否される仕様となっています。これはセキュリティを重視した設計と言えるでしょう。

料金体系

- Cursor Agent CLI: Cursorの有料プラン(Pro/Business)に含まれる

- Claude Code: Claude Proサブスクリプション(月額$20)が必要

おまけ:同じプロンプトでアプリを作ってみた

実際に両ツールの実力を比較するため、同じプロンプトでブログアプリを作成してもらいました。

使用したプロンプト

next.jsを使ってblogアプリをその中につくってみて。

web3とAIを専門にとりあつかうメディアにしたいので、

UI/UXをその方向でデザインしてください。

必要なUIライブラリもお任せするので、じゃんじゃん入れちゃって

このシンプルなプロンプト一発で、どこまでのクオリティが出せるか試してみました。

作成したアプリ

- Claude Codeで作成: https://chainmind-blog.netlify.app/

- Cursor Agentで作成: https://gleaming-starburst-f558e2.netlify.app/

実際のスクリーンショット

Claude Code版(ChainMind)

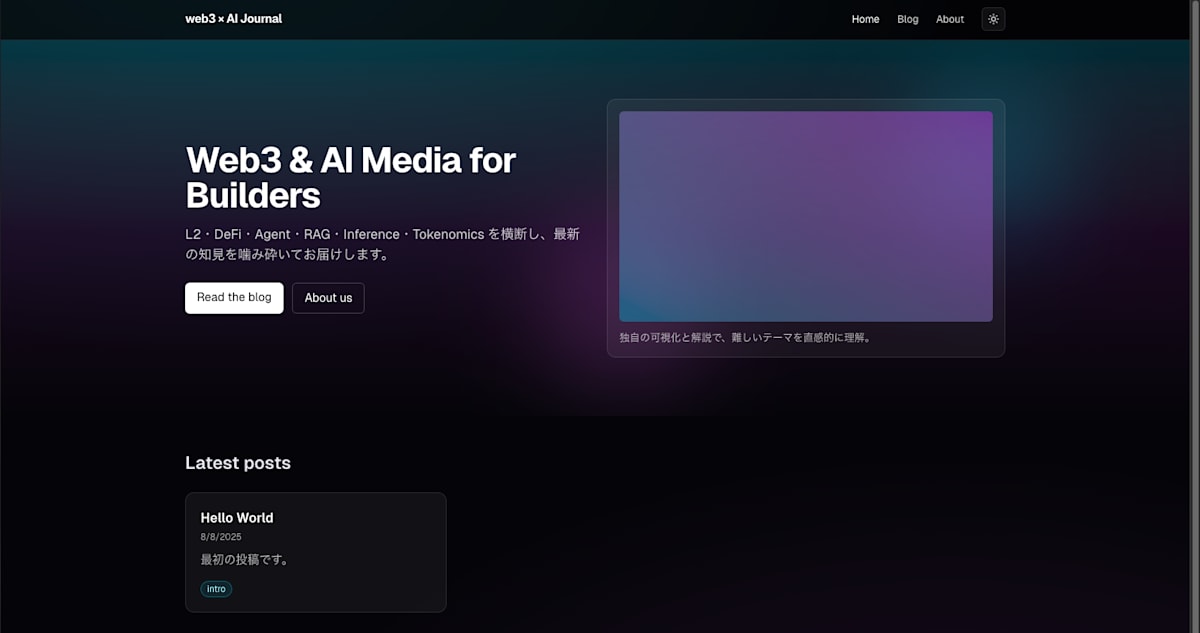

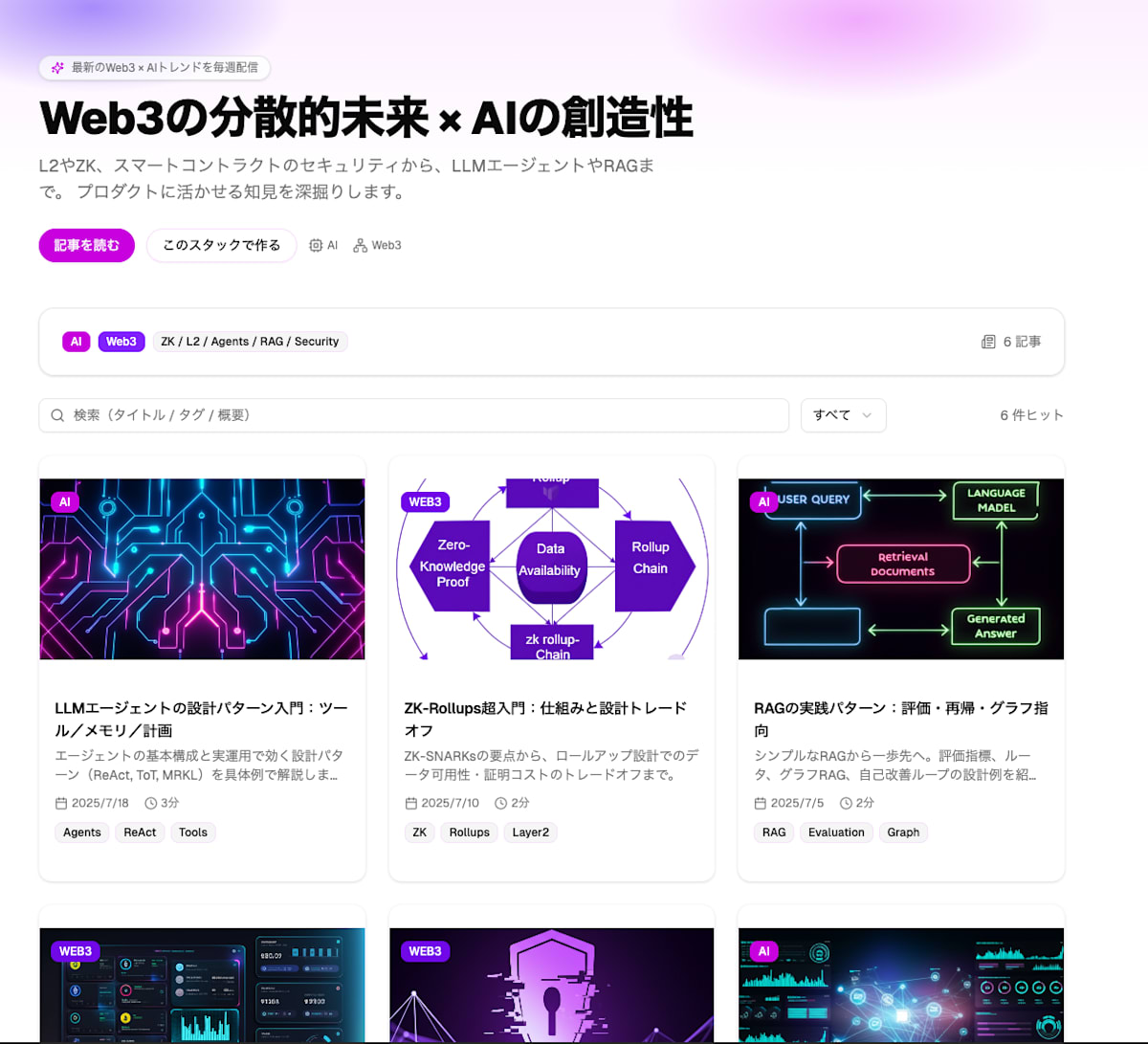

Cursor Agent版(web3 × AI Journal)

正直な感想

率直に言って、同じプロンプトを与えた結果には大きな差がありました。

Claude Code版は、プロンプトの意図を完全に理解し、Web3×AIメディアとして必要な機能(ウォレット接続、カテゴリー分け、プロフェッショナルなデザイン)を自動的に実装してくれました。まさに「プロダクションレディ」な仕上がりです。

一方、Cursor Agent版は、正直なところかなり物足りない結果となりました。「GPT-5使ってるんだから、きっとすごいものが出てくるはず!」と期待していた分、ちょっとショックでした...。基本的なブログの枠組みは作ってくれましたが、Web3要素はテキストで言及するだけで、実際の機能実装はほぼありません。デザインも最小限で、「とりあえず動くもの」という印象です。

GPT-5というビッグネームに期待しすぎていたのかもしれませんが、「え、これがGPT-5の実力...?」というのが正直な第一印象でした(もちろん、ツール側の制約もあるとは思いますが)。

ただし、この差をそのままツールの優劣と判断するのは早計かもしれません。

今回は「ポン出し」のシンプルなプロンプト一発での比較でしたが、以下の点を考慮する必要があります:

- 使用モデルの違い:Claude CodeはClaude Opus 4.1、Cursor AgentはGPT-5という異なるLLMを使用

- ツールの成熟度:Cursor Agentはまだベータ版、Claude Codeは正式リリース版

- プロンプトの書き方:より詳細な指示を与えれば、Cursor Agentでももっと良い結果が得られる可能性

特に、GPT-5とClaude Opus 4.1という異なるモデルの特性もあるため、単純な比較は難しいというのが実情です。今後、両ツールがアップデートされていく中で、この差がどう変化していくか注目したいところです。

さらにおまけ:V0でGPT-5の実力を確認してみた

Cursor Agentの結果にショックを受けたので、「これは本当にGPT-5の実力なのか?」を確認するため、Vercel のV0(GPT-5使用)で同じプロンプトを試してみました。

- V0(GPT-5)で作成 :https://v0-next-js-blog-design-amber.vercel.app/

V0(GPT-5)版の特徴

驚きの完成度!

- プロフェッショナルなグラデーションデザイン

- Web3×AIのコンセプトが完璧に表現されている

- カテゴリー分け(AI、Web3、ZK/L2/Agents/RAG/Security)

- 記事カード型のモダンなレイアウト

- 日本語コンテンツも自然に配置

- ビジュアル重視の図解やダイアグラムも含まれている

結論:GPT-5 vs Claude Opus 4.1

V0での結果を見ると、GPT-5の実力は確かに高いことがわかりました。ただし、これをそのまま比較するのも公平ではないかもしれません。

考えられる要因:

- V0の特性:UI作成に特化したツールなので、GPT-5に対してUI最適化されたプロンプトを内部で渡している可能性

- ツールの制約:Cursor Agentはファイル操作やセキュリティの制約が多い

- 用途の違い:V0はUI生成特化、Cursor Agentは汎用的なコーディング支援

純粋なモデルの能力で比較すると:

- GPT-5(V0経由): UI/UXデザインで素晴らしい成果

- Claude Opus 4.1(Claude Code): フルスタック開発で高い完成度

結局のところ、GPT-5 vs Claude Opus 4.1は用途やツールによって優劣が変わるというのが現実的な結論でしょう。どちらも強力なモデルですが、それを活かすツールやプラットフォームの設計によって、アウトプットが大きく変わることが今回の実験でよくわかりました。

ツール選びは、単純にLLMモデルの性能だけでなく、ツール自体の設計思想や最適化の方向性も含めて総合的に判断する必要がありそうです。

Discussion