〰️

軌跡の指定が可能な動画生成モデル「DragNUWA」を試す

DragNUWAとは?

- DragNUWAは、テキスト、画像、軌跡を同時に制御ができる拡散モデル系の動画生成モデル。

- 意味的、空間的、時間的な観点で制御可能。

- オープンドメインな軌道制御、異なる粒度の軌道制御、視覚的な一貫性を可能とする手法を提案。

- マイクロソフトからの論文

→ Stable Video DiffusionやMake A Videoなど最近動画生成モデルが色々と提案されているけどなど、ほとんどText2VideoやImage2Video、Video2Videoで、軌跡で条件付け生成を行うのは新鮮!

実際に触ってみる

HuggingFaceデモ、Google Colab(npakaさんのコードを参考に)の両方で動かしてみた。

見間違えていなければ公開されているのは画像と軌跡だけの制御でテキストによる条件付けはできなかった。

HuggingFace(A10)は70秒ぐらい、Colab(A100)では40秒ぐらいで、2秒の動画が生成できた。VRAMは16GB弱だったのでT4でもギリギリ動くか。

視点移動

視点移動は、想像よりも高精度で思ったように動かせた。最初の画像で見えてなかった部分もそれっぽく生成できている。フレームの後半になると若干画像クオリティが下がるが、、

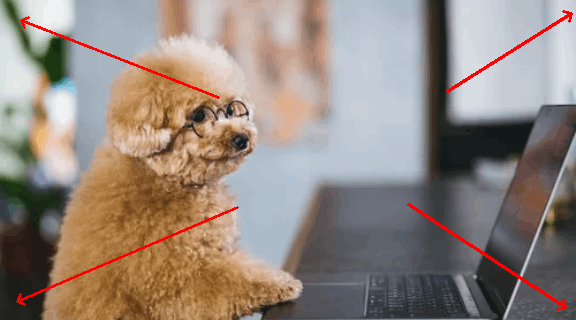

ズーム

- INPUT

- OUTPUT

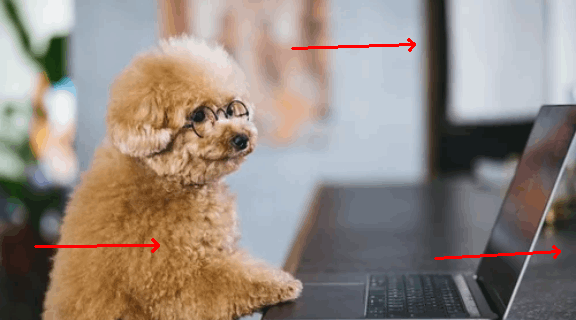

左にスライド

-

INPUT

-

OUTPUT

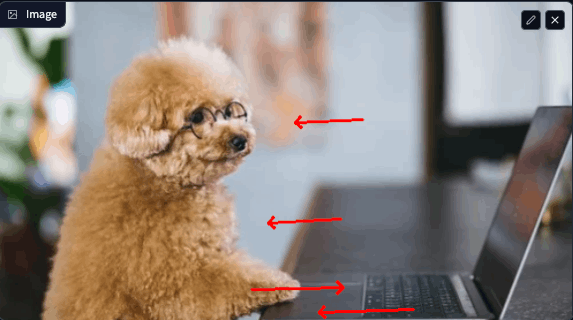

犬に近づく

-

INPUT

-

OUTPUT

画像の中身を動かす

視点移動と比べてタスク難易度が高いのでやはりクオリティが落ちる。軌道の書き方もすごく難しい。

論文の例を見る感じ、もう少し引いた画像の方が精度が出るかもしれない。

犬を動かす

- INPUT

- OUTPUT

犬をダイナミックに動かす

-

INPUT

-

OUTPUT

toyxyz3さんの例

生成しやすい形というのもあるけど、画像の中身もいい感じに生成できている。

どこで使えそう?

DragNUWAは商用利用可能!(https://github.com/ProjectNUWA/DragNUWA/blob/main/LICENSE)

画像から数秒の視点移動であれば実用化できるレベルに近そう。生成できる動画は、576 × 320とちょっと解像度が荒いので、より改善できるモデルが出ることに期待。

リンク一覧

Discussion