【物体検出】評価指標(TP/TN/FP/FN/Precisio/Recall)を分かり易く解説【図解】

はじめに

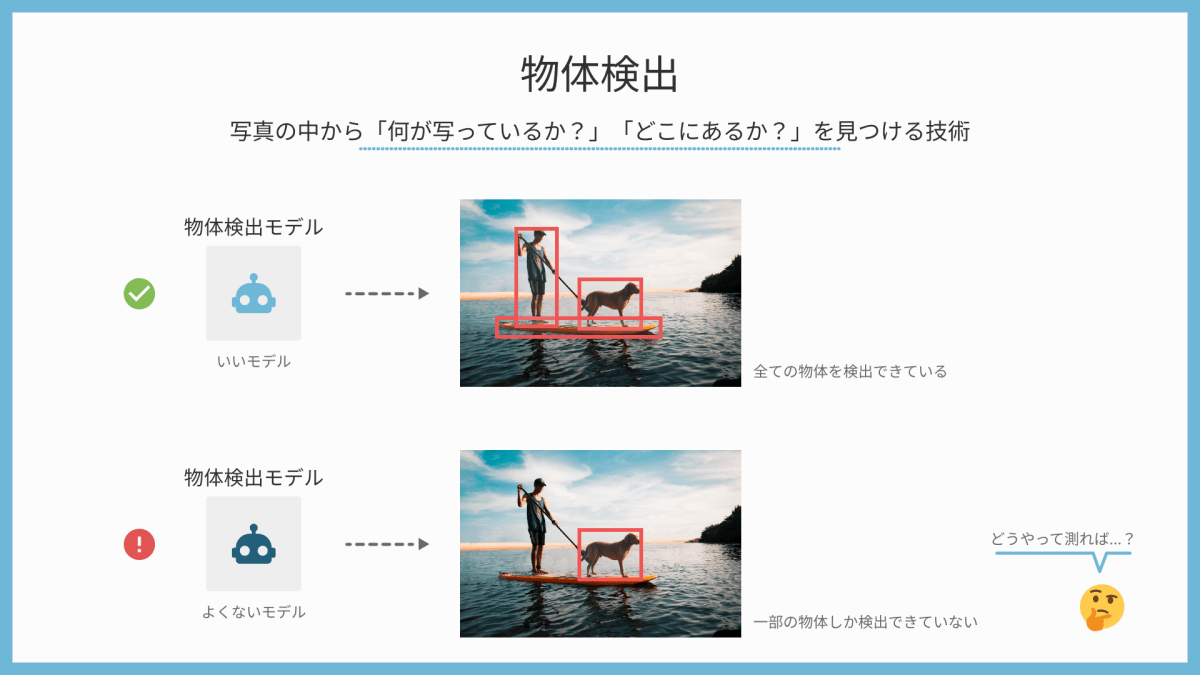

物体検出タスクは、写真や映像の中から「物体が何か?」と「物体がどこにあるか?」を見つける技術です。

物体検出では、モデルがどれだけ上手く物体を見つけられたかを判断するための基準がたくさんあります。

物体検出モデルの精度

今回は、物体検出における評価指標(TP/TN/FP/FN/Precisio/Recall)について解説します。

1. 基本的な用語

まずはじめに、基本となる4つの用語を押さえておきましょう。

基本の4つ

True Positive (TP)

物体検出モデルが物体を「検出した」と予測し、その予測が正しかった場合。

例:画像に犬がいて、モデルがその犬を正確に検出した場合。

False Positive (FP)

物体検出モデルが物体を「検出した」と予測したけれど、その予測が間違っていた場合。

例:背景や他の物体を犬と誤って検出した場合。

True Negative (TN)

物体検出の文脈では、TNはあまり使われません。なぜなら、大量の「負の」背景領域が存在するため、この指標が意味を成さないからです。

False Negative (FN)

物体が存在するにも関わらず、モデルがその物体を「検出しなかった」と予測した場合。

例:画像に犬がいるのに、モデルが犬を検出しなかった場合。

2. 評価指標

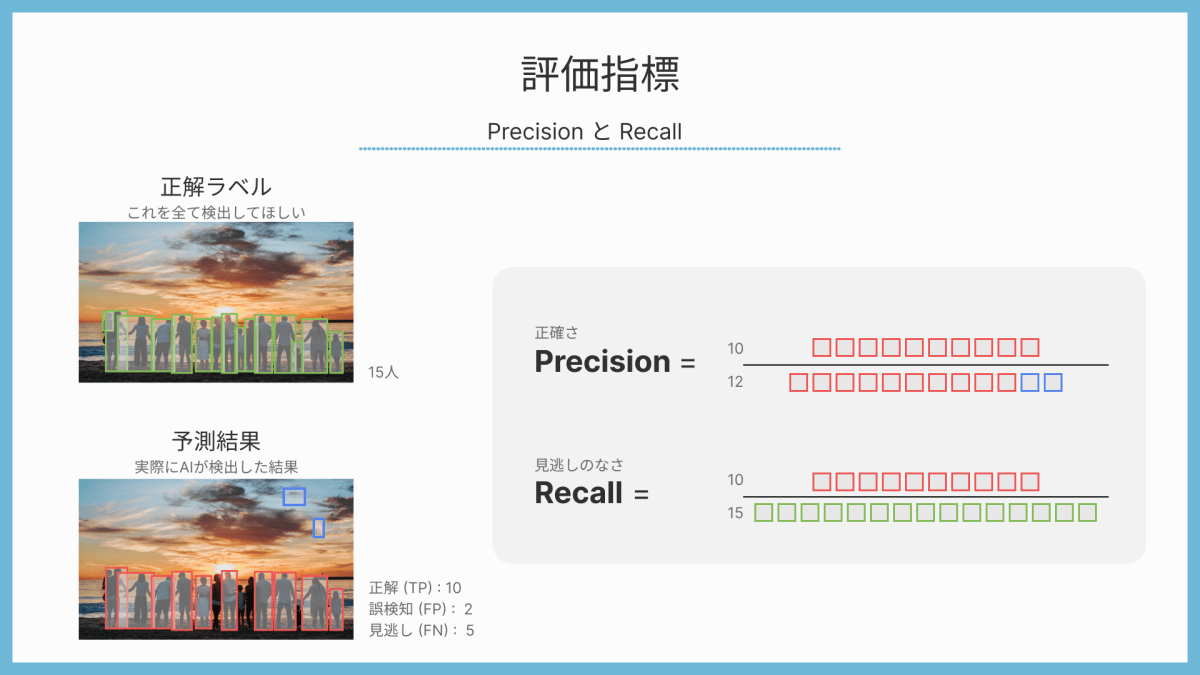

PrecisionとRecall

▼ Precision

正確さを示す指標。モデルが「検出した」と予測した物体のうち、実際に正しく検出された物体の割合。

これを簡単に言うと、Precisionは「正しく検知できた数」を「すべての予測数(予測されたBoxの合計数)」で割ったものです。

▼ Recall

再現率を示す指標。実際に存在する物体のうち、モデルがどれだけを正確に検出できたかの割合。

簡単に言えば、Recallは「正しく検知できた数」を「すべての正解数(検出してほしい正解Boxの合計数)」で割ったものです。

例

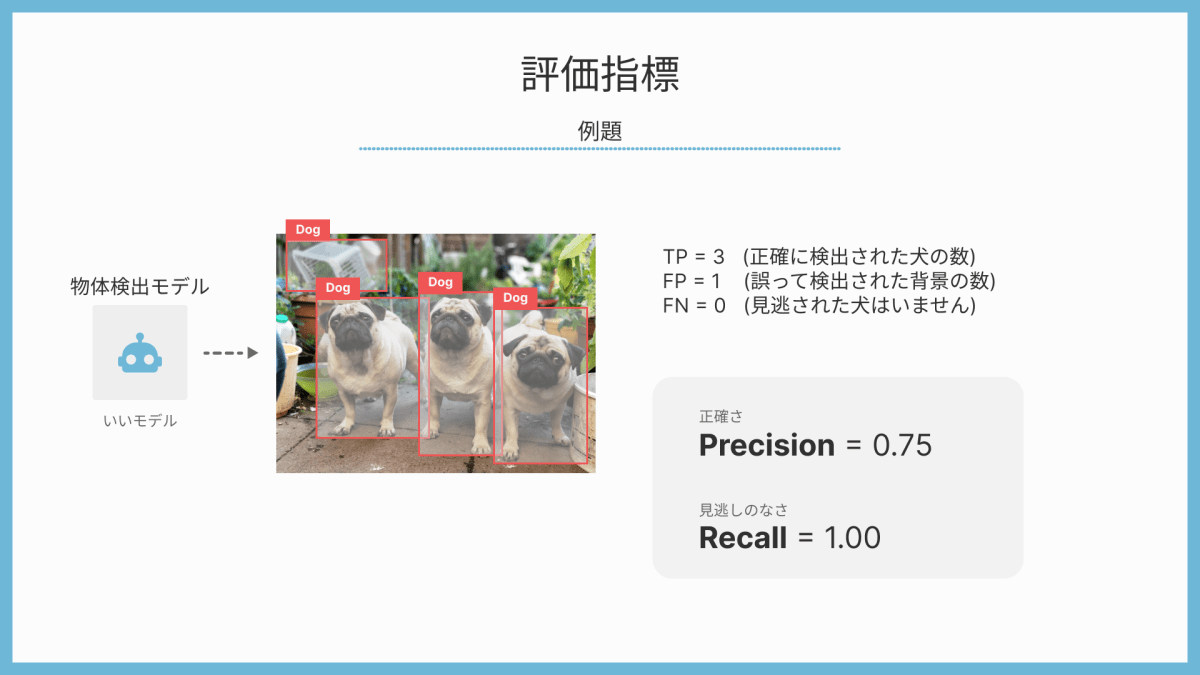

以下は、物体検出の状況を示す簡単な例です。

- 画像には3匹の犬がいます。

- モデルは4つの「犬」としての検出を報告しました。

- そのうち3つの検出は正確で、1つの検出は背景を誤って「犬」として検出したものです。

例題 : 3匹の犬

この場合:

- TP = 3 (正確に検出された犬の数)

- FP = 1 (誤って検出された背景の数)

- FN = 0 (見逃された犬はいません)

このように、PrecisionとRecallはモデルの性能を評価するための重要な指標となります。

まとめ

物体検出の評価指標について紹介しました。難しそうに聞こえますが、基本は「正しく見つけられたか」「間違って見つけたか」「見逃してしまったか」を数値で示すことです。今回の評価指標を使えば、モデルがどれだけ賢いのか、簡単にチェックすることができます。

機械学習をもっと詳しく

ねこアレルギーの AI

普段は YouTube で機械学習について発信しています。お時間ある方は覗いていただけると喜びます。

Created by NekoAllergy

Discussion