DeepSeekを触ってみた

はじめに

最近、DeepSeek-R1が話題になっています。

DeepSeek-R1とは、2025年に発表された大規模言語モデル(LLM)です。

オープンソースであり、API利用料金も低価格で提供されています。

本記事では、個人的な生成AIの技術調査としてDeepSeek-R1を実際に使ってみた使用感について説明します。

また、実行環境は以下の通りです。

- OS : Windows 11

- Python : 3.13.1

- Node.js : 22.13.1

- Ollama : 0.5.7

- bolt.diy : 0.0.6

OllamaでDeepSeek-R1を体感する

今回は、Ollamaというローカル環境で大規模言語モデルを扱うことができるOSSを活用して、DeepSeek-R1をローカル環境で実行してみます。

まずはOllamaを公式サイトからダウンロードします。

macOS・Linux・Windowsから選択することができ、環境にあったものをダウンロード・インストールしてください。

本記事の環境ではWindowsを選択しています。

インストールが完了したら、下記のコマンドで正常にインストールできているか確認します。

ollama --version

ollama version is 0.5.7

正常にインストールが完了したことを確認できたら、モデルのダウンロードを行います。

下記サイトからモデルサイズを選択し、表示されているコマンドをコマンドプロンプトから実行します。

後ほど、チャットのみでなく別のタスクも試してみたかったので70bを選択しました。

ローカル環境での性能を体感してみたかったため、大きなサイズを選択しましたが

自分の環境にあったものを選択するほうが、後悔が少ないかと思います。

ollama run deepseek-r1:70b

モデルファイルもダウンロードした後、コマンドプロンプトにてチャットできるようになります。

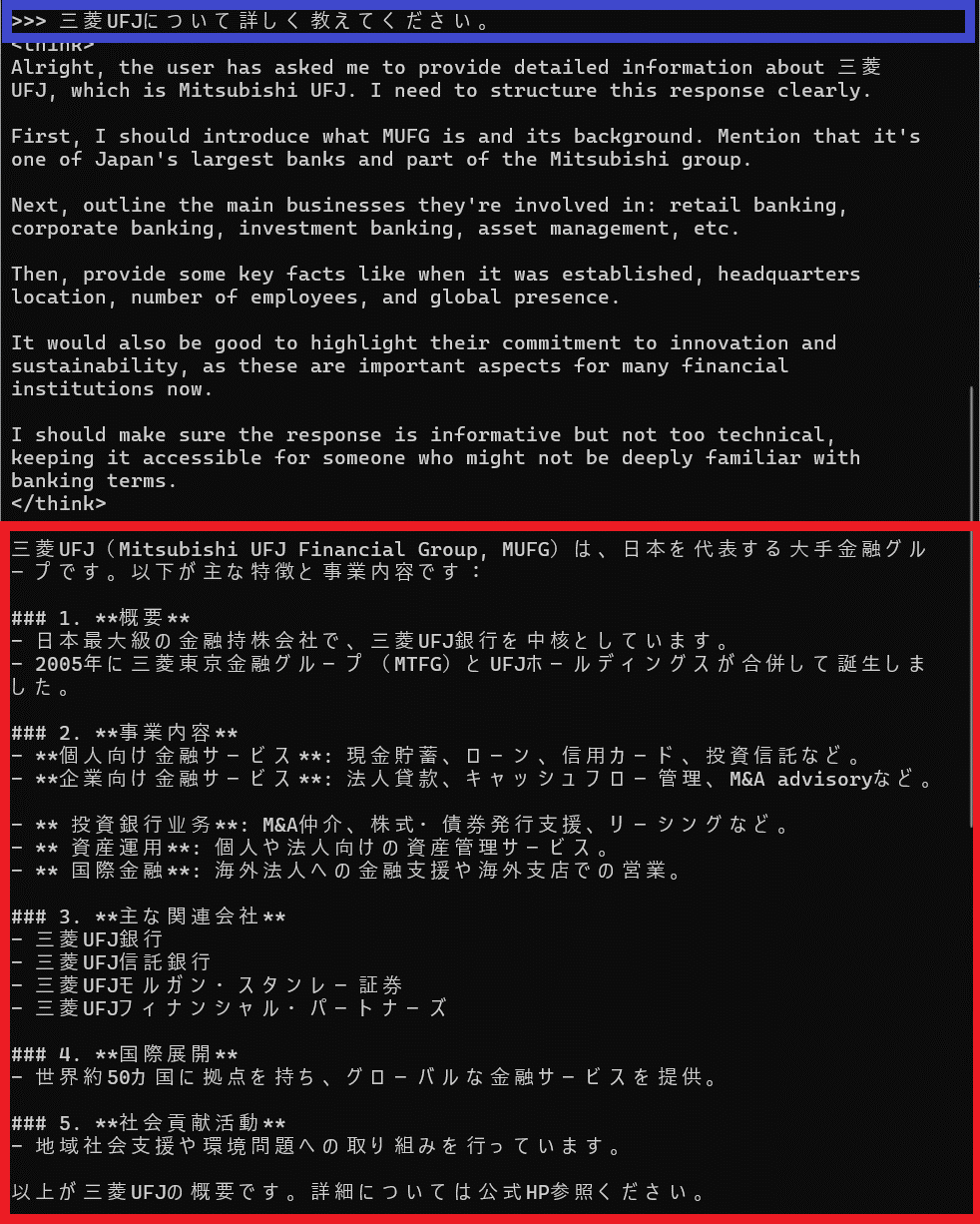

三菱UFJについて聞いてみました。

青で囲われている個所が質問文で、赤枠が返答です。

中国語が混ざっていたりしますが、回答はほぼ問題なく日本語で答えてくれています。

グループ全体でいろんな事業内容があり、勉強になりました。

英語は一単語ずつ出力されるのに対して、日本語はさらに小さな単位での出力も混じっていました。

次のトークンを予測されているのが体感でき、感動しました。

bolt.diyでDeepSeek-R1を体感する

次に、bolt.diyをDeepSeek-R1で動かしてみたいと思います。

世間ではbolt.newが流行していましたが、本記事ではOSS版のbolt.diyを使用し、すべてローカル環境で動作させることで使い放題にすることを目指してみます。

bolt.diyとは、オープンソースのAIコーディングアシスタントです。

AIが開発環境を管理し、ブラウザ上で簡単に開発をすることができます。

使用するAIモデルを自由に選択でき、Ollamaもサポートされているため、先ほどダウンロードしてきたDeepSeek-R1で実行できるよう設定していきます。

GtiHubのReadmeを参照しながら進めます。

リポジトリのクローンを行います。

GitHubからbolt.diyを下記コマンドでクローンしてきます。

git clone https://github.com/stackblitz-labs/bolt.diy.git

Running the Applicationの手順について補足します。

事前準備として、Ollamaを使用するための準備を行います。

クローンしてきたプロジェクトのルートフォルダ配下に存在する.env.exampleというファイルを.env.localというファイル名に変更します

.env.localを編集し、OLLAMA_API_BASE_URLに立ち上がっているOllamaのURLを記載してください。

Ollamaのサーバーはデフォルトで127.0.0.1:11434にバインドされているため、デフォルトから変更していない場合は下記のように追記してください。

OLLAMA_API_BASE_URL= http://127.0.0.1:11434

修正後、Option 1: Direct Installation (Recommended for Beginners)の1~3の手順を進めます。

パッケージマネージャーをインストールし、依存関係を解消します。

npm install -g pnpm

pnpm install

インストール完了後、下記コマンドでアプリケーションを立ち上げることができます。

pnpm run dev

プルダウンからOllamaを選択し、先ほどダウンロードしてきたDeepSeek-R1を選択します。

簡単なアプリケーションを作成するようにお願いしてみます。

「簡単なアプリ」というあいまいな指示でしたが、初心者向けの教材でも取り上げられやすいTODOリストを作成するようです。

アプリの作成中にシェルコマンドの実行エラーで発生してしまったようです。

「Ask Bolt」をクリックすることで、自動でエラーを解析し、修正までできます。

python3を用いて、HTTPサーバーを起動することができなかったことがエラーの原因のようですが、Node.jsを使用することで解決してくれたようです。

発生したエラーにも難なく対処し、無事に簡単なアプリケーションを作成することができました。

終わりに

今回は話題の技術について触れてみました。

フルモデルではないですが、ローカル環境で好きなモデルを選択して技術を組み合わせていくのは楽しかったです。

自分の環境や設定値の問題か、モデルが大きすぎたためか思うような生成スピードがでず、アプリの作成が完了するまでに30分ほど要しました。

GPUを活用する方法や処理速度を上げる方法を調査していく必要があると感じました。

今後はbolt.newも試してみたいと思います。

Discussion