LLM(大規模言語モデル)の変遷まとめ

今回のブログでは2025年2月時点でのLLMの変遷をまとめてみました。

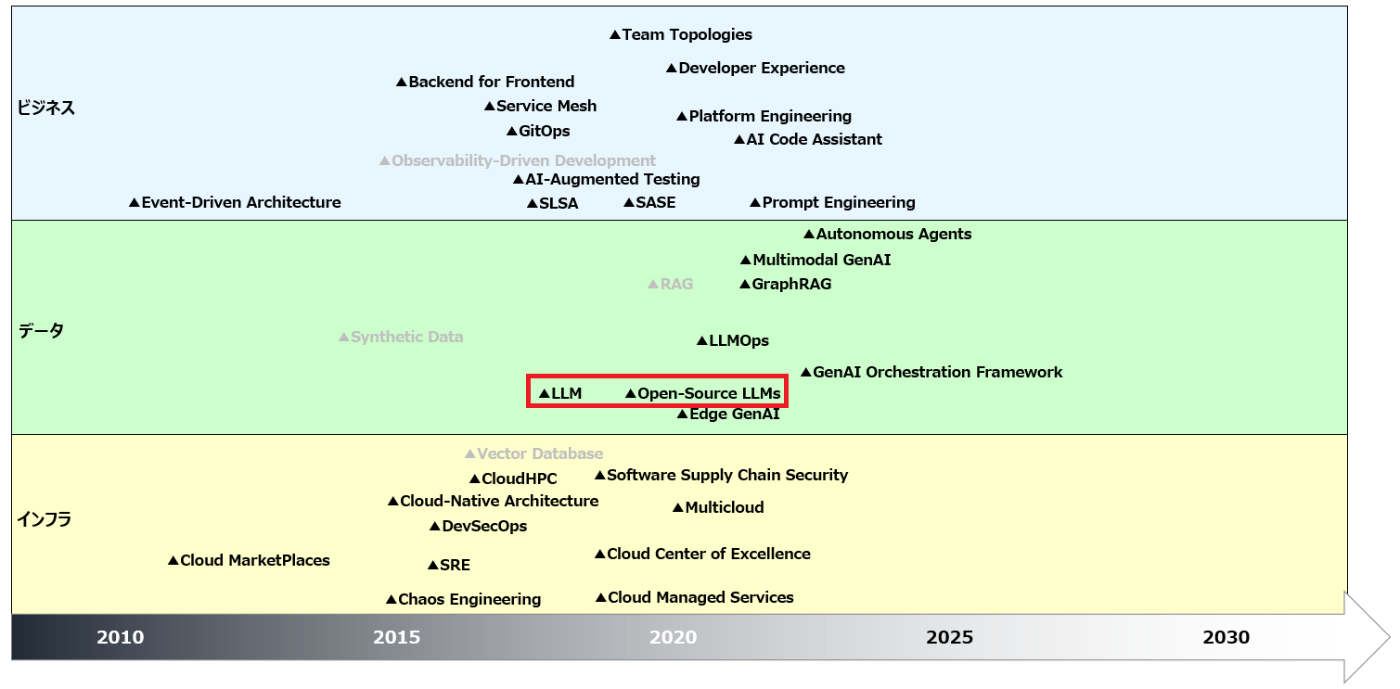

去年9月にYouTubeで解説している技術テーマの年表をリニューアルしました。下図がその年表になります。ちなみに、グレーアウトしたところは既に解説済みの動画になります。よろしければご覧ください。今回は、赤字で囲っているLLMと、オープンソースベースのLLMを解説していきます。

LLMの変遷(年表)

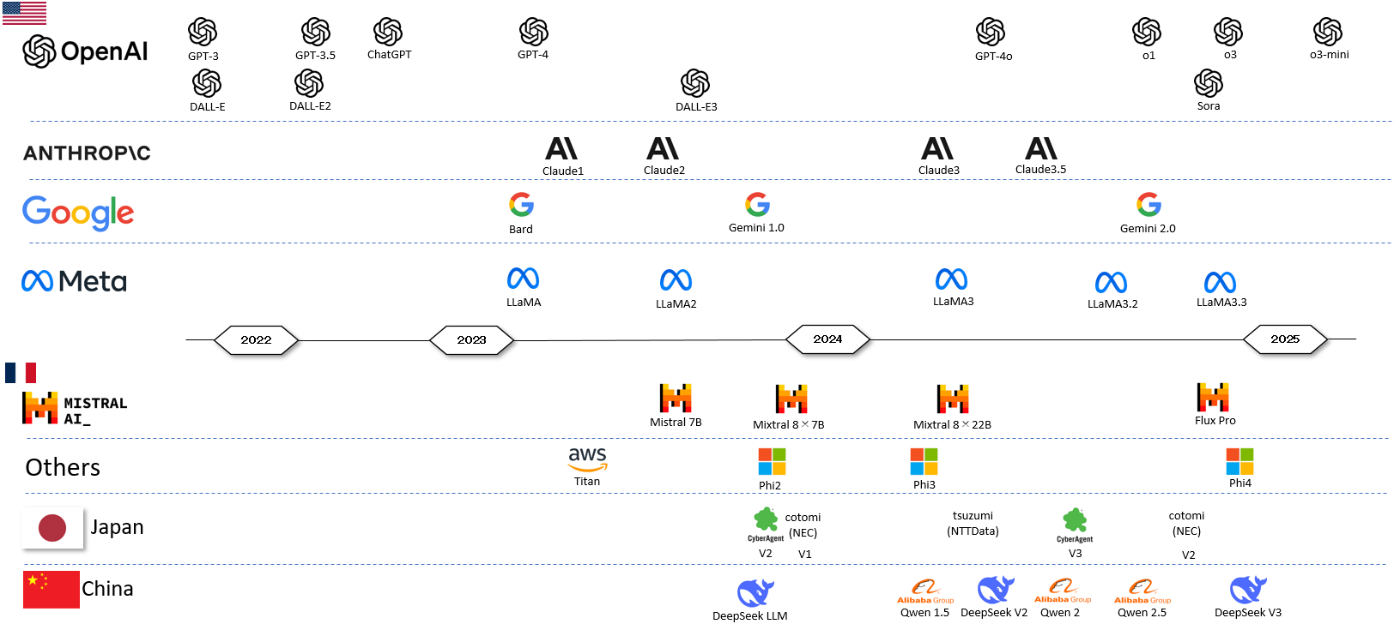

さっそくですが、変遷をまとめてみました。LLMの概念自体は2018年頃に登場しましたが、今回は昨今のAIブームの火付け役になったGPT-3以降を中心にまとめています。

まとめるにあたり、OpenAI、Anthropic、Google、Meta、Mistral AIを中心にピックアップしました。また、参考として日本製のLLMと、中国製LLMも追加しています。

OpenAI

OpenAI社については特に説明不要かと思いますが、間違いなく現在のLLM界隈の中心的存在です。LLMを牽引していますし、常にベンチマークとして扱われます。

OpenAIは、GPT-3は2020年に公開されています。その後、GPT-3.5が登場し、それをベースにChatGPTをリリースしたタイミングでブレイクスルーが起きました。ChatGPTはLLMではなく、LLMを体感しやすいツールだと思いますが、重要な役割を果たしたのであえて年表に加えています。

その後、GPT-4と進化しましたが、GPT-4oが登場するまでには少し時間がかかりました。その間に後段で解説するClaudeの追い上げを受けていました。しかしGPT-4oでは、動画を理解させて会話できるマルチモーダルの扉を開き、その後、o1、o3と矢継ぎ早に革新的なモデルを発表しています。2024年のOpenAIは有力な社員が抜けてしまい、ライバルであるAnthropicに参画するなど、失速の懸念もありましたが、そんな心配を払拭するような2024年の後半になりました。

なお、新しいo系のモデルは、最近推論型モデルと呼ばれています。高い数学能力や、推論能力に特化したモデルで、推論型モデルの能力を測るのに、MATH(Math Word Problem Solving)やGPQA (Graduate-Level Google-Proof Q&A Benchmark)が利用されます。

また、今月サムアルトマンがo3-miniもリリースするとXで呟いていましたが(補足:記事をアップする前にo3-miniとo3-mini-highも出てしまい話題となっています)、進化の加速が止まらない印象があります。2025年はエージェント元年と言われますが、OpenAIの推論型モデルからも目が離せません。

Anthropic

Anthropic社のClaudeは2023年以降急激に成長し、打倒OpenAIの最有力候補に躍り出ました。また、OpenAIはMicrosoftと密接な関係にありますが、その影響もありAnthropicはAWSやGoogleとの関係性を保っています。バックサポートする巨大クラウドカンパニーの競争も見て取れると思います。

肝心のモデルについてですが、Anthropicを有名にしたのがClaude3.5だと思います。特にSonnetはGPT-4oとよく比較されます。ベンチマークによってはGPTを超えている場合もあります。そういう意味ではかなり勢いがありましたが、それ以降革新的なアップデートが無い状況です。OpenAIがo1とo3を発表していることと比較してしまうと少し物足りなさを感じますが、2025年の発表には期待したいと思います。

Googleは当初Bardを開発していましたが、一度躓いています。そのキャッチアップのためにGeminiを開発し、Gemini1.0のリリースへと漕ぎつけています。また、OpenAIのChatGPTをかなり強く意識しており、他の大手クラウドベンダー(AWSとMicrosoft)よりも独自モデルに力を入れています。そういう意味でもクラウドベンダーの3社の戦略は明確な違いがあり、AIに関してはGoogleが一番奮闘しているとも言えます。

肝心の性能に関してですが、ベンチマークではOpenAIと同等か少し下回ることが多いです。私見ですが半年くらい開発スピードに差がある印象です。ただ、推論型モデルに関しても激しい追い上げを見せており、OpenAIのo1と、GoogleのGemini2.0 Experimentalの差は縮まっています。

Meta

続いてMeta社のLLaMAについてです。LLaMAはOSSとして開発されているため、ブラックボックスではない安心感があります。そのため、位置づけとしてはOSSによる安心感とMeta社が開発しているため信頼度があるものの、安価に実験もしやすいポジションとも言えます。またOSSのため、オンプレミス環境などの自社データセンターでも運用が可能で、実際の利用価値も高いと思います。

一方で性能はというと、2024年にかなり追い上げを見せたものの、先行するOpenAI、Anthropic、Googleには一歩及ばずというポジションと言えると思います。とはいえ、LLaMAは既に公開した記事「OpenAI(ChatGPT)やAnthropicなどの価格を比較してみた」でも書いているように、かなり安価なので試してみる価値は十分にあります。実際のユースケースとして、LLaMAで試してみて性能に満足できなければ他のモデルに切り替えるのが良いでしょう。

Mistral AI

Mistral AIの最大の特徴は米国のモデルではなく、フランス製であるというところでしょう。また、Metaと同様にOSSとしても提供しているところがポイントになります。AIだけでなく、IT技術全般は米国製のものが多いので、日本とヨーロッパはある意味似たような環境にあります。要するに技術を使う側になっているということなんですが、技術のコアを米国に握られているとも言えるので、使う側としてはいろいろな意味で警戒する必要が出てきます。そういう背景もあり、クラウド利用であったり、AIの利用に関しての規制の進化は欧州のほうが早かったりします。

肝心の性能に関しては、先行する3社+Metaには追い付いていないのが実情だと思います。推論型モデルに関しても現状では先行する会社を追いかけているというポジションでしょう。また、日本で利用することを考えた場合、どうしても日本語対応能力を求める必要があるので、そういう場面においてもそこまで期待はできないと思います。

日本製モデル

日本製のモデルに関してですが、海外のものと比べるとそれほど勢いがあるわけでなく、目的特化のモデルと言えると思います。有名どころとしては、サイバーエージェント社のモデル、NTT Data社の「tsuzumi」、NEC社の「cotomi」あたりだとおもいます。

いろいろな講演や事例を聞いていると、日本製モデルの特徴は学習データになると思います。性能面においては海外に劣るものの、学習させているデータの質が高いので、日本語に強かったり、日本独自のデータに強かったりします。そのため、汎用的な利用目的には先行する3社のものを利用しつつ、目的を特化させて利用するのが良いでしょう。

中国製モデル

昨今話題になっているDeepSeekを中心に猛烈に追い上げているのが中国製モデルだと思います。元々中国に関してはGPUの輸出規制もあり、AI技術の進化は遅れるだろうと言われていました。そんな中で登場したのがDeepSeekになるわけですが、性能に関してもかなり高いレベルになっています。ベンチマークにおいて、DeepSeekR1はOpenAIのo1に迫るところまできていることもあり、大きな話題になりました。

DeepSeekの性能もさることながら、最大の特徴は安さだと思います。AI界隈に関しての価格破壊が起こるとも言われましたが、はじめて価格を調べた時には計算を間違ったかと思ったほどでした。とはいえ、価格破壊は技術進化の中では必ず起こるものなので、ある意味正常な進化ともいえると思います。iPhoneが登場して、その後格安スマホが登場していったように、どのようなプロダクトでも発生します。また、一部では回答が中国寄りという指摘もありますが、それは学習したデータが中国のものが多いと思うので仕方がない部分だと思います。重要なのはそこではなくて、どのようなアプローチで開発したかです。学習に関してのコストが低いとか、蒸留の話が出ていますが、その方法論は他社のモデルでも実践できることです。つまり本当のインパクトはDeepSeekのアプローチが他社でも導入されることであって、それはある意味AI業界全体が進化する可能性にもなります。そういう動きを見逃さないことが重要なのでは、と私は考えます。

補足

今回の記事を記載する上でまとめ方に関してはかなり悩みました。できるだけ定量的に比べられないかと思ったので、パラメータ数(LLMの性能をXXBのように表現することがあります)や、ベンチ―マークの値でまとめるかを考えました。ただ、両方の数値は参考になるのですが、その数字でLLMの優劣をつけるのはかなり難しいと思います。LLMにはそれぞれ特徴があり、性能の優劣はユースケースに依存します。そのため、ある程度オブラートに包んだような表現にはなりますが、一般的な評価と位置づけで表現することにしました。利用するにあたり、どのモデルが良いのかは実際に使ってみないとわからないので、その点については補足させて頂きます。

Discussion