🎃

Apple Silicon (M3) Mac で Ollama 上の gpt‑oss を動かしてみた

Apple Silicon (M3) Mac で Ollama 上の gpt‑oss を動かしてみた

ローカル LLM を使うと 利用料ゼロ・オフライン稼働・機密保持 など多くの利点があります。今回は OpenAI が 5 年ぶりに公開した オープンウェイト言語モデル gpt‑oss を、Mac にインストール済みの Ollama をアップデートするだけで動かす手順をまとめます。

gpt‑oss の必要メモリ数の目安

| モデル | パラメータ数 (総計) | 必要メモリ目安 |

|---|---|---|

| gpt-oss-20b | 21 B(MoE、3.6 B active) | CPU RAM 20-24 GB 程度 |

| gpt-oss-120b | 117 B(MoE、5.1 B active) | CPU RAM 64-96 GB 推奨 |

実行環境例

- MacBook Pro (M3 Max)

- メモリ : 128 GB ユニファイドメモリ

- OS : macOS Sonoma 15.x

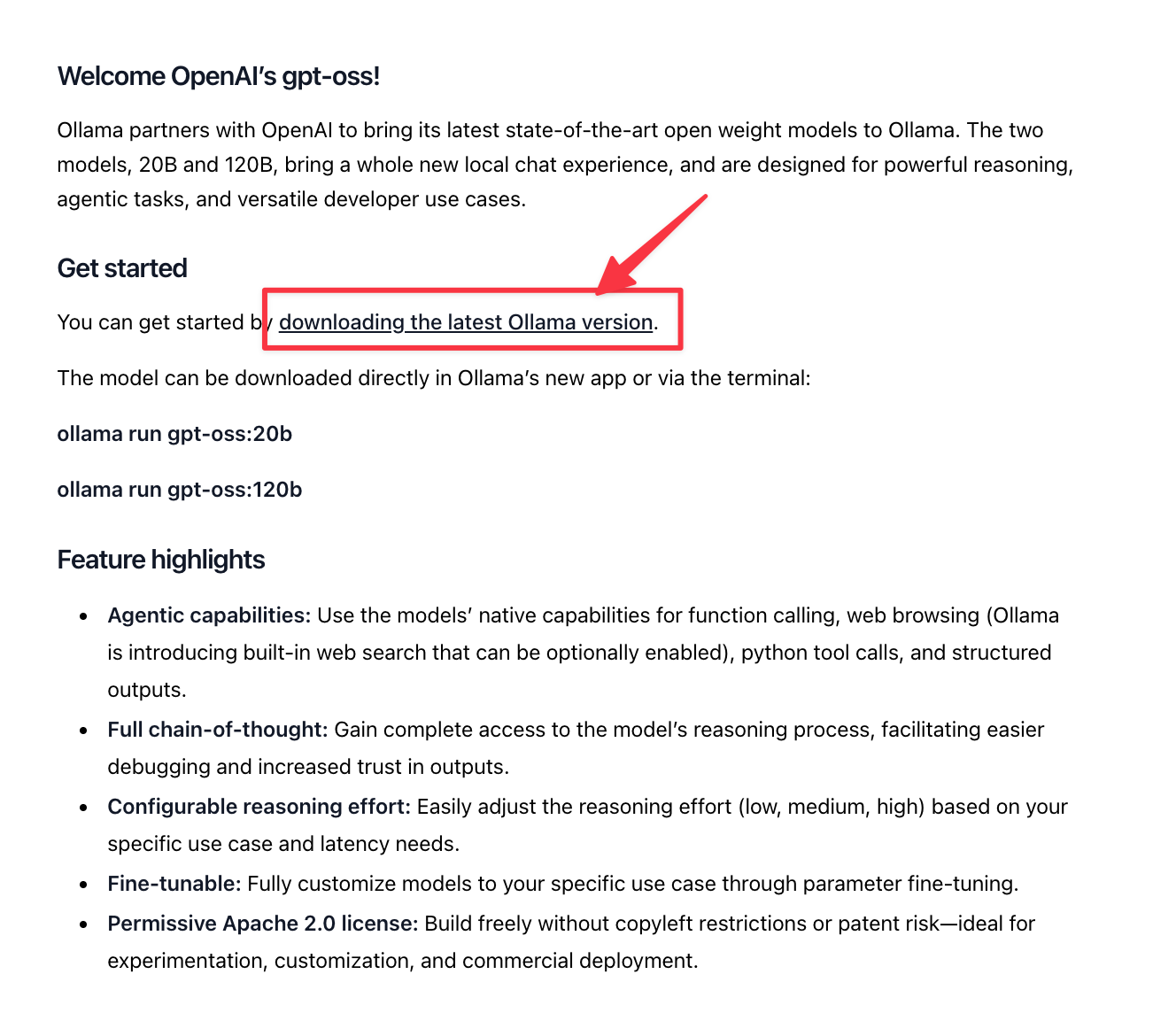

Ollama を最新にアップデート

以下のリンクから最新版をダウンロードしました。

gpt-oss を実行

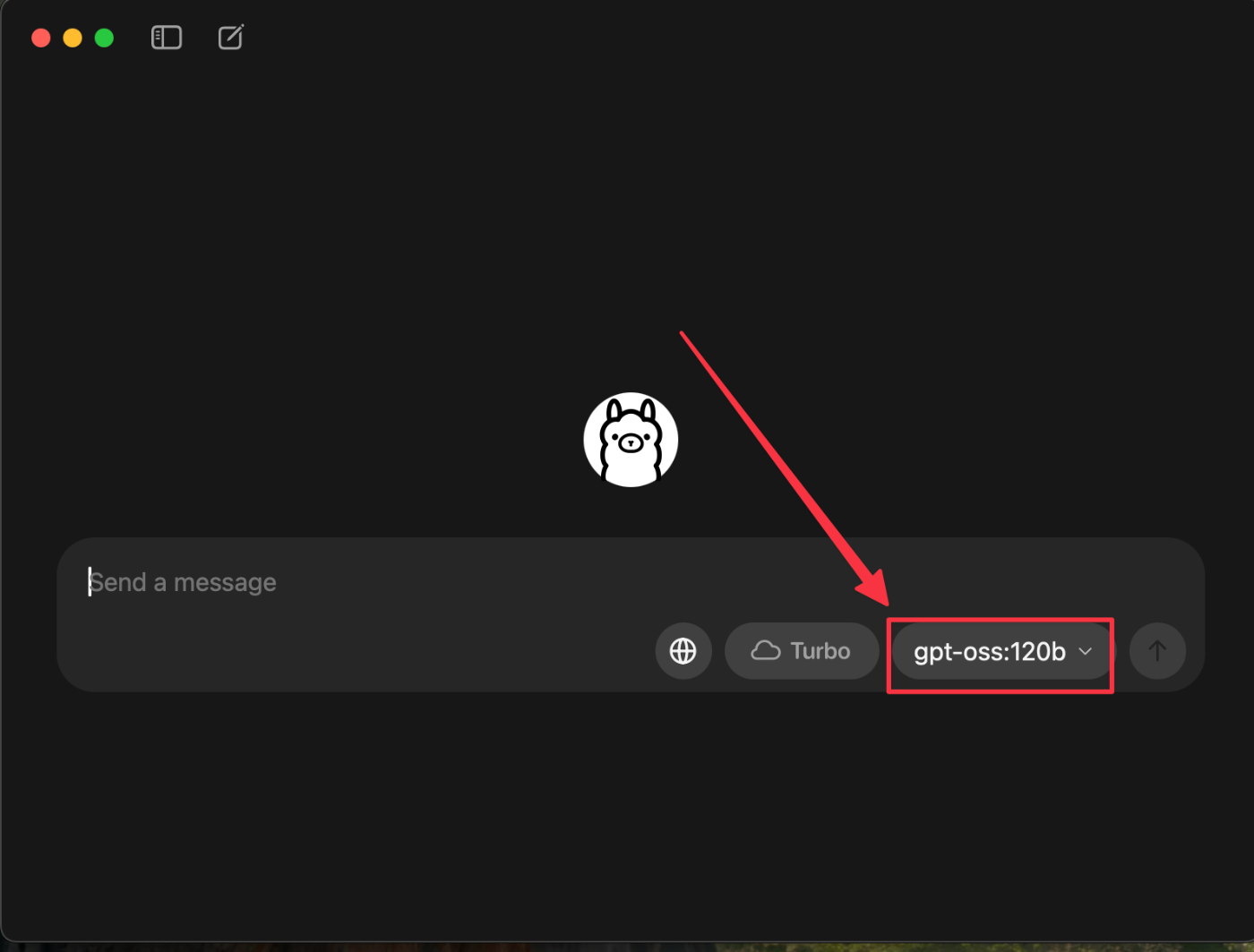

ダウンロードした Ollama を起動すると、モデル選択に gpt-oss が表示されていました。

初回実行時にモデルのダウンロードが実行され、しばらく待つとローカル環境での利用が可能となります。

私のマシーンは96 GB 以上のメモリを搭載していたので 120b がローカルで動作しました。

まとめ

- Ollama 最新版をダウンロードするだけで利用が出来ます。

- 初回実行時にモデルのダウンロードが走ります。

- 最低限 メモリサイズが 20-24GB 以上のマシーンスペックが必要です

注記:この記事の一部は gpt-oss を利用して執筆しています。

Discussion