🦙

OllamaでMistralを動かしてみる

はじめに

- Mistralという7Bモデルの性能が良いらしいので動かしてみたい

- Ollamaというツールを使うとローカルLLMを簡単に動かせるらしい

- ということでOllamaでMistralをローカルPC上で動かしてみた

環境

- OS: WSL2 Ubuntu 22.04

- GPU: なし

- メモリ: 16GB

Mistralの概要

- Mistral 7B The best 7B model to date, Apache 2.0

- Mistral AI社開発の7Bモデル

- Apache2.0ライセンスで商用利用可能

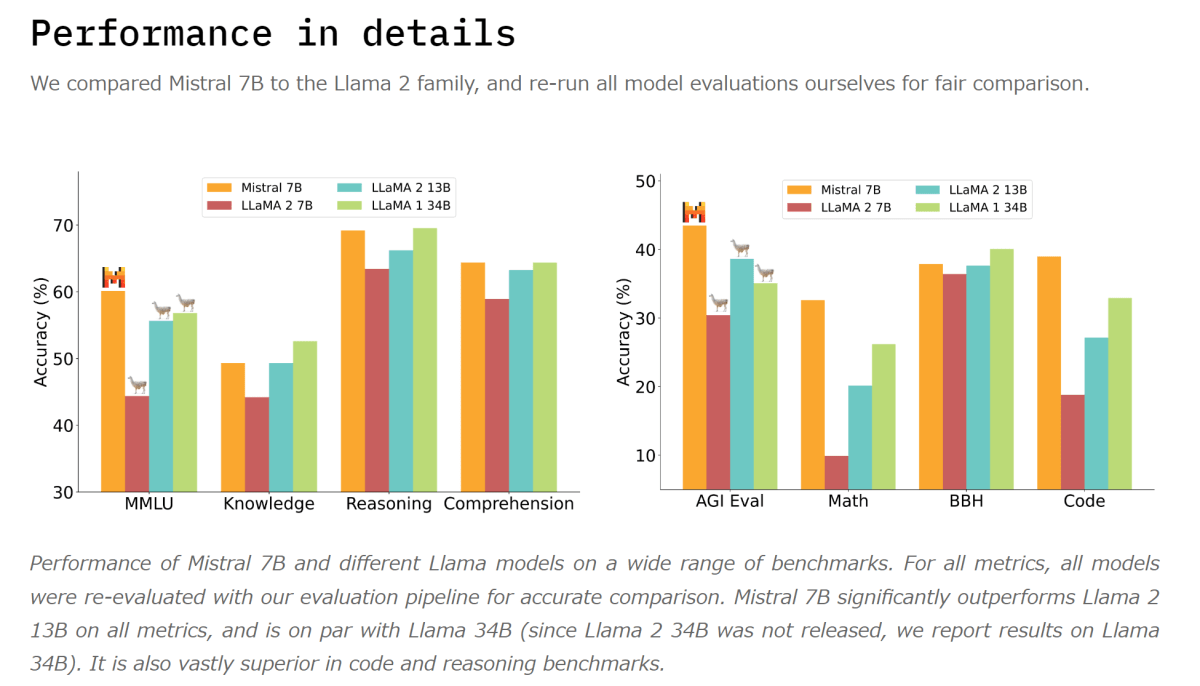

- ベンチマークでLLaMa 13Bを超える性能を出しているらしい

- "Math"や"Code"の成績が良い

Ollamaのインストール

- 公式サイトの通り

$ curl https://ollama.ai/install.sh | sh

- インストールできたことを確認

$ ollama --help

Large language model runner

Usage:

ollama [command]

Available Commands:

serve Start ollama

create Create a model from a Modelfile

show Show information for a model

run Run a model

pull Pull a model from a registry

push Push a model to a registry

list List models

cp Copy a model

rm Remove a model

help Help about any command

Flags:

-h, --help help for ollama

Ollamaサーバの起動

- モデルのダウンロードや起動のために必要

$ ollama serve

2023/10/06 02:48:22 images.go:996: total blobs: 4

2023/10/06 02:48:22 images.go:1003: total unused blobs removed: 1

2023/10/06 02:48:22 routes.go:564: Listening on 127.0.0.1:11434

2023/10/06 02:48:22 routes.go:584: Warning: GPU support may not enabled, check you have installed install GPU drivers: nvidia-smi command failed

Mistralモデルのpull

- 以下のコマンドでMistralモデルをpullできる

$ ollama pull mistral

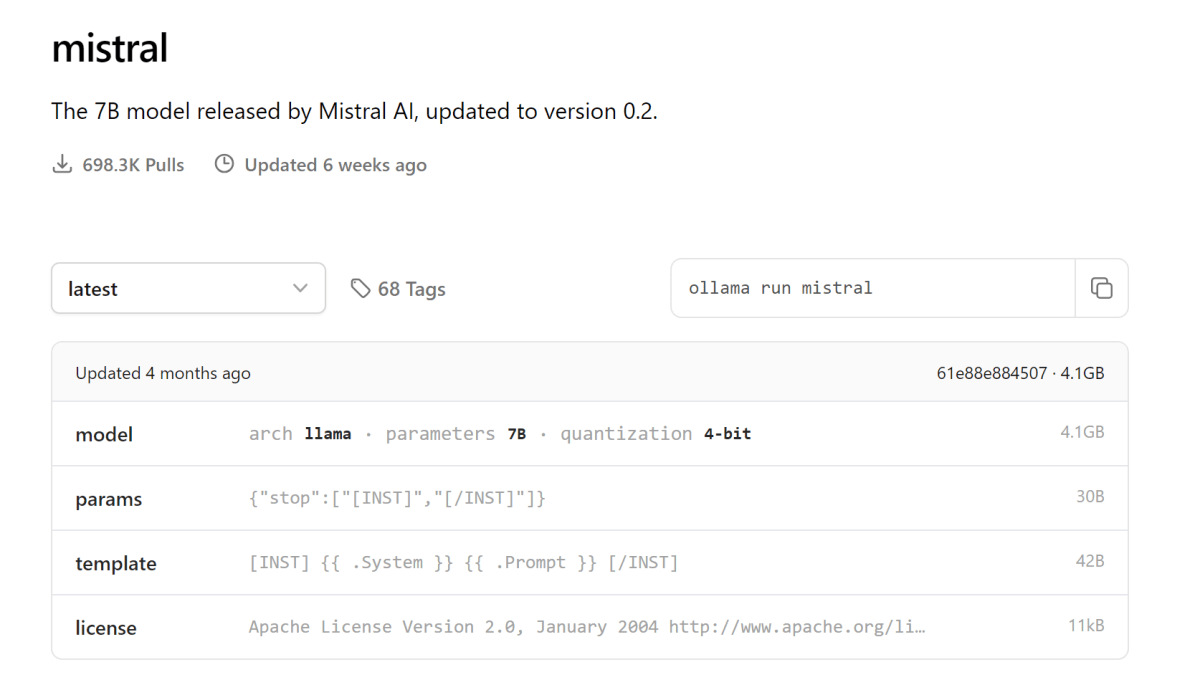

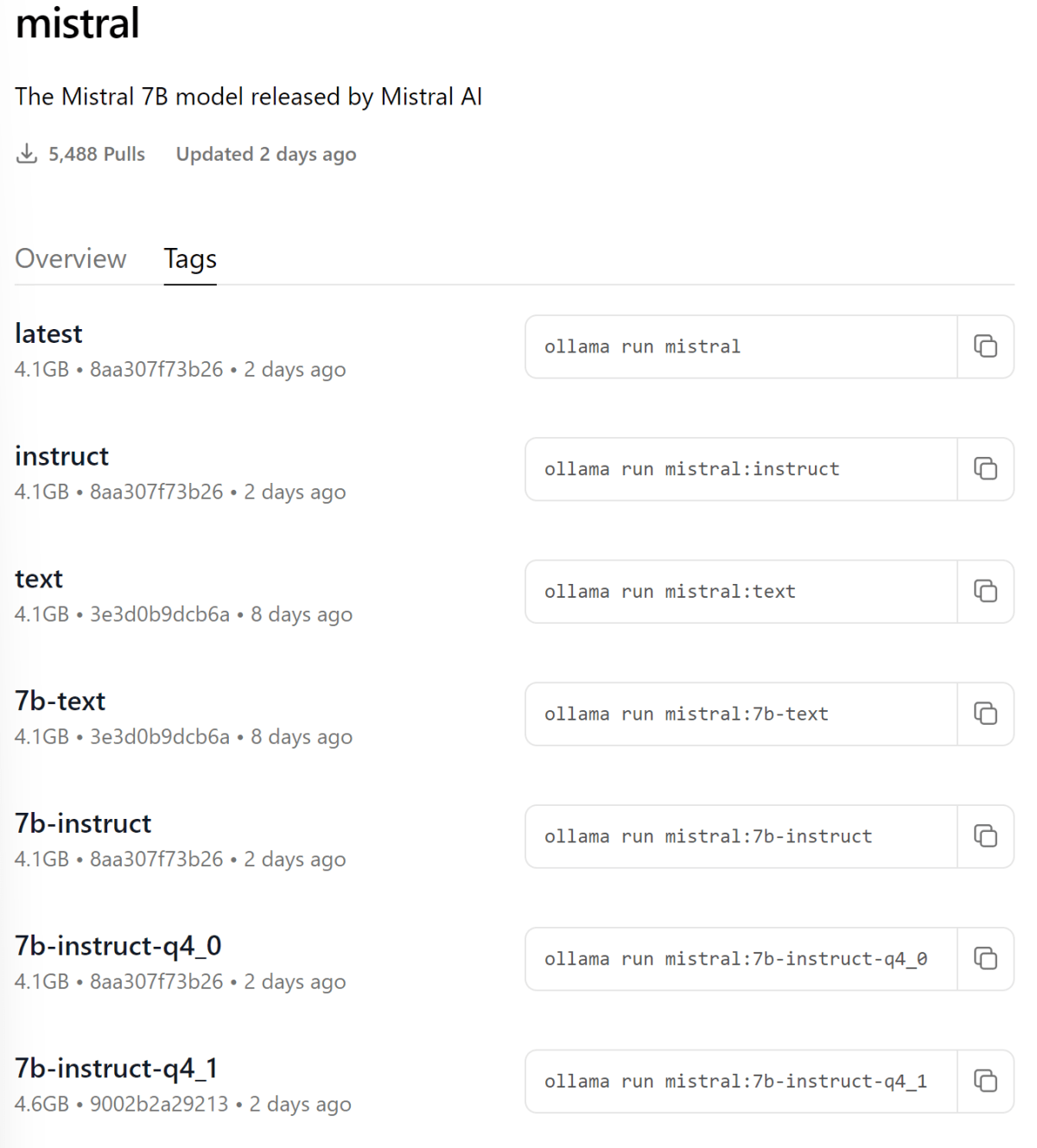

- タグ無しだと7Bモデルの4bit量子化版がダウンロードされるよう

- タグで量子化等のオプションも指定できそう

Mistralモデルの実行

$ ollama run mistral

>>> 自己紹介して

Hi, I'm an AI language model designed to help you find information and answer your questions. How can I assist you today?

>>> 日本語はわかる?

申し訳ありがとうございます。私は日本語を理解できます。どのように彼女を助けられますか?

感想

- Ollamaは簡単にローカルLLMを動かせて便利

- Mistralは日本語苦手そう

Discussion