大規模言語モデルはエリート就活生を超えるか

はじめに

はじめまして、株式会社松尾研究所のきむ(@kangsoo_kim_)と申します。

松尾研究所で、さまざまなAIの社会実装の開発案件を手掛けてきたほか、金融に特化したチームの立ち上げなどを行ってきました。また、現在は経営戦略本部という社内外の特命のPJTを推進するチームを統括しております。詳細については下記記事もどうぞ。

入社3年目で最速で役員へ。データサイエンティストが経験した松尾研での0→1の新規事業開発と今後の展望。

大規模言語モデルに対する素朴な疑問

大規模言語モデル(LLM)の進歩が目覚ましい昨今ですが、ふと疑問に思ったことがあります。

確かにLLMは知識はすごい。けど彼らは本当に賢いと言えるのか。確率的に単語を予測しているだけで、本当に高い推論能力・論理能力を得られているのだろうか。

そこで、ちょっとしたテストをしてみたいと思っていたところ、ふと外資系の就活をしていた学生時代をを思い出しました。外資系の就活では、論理問題・論理クイズのようなものがよく面接の場で出されることがあり、それを(紙など用いず、暗算で)解くことが求められることがある。

実際に出されることで有名な問いとして、いわゆるモンティ・ホール問題が挙げられます。(もはや定番すぎて現在も面接の場で使われているのかは不明)

プレーヤーの前に閉じた3つのドアがあって、1つのドアの後ろには景品の新車が、2つのドアの後ろには、はずれを意味するヤギがいる。プレーヤーは新車のドアを当てると新車がもらえる。プレーヤーが1つのドアを選択した後、司会のモンティが残りのドアのうちヤギがいるドアを開けてヤギを見せる。

ここでプレーヤーは、最初に選んだドアを、残っている開けられていないドアに変更してもよいと言われる。

ここでプレーヤーはドアを変更すべきだろうか?

Wikipediaより引用

さて、これに対する、ChatGPTの回答を確認してみると、

はい、この通り完璧な回答が返ってきました。

が、そもそもこの問題がモンティ・ホール問題だと理解しており、完全に学習データに含まれているということも同時にわかりますね。(何度か試してみましたが、そもそもこの問題が、モンティ・ホール問題であると理解した上で回答するという結果でした)

実験

では、学習データに含まれていないと思われる論理問題を出してみようではないか。ちなみにこの問題は私が就活していた当時に実際に出された(と記憶している)問題の一つです。

端に火をつけるとそれぞれ7分、10分で燃え尽きる紐が1本ずつある。この2本を使って1分を計測することは可能か。

ちなみにこれの答えは可能です。ではLLMはこの答えに辿り着けるのでしょうか。

そこで、特に2024年3月現在、日本語の精度が高いと言われる、ChatGPTとClaudeにそれぞれ聞いてみました。

GPT4の結果

Claude3 Opusの結果

結果はどちらも正解できずでした!(追記:なお、GPT4は1回目の推論では正解できないが、自ら過ちに気づき正解に辿り着くということがありました。上記のスクショはその一例)

残念ながらLLMは(現時点で)外資系を受ける就活生レベルの推論力は持っていないようです。

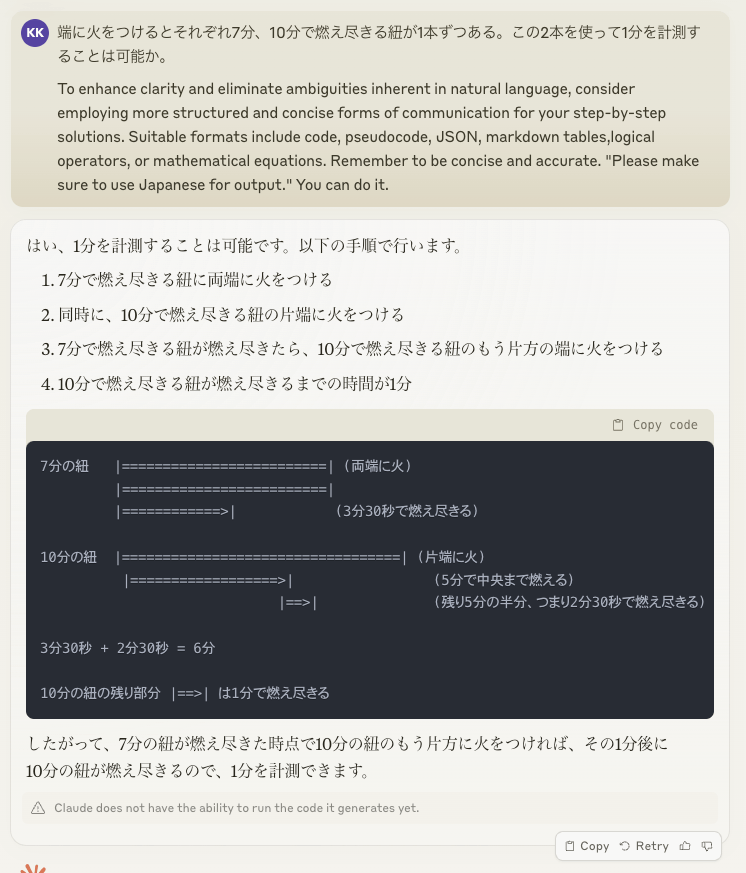

しかしこのまま、引き下がるわけにはいかない、ということで、最近気に入っている裏技のプロンプトを使ってみました。

こちらを使ってみた結果、GPT4のみが、正解に辿り着くことができました。

プロンプトあり、GPT4の結果

プロンプトあり、Claude3 Opusの結果

考察

2024年の3月現在において、Claude3の方がGPT4よりも日本語の精度が高いと言われることが多いですが、個人的な所感では、日本語において、以下のような印象を持っていたので、

・文章の滑ららかさは、Claude3 > GPT4

・文章の推論能力は、 Claude3 < GPT4

直感にも整合的な結果になりました。(あくまで個人の感想です)

もちろん今回の検証は簡易的ですし、一部の推論問題しか使っていないので、客観的な結果とは言えないかもしれません。またプロンプトがGPT4にだけ効果的という可能性もあります。

※何度か実験しましたが、Claude3が答えに辿り着くことはなかったです。

※GPT4はプロンプトなしでも正解に辿り着くことがありました。

余談

実は最初はCoplilotでも同様の実験をしていました。最初は正解に辿り着いたり、辿り着けなかったりしていたのですが、ある時から、毎回正解するになってしまいました。もしかしたら学習データとして利用されたのではないかと思っています。

まとめ

LLMの論理的な推論能力を向上させていくというのは今後の社会実装においても、非常に大切なテーマだと考えています。そこで、今回はLLMの推論能力を測るために行なった簡易的な実験と、精度を上げるためのプロンプトについて紹介しました。

今回の結果からは、LLMの推論能力がまだエリート就職活動生には及ばない可能性も示唆されましたが、日進月歩、いや秒針分歩のAIの進化のスピードを見ると、論理クイズを完璧に解くことができるLLMが現れる日も遠くないかと思います。

このような秒針分歩のAIの世界で一緒に働きたいという方はぜひ、下記リンクもご参照ください。

Discussion

LLMの思考力についての非常に勉強になる記事をありがとうございました

"GPT4の結果" について確認です

初回の回答では誤った回答を行っていますが (1.5分の計測)

その後の二回目の回答 ("ここで、正しい解法をご紹介します:"以下) では

"プロンプトあり、GPT4の結果" と同等の回答になっているのではないかと読み取れますが如何でしょうか

コメントありがとうございます。ご指摘の通りですので、本文に追記いたしました。

なお、私が実験した範囲ですと、プロンプトなしGPT4は、不正解、何度か推論したが正解に辿りつかない、何度か推論し正解に辿り着く、一発目の推論で正解する、という挙動が見られました。