Chain-of-Draft (CoD) がプロンプティングの王座に君臨!? CoTを超える精度とコスパを徹底解説!🎉

3秒まとめ

- Chain-of-Draft (CoD) は、Zoomの研究者が発表した新しいプロンプティング技術

- 従来の Chain-of-Thought (CoT) よりも高い精度を出しながら、推論に使うトークン量を 7.6% まで激減させられる、まさに革命的な手法!

- これからのLLM開発では、CoDがコストとパフォーマンスの最適解になるかも

どんな人向けの記事?

- LLMのプロンプティングで、精度とコストのバランスに悩んでいる方

- Chain-of-Thought (CoT) は知ってるけど、もっと良い方法を探している方

- 最新のAI技術トレンドをサクッとキャッチアップしたい方

*本記事の30%ほどはAIにより作成されました

はじめに

LLMのプロンプティング、色々試してるけど「もっと精度が欲しいな...」「でも、APIコストがどんどん膨らむ...」なんてこと、ありませんか?

ぼくも普段、AI系のツールを触っていると、このジレンマにいつも頭を悩ませています。特に、複雑なタスクをお願いしようとすると、どうしてもプロンプトが長くなって、思考の連鎖(Chain-of-Thought)を促す必要が出てきますよね。

CoTは確かに強力ですが、その分、生成されるトークン量が多くなりがちで、レスポンス速度やコスト面に課題がありました。

そんな中、「CoTの時代は終わった...?」 と思わせるような、とんでもない論文が登場しました。

それが、今回紹介する Chain-of-Draft (CoD) です

この記事では、CoDがなぜ「新しい王様」と呼ばれるのか、その仕組みと驚くべき成果を、分かりやすく解説していきますね!

これまでの王様「Chain-of-Thought (CoT)」とは?

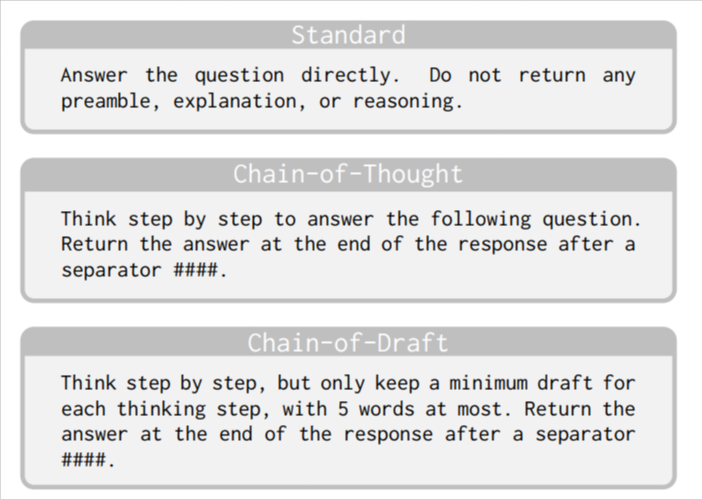

まずはおさらいから。Chain-of-Thought (CoT) プロンプティングは、LLMに複雑な問題やタスクを与える際に、「ステップ・バイ・ステップで考えて」と促す手法のことです。

例えば、「日本の首都は?」と聞くのではなく、「日本の首都を特定するための手順をステップバイステップで考えてください」とお願いするイメージ。これにより、LLMは思考の過程を文章として出力し、より正確な結論にたどり着きやすくなります。

このCoTの登場で、LLMの推論能力は飛躍的に向上しました。まさに、LLMの可能性を切り開いた立役者と言えるでしょう。

CoTから派生したプロンプティング技術には、Tree of Thoughts (ToT)などがあり、精度向上が確認されていますが、これらの技術には共通した弱点が存在します。

でも、CoTには弱点もあった...

しかし、その栄光の裏で、CoTにはいくつかの無視できない弱点がありました。

- 燃費の悪さ(高コスト・高レイテンシ): CoTは思考の過程をすべて文章として生成するため、トークン消費量が非常に多くなります。これはAPIの利用料金に直結し、お財布に優しくありません。また、生成に時間がかかるため、ユーザーを待たせてしまうという問題もありました。

- 一本道で後戻りできない: CoTの思考プロセスは、一度始まると修正が効かない「一本道」です。途中で論理的な間違いがあっても、そのまま突き進んでしまい、最終的に誤った結論に至ることがありました。

- 品質の不安定さ: プロンプトのちょっとした違いで、生成される思考の質が大きく変わってしまうことがあり、安定した結果を得るのが難しい場合がありました。

これらの弱点があったからこそ、「もっと効率的で、もっと賢い方法はないのか?」という探求が続けられてきたのです。

新時代の覇者「Chain-of-Draft (CoD)」とは?

さて、本題の Chain-of-Draft (CoD) です。これは、Zoomの研究者チームによって発表された、まったく新しいアプローチのプロンプティング技術です。

CoDのアイデアは、人間が複雑な問題を考えるときの思考プロセスから着想を得ています。ぼくたちが何かを考えるとき、頭の中で長々とした文章を組み立てるのではなく、要点だけをメモ書きのように書き出していくことが多いですよね。CoDは、この効率的な思考法をLLMに模倣させます。

その具体的な方法が、驚くほどシンプルなんです。

「ステップバイステップで考えてください。だだし、各思考ステップごとに最大 5 語の最小限の下書きのみを残します。」

CoDは、この指示をモデルに与えるだけ。ただし、モデルにこの「CoDスタイル」を理解させるために、プロンプトの中に**Few-shot(いくつかの例示)**として、手動で作成した簡潔な思考ステップの例を含めます。

面白いのは、この「5単語以内」というルールは厳密に強制されるわけではなく、あくまでモデルに対する「ガイドライン」として機能する点です。

CoTが詳細な説明を例示するのに対し、CoDは極めて簡潔な思考の「ドラフト(草稿)」を例示することで、モデルの出力をより効率的な方向へと導くのです。

CoDの驚くべき成果

「理屈はわかったけど、実際どれくらいすごいの?」って思いますよね。

論文で示されたデータを見ると、本当に驚きます。下のグラフは、Claude 3.5 Sonnetを使って、いくつかの推論タスクにおける精度(Accuracy)とトークン使用量(Token Usage)を比較したものです。

*出典: Chain-of-Draft (CoD) Is The New King Of Prompting Techniques

見てください、この結果!

- 精度 (Accuracy): CoDは、多くのタスクでCoTを上回るか、同等の精度を達成しています。

- トークン使用量 (Token Usage): ここが一番の驚きポイントですが、CoDはCoTに比べて、使用するトークン量が劇的に少ないんです。論文によると、なんと CoTのわずか7.6% のトークンで済むケースもあったとか...!

これは、まさに革命的じゃないでしょうか?

精度を落とさずに(むしろ向上させながら)、コストと待ち時間を大幅に削減できるなんて、開発者にとっては夢のような話です。

なぜCoDはこれほど優れているのか?

CoDがCoTを凌駕する理由は、その 「人間的な思考の模倣による効率化」 にあると考えられています。

CoTは、思考のすべてを詳細に言語化することで精度を担保しようとしましたが、その結果として大量のトークンを消費するという「燃費の悪さ」を抱えていました。

一方、CoDは、「各ステップ5単語以内」 という具体的な制約をガイドラインとして設けることで、LLMに思考の要点だけを抽出させます。これにより、LLMは冗長な説明を生成するコストから解放され、推論の核心部分に集中することができます。

人間がメモを取りながら思考を整理するように、本質的でない情報を削ぎ落とす。このシンプルながらも強力なアプローチが、精度を大きく損なうことなく(タスクによっては向上させながら)、コストと速度を劇的に改善する鍵となっているのです。

まとめ

今回は、新しいプロンプティング技術「Chain-of-Draft (CoD)」について解説しました。

- CoDは思考の要点だけを簡潔に記述するアプローチ

- CoTを超える精度と、圧倒的なコスト効率を実現

- 今後のLLM開発のスタンダードになる可能性を秘めている

LLMの進化は本当に速くて、キャッチアップするだけでも大変ですが、CoDのような技術が登場することで、ぼくたちの開発はもっとクリエイティブで、もっと効率的になっていくはずです。

個人的にも、AIエージェントの開発中は特にトークンを莫大に消費するため、CoDをすぐにでも自分のプロジェクトで適用し、トークン量とレスポンスタイムの向上に役立てたいと考えています。

おまけ

私はMinedia,inc.にて、AIエージェントやFlutter/Go/GCPを使ったアプリ開発を開発しています。AIを活用した業務効率化ツールの開発などをしています。薬剤師としての経験を活かして、医療分野の課題をテクノロジーで解決することにも挑戦中です。

最新のAI技術や開発手法については、これからもどんどん発信していくので、良かったらZennやTwitterのフォローをお願いします!

面白い技術やアイデアがあったら、ぜひ教えてくださいね!

ではまた!🙌

Discussion