【ML Tips / LLM Tips】Google Colabについて📝

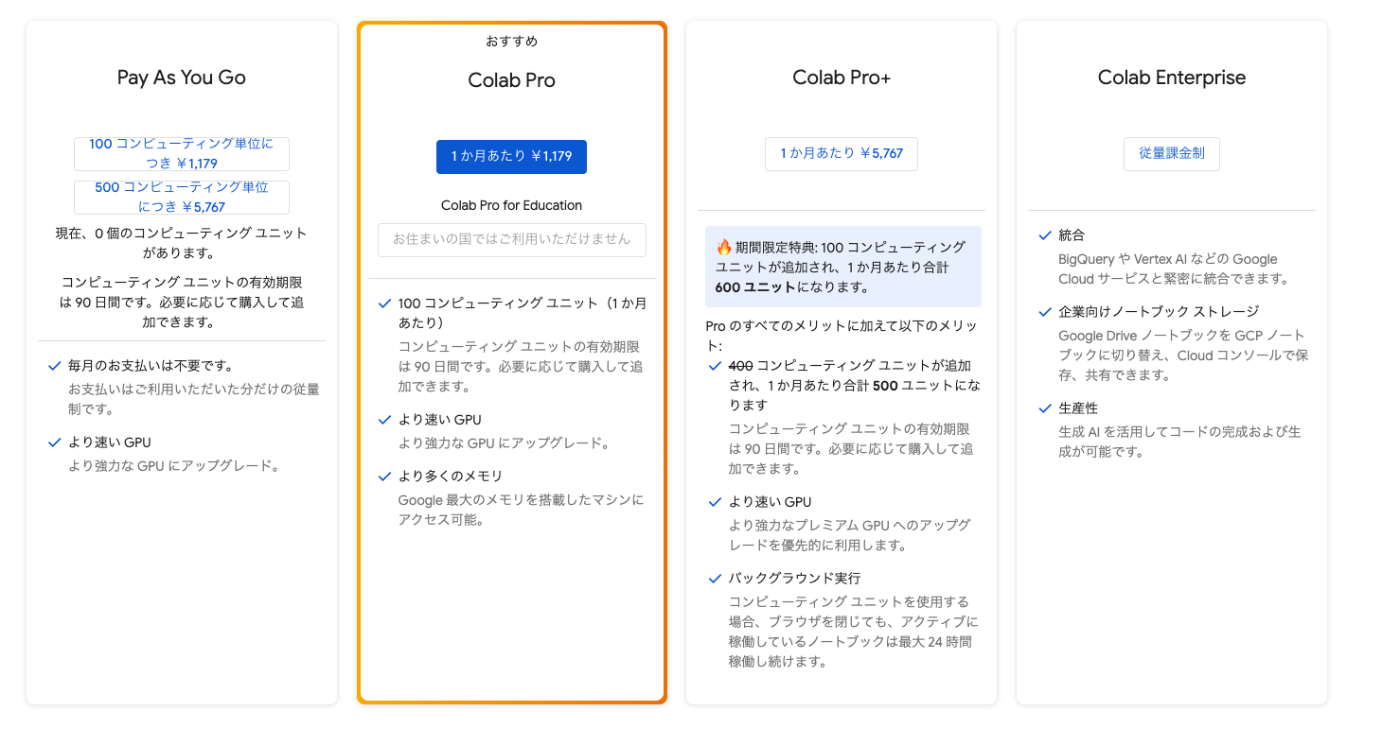

Google Colabの有料プランについて📝

Google Colabの定期購入やスポット購入について📝

100コンピューティングユニットだけスポット購入とかもできる📝

Colab の定期購入を最大限に活用する📝

Google Colabの定期購入を解約する

【Google Colab入門】無料でPythonを動かせる!基本の使い方📝

Google Colabの制限と対策📝

Google Colabで使えるGPUについて📝

Google Colab で現在(2025 年 7 月時点)利用できる GPU とその使い方 を、プラン別の特徴・GPU タイプ・料金体系・制限・確認方法・最近のアップデートの順に整理します。

要点だけ先にまとめると――無料枠では主に T4 (16 GB) が割り当てられ、Pro 以上にすると V100/L4 が増え、Pro+ や十分な Compute Unit があれば A100 (40 GB/80 GB クラス) も手に入ります。

計算コストは「Compute Unit(CU)」で課金され、T4≈11.7 CU/h、A100≈62 CU/h が目安です(thundercompute.com)。

ノートブック実行は無料版で最長 12 h、Pro+ なら最長 24 h(アイドル時は短縮)(research.google.com)。以下で詳細を確認しましょう。

プラン別 GPU 割り当て

| プラン | 主な GPU タイプ | セッション上限 | メモ |

|---|---|---|---|

| Free | T4 16 GB(稀に P4/P100)(Medium) | 12 h / 接続 | GPU タイプは完全ランダム |

| Pay‑As‑You‑Go | Free と同じだが CU 消費開始 | 12 h | 100 CU=US$ 9.99([mccormickml.com][4]) |

| Colab Pro | T4 が中心、混雑時に V100/L4 へ切替可 | 12 h | 月 US$ 9.99 + CU |

| Colab Pro+ | T4 / V100 / L4 に加え A100 40 GB (80 GB) が「空き次第」で割当([mccormickml.com][4]) | 24 h | 月 US$ 49.99 + CU |

| Colab Enterprise* | T4 / V100 / A100 / L4 を組織契約で確保 | 24 h+ | GCP 連携。VM 専有で制限緩和 |

*Enterprise は学校・企業向け。FAQ では専用 VM により Colab の制限を外せると明言(research.google.com)。

GPU の主要スペック

| GPU | 世代 | VRAM | CUDA Core | 代表的性能 (FP16/Tensor) | 参考 |

|---|---|---|---|---|---|

| T4 | Turing | 16 GB | 2 560 | 65 TFLOPS FP16([NVIDIA][5]) | |

| L4 | Ada Lovelace | 24 GB | 非公開 (30.3 TFLOPS FP32) | 120 TFLOPS TF32([NVIDIA][6]) | |

| P100 | Pascal | 16 GB | 3 584 | 18 TFLOPS FP16 (※参考) | |

| V100 | Volta | 16 GB / 32 GB | 5 120 | 125 TFLOPS Tensor | |

| A100 | Ampere | 40 GB / 80 GB | 6 912 | 312 TFLOPS FP16、MIG 対応([NVIDIA][7]) | |

| K80 (終了) | Kepler | 12 GB×2 | 4 992 | 8.7 TFLOPS FP32(2024/5/1 で EOS)([Google Cloud][8]) |

ポイント

- L4 は T4 の約 2.2 倍、A100 は T4 の約 6 〜 13 倍速という実測報告があります([mccormickml.com][4])。

- A100 と L4 は bfloat16 対応で安定学習に有利([mccormickml.com][4])。

- K80 は 2024 年に Colab から完全撤去済み。

Compute Unit と課金イメージ

| GPU | おおよその CU/h | US$/h (10 CU=US$1 換算) | 1 時間あたりセッション残存時間 (100 CU 保有時) |

|---|---|---|---|

| T4 | ≈ 11.7 CU(thundercompute.com) | ≈ $1.17 | 約 8.5 h |

| V100 | ≈ 4.9 CU (Pro+)([mccormickml.com][4]) | ≈ $0.49 | 約 20 h |

| L4 | ≈ 4.8 CU (Pro+)([mccormickml.com][4]) | ≈ $0.48 | 約 20 h |

| A100 | ≈ 62 CU(thundercompute.com) | ≈ $6.20 | 1.6 h |

節約術:

- T4 でコード開発 → 収束確認や本番学習だけ A100 に切替([mccormickml.com][4])

- 長時間ジョブは CU 消費効率の良い V100/L4 を狙う

- CU が尽きたら自動で Free 基準に落ちるので注意(research.google.com)

実行時間・セッション制限

- Free/Pay‑As‑You‑Go/Pro: 1 セッション最長 12 時間、アイドル数分で切断の場合あり。

- Pro+: 連続実行は 24 時間まで延長。ただし CU が尽きるとそこで停止。

- 制限は「公開していない」動的ポリシーで時期により変動する旨が公式 FAQ に明記(research.google.com)。

GPU 割り当てを確認する方法

ノートブック内で次を実行すると現在の GPU とメモリ占有状況が確認できます。

!nvidia-smi -L # GPU 型名を表示

!nvidia-smi # 温度・VRAM 使用量など詳細

GPU を有効にしていない場合は「Runtime ▶ Change runtime type ▶ Hardware accelerator = GPU」を選択すると Stack Overflow 答えにある通り割り当てが復活します([Stack Overflow][9])。なお実行中でも GPU 稼働率が 0 % なら CPU 実行になっている可能性があるので要確認([Stack Overflow][10])。

最近のアップデート & ニュース

- K80 完全撤去(2024/5/1)により無料枠でも T4 が標準化([Google Cloud][8])。

- Compute Unit 制導入(2024 年)で従量課金が明確化([mccormickml.com][4])。

- L4 GPU 追加(2024/Q2)で Pro/Pro+ の選択肢拡充、T4 比 2×弱の性能アップ([NVIDIA][6])。

- Colab Enterprise 経由で GCP GPU(H100 など)も使えるが別契約が必要(research.google.com)。

まとめ&活用ヒント

- 学習・検証フローを分ける:開発は T4(Free/Pro)で費用節約、本番学習・大規模推論は A100/L4 を短時間で回す。

- CU 残量の監視:右上「View resources」パネルで残 CU と消費レートを随時チェック([mccormickml.com][4])。

- 長期ジョブは外部クラウドと比較:Thunder Compute などでは A100 が Colab より低価格で 24 h+ 継続接続できるとの比較例あり(thundercompute.com)。

- 突然のダウングレード対策:A100 が枯渇すると自動で V100 へ降格されるため、再接続や時間帯調整で空きを狙う([GitHub][11])。

これらを踏まえ、**「T4 で作り、A100 で回す」**を基本戦略にすると Colab の GPU を最もコスト効率良く利用できます。

[4]: https://mccormickml.com/2024/04/23/colab-gpus-features-and-pricing/ "

Colab GPUs Features & Pricing · Chris McCormick

"

[5]: https://www.nvidia.com/en-us/data-center/tesla-t4/?utm_source=chatgpt.com "NVIDIA T4 Tensor Core GPU for AI Inference | NVIDIA Data Center"

[6]: https://www.nvidia.com/en-us/data-center/l4/?utm_source=chatgpt.com "L4 Tensor Core GPU for AI & Graphics - NVIDIA"

[7]: https://www.nvidia.com/en-us/data-center/a100/?utm_source=chatgpt.com "NVIDIA A100 Tensor Core GPU"

[8]: https://cloud.google.com/compute/docs/eol/k80-eol?utm_source=chatgpt.com "NVIDIA K80 end of support - Compute Engine - Google Cloud"

[9]: https://stackoverflow.com/questions/62697331/nvidia-smi-has-failed-because-it-couldnt-communicate-with-the-nvidia-driver-ma?utm_source=chatgpt.com "NVIDIA-SMI has failed because it couldn't communicate with the ..."

[10]: https://stackoverflow.com/questions/60299967/how-to-get-allocated-gpu-spec-in-google-colab?utm_source=chatgpt.com "How to get allocated GPU spec in Google Colab - Stack Overflow"

[11]: https://github.com/googlecolab/colabtools/issues/4505?utm_source=chatgpt.com "Google Colab Pro+ not access A100 GPU · Issue #4505 - GitHub"