Open Interpreter の調査・まとめ

まずは Open Interpreter を Docker で使ってみる

Open Interpreter凄いのですが、問題は凄すぎる点ですね。

ガンガンコマンドを実行するので、ローカルで動かしたら凄い勢いで環境が汚れていきます。

デフォルトのプロンプトは安全側に倒されていますが、それでもファイルを消されたりする可能性もゼロではないですし、色々実験したくもなりそうです。

というわけで、闇のエンジニアである からあげさんの指南(記事の内容)に則って、Open Interpreter をDockerで構築していきます。

- まずは、からあげさんのリポジトリをクローンします。

git clone https://github.com/karaage0703/open-interpreter-docker

- 次に、Dockerfileをビルドします(Docker Image の作成)

cd open-interpreter-docker

docker image build -t open-interpreter-simple ./container-simple

- 動かしたい時は、Docker Container を Runする

docker container run -it --rm -v $(pwd):/root open-interpreter-simple

- コンテナが立ち上がるので、コンテナ内でOpen Interpreterを実行します。

root@hostname:~# interpreter -y

- Open Interpreter の初期SetUpを実施する

Open Interpreterを実行すると、質問されるので、それに答えていきます。

ここからは、からあげさんの記事の手順にもなかったので、独自判断で行きます。。。

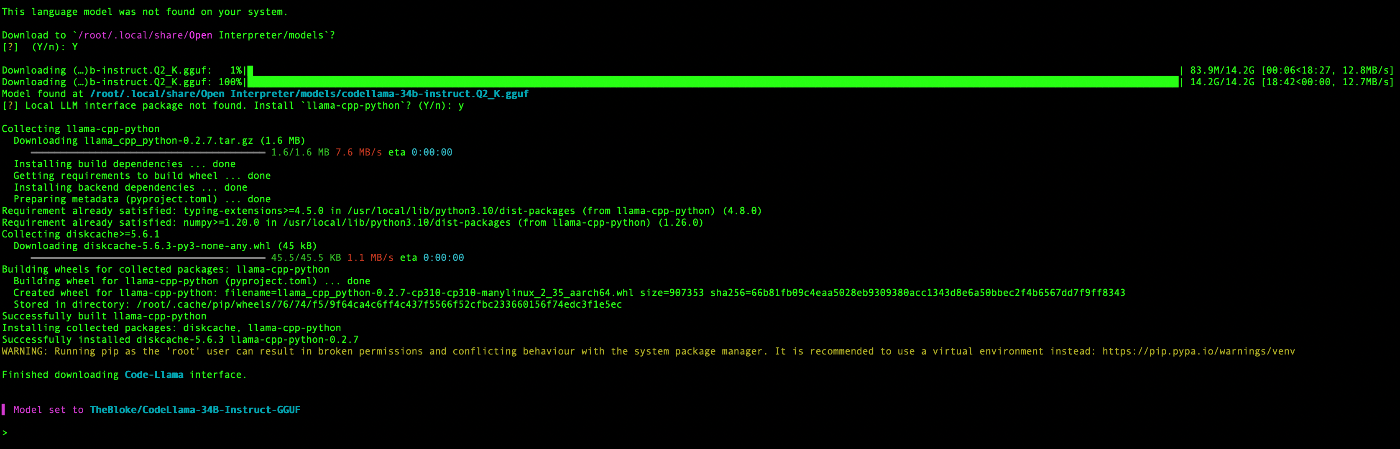

すべて回答して、言語モデルをDownloadしている状態の画面は、次のとおり。

1つ1つ回答内容について見ていきます。

5-1. Open Interpreter を実行するモデルの選択

OpenAI API key not found

To use GPT-4 (recommended) please provide an OpenAI API key.

To use Code-Llama (free but less capable) press enter.

- 無料の Code-Llama を選択しました。

5-2. モデルで使用するパラメータ数の選択

Open Interpreter will use Code Llama for local execution.

Use your arrow keys to set up the model.

[?] Parameter count (smaller is faster, larger is more capable): 34B

7B

13B

34B

- 今回は、34Bを選択しました。

5-3. サイズの選択

Quality (smaller is faster, larger is more capable): Small | Size: 13.2 GB, Estimated RAM usage: 15.7 GB

Small | Size: 13.2 GB, Estimated RAM usage: 15.7 GB

Medium | Size: 18.8 GB, Estimated RAM usage: 21.3 GB

Large | Size: 33.4 GB, Estimated RAM usage: 35.9 GB

See More

-

ご丁寧に、サイズに応じた推定 RAM使用量も掲載してくれています。

-

まずは、小型のサイズで試してみます。

5-4. GPUを使用するかどうか?

Use GPU? (Large models might crash on GPU, but will run more quickly) (Y/n):

- GPUを使用してみます。

5-5. 言語モデルの Install

This language model was not found on your system.

Download to/root/.local/share/Open Interpreter/models?

[?] (Y/n):

- 言語モデルの Installをしていいかを聞かれるので、yesを選択します。

5-6. llama-cpp-pythonのパッケージをインストール

[?] Local LLM interface package not found. Install

llama-cpp-python? (Y/n): y

-

llama-cpp-pythonを Installをしていいかを聞かれるので、yesを選択します。 - ちなみに、

llama-cpp-pythonは、LLaMA(Large Language Model Meta AI)をローカルマシン上で使用できるようにするためのツールです。

ここまでで、セットアップ完了です!

[ 参考・引用 ]

Open Interpreter の参考になる記事

Open Interpreter のリスク・デメリット

- 環境をぶっ壊す・カオスにする恐れがある。。。

- 目的を達成するために、自動で、いろんなコマンドをバシバシ使うので、思わぬ createやdeleteで、環境をカオスにする可能性があることは、上記の参考記事のいくつかでも指摘があります。。。

- セキュリティ関係のリスクは、要調査

- API Key が必要なところで、渡しておいたものが外部に流出しないかなど(?)

Open Interpreter ✖️ Slack Bot

- ぜひ、うちの会社でも試したい。。。面白そう。。。