Alibaba Cloud ACKにDifyをデプロイする

overview

ACKにDifyをデプロイできるらしいので試してみる!

コンポーネントが用意されてるっぽいのでめっちゃ楽そう〜

とりあえず公式ドキュメントをなぞってやってみる〜〜〜✌️

やってみる

まずはクラスタ作成!

ふつーにつくる VPCとかvSwitchとかもふつーにつくる

Ingressはいつものnginxを指定した!

公式曰く

クラスターの安定性を確保するために、クラスターの Kubernetes システム用に少なくとも 2 つの vCPU と 4 GB のメモリを予約し、Container Storage Interface (CSI) プラグインをインストールすることをお勧めします。

だそうなので、4vCPU16GBのインスタンスタイプ選択 & ボリュームプラグインのとこのチェックはつけっぱで!

で、いざ作成〜〜〜〜

できぴ〜〜〜〜〜〜〜

次はクラスタにDifyをいれる!

Helmデプロイするらしい

ここのデプロイを押し

ack-difyを選んでバージョン最新でデプロイ!

デプロイされた!

ので外部からアクセスするために名前空間dify-system にingressを追加する〜

ingressできぴ!

書かれてるエンドポイントにアクセスすると。。。

きた〜〜〜〜〜〜〜〜〜〜〜〜〜〜〜difyうごいてる✌️

Difyの設定

セットアップしてログインする!

無事入れたので、チャットボットつくろ〜

まずモデルプロバイダを設定しなきゃなので、一旦Alibaba Cloud Model Studioにいってモデルの設定する!

Modelsにいくといろんなモデルがあった!

とりあえずqwen-maxつかってみる〜

APIの詳細はこれ

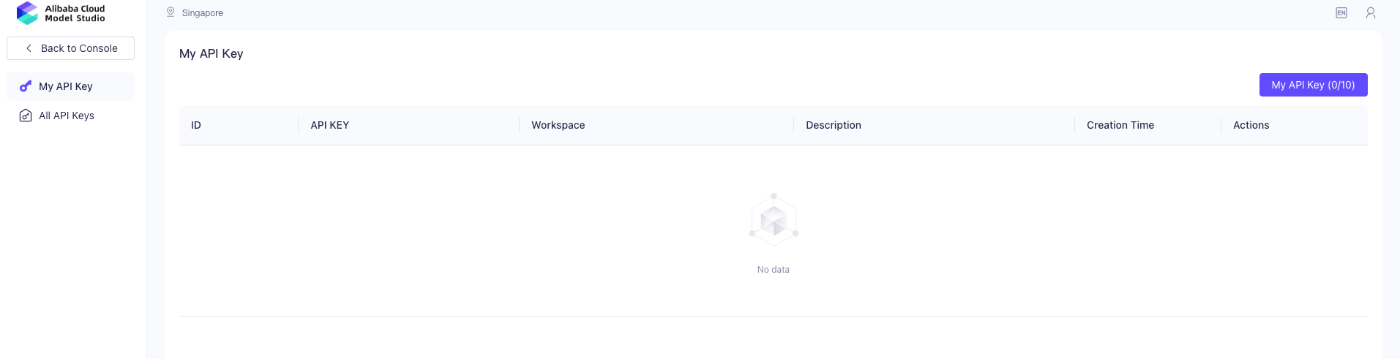

まずAPI Keyを発行する!

右上のアカウントからAPI-KEYにいって作成〜!

API詳細にあった接続先(https://dashscope-intl.aliyuncs.com/compatible-mode/v1)と↑でつくったAPI KEYをdifyの方に設定する

difyの画面に戻って、右上のアカウント → 設定 → モデルプロバイダ へ

今回はOpenAI-API-compatibleを選べばいいっぽいので選択する

以下を入力する

Model Name: qwen-max

API Key: ↑で作ったAlibaba Cloud Model StudioのAPI KEY

API endpoint URL: https://dashscope-intl.aliyuncs.com/compatible-mode/v1

Model Context size: 8000

Upper bound for max tokens: 2000

いけた〜!!!!!!!!!!!!

ので、システムモデルにこのモデルを設定する!

準備できた!雑チャットボットつくる!

公開してアプリ実行して、実際会話してみた

きちゃ〜〜〜〜〜〜〜〜〜〜〜!!!!!!!!!!!!

ちょっと中国語まざったりしちゃってるけど、言ってることはいい感じな気がする!

これにて挙動確認終了✌️

まとめ

- クラスタつくったらHelmの設定いれるだけでDifyがデプロイできるの楽すぎる

- Difyのモデルプロバイダ、OpenAI-API-compatibleを使うのか〜

- とにかく楽に自前環境作れるの良すぎる

- ただDifyで使うDBはアリババのマネージドのものではないので、今度はそこ設定したい

おわり!

Discussion