LandingAI のAgentic Object Detectionが凄い

アンドリュー・ン (Andrew Ng) 先生が設立したLandingAIの紹介動画を見たんだけどこれが凄い

以下 訳

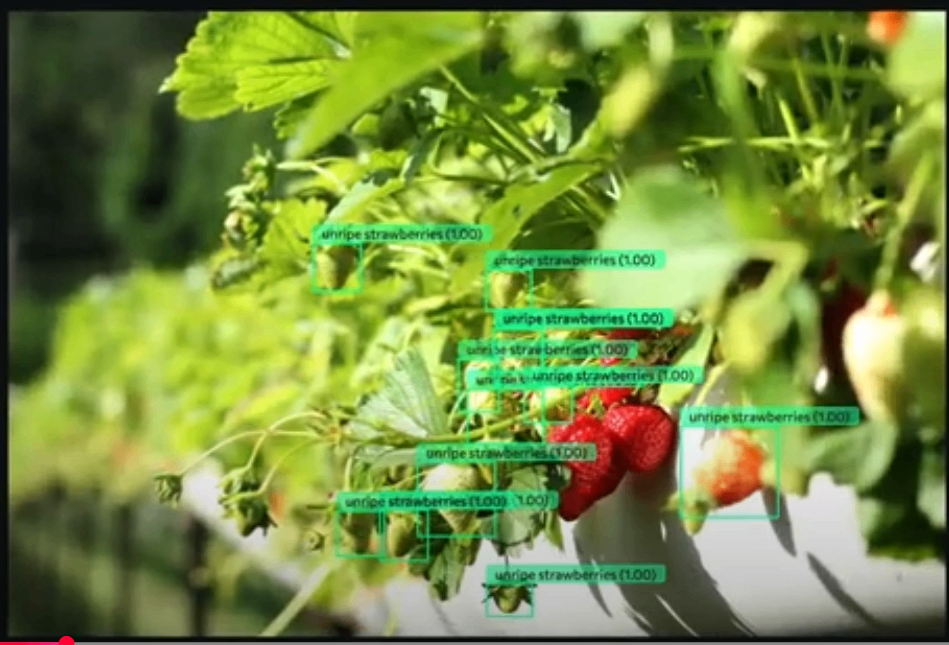

従来のコンピュータビジョンにおける物体検出は、データのラベル付けのために大量のバウンディングボックスを描画し、その後ニューラルネットワークをトレーニングする必要があり、非常に時間のかかるプロセスでした。しかし、Agentic Object Detection (エージェント型物体検出) では、例えば「未熟なイチゴ」(unripe strawberries)のように、あなたが望むものをプロンプトで記述するだけで、Visual AIエージェントがしばらく考え込み、このような結果が得られます。見ての通り、未熟なイチゴだけをうまく抽出できているようです。

これは、トレーニング例にラベルを付ける必要が全くありません。私がこれに興奮するのは、Visual AI問題のワークフローが変わるからです。データを取得し、ラベルを付けて、モデルをトレーニングする必要がなくなり、代わりに、あなたが望むものを記述するだけで結果が得られるようになります。

Agenticシステムとは、リフレクション、ツール利用、計画、マルチエージェント連携といった設計パターンを利用し、高品質な出力を生成する前にタスクについて時間をかけて推論するAIシステムを指します。大規模なマルチモーダルモデルやLLM (大規模言語モデル) を物体検出に利用することは、画像を一瞥してすぐに結果を吐き出すようなものです。

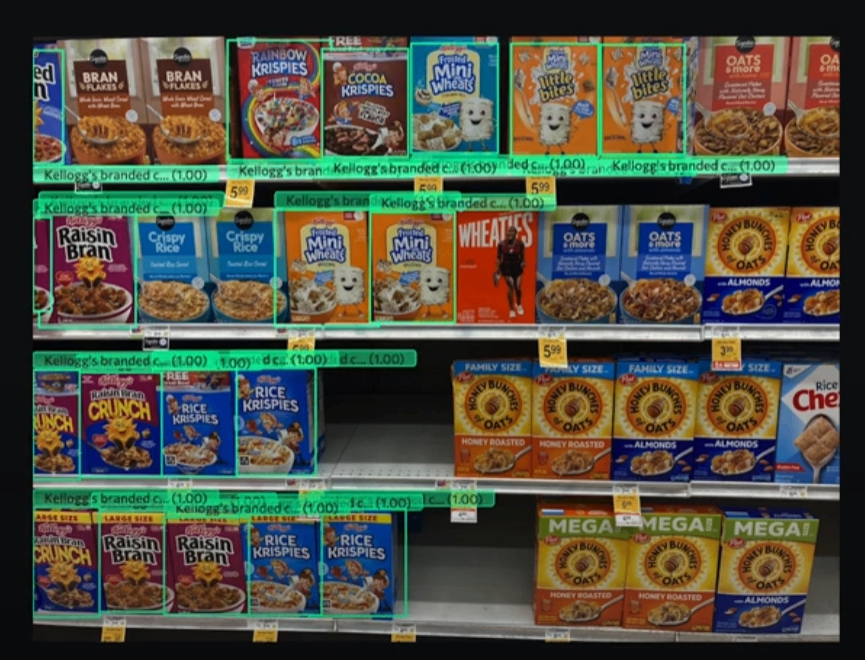

私たちのAgentic Object Detectionは、OpenAIのo1やDeepSeek-R1がテキスト問題について時間をかけて推論し、より高品質な出力を生成するのと同じように、画像について時間をかけて推論します。そのため、例えば「2つのエンジンを持つ飛行機」(planes with 2 engine)といったプロンプトを記述して結果を得たり、「ケロッグのブランドシリアル」(Kellogg's branded cereal)と記述して結果を得たりできます。

私たちの内部ベンチマークでは、Agentic Object Detectionは、他の主要チームのシステムを大幅に上回りました。弱点の1つは、画像の処理に時間がかかることです。おそらく20~30秒ほどかかりますが、これはまだ開発途上であり、私たちのチームは改善に懸命に取り組んでいます。今後、多くのアップデートにご期待ください。

これほど早く物体検出システムを構築できたことはありません。ぜひウェブサイトでデモをお試しください。開発者の皆様はAPIもチェックしてみてください。これで何かクールなものを開発していただければ幸いです。

訳ここまで

未熟なイチゴなら、映像だけで判断できそうですが、エンジンが2つの旅客機の例では映像ではエンジンが1つしか映っていないわけで、機体の反対側にもエンジンについての知識があるって判断しているってことですよね。

動画の中で紹介されていたほかの例では

frame with city map というプロンプトで部屋に飾られている絵の中から地図が描かれているものを検出しているなんてのもあります。

ビジョンをかじっている人間としては衝撃です。

LandingAIのプロダクトには、LandingLens、LandingLens for Snowflake、Vision Agentの3つがあるようです。3つ目のVision Agentのデモもすごいので使って報告したいと思います。

Discussion