PyTorchのインストール手順

はじめに

PyTorchは、機械学習やディープラーニングを開発するためのPythonのフレームワークです。自分ではディープラーニングの開発をしなくても、使用するライブラリがPyTorchを必要とすることがあります。私の場合はWhisperをGPUで稼働させるためにPyTorchが必要でした。

PyTorchをインストールする場合、GPUの型番やCUDAのバージョンなど、いろいろな要因が関係していて一筋縄ではいきません。そこで、この資料ではPyTorchのインストール手順をまとめてみました。

対象読者

この資料は下記の読者を対象にしています。

- 開発者

- PyTorchを使いたい方

- Pythonの知識がある方(多少でもOK)

- NVIDIAのGPUを持っている方

- Windowsユーザー

PyTorchのインストール手順

📌 手順1. CUDAの確認

PCにCUDAがインストールされているかを以下のコマンドで確認します。

nvcc --version

うちのPCにはCUDAの12.3がインストールされていました。出力例は以下の通りです。

nvcc: NVIDIA (R) Cuda compiler driver

Copyright (c) 2005-2023 NVIDIA Corporation

Built on Fri_Nov__3_17:51:05_Pacific_Daylight_Time_2023

Cuda compilation tools, release 12.3, V12.3.103

Build cuda_12.3.r12.3/compiler.33492891_0

インストールされている場合は手順8.PyTorchのインストールに進みます。

インストールされていなかったり、CUDAの新しいバージョンをインストールしたい場合は手順2に進みます。

📌 手順2. GPUの型番の確認

使えるCUDAのバージョンはGPUによって違うため、PCに搭載されているGPUの型番を調べる必要があります。

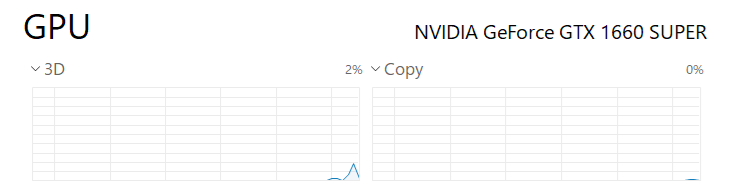

GPUの型番はタスクマネージャーのパフォーマンスタブで確認できます。

うちの場合は NVIDIA GeForce GTX 1660 SUPER を使っていることがわかります。

📌 手順3. GPUのマイクロアーキテクチャの確認

続いてGPUのマイクロアーキテクチャを調べます(以下のWikipedia参照)。

1660 SUPERのマイクロアーキテクチャはTuringだとわかります。

📌 手順4. 互換性のあるCUDAのバージョンを確認

上記Wikipediaの上の表で、GPUと互換性のあるCUDAのバージョンを調べます。

表頭にあるGPUのマイクロアーキテクチャを下に辿っていき緑の欄が対応するCUDAのバージョンです。

Turingの場合、CUDA 10.0 - 12.8に対応していることがわかります。

使用できる最新のバージョンをインストールすることを念頭においておいて、次の手順にすすみます。

📌 手順5. GPUドライバのバージョンの確認

次にGPUのドライバが、インストールするCUDAのバージョンに対応しているかを調べます。

PCにインストールされているドライバのバージョンを調べるには、NVIDIA Control Panelの「ヘルプ」-「システム情報」を見ます。

うちのPCには560.94がインストールされていることがわかります。

📌 手順6. GPUドライバの互換性の確認

続いてドライバがCUDAのバージョンに対応しているかを調べます。

NVIDIAの以下のページにCUDAのバージョンと、ドライバのバージョンの互換性が記載されています。

この表からCUDAの最新バージョンを使うには、ドライバの572.61以上が必要なことがわかります(Windowsの場合)。

ドライバの要件が合わない場合は、新しいドライバーをインストールします。

うちの場合ドライバが560.94なので、最新のCUDAをインストールする場合はドライバを更新する必要があることがわかります。

📌 手順7. CUDA Toolkitのインストール

CUDAは下記ページからダウンロードしてインストールできます。

もし古いバージョンのCUDAをインストールしたい場合は、下記ページからダウンロードできます。

📌 手順8. PyTorchのインストール

まず、PyTorchのインストールコマンドを公式サイトで調べます。

サイトの中にあるインストールコマンド生成用のツールに、自分の環境を入力していくと下部にコマンドテキストが表示されます。

自分の環境にあった環境が見つからない場合はprevious versionsから探せます。

うちの環境ではCUDA 12.3がインストールされており、previous versionsでCUDA 12.1用のコマンドを見つけて、それでインストールしました(PyTorchのバージョンはv2.5.1)。

# CUDA 12.1

pip install torch==2.5.1 torchvision==0.20.1 torchaudio==2.5.1 --index-url https://download.pytorch.org/whl/cu121

ぴったりのバージョンが見つからない場合は、使用しているCUDAのバージョン以下(ただしメジャーバージョンは合わせる)のPyTorchをインストールすればOKみたいです。

📌 手順9. PyTorchの動作確認

以下のようなプログラムで動作確認をします。問題なく動けばOKです。

import torch

print(torch.__version__) # バージョン確認

print(torch.cuda.is_available()) # GPUが使えるか確認

x = torch.rand(5, 3) # ランダムなテンソルを作成

print(x) # テンソルを表示

まとめ

PyTorchをインストールするには、GPUとCUDAの互換性を確認する必要があります。この資料で紹介した手順をまとめると:

- 環境の確認: まずCUDAがすでに入っているか確認する

- GPUの確認: 搭載されているGPUの型番とアーキテクチャを調べる

- 互換性チェック: GPUに対応するCUDAのバージョンとドライバの互換性を確認する

- インストール: 必要なCUDAとPyTorchをインストールする

- 動作確認: 簡単なコードで正しく動作するか確認する

これらの手順を踏むことで、エラーなくPyTorchをインストールし、GPUを活用したディープラーニングの環境を整えることができます。環境構築でつまずいた場合は、PyTorch公式フォーラムやGitHubのissueも参考になります。

ディープラーニングの旅をぜひ楽しんでください!

Discussion