2024/01/25 論文読み勉強会

論文読み勉強会とは

機械学習の分野は日進月歩で、日々沢山の論文が出てきます。最新の技術動向を知るためには日頃から論文を読む習慣をつける必要があります。また、沢山読むためには論文を速読するスキルも必要です。そこで、弊社来栖川電算ではみんなで論文を読んで発表する社内勉強会(論文読み勉強会)を始めました。論文読み勉強会では、はじめて読む論文を50分間のタイムアタックで読み、最後に1人1, 2分程度で分かったことを発表する形式で実施しています。

1月25日(木)の勉強会

この日の参加者は3人でした。各メンバーが読んだ論文とそのまとめを紹介します。

これから論文を読んで知識を付けていきたいと思っている参加者が1時間のタイムアタックで読んでまとめた内容なので誤った内容が含まれている可能性がありますのでご了承ください。

各論文の概要

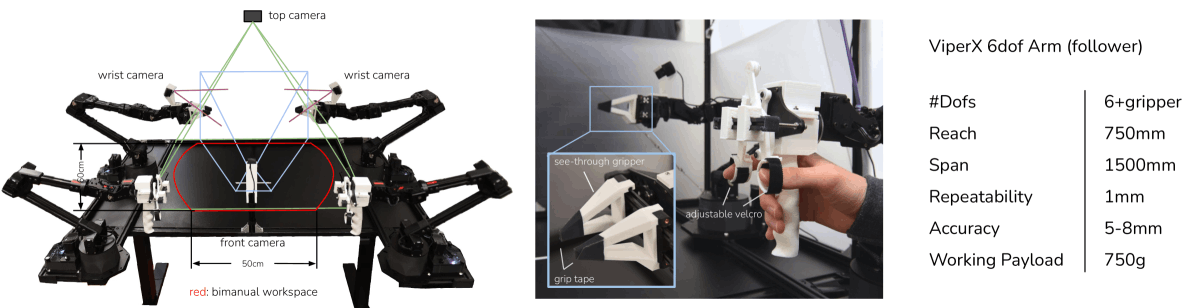

- Learning Fine-Grained Bimanual Manipulation with Low-Cost Hardware[1]

- 低コスト低精度のハードウェアでも、学習によって微細な操作タスクを実行できるようにするエンド・ツー・エンドの模倣学習を行うシステム

- YOLOv7: Trainable bag-of-freebies sets new state-of-the-art for real-time object detectors[2]

- (2022年7月の時点で)既存のモデルと比べて、速度・精度が良いトレードオフとなるリアルタイム物体検出器を提案

- StreamDiffusion: A Pipeline-level Solution for Real-time Interactive Generation[3]

- diffusion modelによる画像生成をリアルタイムでできるようにした

勉強会の議事録

Wさん

論文名

- Learning Fine-Grained Bimanual Manipulation with Low-Cost Hardware[1]

どんなもの?

- 学習によって、低コストで精度の低いハードウェアでも、微細な操作タスクを実行できるようにするエンド・ツー・エンドの模倣学習を行う低コストシステム

先行研究と比べてどこがすごい?

- 従来のシステムは高価なロボットやセンサーを必要としていたが、この研究は低コストでアクセスしやすいハードウェアに焦点を当てている。

- 模倣学習の新しいアルゴリズムを提案し、精密操作タスクにおいて以前の方法よりも優れた性能を示した

技術や手法のキモはどこ?

- 「Action Chunking with Transformers (ACT)」という新しいアルゴリズムを開発した

- 行動シーケンスの生成モデルを学習し、ロボットが実世界のタスクを学習するのに役立つ。

- Conditional VAE (CVAE)

どうやって有効だと検証した?

- 実世界およびシミュレーションされたタスクを用いた実験を行い、他の模倣学習方法と比較して性能を評価

議論はある?

- 低コストのハードウェアの精度の低さや、模倣学習の課題について

Kさん

論文名

- YOLOv7: Trainable bag-of-freebies sets new state-of-the-art for real-time object detectors[2]

どんなもの?

- リアルタイム物体検出で推論コストを増加させずに検出精度を大幅に増加させることが出来るようにいくつかの学習可能なbag-of-freebies法を設計

- 物体検出法を進化させるための新しい研究トピックを発見した

- 再パラメータ化モジュールが元のモジュールをどのように置き換えるか

- 動的ラベル割当戦略が異なる出力層への割当をどのように扱うか

- 上記2つの問題を解決するために学習可能なbag-of-freebies法を提案

- リアルタイム物体検出器のためのAugment、複合スケーリング手法を提案

- 提案手法により、大量のパラメータとSOTAのリアルタイム打った検出器の計算を効果的に削減し、推論速度が早くて検出精度も高いことを実現

先行研究と比べてどこがすごい?

- 5FPS~120FPSの範囲で既知の物体検出器を速度・精度の両方で上回り、GPU V100で30FPS以上の既知のリアルタイム物体検出器の中で最も高い精度56.8%のAPを達成

[2]より引用

技術や手法のキモはどこ?

- Extended efficient layer aggregation networks

- Trainable bag-of-freebies

- Planned re-parameterization model

- RepConv(3x3畳み込み、1x1畳み込み、identity connectionに分岐する)という手法がVGGで優れた性能を達成しているが、これをResNetやDenseNetなどの残差接続を持つアーキテクチャに適用すると精度が低下する

- RepConvN(identity connectionなしのRepConv)を採用すると残差接続と組み合わせて良い結果が得られた

[2]より引用

- Planned re-parameterization model

どうやって有効だと検証した?

- 実験設定

- MS COCOデータセットを用いて実験

- 全てゼロから学習

- エッジGPU、ノーマルGPU、クラウドGPUの基本モデルを設計し、それぞれYOLOv7tiny、YOLOv7、YOLOv7-W6と呼ぶ

- ベースライン物体検出器(他のYOLO系手法)との比較。

[2]より引用- YOLOv7・・・パラメータ数、計算量、精度の店でベースラインモデルより優れている

- YOLOv7tiny・・・39%のパラメータと49%の計算量削減して、YOLOv4-tiny-31と同等のAP

- SOTAとの比較

[2]より引用- 精度と速度で良いトレードオフ

Mさん

論文名

- StreamDiffusion: A Pipeline-level Solution for Real-time Interactive Generation[3]

- code

どんなもの?

- インタラクティブな画像生成用のリアルタイムdiffusion pipeline:Stream Diffusionを提案

[3]より引用 - diffusion modelは画像を生成することに関しては優れているが、リアルタイム性の観点では不十分である。

- そのため、メタバースやゲームグラフィックス、ライブストリーミングへの応用に問題がある

- これに対処するため、シンプルなアプローチを提案

- オリジナルのシーケンシャルなデノイジングを

- バッチデノイジングに置き換える

- Stream Batchは従来のwait-and-interactなアプローチを排除して、中道的で高スループットなストリームを可能にする

- データ入力とモデルのスループットの周期の違いに対して、ストリーミング処理の並列化のための入出力キューを設計

- 更に、既存のdifffusion pipelineはclassidier-free guidanceで生成結果をプロンプトに基づくように強制しているが、ネガティブな条件付きdenoisingに固有の冗長性のために、この実装が非効率的である

- その冗長性を軽減するために、residual classifier-free guidance(RCFG)を提案

- ネガティブな条件付きdenoisingのステップ数を1つだけ、または0にすることができる

- 電力消費の最適化のために、確率的類似性フィルタリング戦略(stochastic similatiry filtering strategy)を使う

- GPU実行頻度が劇的に減り、GPU使用率を効率的にした

- 速度上昇(既存のdenoising methodと比べて)

- batching denoising: 1.5x

- RCFG:2.05x

- 計測すると

- 提案した手法と高速化のためのツール(TensorRTとか?)を組み合わせて

- 91.07fps(RTX4090)

- 既存手法と比べて、59.56x

- エネルギー消費を抑えた

- 2.39x(RTX3060)

- 1.99x (RTX4090)

- ※固定的なシーンの入力に対して

- 先行研究と比べてどこがすごい?

- とにかく早くてGPUを効率的に使っているところ

- 既存のdiffusion pipelineに対して60倍近く速くなり、diffusion modelによるリアルタイム処理が可能になった

- 技術や手法のキモはどこ?

- 既存のパイプラインに対して、非効率的な個所を効率的な手法に置き換えた

- batching denoising

- RCFG: Residual Classifier-Free Guidance

- stochastic similarity filtering

- その他の高速化ツールでの実装もがんばった

- githubに使いやすいようにしっかりまとめてあるのも良き

- 単に実装が置いてあるだけじゃなくて、いろんな人が使いやすいようにまとまっている

どうやって有効だと検証した?

- 100枚の画像を処理した際の画像当たりの平均推論時間を計測

次に読むべき論文は?

- この論文の続き

- 結構濃密な論文で読み切れてない箇所が多い

感想

今回の論文読み会は9回目でした。私が読んだ[1]の感想や、この論文読み会を続けてみて思うことを書いてみます。

https://mobile-aloha.github.io/ でのデモ動画を見たのがきっかけで読んで見ました。Transformerで行動を生成する、行動はチャンクにわけて扱う、というアイディアから、Transformerの応用の幅広さを感じました。同時にTransformer自体の理解をもっと深めないととも思いました。

論文読み会を続けてきて良いなと思う点は、気になった論文を「とりあえず50分」「週1ペース」というルールを設けることで「あとで読もう」とか「これは時間がかかりそうだからまとまった時間ができたときに読もう」みたいに、後回しにしなくなったことです。50分なので完璧に中身を理解するには至りませんが、以前より論文を読んでいる時間は増えているので、良い傾向かなと感じています。

これからも執筆者交代しながら論文読み勉強会の内容を紹介していきます。

参考文献

[1]

Tony Z. Zhao, Vikash Kumar, Sergey Levine, Chelsea Finn. (2023). Learning Fine-Grained Bimanual Manipulation with Low-Cost Hardware. arXiv preprint arXiv:2304.13705. Available: https://arxiv.org/abs/2304.13705

[2]

Chien-Yao Wang, Alexey Bochkovskiy, Hong-Yuan Mark Liao. (2022). YOLOv7: Trainable bag-of-freebies sets new state-of-the-art for real-time object detectors. arXiv preprint arXiv:2207.02696. Available: https://arxiv.org/abs/2207.02696

[3]

Akio Kodaira, Chenfeng Xu, Toshiki Hazama, Takanori Yoshimoto, Kohei Ohno, Shogo Mitsuhori, Soichi Sugano, Hanying Cho, Zhijian Liu, Kurt Keutzer. (2023). StreamDiffusion: A Pipeline-level Solution for Real-time Interactive Generation. arXiv preprint arXiv:2312.12491. Available: https://arxiv.org/abs/2312.12491

名古屋のAI企業「来栖川電算」の公式publicationです。AI・ML を用いた認識技術・制御技術の研究開発を主軸に事業を展開しています。 公式HP→ kurusugawa.jp/ , 採用情報→ kurusugawa.jp/jobs/

Discussion