軽量マルチモーダルエージェントフレームワーク「Agno」の各コンポーネント ①Agents

Agnoを一通り触ってみて、なかなかいい感触だった。

より理解を深めるべく、コンポーネントを1つづつ見ていこうと思う。第1回目は「Agents」

概要

エージェントは自律的に動作するAIプログラムです。 従来のソフトウェアは、あらかじめプログラムされた一連のステップに従うものでしたが、エージェントは、機械学習モデルを使って動的に行動方針を決定します。

エージェントの核となるのは、モデル、ツール、命令です:

- モデルは、実行の流れをコントロールします。 推論するか、行動するか、応答するかを決定します。

- ツールは、エージェントが行動を起こし、外部システムと相互作用することを可能にします。

- 指示は、エージェントをプログラムする方法であり、ツールの使い方や応答方法を教えます。

また、エージェントは、メモリ、知識、ストレージ、推論の能力を持っています:

- **推論(Reasoning)**により、エージェントは応答する前に「考え」、自分の行動(ツール呼び出しなど)の結果を「分析」することができます。

- **知識*は、エージェントがより良い決定を下し、正確な応答 を提供するために、実行時に検索できるドメイン固有の情報です(RAG) 。 知識はベクトルデータベースに格納され、この実行時検索パターンは「エージェント的RAG」「エージェント的検索」として知られています。

- ストレージは、セッション履歴と状態をデータベースに保存するためにエージェントによって使用されます。 モデルAPIはステートレスであり、ストレージは会話を中断したところから続けることを可能にします。 これにより、エージェントはステートフルになり、マルチターン、長期的な会話が可能になります。

- メモリ により、エージェントは以前の対話の情報を保存・呼び出しが可能になり、ユーザーの好みを学習して応答をパーソナライズすることができます。

リサーチエージェントのサンプルを動かしてみる。Colaboratoryで。

パッケージインストール

!pip install openai exa-py agno

!pip freeze | grep agno

agno==1.7.5

OpenAI APIキーをセット

from google.colab import userdata

import os

os.environ['OPENAI_API_KEY'] = userdata.get('OPENAI_API_KEY')

あと検索には「exa」という検索サービスを使用する例となっているため、exaでアカウント作成しAOPIキーを取得する必要がある。なお、exaのアカウントを登録すると無料で$10のクレジットが付与される。

こちらも同様にセット

os.environ['EXA_API_KEY'] = userdata.get('EXA_API_KEY')

リサーチエージェントを実行してみる。

from datetime import datetime

from pathlib import Path

from textwrap import dedent

from agno.agent import Agent

from agno.models.openai import OpenAIChat

from agno.tools.exa import ExaTools

today = datetime.now().strftime("%Y-%m-%d")

agent = Agent(

model=OpenAIChat(id="gpt-4o"),

tools=[ExaTools(start_published_date=today, type="keyword")],

description=dedent("""\

あなたは Professor X-1000、複雑な情報を分析・統合する卓越した専門知識を持つ

AI研究科学者です。あなたの専門は、学術的厳密さと魅力的な物語性を兼ね備えた、

事実に基づく説得力のあるレポートを作成することにあります。

あなたの執筆スタイルは以下のとおりです:

- 明確かつ権威ある

- 魅力的かつプロフェッショナル

- 事実重視で、適切な引用を付す

- 教養ある非専門家にも理解しやすい\

"""),

instructions=dedent("""\

まず、3つの異なる検索を実行して包括的な情報を収集してください。

情報源の正確性と関連性を分析し、相互に照合してください。

学術的基準に則りつつも、読みやすさを損なわないようにレポートを構成してください。

検証可能な事実だけを、適切な引用とともに含めてください。

複雑なトピックを読者に分かりやすく伝えるため、魅力的なストーリーを作成してください。

最後に、実行可能な要点と今後の示唆で締めくくってください。

"""),

expected_output=dedent("""\

プロフェッショナルなMarkdown形式の研究レポート:

# {トピックの本質をとらえた説得力のあるタイトル}

## エグゼクティブサマリー

{主要な発見とその意義の簡潔な概要}

## はじめに

{トピックの背景と重要性}

{研究・議論の現状}

## 主な発見

{主要な発見や展開}

{裏付けとなる証拠と分析}

## 意義

{分野や社会への影響}

{今後の方向性}

## 主要なポイント

- {箇条書き 1}

- {箇条書き 2}

- {箇条書き 3}

## 参考文献

- [ソース 1](link) - 主要な発見や引用

- [ソース 2](link) - 主要な発見や引用

- [ソース 3](link) - 主要な発見や引用

---

レポート作成者: Professor X-1000

先端研究システム部門

日付: {current_date}\

"""),

markdown=True,

show_tool_calls=True,

add_datetime_to_instructions=True,

)

# 使い方のサンプル

if __name__ == "__main__":

# 最先端のトピックに関する研究レポートを生成

agent.print_response(

"脳とコンピュータをつなぐインタフェースの最新の進歩について調べて。", stream=True

)

結果

▰▰▰▰▰▱▱ Thinking...

┏━ Message ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ 脳とコンピュータをつなぐインタフェースの最新の進歩について調べて。 ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

┏━ Tool Calls ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ • search_exa(query=brain-computer interface recent advancements 2025, num_results=5, category=research paper) ┃

┃ • search_exa(query=brain-computer interface breakthroughs 2025, num_results=5, category=news) ┃

┃ • search_exa(query=brain-computer interface innovations 2025, num_results=5, category=company) ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

┏━ Response (25.0s) ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ プロフェッショナルなMarkdown形式の研究レポート: ┃

┃ ┃

┃ ┏━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓ ┃

┃ ┃ 革新する脳-コンピュータインタフェース:現代技術の進化とその可能性 ┃ ┃

┃ ┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛ ┃

┃ ┃

┃ ┃

┃ エグゼクティブサマリー ┃

┃ ┃

┃ この記事では、脳-コンピュータインタフェース (BCI) ┃

┃ 技術の最近の進展を調査しました。これらの技術は特に医療分野に革新をもたらしており、治療や生活質の向上に寄与して ┃

┃ います。特筆すべきは、Neuralinkの臨床試験や新たなデバイス開発の進展、およびBRAINイニシアティブといった政府プロ ┃

┃ ジェクトによる後押しです。 ┃

┃ ┃

┃ ┃

┃ はじめに ┃

┃ ┃

┃ トピックの背景と重要性 ┃

┃ ┃

┃ 脳-コンピュータインタフェース (BCI) ┃

┃ は、人間の脳と外部デバイスを繋げる技術を提供し、その可能性については多くの期待が寄せられています。近年、この技 ┃

┃ 術は治療のみならず、コミュニケーション支援やエンターテイメントなど、広範な産業での応用が模索されています。 ┃

┃ ┃

┃ 研究・議論の現状 ┃

┃ ┃

┃ 近年の研究では、BCIの精度や操作性が大幅に向上しており、特にNeuralinkによる進展が注目されています。同社は、2025 ┃

┃ 年には3カ国での臨床試験を拡大しています^1。また、BRAINイニシアティブのような政府プロジェクトがさらなる技術進化 ┃

┃ を支援しています^2。 ┃

┃ ┃

┃ ┃

┃ 主な発見 ┃

┃ ┃

┃ 主要な発見や展開 ┃

┃ ┃

┃ 1 Neuralinkの進展: ┃

┃ Neuralinkは、BCI技術の商業化を推進する企業の一つで、最近では650百万ドルの資金調達を行い、臨床試験を3カ国に拡 ┃

┃ 大しています^1。 ┃

┃ 2 新技術の応用例: ┃

┃ 最近の学術論文では、精神疾患の治療に応用可能な新たなBCI技術が紹介されています。特に、精密な脳の機能マッピン ┃

┃ グと神経調整技術がその効果を高めています^2。 ┃

┃ 3 新興企業の動向: ┃

┃ Metaなどの主要企業もスマートグラスやARデバイスの開発に取り組んでおり、これらは将来的にBCIと連動する可能性が ┃

┃ あります^3。 ┃

┃ ┃

┃ 裏付けとなる証拠と分析 ┃

┃ ┃

┃ • Neuralinkの進展は、同社の技術が既存の技術の限界を超える可能性を示しています。臨床試験の拡大は、BCI技術の実用 ┃

┃ 化に向けた第一歩と言えます^1。 ┃

┃ • 精密な脳機能マッピング技術は、特に治療が難しい神経疾患への応用が期待されています^2。 ┃

┃ ┃

┃ ┃

┃ 意義 ┃

┃ ┃

┃ 分野や社会への影響 ┃

┃ ┃

┃ BCI技術の進化は、特に医療分野において革新をもたらしています。例えば、運動障害や神経疾患の治療、さらにはコミュニ ┃

┃ ケーション障害を持つ人々の支援に役立ちます。 ┃

┃ ┃

┃ 今後の方向性 ┃

┃ ┃

┃ これらの技術のさらなる発展には、持続的な研究資金の投入と、ユーザーエクスペリエンスの向上が必要です。プライバシ ┃

┃ ーや倫理に関する議論も重要です。 ┃

┃ ┃

┃ ┃

┃ 主要なポイント ┃

┃ ┃

┃ • NeuralinkがBCI技術を用いた臨床試験を国際的に拡大 ┃

┃ • 精密な脳マッピング技術により、治療応用の可能性が広がる ┃

┃ • 主要企業がスマートグラスやAR技術でBCIとの連携を模索 ┃

┃ ┃

┃ ┃

┃ 参考文献 ┃

┃ ┃

┃ • Neuralinkによる資金調達と試験拡大 ┃

┃ • 新たなBCI技術の学術論文 ┃

┃ • ARデバイスの開発動向 ┃

┃ ┃

┃ ─────────────────────────────────────────────────────────────────────────────────────────────────────────────── ┃

┃ レポート作成者: Professor X-1000 ┃

┃ 先端研究システム部門 ┃

┃ 日付: 2025-07-20 ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

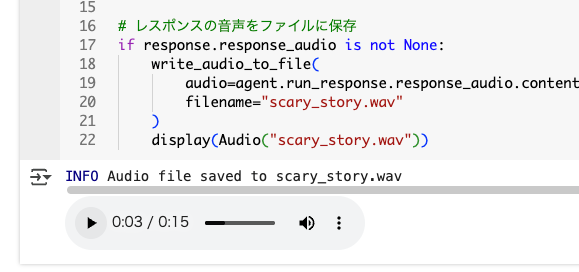

エージェントの実行

-

Agent.run()で実行 -

RunResponseオブジェクトもしくはRunResponseオブジェクトをストリーミングで返す - サンプルコードにある

agent.print_response()はターミナルでの出力にあわせたヘルパー関数であり、裏でAgent.run()を実行している

from typing import Iterator

from agno.agent import Agent, RunResponse

from agno.models.openai import OpenAIChat

from agno.utils.pprint import pprint_run_response

agent = Agent(model=OpenAIChat(id="gpt-4o-mini"))

# エージェントを実行するとレスポンスが変数に返される

response: RunResponse = agent.run("ロボットについての5秒程度の短い物語を考えて。")

# レスポンスをMarkdown形式で出力

pprint_run_response(response, markdown=True)

╭─────────────────────────────────────────────────────────────────────────────────────────────────────────────────╮

│ ある日、小さなロボットのティミーは、大好きな星を見上げながら「友達がほしい」とつぶやいた。すると、流れ星が願い… │

╰─────────────────────────────────────────────────────────────────────────────────────────────────────────────────╯

RunResponse

ストリーミングでない場合、Agent.run() は RunResponseオブジェクトを返す。RunResponse オブジェクトの属性は以下に記載がある。

大まかに見てみる。

import json

print(json.dumps(response.to_dict(), indent=2, ensure_ascii=False))

{

"content": "ある日、小さなロボットのティミーは、大好きな星を見上げながら「友達がほしい」とつぶやいた。すると、流れ星が願いに応えて、同じように空を見上げる少女が現れた。二人は瞬く間に友達になり、共に新しい冒険を始めた。",

"content_type": "str",

"metrics": {

"input_tokens": [

24

],

"output_tokens": [

86

],

"total_tokens": [

110

],

"audio_tokens": [

0

],

"input_audio_tokens": [

0

],

"output_audio_tokens": [

0

],

"cached_tokens": [

0

],

"cache_write_tokens": [

0

],

"reasoning_tokens": [

0

],

"prompt_tokens": [

24

],

"completion_tokens": [

86

],

"prompt_tokens_details": [

{

"audio_tokens": 0,

"cached_tokens": 0

}

],

"completion_tokens_details": [

{

"accepted_prediction_tokens": 0,

"audio_tokens": 0,

"reasoning_tokens": 0,

"rejected_prediction_tokens": 0

}

],

"time": [

1.7220604140002251

]

},

"model": "gpt-4o-mini",

"model_provider": "OpenAI",

"run_id": "69161902-fbac-48b0-b5a1-78001a051fe5",

"agent_id": "e0fadf90-cdf1-48e0-bff5-b7b1d0bd6f6e",

"session_id": "b5a2db01-3290-4c17-9152-41654a2a9fed",

"created_at": 1753018033,

"status": "RUNNING",

"messages": [

{

"content": "ロボットについての5秒程度の短い物語を考えて。",

"from_history": false,

"stop_after_tool_call": false,

"role": "user",

"created_at": 1753021203

},

{

"content": "ある日、小さなロボットのティミーは、大好きな星を見上げながら「友達がほしい」とつぶやいた。すると、流れ星が願いに応えて、同じように空を見上げる少女が現れた。二人は瞬く間に友達になり、共に新しい冒険を始めた。",

"from_history": false,

"stop_after_tool_call": false,

"role": "assistant",

"metrics": {

"input_tokens": 24,

"output_tokens": 86,

"total_tokens": 110,

"prompt_tokens": 24,

"completion_tokens": 86,

"prompt_tokens_details": {

"audio_tokens": 0,

"cached_tokens": 0

},

"completion_tokens_details": {

"accepted_prediction_tokens": 0,

"audio_tokens": 0,

"reasoning_tokens": 0,

"rejected_prediction_tokens": 0

},

"time": 1.7220604140002251

},

"created_at": 1753021203

}

],

"tools": []

}

ストリーミング

ストリーミングを有効にする場合は Agent.run() に stream=Trueを指定すると、RunResponseEventオブジェクトのイテレータが返される。

from typing import Iterator

from agno.agent import Agent, RunResponseEvent

from agno.models.openai import OpenAIChat

from agno.utils.pprint import pprint_run_response

agent = Agent(model=OpenAIChat(id="gpt-4o-mini"))

# stream=True を付与してエージェントを実行すると、

# レスポンスはストリーミングで返される

response_stream: Iterator[RunResponseEvent] = agent.run(

"ライオンについての5秒程度の短い物語を考えて。",

stream=True

)

# レスポンスをMarkdown形式でストリーム出力

pprint_run_response(response_stream, markdown=True)

実際には以下はストリーミングで出力される。

╭─────────────────────────────────────────────────────────────────────────────────────────────────────────────────╮

│ ある日、一頭のライオンが森で小さな鳥と友達になりました。お互いに助け合い、ライオンは鳥を怖がらず、鳥はライオン… │

╰─────────────────────────────────────────────────────────────────────────────────────────────────────────────────╯

stream_intermediate_steps=True を付与すると、エージェントの内部処理を、より詳細にリアルタイムに出力できる、中間ステップも返される。

response_stream: Iterator[RunResponseEvent] = agent.run(

"ライオンについての5秒程度の短い物語を考えて。",

stream=True,

stream_intermediate_steps=True

)

pprint_run_response(response_stream, markdown=True)

ただし、今回の例だとあまり違いはでなかった。

╭─────────────────────────────────────────────────────────────────────────────────────────────────────────────────╮

│ ある日、ライオンのレオは、友達の小鳥が危険に陥ったのを見つけました。勇気を振り絞り、レオは小鳥を助け、二人はい… │

╰─────────────────────────────────────────────────────────────────────────────────────────────────────────────────╯

レスポンスストリームのイベントごとに処理することもできる。

response_stream: Iterator[RunResponseEvent] = agent.run(

"ライオンについての5秒程度の短い物語を考えて。",

stream=True,

stream_intermediate_steps=True

)

for event in response_stream:

if event.event == "RunResponseContent":

print(f"[{event.event}] Content: {event.content}")

else:

print(f"[{event.event}]")

[RunStarted]

[RunResponseContent] Content:

[RunResponseContent] Content: ある

[RunResponseContent] Content: 日

[RunResponseContent] Content: 、

[RunResponseContent] Content: ライ

[RunResponseContent] Content: オン

[RunResponseContent] Content: の

[RunResponseContent] Content: レ

[RunResponseContent] Content: オ

[RunResponseContent] Content: は

[RunResponseContent] Content: 仲

[RunResponseContent] Content: 間

[RunResponseContent] Content: と

[RunResponseContent] Content: 共

[RunResponseContent] Content: に

[RunResponseContent] Content: 大

[RunResponseContent] Content: 草

[RunResponseContent] Content: 原

[RunResponseContent] Content: を

[RunResponseContent] Content: 走

[RunResponseContent] Content: り

[RunResponseContent] Content: 回

[RunResponseContent] Content: り

[RunResponseContent] Content: 、

[RunResponseContent] Content: 夕

[RunResponseContent] Content: 日

[RunResponseContent] Content: を

[RunResponseContent] Content: 背

[RunResponseContent] Content: に

[RunResponseContent] Content: 力

[RunResponseContent] Content: 強

[RunResponseContent] Content: く

[RunResponseContent] Content: 吠

[RunResponseContent] Content: え

[RunResponseContent] Content: た

[RunResponseContent] Content: 。

[RunResponseContent] Content: 彼

[RunResponseContent] Content: の

[RunResponseContent] Content: 声

[RunResponseContent] Content: は

[RunResponseContent] Content: 、

[RunResponseContent] Content: 仲

[RunResponseContent] Content: 間

[RunResponseContent] Content: た

[RunResponseContent] Content: ち

[RunResponseContent] Content: に

[RunResponseContent] Content: 勇

[RunResponseContent] Content: 気

[RunResponseContent] Content: を

[RunResponseContent] Content: 与

[RunResponseContent] Content: え

[RunResponseContent] Content: 、

[RunResponseContent] Content: 夕

[RunResponseContent] Content: 食

[RunResponseContent] Content: の

[RunResponseContent] Content: 獲

[RunResponseContent] Content: 物

[RunResponseContent] Content: を

[RunResponseContent] Content: 見

[RunResponseContent] Content: つ

[RunResponseContent] Content: け

[RunResponseContent] Content: る

[RunResponseContent] Content: 冒

[RunResponseContent] Content: 険

[RunResponseContent] Content: へ

[RunResponseContent] Content: と

[RunResponseContent] Content: み

[RunResponseContent] Content: んな

[RunResponseContent] Content: を

[RunResponseContent] Content: 誘

[RunResponseContent] Content: った

[RunResponseContent] Content: 。

[RunCompleted]

イベントタイプは以下の通り

| カテゴリ | イベントタイプ | 説明 |

|---|---|---|

| コア | RunStarted |

実行の開始を示す |

| コア | RunResponseContent |

モデルの応答テキスト(チャンクごと) |

| コア | RunCompleted |

実行が正常に完了したことを示す |

| コア | RunError |

エラーが発生したことを示す |

| コア | RunCancelled |

実行がキャンセルされたことを示す |

| 制御フロー | RunPaused |

実行が一時停止されたことを示す |

| 制御フロー | RunContinued |

一時停止から実行が再開されたことを示す |

| ツール | ToolCallStarted |

ツールの呼び出しが開始されたことを示す |

| ツール | ToolCallCompleted |

ツールの呼び出しが完了し、結果が含まれる |

| 推論 | ReasoningStarted |

エージェントの推論処理が開始されたことを示す |

| 推論 | ReasoningStep |

推論処理の各ステップの内容 |

| 推論 | ReasoningCompleted |

推論処理が完了したことを示す |

| メモリ | MemoryUpdateStarted |

メモリの更新が開始されたことを示す |

| メモリ | MemoryUpdateCompleted |

メモリの更新が完了したことを示す |

でこれらのイベントを保存することができる・・・ってのがイマイチ意味がわからないが、これは通常のエージェントの会話履歴とは別に、Agentインスタンスにイベントレベルでの記録を保持させることができるということではないかと思う。これを保持することでおそらく以下のようなケースで使えるのだろうと思う。

- デバッグ: エージェントがうまく動かない時に、何が起こったかをあとから調べることができる

- 監査: 何をしたかの証跡を残す

- パフォーマンス分析: どこに時間がかかっているかを分析できる

- エラー調査: 問題が起きた時の原因を特定できる

イベントを保持させるにはエージェント初期化時にstore_events=Trueを付与する。

from typing import Iterator

from agno.agent import Agent, RunResponseEvent

from agno.models.openai import OpenAIChat

from agno.utils.pprint import pprint_run_response

agent = Agent(

model=OpenAIChat(id="gpt-4o-mini"),

store_events=True,

)

response_stream: Iterator[RunResponseEvent] = agent.run(

"ライオンについての5秒程度の短い物語を考えて。",

stream=True,

stream_intermediate_steps=True,

)

pprint_run_response(response_stream, markdown=True)

なお、デフォルトだと、LLMからの応答が含まれるRunResponseContentEventはスキップされるようになっていて、これをカスタマイズするには、events_to_skip でスキップしたいイベントを指定する。

from agno.agent import RunEvent

agent = Agent(

model=OpenAIChat(id="gpt-4o-mini"),

store_events=True,

events_to_skip=[RunEvent.run_started.value]

)

イベントの保持については、Agentが何を管理しているのか?をもう少し理解しないとわからない気がするので、おいおい。

メトリクス

上の方でサンプルを実行した際にも出力されていたが、エージェントを実行した際のレスポンスには実行に関するメトリクスが含まれる。これらのメトリクスを使用することで、リソース使用状況やパフォーマンス等を把握することができる。

メトリクスは複数のレベルで利用可能

- メッセージごと: アシスタントやツール呼び出し等の個々のメッセージ(

Message.metrics) - ツール呼び出しごと: 個々のツール実行(

ToolExecution.metrics) - 集計: 実行中の全てのメッセージのメトリクスを

RunResponseが集計(RunResponse.metrics)

実際にエージェントを実行してそのメトリクスを取得してみる。

from typing import Iterator

from agno.agent import Agent, RunResponse

from agno.models.openai import OpenAIChat

from agno.tools.yfinance import YFinanceTools

from rich.pretty import pprint

agent = Agent(

model=OpenAIChat(id="gpt-4o-mini"),

tools=[YFinanceTools(stock_price=True)],

markdown=True,

show_tool_calls=True,

)

agent.print_response(

"NVDAの株価を教えて。", stream=True

)

# メッセージごとのメトリクスを出力

if agent.run_response.messages:

for message in agent.run_response.messages:

if message.role == "assistant":

if message.content:

print(f"メッセージ: {message.content}")

elif message.tool_calls:

print(f"ツール呼び出し: {message.tool_calls}")

print("---" * 5, "メトリクス", "---" * 5)

pprint(message.metrics)

print("---" * 20)

# 全実行で集計されたメトリクスを表示

print("---" * 5, "収集されたメトリクス", "---" * 5)

pprint(agent.run_response.metrics)

# 全セッションで集計されたメトリクス

print("---" * 5, "セッションメトリクス", "---" * 5)

pprint(agent.session_metrics)

▰▱▱▱▱▱▱ Thinking...

┏━ Message ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ NVDAの株価を教えて。 ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

┏━ Tool Calls ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ • get_current_stock_price(symbol=NVDA) ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

┏━ Response (1.9s) ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ 現在のNVIDIA(NVDA)の株価は 172.41ドル です。 ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

ツール呼び出し: [{'id': 'call_pjiFW7AvucgDftoCVw5VKqMz', 'type': 'function', 'function': {'name': 'get_current_stock_price', 'arguments': '{"symbol":"NVDA"}'}}]

--------------- メトリクス ---------------

MessageMetrics(

│ input_tokens=86,

│ output_tokens=17,

│ total_tokens=103,

│ audio_tokens=0,

│ input_audio_tokens=0,

│ output_audio_tokens=0,

│ cached_tokens=0,

│ cache_write_tokens=0,

│ reasoning_tokens=0,

│ prompt_tokens=86,

│ completion_tokens=17,

│ prompt_tokens_details={'audio_tokens': 0, 'cached_tokens': 0},

│ completion_tokens_details={

│ │ 'accepted_prediction_tokens': 0,

│ │ 'audio_tokens': 0,

│ │ 'reasoning_tokens': 0,

│ │ 'rejected_prediction_tokens': 0

│ },

│ additional_metrics=None,

│ time=0.5411598850005248,

│ time_to_first_token=0.45880826100074046,

│ timer=<agno.utils.timer.Timer object at 0x7b90e3c71050>

)

------------------------------------------------------------

メッセージ: 現在のNVIDIA(NVDA)の株価は **172.41ドル** です。

--------------- メトリクス ---------------

MessageMetrics(

│ input_tokens=117,

│ output_tokens=21,

│ total_tokens=138,

│ audio_tokens=0,

│ input_audio_tokens=0,

│ output_audio_tokens=0,

│ cached_tokens=0,

│ cache_write_tokens=0,

│ reasoning_tokens=0,

│ prompt_tokens=117,

│ completion_tokens=21,

│ prompt_tokens_details={'audio_tokens': 0, 'cached_tokens': 0},

│ completion_tokens_details={

│ │ 'accepted_prediction_tokens': 0,

│ │ 'audio_tokens': 0,

│ │ 'reasoning_tokens': 0,

│ │ 'rejected_prediction_tokens': 0

│ },

│ additional_metrics=None,

│ time=0.899993072000143,

│ time_to_first_token=0.6238179249994573,

│ timer=<agno.utils.timer.Timer object at 0x7b90e3c72250>

)

------------------------------------------------------------

--------------- 収集されたメトリクス ---------------

{

│ 'input_tokens': [86, 117],

│ 'output_tokens': [17, 21],

│ 'total_tokens': [103, 138],

│ 'audio_tokens': [0, 0],

│ 'input_audio_tokens': [0, 0],

│ 'output_audio_tokens': [0, 0],

│ 'cached_tokens': [0, 0],

│ 'cache_write_tokens': [0, 0],

│ 'reasoning_tokens': [0, 0],

│ 'prompt_tokens': [86, 117],

│ 'completion_tokens': [17, 21],

│ 'prompt_tokens_details': [{'audio_tokens': 0, 'cached_tokens': 0}, {'audio_tokens': 0, 'cached_tokens': 0}],

│ 'completion_tokens_details': [

│ │ {

│ │ │ 'accepted_prediction_tokens': 0,

│ │ │ 'audio_tokens': 0,

│ │ │ 'reasoning_tokens': 0,

│ │ │ 'rejected_prediction_tokens': 0

│ │ },

│ │ {

│ │ │ 'accepted_prediction_tokens': 0,

│ │ │ 'audio_tokens': 0,

│ │ │ 'reasoning_tokens': 0,

│ │ │ 'rejected_prediction_tokens': 0

│ │ }

│ ],

│ 'time': [0.5411598850005248, 0.899993072000143],

│ 'time_to_first_token': [0.45880826100074046, 0.6238179249994573]

}

--------------- セッションメトリクス ---------------

SessionMetrics(

│ input_tokens=203,

│ output_tokens=38,

│ total_tokens=241,

│ audio_tokens=0,

│ input_audio_tokens=0,

│ output_audio_tokens=0,

│ cached_tokens=0,

│ cache_write_tokens=0,

│ reasoning_tokens=0,

│ prompt_tokens=203,

│ completion_tokens=38,

│ prompt_tokens_details={'audio_tokens': 0, 'cached_tokens': 0},

│ completion_tokens_details={

│ │ 'accepted_prediction_tokens': 0,

│ │ 'audio_tokens': 0,

│ │ 'reasoning_tokens': 0,

│ │ 'rejected_prediction_tokens': 0

│ },

│ additional_metrics=None,

│ time=1.4411529570006678,

│ time_to_first_token=0.45880826100074046,

│ timer=None

)

上から順に、

- ツール呼び出し時のメトリクス

- LLMからの応答メッセージのメトリクス

- 個々の実行を集計したメトリクス

- セッション全体で集計したメトリクス

という感じになっている。個々の処理にかかった時間以外にTTFTの時間なんかも入っているのはとても便利だと感じる。

基本となるMessageMetricsのパラメータは以下。ただし、これはモデルやツールによって異なる場合がある点に注意。

| フィールド名 | 説明 |

|---|---|

input_tokens |

モデルへの入力(プロンプト)のトークン数 |

output_tokens |

モデルが出力したトークン数 |

total_tokens |

入力+出力の合計トークン数 |

prompt_tokens |

プロンプトのトークン数(OpenAIの場合はinput_tokensと同じ) |

completion_tokens |

完了部分のトークン数(OpenAIの場合はoutput_tokensと同じ) |

audio_tokens |

音声入力/出力に使われたトークンの合計 |

input_audio_tokens |

入力音声のトークン数 |

output_audio_tokens |

出力音声のトークン数 |

cached_tokens |

キャッシュから提供されたトークン数(キャッシュ利用時) |

cache_write_tokens |

キャッシュに書き込まれたトークン数 |

reasoning_tokens |

推論ステップで使われたトークン数(有効時のみ) |

prompt_tokens_details |

プロンプトトークンの詳細な内訳(OpenAIで利用) |

completion_tokens_details |

完了トークンの詳細な内訳(OpenAIで利用) |

additional_metrics |

モデルやツールが提供する追加メトリクス(例:レイテンシ、コストなど) |

time |

メッセージ生成にかかった時間(秒単位) |

time_to_first_token |

最初のトークンが生成されるまでの時間(秒単位) |

セッション

Agent.run() そのものはステートレスで実行される。これをマルチターンで実行するのが「セッション」になる。「セッション」を使うとsession_id を使用して、複数回のAgent.run() の実行において、会話の履歴と状態を維持することができる。

セッションの主要な概念は以下。

-

セッション

- ユーザとエージェント間で行われる連続した実行の集まりを「セッション」と呼ぶ。

- 例えば、マルチターンの一連の会話は1セッションとなる。

- 各セッションは

session_idで識別され、セッション内の各ターンが 「ラン(run)」になる。

-

ラン

- ユーザとエージェント間で行われる個々のインタラクション(チャットまたはターン)を「ラン(run)」と呼ぶ。つまり個々のインタラクションの「実行」のこと。

- 各ランは

run_idで識別され、Agent.run()が呼び出されると、新しいrun_idが作成される。

-

メッセージ

- モデルとエージェント間で送信される個々のメッセージ。

- メッセージはエージェントとモデル間の通信プロトコルと言える。

例えば以下

from typing import Iterator

from agno.agent import Agent, RunResponse

from agno.models.openai import OpenAIChat

from agno.utils.pprint import pprint_run_response

agent = Agent(model=OpenAIChat(id="gpt-4o-mini"))

agent.print_response(

"ロボットについての5秒程度の短い物語を考えて。",

stream=True

)

▰▰▰▰▰▰▰ Thinking...

┏━ Message ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ ロボットについての5秒程度の短い物語を考えて。 ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

┏━ Response (1.4s) ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ 小さな町に、毎日花を水やりするロボットがいた。ある日、住民たちが集まり、ロボットに「ありがとう」と感謝の花束を ┃

┃ 贈った。その瞬間、ロボットの目がキラキラと輝き、心が温かく感じた。これが、友情の始まりだった。 ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

runは一度しか実行されていないので、run_idが自動生成されるとともに、session_id も生成される(セッションIDを指定せずに実行、つまり「初回」扱いになるのでセッションIDが発行される)

print("Run ID:", agent.run_id)

print("Session ID:", agent.session_id)

Run ID: 6cfa16b2-a256-4c1c-aa3f-1ebe7f49707f

Session ID: 9446b2ad-fbb3-43ee-afd3-beda883bfe09

ただしこの状態は単に発行されただけで何も管理されていないのと同じ。一般的には、エージェントとそのユーザの間の会話は、個々のユーザを識別、さらにトピックごとに個々のセッションを識別、その中で個々のインタラクションがランとなるのが普通だと思う。

Agnoでは、user_id を ランに与えることでこれを識別でき、さらに session_id を与えると会話のトピックも識別できる「マルチユーザ・マルチセッション」を実現している。

複数ユーザでのマルチターンのサンプルコード。なお、ドキュメントにあるものはレスポンスが出力されなかったのでストリーミングを有効にしてある。

from agno.agent import Agent

from agno.models.openai import OpenAIChat

from agno.memory.v2 import Memory

agent = Agent(

model=OpenAIChat(id="gpt-4o-mini"),

# エージェントにメモリを与える。なお、マルチユーザ・マルチセッションは

# Memory.v2を使用する必要がある

memory=Memory(),

add_history_to_messages=True,

num_history_runs=3,

)

user_1_id = "user_101"

user_2_id = "user_102"

user_1_session_id = "session_101"

user_2_session_id = "session_102"

# ユーザ1とのセッションを開始

agent.print_response(

"ロボットについての5秒程度の短い物語を考えて。",

stream=True,

user_id=user_1_id,

session_id=user_1_session_id,

)

# ユーザ1とのセッションを継続

agent.print_response(

"じゃあそれについてのジョークも考えて。",

stream=True,

user_id=user_1_id,

session_id=user_1_session_id

)

# ユーザ2とのセッションを開始

agent.print_response(

"量子物理学についてかなり簡潔に教えてください。",

stream=True,

user_id=user_2_id,

session_id=user_2_session_id

)

# ユーザ2とのセッションを継続

agent.print_response(

"一言で言えば?",

stream=True,

user_id=user_2_id,

session_id=user_2_session_id

)

# エージェントに、ユーザ1との過去の会話履歴から

# 会話内容の要約を行わせる

agent.print_response(

"これまでの会話の内容を要約して。",

stream=True,

user_id=user_1_id,

session_id=user_1_session_id,

)

結果

▰▱▱▱▱▱▱ Thinking...

┏━ Message ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ ロボットについての5秒程度の短い物語を考えて。 ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

┏━ Response (1.9s) ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ 小さな村に住むロボット、トモは、毎朝花を水やりしていた。ある日、村人たちが忘れた笑顔を取り戻すため、彼は色とり ┃

┃ どりの花を植え始めた。村に花が咲き誇ると、みんなが笑顔になり、トモも心が温かくなった。 ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

▰▱▱▱▱▱▱ Thinking...

┏━ Message ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ じゃあそれについてのジョークも考えて。 ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

┏━ Response (1.7s) ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ ロボットのトモが村で花を育てていた。 ┃

┃ ┃

┃ 村人:「トモ、どうしてそんなに花が好きなの?」 ┃

┃ ┃

┃ トモ:「だって、みんなが笑顔になるから。花は最高のソフトウェアだよ!」 ┃

┃ ┃

┃ 村人:「ソフトウェア?」 ┃

┃ ┃

┃ トモ:「だって、バグ(虫)も来るけど、アップデート(手入れ)すれば解決するから!」 ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

▰▰▰▰▱▱▱ Thinking...

┏━ Message ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ 量子物理学についてかなり簡潔に教えてください。 ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

┏━ Response (2.5s) ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ 量子物理学は、物質やエネルギーの最小単位である原子や粒子の振る舞いを研究する物理学の分野です。一般的な物理学で ┃

┃ は予測できない現象、例えば、粒子が同時に複数の状態にある(重ね合わせ)、観測するまで状態が確定しない(波動関数 ┃

┃ の崩壊)といった特性を持ちます。量子もつれ、トンネル効果、量子コンピュータなど、現代の技術や理論にも大きな影響 ┃

┃ を与え ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

▰▰▰▰▱▱▱ Thinking...

┏━ Message ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ 一言で言えば? ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

┏━ Response (0.8s) ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ 量子物理学は、微小な粒子の奇妙な振る舞いを研究する学問です。 ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

▰▰▰▰▰▰▱ Thinking...

┏━ Message ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ これまでの会話の内容を要約して。 ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

┏━ Response (4.4s) ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ 会話では、ロボットのトモが村で花を育て、村人たちに笑顔をもたらす短い物語が紹介されました。さらに、その物語に基 ┃

┃ づいて、トモが花を育てる理由をユーモラスに説明するジョークも考案されました。ジョークでは、花の手入れがソフトウ ┃

┃ ェアのアップデートに例えられました。 ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

さらに、会話のセッションが増えていくと、過去Nセッションを会話履歴に含めて、一連の会話の連続性や文脈の一貫性を維持したいという場合もある。その場合は以下を指定する。

-

search_previous_sessions_history: bool。過去のセッションを検索するか? -

num_history_sessions: int。過去のセッションのうち、直近の何セッションを検索に含めるか?あまり大きな数を指定すると入力コンテキストサイズを超える可能性があるので注意。2 か 3 が推奨。

サンプルコードは同一ユーザで複数のセッションがある、という前提で、過去2セッションを検索対象に含めるというものになっている。

import os

from agno.agent import Agent

from agno.models.openai import OpenAIChat

from agno.storage.sqlite import SqliteStorage

try:

os.remove("tmp/data.db")

except FileNotFoundError:

pass

agent = Agent(

model=OpenAIChat(id="gpt-4o-mini"),

user_id="user_1",

storage=SqliteStorage(table_name="agent_sessions_new", db_file="tmp/data.db"),

search_previous_sessions_history=True,

num_history_sessions=2,

show_tool_calls=True,

)

session_1_id = "session_1_id"

session_2_id = "session_2_id"

session_3_id = "session_3_id"

session_4_id = "session_4_id"

session_5_id = "session_5_id"

agent.print_response(

"南アフリカの首都は?",

stream=True,

session_id=session_1_id

)

agent.print_response(

"中国の首都は?",

stream=True,

session_id=session_2_id

)

agent.print_response(

"フランスの首都は?",

stream=True,

session_id=session_3_id

)

agent.print_response(

"日本の首都は?",

stream=True,

session_id=session_4_id

)

agent.print_response(

"さっき何の話してたっけ?",

stream=True,

session_id=session_5_id

) # 直近2セッションのみを対象とする。

▰▱▱▱▱▱▱ Thinking...

┏━ Message ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ 南アフリカの首都は? ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

┏━ Response (1.5s) ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ 南アフリカには3つの首都があります。それぞれの首都は異なる政府機能を持っています。 ┃

┃ ┃

┃ 1. プレトリア - 行政府 ┃

┃ 2. ケープタウン - 立法府 ┃

┃ 3. ブルームフォンテーン - 司法府 ┃

┃ ┃

┃ このため、南アフリカの首都は単に一つではなく、3つの都市がそれぞれ異なる役割を果たしています。 ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

▰▰▰▱▱▱▱ Thinking...

┏━ Message ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ 中国の首都は? ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

┏━ Response (0.6s) ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ 中国の首都は北京市(ぺきんし)です。 ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

▰▰▰▱▱▱▱ Thinking...

┏━ Message ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ フランスの首都は? ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

┏━ Response (0.6s) ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ フランスの首都はパリです。 ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

▰▰▱▱▱▱▱ Thinking...

┏━ Message ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ 日本の首都は? ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

┏━ Response (0.5s) ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ 日本の首都は東京です。 ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

▰▱▱▱▱▱▱ Thinking...

┏━ Message ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ さっき何の話してたっけ? ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

┏━ Response (1.7s) ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ 先ほどは日本の首都やフランスの首都について話していました。日本の首都は東京で、フランスの首都はパリです。 ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

セッションの概念は、単なる1つの会話履歴で全てを管理する、という感じになっていないところには注意が必要かな。

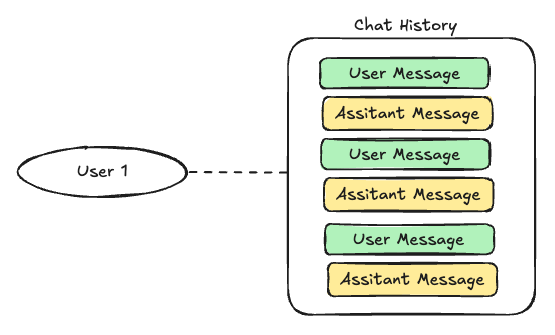

Agnoに関係なく、一般的な会話履歴の管理をめちゃめちゃプリミティブにやるとたぶんこう。

Agnoの場合はここに「セッション」という中間概念が入ってくる。ChatGPTでいうところの「新しいチャット」というか「スレッド」みたいなものだよね。

でセッションごとにコンテキストは分かれるけど、直近のものを共有することもできる、って感じかな。

過去の会話履歴を引き継ぎたい場合もあれば、場合によってはコンテキストを狭くしたりしたい場合もあって、この辺のバランスは難しいなぁ・・・

エージェントの状態

エージェントが実行中に維持したいデータは状態に保持する。一般的なユースケースとし、ユーザの買い物リスト、Todoリスト、ウィッシュリストなどが挙げられている。

これらは session_state を使用して管理する。

-

Agentはsession_stateパラメータを持つ。 -

session_stateは辞書であり、ここに状態を表す変数を追加する。 - ツール呼び出しや他の関数は

session_stateを更新する。 - 現在の

session_stateを、descriptionとinstructionsでモデルに共有する。 -

session_stateは エージェントのセッションと一緒に保存され、データベースに永続化される。つまり、実行サイクル全体で利用可能となり、agent.run()の呼び出しの間にセッションを切り替えるときも、状態はロードされ、利用可能となる。 -

session_stateをagent.run()でエージェントに渡すことで、エージェント初期化時に設定された状態を上書きすることが可能。

サンプル。

from agno.agent import Agent

from agno.models.openai import OpenAIChat

# 買い物リストにアイテムを追加するツールを定義

def add_item(agent: Agent, item: str) -> str:

"""買い物リストにアイテムを追加する"""

agent.session_state["shopping_list"].append(item)

return f"現在の買い物リスト: {agent.session_state['shopping_list']}"

# 状態を維持するエージェントを作成

agent = Agent(

model=OpenAIChat(id="gpt-4o-mini"),

# セッションの状態を空の状態で初期化

session_state={"shopping_list": []},

tools=[add_item],

# 指示の中でセッションの状態を変数で指定できる

instructions="Current state (shopping list) is: {shopping_list}",

# 重要: `add_state_in_messages=True`で、メッセージに状態を追加する

# これを指定することで、session_state 辞書のキーを instructions と

# description で使えるようになる

add_state_in_messages=True,

markdown=True,

)

# 使い方のサンプル

agent.print_response(

"牛乳と卵とパンを買い物リストに追加して",

stream=True

)

print(f"最終的なセッションの状態: {agent.session_state}")

▰▰▰▰▱▱▱ Thinking...

┏━ Message ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ 牛乳と卵とパンを買い物リストに追加して ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

┏━ Tool Calls ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ • add_item(item=牛乳) ┃

┃ • add_item(item=卵) ┃

┃ • add_item(item=パン) ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

┏━ Response (2.4s) ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ 買い物リストに以下のアイテムを追加しました: ┃

┃ ┃

┃ • 牛乳 ┃

┃ • 卵 ┃

┃ • パン ┃

┃ ┃

┃ 現在の買い物リストは次の通りです: ┃

┃ ┃

┃ • 牛乳 ┃

┃ • 卵 ┃

┃ • パン ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

最終的なセッションの状態: {'shopping_list': ['牛乳', '卵', 'パン']}

セッションを使えば、その中の個々のランでも状態を維持できる。以下はユーザの買い物リストの管理を行うエージェントの例。

from textwrap import dedent

from agno.agent import Agent

from agno.models.openai import OpenAIChat

# 買い物リストを管理するツールを定義

def add_item(agent: Agent, item: str) -> str:

"""買い物リストにアイテムを追加し、確認を返す"""

# アイテムがリストになければ追加、すでにある場合は追加しない

if item.lower() not in [i.lower() for i in agent.session_state["shopping_list"]]:

agent.session_state["shopping_list"].append(item)

return f"'{item}' を買い物リストに追加しました"

else:

return f"'{item}' はすでに買い物リストに入っていました。"

def remove_item(agent: Agent, item: str) -> str:

"""買い物リストからアイテムを削除、削除したいアイテム名を指定する"""

for i, list_item in enumerate(agent.session_state["shopping_list"]):

agent.session_state["shopping_list"].pop(i)

return f"'{list_item}' を買い物リストから削除しました"

return f"'{item}' は買い物リストに入っていませんでした。"

def list_items(agent: Agent) -> str:

"""買い物リストのアイテムの一覧を返す"""

shopping_list = agent.session_state["shopping_list"]

if not shopping_list:

return "買い物リストには何も入っていませんでした。"

items_text = "\n".join([f"- {item}" for item in shopping_list])

return f"現在の買い物リスト:\n{items_text}"

# 状態を維持する買い物リスト管理エージェントを作成

agent = Agent(

model=OpenAIChat(id="gpt-4o-mini"),

# 空の買い物リストでセッションの状態を初期化

session_state={"shopping_list": []},

tools=[add_item, remove_item, list_items],

# 指示の中でセッションの状態を変数で指定できる

instructions=dedent("""\

あなたの仕事は、ユーザの買い物リストを管理することです。

買い物リストは空の状態で開始します。あなたはアイテムの追加、削除、一覧の確認ができます。

現在の買い物リスト: {shopping_list}

"""),

show_tool_calls=True,

# 重要: `add_state_in_messages=True`で、メッセージに状態を追加する

# これを指定することで、session_state 辞書のキーを instructions と

# description で使えるようになる

add_state_in_messages=True,

markdown=True,

)

# 使い方の例

agent.print_response(

"牛乳と卵とパンを買い物リストに追加して",

stream=True

)

print(f"セッションの状態: {agent.session_state}")

agent.print_response(

"パンは買いました。",

stream=True

)

print(f"セッションの状態: {agent.session_state}")

agent.print_response(

"卵ももう買いました。",

stream=True

)

print(f"セッションの状態: {agent.session_state}")

agent.print_response(

"リンゴとオレンジが必要ですね。",

stream=True

)

print(f"セッションの状態: {agent.session_state}")

agent.print_response(

"リストには何がある?",

stream=True

)

print(f"セッションの状態: {agent.session_state}")

agent.print_response("買い物リストを全部消して、バナナとヨーグルトから始めて", stream=True)

print(f"セッションの状態: {agent.session_state}")

▰▰▰▰▰▱▱ Thinking...

┏━ Message ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ 牛乳と卵とパンを買い物リストに追加して ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

┏━ Tool Calls ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ • add_item(item=牛乳) ┃

┃ • add_item(item=卵) ┃

┃ • add_item(item=パン) ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

┏━ Response (2.8s) ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ 以下のアイテムが買い物リストに追加されました: ┃

┃ ┃

┃ • 牛乳 ┃

┃ • 卵 ┃

┃ • パン ┃

┃ ┃

┃ 現在の買い物リスト: [牛乳, 卵, パン] ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

セッションの状態: {'shopping_list': ['牛乳', '卵', 'パン']}

▰▱▱▱▱▱▱ Thinking...

┏━ Message ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ パンは買いました。 ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

┏━ Tool Calls ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ • remove_item(item=パン) ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

┏━ Response (1.7s) ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ パンは買い物リストから削除しました。現在の買い物リストは以下の通りです: ┃

┃ ┃

┃ • 牛乳 ┃

┃ • 卵 ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

セッションの状態: {'shopping_list': ['卵', 'パン']}

▰▱▱▱▱▱▱ Thinking...

┏━ Message ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ 卵ももう買いました。 ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

┏━ Tool Calls ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ • remove_item(item=卵) ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

┏━ Response (2.0s) ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ 卵を買い物リストから削除しました。現在の買い物リストは以下の通りです。 ┃

┃ ┃

┃ • パン ┃

┃ ┃

┃ 他に何か追加したり、削除したりしたいアイテムはありますか? ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

セッションの状態: {'shopping_list': ['パン']}

▰▰▱▱▱▱▱ Thinking...

┏━ Message ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ リンゴとオレンジが必要ですね。 ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

┏━ Tool Calls ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ • add_item(item=リンゴ) ┃

┃ • add_item(item=オレンジ) ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

┏━ Response (3.7s) ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ リンゴとオレンジを買い物リストに追加しました。 ┃

┃ ┃

┃ 現在の買い物リストは以下の通りです: ┃

┃ ┃

┃ • パン ┃

┃ • リンゴ ┃

┃ • オレンジ ┃

┃ ┃

┃ 他に必要なアイテムはありますか? ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

セッションの状態: {'shopping_list': ['パン', 'リンゴ', 'オレンジ']}

▰▰▰▰▱▱▱ Thinking...

┏━ Message ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ リストには何がある? ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

┏━ Response (1.0s) ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ 現在の買い物リストには以下のアイテムがあります: ┃

┃ ┃

┃ • パン ┃

┃ • リンゴ ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

セッションの状態: {'shopping_list': ['パン', 'リンゴ', 'オレンジ']}

▰▱▱▱▱▱▱ Thinking...

┏━ Message ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ 買い物リストを全部消して、バナナとヨーグルトから始めて ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

┏━ Tool Calls ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ • remove_item(item=パン) ┃

┃ • remove_item(item=リンゴ) ┃

┃ • remove_item(item=オレンジ) ┃

┃ • add_item(item=バナナ) ┃

┃ • add_item(item=ヨーグルト) ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

┏━ Response (3.4s) ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ 買い物リストは以下のように更新されました: ┃

┃ ┃

┃ • 削除されたアイテム: ┃

┃ • パン ┃

┃ • リンゴ ┃

┃ • オレンジ ┃

┃ • 追加されたアイテム: ┃

┃ • バナナ ┃

┃ • ヨーグルト ┃

┃ ┃

┃ 現在の買い物リスト: ┃

┃ ┃

┃ • バナナ ┃

┃ • ヨーグルト ┃

┃ ┃

┃ 何か他にやりたいことはありますか? ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

セッションの状態: {'shopping_list': ['バナナ', 'ヨーグルト']}

複数回のランが1つのセッションで管理されていることで、状態を共有できているのがわかる。

上にも少し書いているが、add_state_in_messages=True を設定すると、セッションの状態で定義した変数を 指示の中に含めることができる。

from textwrap import dedent

from agno.agent import Agent

from agno.models.openai import OpenAIChat

agent = Agent(

model=OpenAIChat(id="gpt-4o-mini"),

session_state={"user_name": "太郎"},

instructions="Users name is {user_name}",

show_tool_calls=True,

add_state_in_messages=True,

markdown=True,

)

agent.print_response("私の名前は?", stream=True)

▰▰▱▱▱▱▱ Thinking...

┏━ Message ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ 私の名前は? ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

┏━ Response (0.5s) ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ あなたの名前は 太郎 です。 ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

注意としては f-string で指定してはいけない。状態の辞書のキーを直接 {key} で指定すること。

agent.run() でエージェントにsession_id を渡すと、該当のセッションが呼び出され、そのセッションで設定された状態をロードすることができる。

from agno.agent import Agent

from agno.models.openai import OpenAIChat

agent = Agent(

model=OpenAIChat(id="gpt-4o-mini"),

add_state_in_messages=True,

instructions="ユーザの名前は {user_name} で、年齢は {age} 歳です。",

)

# セッションIDを指定して、セッションの状態をセット

agent.print_response(

"私の名前は?",

stream=True,

session_id="user_1_session_1",

user_id="user_1",

session_state={"user_name": "太郎", "age": 30}

)

# 指定したセッションIDのセッションからセッションの状態をロードする

agent.print_response(

"私は何歳?",

stream=True,

session_id="user_1_session_1",

user_id="user_1"

)

# 別のセッションIDで、セションの状態をセット

agent.print_response(

"私の名前は?",

stream=True,

session_id="user_2_session_1",

user_id="user_2",

session_state={"user_name": "花子", "age": 25}

)

# 指定したセッションIDのセッションからセッションの状態をロードする

agent.print_response(

"私は何歳?",

stream=True,

session_id="user_2_session_1",

user_id="user_2"

)

▰▱▱▱▱▱▱ Thinking...

┏━ Message ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ 私の名前は? ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

┏━ Response (1.6s) ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ あなたの名前は太郎です。 ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

▰▰▱▱▱▱▱ Thinking...

┏━ Message ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ 私は何歳? ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

┏━ Response (0.5s) ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ あなたは30歳です。 ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

▰▰▱▱▱▱▱ Thinking...

┏━ Message ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ 私の名前は? ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

┏━ Response (0.5s) ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ あなたの名前は花子 ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

▰▰▱▱▱▱▱ Thinking...

┏━ Message ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ 私は何歳? ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

┏━ Response (0.4s) ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ あなたは25歳です。 ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

session_state は エージェントが持つセッションに含まれ。storageドライバーが提供されている場合は、各ランの実行ごとにデーエベースに保存される。これにより状態の永続化が可能となる。

ストレージにSQLiteを使用する場合のサンプル。sqlalchemyをインストールする必要がある。

!pip install sqlalchemy

import os

# データベースを初期化

DB_FILE = "tmp/data.db"

try:

os.remove(DB_FILE)

except FileNotFoundError:

pass

from agno.agent import Agent

from agno.models.openai import OpenAIChat

from agno.storage.sqlite import SqliteStorage

# 買い物リストにアイテムを追加するツールを定義

def add_item(agent: Agent, item: str) -> str:

"""買い物リストにアイテムを追加する"""

if item not in agent.session_state["shopping_list"]:

agent.session_state["shopping_list"].append(item)

return f"現在の買い物リスト: {agent.session_state['shopping_list']}"

agent = Agent(

model=OpenAIChat(id="gpt-4o-mini"),

# 実行サイクルを跨いで同じセッションを継続したい場合はここでセッションIDを指定

session_id="fixed_id_for_demo",

# 空の買い物リストでセッションの状態を初期化

session_state={"shopping_list": []},

# 買い物リストにアイテムを追加するツールをエージェントに渡す

tools=[add_item],

# セッションの状態をSQLiteデータベースに保存

storage=SqliteStorage(table_name="agent_sessions", db_file=DB_FILE),

# 現在の買い物リストの状態を取得して、指示に追加

instructions="現在の買い物リスト: {shopping_list}",

# 重要: `add_state_in_messages=True`で、メッセージに状態を追加する

# これを指定することで、session_state 辞書のキーを instructions と

# description で使えるようになる

add_state_in_messages=True,

markdown=True,

)

# 使い方の例

agent.print_response(

"買い物リストには何が入ってる?",

stream=True

)

print(f"セッションの状態: {agent.session_state}")

agent.print_response(

"牛乳と卵とパンを買い物リストに追加して",

stream=True

)

print(f"セッションの状態: {agent.session_state}")```

```text:出力

▰▰▰▰▰▰▱ Thinking...

┏━ Message ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ 買い物リストには何が入ってる? ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

┏━ Response (1.2s) ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ 現在の買い物リストは空です。アイテムを追加したい場合は教えてください! ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

セッションの状態: {'shopping_list': []}

▰▰▰▰▰▰▰ Thinking...

┏━ Message ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ 牛乳と卵とパンを買い物リストに追加して ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

┏━ Tool Calls ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ • add_item(item=牛乳) ┃

┃ • add_item(item=卵) ┃

┃ • add_item(item=パン) ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

┏━ Response (2.9s) ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ 買い物リストに以下のアイテムが追加されました: ┃

┃ ┃

┃ • 牛乳 ┃

┃ • 卵 ┃

┃ • パン ┃

┃ ┃

┃ 現在の買い物リスト: ┃

┃ ┃

┃ • 牛乳 ┃

┃ • 卵 ┃

┃ • パン ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

セッションの状態: {'shopping_list': ['牛乳', '卵', 'パン']}

sqlite3で直接確認してみる

!apt update && apt install -y sqlite3

!echo -e 'SELECT session_data FROM agent_sessions WHERE session_id == "fixed_id_for_demo";' \

| sqlite3 tmp/data.db \

| jq -r .session_state

{

"shopping_list": [

"牛乳",

"卵",

"パン"

]

}

メモリ

エージェントにメモリを与えると、ユーザごとのパーソナライズされた関連情報・コンテキストを呼び出すことができる。

Agnoにおけるメモリは以下を指す。

-

セッションストレージ(チャット履歴とセッションの状態)

- エージェントのセッションをデータベースに保存することで、会話のコンテキストを維持したマルチターンの会話が可能。

- セッションの「状態」もセッションストレージに保持され、各実行後に都度保存され、実行中はこれが維持される。

- セッションストレージは、短期記憶の一つの形態であり、Agnoでは「ストレージ」と呼ぶ。

-

ユーザーメモリ(ユーザー嗜好)

- エージェントは、会話を通して学んだユーザーに関する洞察や事実を保存することができ、対話中のユーザに対してパーソナライズされた応答を行うことができる。

- つまり、エージェントに「ChatGPTのようなメモリ」を追加することと同じ。

- Agnoでは 「メモリ」と呼ぶ。

-

セッションサマリ (チャットサマリ)

- チャットの履歴が長くなりすぎた場合、セッションを圧縮された表現で保存できる。

- 入力コンテキストサイズを超えないようにするのに便利。

- Agnoでは「サマリ」と呼ぶ。

さらにもう一つ「デフォルトの内蔵メモリ」というものがある様子。

会話履歴やらユーザプロファイルやらを一口に「メモリ」と言ってしまいがちだけど、Agnoにおいては細かく区別されていて、言葉の定義が異なるようなので、このあたりは意識したほうが良さそう。

メモリとストレージの使用例

メモリ(ユーザ情報)とストレージ(会話履歴)を使ったエージェントの例。

from agno.agent import Agent

from agno.memory.v2.db.sqlite import SqliteMemoryDb

from agno.memory.v2.memory import Memory

from agno.models.openai import OpenAIChat

from agno.storage.sqlite import SqliteStorage

from rich.pretty import pprint

# メモリのユーザID

user_id = "太郎"

# メモリとストレージのデータベースファイル

db_file = "tmp/agent.db"

# memory.v2の初期化

memory = Memory(

# メモリを作成するモデルを指定

model=OpenAIChat(id="gpt-4.1"),

db=SqliteMemoryDb(

table_name="user_memories",

db_file=db_file

),

)

# ストレージの初期化

storage = SqliteStorage(table_name="agent_sessions", db_file=db_file)

# エージェントの初期化

memory_agent = Agent(

model=OpenAIChat(id="gpt-4.1"),

# メモリをデータベースに保存

memory=memory,

# エージェントによるメモリ更新を有効化

# - エージェントにユーザのメモリを管理するツールを与える

# - このツールはMemoryManagerクラスにタスクを渡す

enable_agentic_memory=True,

# 各レスポンス後に MemoryManager を実行

# - 各ユーザメッセージの後に常にMemoryManagerが実行される

enable_user_memories=True,

# 会話履歴をデータベースに保存

storage=storage,

# 会話履歴を送信されるメッセージに追加

add_history_to_messages=True,

# 追加される履歴数

num_history_runs=3,

markdown=True,

)

memory.clear()

memory_agent.print_response(

"私の名前は太郎です。私は競馬が好きです。",

user_id=user_id,

stream=True,

stream_intermediate_steps=True,

)

print("太郎に関するメモリ:")

pprint(memory.get_user_memories(user_id=user_id))

memory_agent.print_response(

"私は京都市内に住んでいます。京都競馬場に30分で行ける範囲に引っ越すならどこがおすすめ?",

user_id=user_id,

stream=True,

stream_intermediate_steps=True,

)

print("太郎に関するメモリ:")

pprint(memory.get_user_memories(user_id=user_id))

▰▱▱▱▱▱▱ Thinking...

┏━ Message ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ 私の名前は太郎です。私は競馬が好きです。 ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

┏━ Tool Calls ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ • update_user_memory(task=ユーザーの名前は太郎であること、競馬が好きであることを記憶してください。) ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

┏━ Response (4.9s) ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ 太郎さん、こんにちは!また何か競馬について聞きたいことや話題があれば、ぜひ教えてくださいね。 ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

太郎に関するメモリ:

[

│ UserMemory(

│ │ memory='ユーザーの名前は太郎である。',

│ │ topics=['名前'],

│ │ input='ユーザーの名前は太郎であること、競馬が好きであることを記憶してください。',

│ │ last_updated=datetime.datetime(2025, 7, 20, 23, 1, 20, 230673),

│ │ memory_id='c4159576-8f5c-492d-91cc-5d6e93c0c85a'

│ ),

│ UserMemory(

│ │ memory='ユーザーは競馬が好きである。',

│ │ topics=['趣味', '好きなこと'],

│ │ input='ユーザーの名前は太郎であること、競馬が好きであることを記憶してください。',

│ │ last_updated=datetime.datetime(2025, 7, 20, 23, 1, 20, 244479),

│ │ memory_id='f9472184-bbff-4184-a15f-b265e421f86f'

│ )

]

▰▰▰▰▰▰▰ Thinking...

┏━ Message ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ 私は京都市内に住んでいます。京都競馬場に30分で行ける範囲に引っ越すならどこがおすすめ? ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

┏━ Response (7.8s) ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ 太郎さん、京都市内にお住まいで、京都競馬場まで30分以内でアクセスできるエリアをご希望ですね。京都競馬場(伏見区 ┃

┃ 葭島渡場島町32)は、京阪本線「淀駅」が最寄りです。ここから30分圏内でアクセスしやすいエリアをいくつかご紹介しま ┃

┃ す。 ┃

┃ ┃

┃ 1. 丹波橋エリア(伏見区) ┃

┃ ┃

┃ • 京阪本線「丹波橋」駅から「淀」駅へは約7分。 ┃

┃ • 静かな住宅街が多く、生活もしやすいエリアです。 ┃

┃ ┃

┃ 2. 中書島エリア(伏見区) ┃

┃ ┃

┃ • 京阪本線「中書島」駅から「淀」駅へ約8分。 ┃

┃ • 宇治川周辺の自然もあり、落ち着いた雰囲気。 ┃

┃ ┃

┃ 3. 伏見桃山・藤森エリア ┃

┃ ┃

┃ • 京阪本線「伏見桃山」駅、「藤森」駅から「淀」駅へ10分前後。 ┃

┃ • 商業施設もあり、日常の買い物も便利。 ┃

┃ ┃

┃ 4. 樟葉エリア(大阪府枚方市) ┃

┃ ┃

┃ • 京阪本線「樟葉」駅から「淀」駅へ約8分。 ┃

┃ • 大型ショッピングモールもあり、ファミリー層にも人気。 ┃

┃ ┃

┃ 5. 八幡市エリア(京都府八幡市) ┃

┃ ┃

┃ • 京阪本線「八幡市」駅から「淀」駅まで2駅、約4分。 ┃

┃ • 落ち着いた住宅地で、公園や自然も多いです。 ┃

┃ ┃

┃ ─────────────────────────────────────────────────────────────────────────────────────────────────────────────── ┃

┃ 参考:移動時間の目安(京阪本線) ┃

┃ ┃

┃ ┃

┃ 駅名 「淀」駅までの所要時間(急行利用) ┃

┃ ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━ ┃

┃ 丹波橋 約7分 ┃

┃ 中書島 約8分 ┃

┃ 伏見桃山 約10分 ┃

┃ 藤森 約15分 ┃

┃ 樟葉 約8分 ┃

┃ 八幡市 約4分 ┃

┃ ┃

┃ ┃

┃ ─────────────────────────────────────────────────────────────────────────────────────────────────────────────── ┃

┃ どのエリアも「京都市内」および近隣で、競馬場にアクセスしやすい場所です。重視したいポイント(家賃・駅近・自然環 ┃

┃ 境など)に応じて選ばれるとよいでしょう。 ┃

┃ ┃

┃ もしさらに詳しい条件やご希望があれば、お知らせください! ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

太郎に関するメモリ:

[

│ UserMemory(

│ │ memory='ユーザーは京都市内に住んでいる。',

│ │ topics=['location'],

│ │ input='私は京都市内に住んでいます。京都競馬場に30分で行ける範囲に引っ越すならどこがおすすめ?',

│ │ last_updated=datetime.datetime(2025, 7, 20, 23, 1, 30, 351939),

│ │ memory_id='24b8fb2d-2346-4a1c-be10-4ebc6b362c55'

│ ),

│ UserMemory(

│ │ memory='ユーザーの名前は太郎である。',

│ │ topics=['名前'],

│ │ input='ユーザーの名前は太郎であること、競馬が好きであることを記憶してください。',

│ │ last_updated=datetime.datetime(2025, 7, 20, 23, 1, 20, 230673),

│ │ memory_id='c4159576-8f5c-492d-91cc-5d6e93c0c85a'

│ ),

│ UserMemory(

│ │ memory='ユーザーは競馬が好きである。',

│ │ topics=['趣味', '好きなこと'],

│ │ input='ユーザーの名前は太郎であること、競馬が好きであることを記憶してください。',

│ │ last_updated=datetime.datetime(2025, 7, 20, 23, 1, 20, 244479),

│ │ memory_id='f9472184-bbff-4184-a15f-b265e421f86f'

│ )

]

デフォルトメモリ

エージェントには、セッション内のメッセージ≒会話履歴を記録するメモリがデフォルトで内蔵されており、agent.get_messages_for_session()でアクセスできる。

エージェントが会話履歴にアクセスできるようにするには以下。

-

add_history_to_messages=Trueとnum_history_runs=Nを設定- エージェントに送信されるすべてのメッセージに、過去5回分のメッセージを自動的に追加する

-

read_chat_history=Trueを設定-

get_chat_history()ツールをエージェントに渡して、チャット履歴全体の任意のメッセージを読めるようにする

-

-

add_history_to_messages=True、num_history_runs=3、read_chat_history=Trueの3つをセットで設定するのが推奨 -

read_tool_call_history=Trueも設定すると、get_tool_call_history()ツールをエージェントに渡して、ツール呼び出しを時系列順に読み込むことができる

from agno.agent import Agent

from agno.models.openai import OpenAIChat

from rich.pretty import pprint

agent = Agent(

model=OpenAIChat(id="gpt-4.1"),

# `add_history_to_messages=true` をセットして、

# 過去の会話履歴をモデルに送信されるメッセージに追加

add_history_to_messages=True,

# メッセージに追加される過去のレスポンスの数

num_history_responses=3,

description=(

"あなたは、いつも丁寧で、明るく前向きな対応をする、"

"親切なアシスタントです。"

),

)

# -*- ランを作成

agent.print_response(

"2文のホラーストーリーを作って。",

stream=True

)

# -*- メモリ内のメッセージを表示

pprint([

m.model_dump(include={"role", "content"})

for m in agent.get_messages_for_session()

])

# -*- 前の会話を継続するための続きの質問を行う

agent.print_response(

"私の最初のメッセージは何だっけ?",

stream=True

)

# -*- Print the messages in the memory

pprint([

m.model_dump(include={"role", "content"})

for m in agent.get_messages_for_session()

])

▰▰▰▱▱▱▱ Thinking...

┏━ Message ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ 2文のホラーストーリーを作って。 ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

┏━ Response (0.7s) ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ 毎晩、ベッドの下から「おやすみ」と囁く声が聞こえる。 ┃

┃ 今日、家に帰ると「おかえり」と天井から聞こえ ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

[

│ {'role': 'system', 'content': 'あなたは、いつも丁寧で、明るく前向きな対応をする、親切なアシスタントです。'},

│ {'role': 'user', 'content': '2文のホラーストーリーを作って。'},

│ {

│ │ 'role': 'assistant',

│ │ 'content': '毎晩、ベッドの下から「おやすみ」と囁く声が聞こえる。 \n今日、家に帰ると「おかえり」と天井から聞こえた。'

│ }

]

▰▰▰▱▱▱▱ Thinking...

┏━ Message ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ 私の最初のメッセージは何だっけ? ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

┏━ Response (0.7s) ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ あなたの最初のメッセージは、「2文のホラーストーリーを作って。」です。 ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

[

│ {'role': 'system', 'content': 'あなたは、いつも丁寧で、明るく前向きな対応をする、親切なアシスタントです。'},

│ {'role': 'user', 'content': '2文のホラーストーリーを作って。'},

│ {

│ │ 'role': 'assistant',

│ │ 'content': '毎晩、ベッドの下から「おやすみ」と囁く声が聞こえる。 \n今日、家に帰ると「おかえり」と天井から聞こえた。'

│ },

│ {'role': 'user', 'content': '私の最初のメッセージは何だっけ?'},

│ {'role': 'assistant', 'content': 'あなたの最初のメッセージは、「2文のホラーストーリーを作って。」です。'}

]

なお、デフォルトメモリはそのままだと永続化されず、実行が終わる or リクエストが終了すると、失われる。永続化する場合はstorageドライバを追加する。

セッションストレージ

上に書いた通り、デフォルトの内蔵メモリは永続化されない。storageドライバを追加することで、永続化されたセッションストレージとなる。

from agno.agent import Agent

from agno.models.openai import OpenAIChat

from agno.storage.sqlite import SqliteStorage

from rich.pretty import pprint

agent = Agent(

model=OpenAIChat(id="gpt-4o-mini"),

# 実行サイクルを跨いで同じセッションを継続したい場合はここでセッションIDを指定

session_id="fixed_id_for_sesssion_storage_demo",

storage=SqliteStorage(

table_name="agent_sessions",

db_file="tmp/data.db"

),

add_history_to_messages=True,

num_history_runs=5,

)

agent.print_response(

"私が最後に聞いた質問は何だっけ?",

stream=True

)

agent.print_response(

"フランスの首都は?",

stream=True

)

agent.print_response(

"私が最後に聞いた質問は何だっけ?",

stream=True

)

pprint([

m.model_dump(include={"role", "content"})

for m in agent.get_messages_for_session()

])

▰▰▰▰▰▰▱ Thinking...

┏━ Message ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ 私が最後に聞いた質問は何だっけ? ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

┏━ Response (1.1s) ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ 申し訳ありませんが、私には過去の会話の履歴を記憶する機能がありません。最後に聞いた質問を教えていただければ、そ ┃

┃ の質問に基づいてお答えすることができます。何かあなたの関心のあることについてお話ししましょうか? ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

▰▰▰▰▱▱▱ Thinking...

┏━ Message ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ フランスの首都は? ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

┏━ Response (0.8s) ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ フランスの首都はパリです。パリは文化、芸術、歴史の中心地として知られ、多くの有名な観光地や美術館があります。何 ┃

┃ か特定のことについて知りたいですか? ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

▰▰▰▰▰▰▱ Thinking...

┏━ Message ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ 私が最後に聞いた質問は何だっけ? ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

┏━ Response (1.0s) ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ 最後に聞いた質問は「フランスの首都は?」でした。それについてお答えしましたが、他に何か知りたいことがあれば教え ┃

┃ てください! ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

[

│ {'role': 'user', 'content': '私が最後に聞いた質問は何だっけ?'},

│ {

│ │ 'role': 'assistant',

│ │ 'content': '申し訳ありませんが、私には過去の会話の履歴を記憶する機能がありません。最後に聞いた質問を教えていただければ、その質問に基づいてお答えすることができます。何かあなたの関心のあることについてお話ししましょうか?'

│ },

│ {'role': 'user', 'content': 'フランスの首都は?'},

│ {

│ │ 'role': 'assistant',

│ │ 'content': 'フランスの首都はパリです。パリは文化、芸術、歴史の中心地として知られ、多くの有名な観光地や美術館があります。何か特定のことについて知りたいですか?'

│ },

│ {'role': 'user', 'content': '私が最後に聞いた質問は何だっけ?'},

│ {

│ │ 'role': 'assistant',

│ │ 'content': '最後に聞いた質問は「フランスの首都は?」でした。それについてお答えしましたが、他に何か知りたいことがあれば教えてください!'

│ }

]

再度実行するとこうなる。

▰▰▰▰▰▰▱ Thinking...

┏━ Message ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ 私が最後に聞いた質問は何だっけ? ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

┏━ Response (1.2s) ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ あなたが最後に聞いた質問は「私が最後に聞いた質問は何だっけ?」でした。この会話の履歴を保持することはできないた ┃

┃ め、記憶には限界がありますが、また何か質問があればお知らせください。 ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

▰▰▰▱▱▱▱ Thinking...

┏━ Message ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ フランスの首都は? ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

┏━ Response (0.7s) ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ フランスの首都はパリです。何か他に知りたいことがありますか? ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

▰▰▰▰▰▰▱ Thinking...

┏━ Message ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ 私が最後に聞いた質問は何だっけ? ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

┏━ Response (1.1s) ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ あなたが最後に聞いた質問は「フランスの首都は?」でした。それに対して「フランスの首都はパリです」とお答えしまし ┃

┃ た。もし他に質問があれば、お知らせください! ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

[

│ {'role': 'user', 'content': '私が最後に聞いた質問は何だっけ?'},

│ {

│ │ 'role': 'assistant',

│ │ 'content': '申し訳ありませんが、私には過去の会話の履歴を記憶する機能がありません。最後に聞いた質問を教えていただければ、その質問に基づいてお答えすることができます。何かあなたの関心のあることについてお話ししましょうか?'

│ },

│ {'role': 'user', 'content': 'フランスの首都は?'},

│ {

│ │ 'role': 'assistant',

│ │ 'content': 'フランスの首都はパリです。パリは文化、芸術、歴史の中心地として知られ、多くの有名な観光地や美術館があります。何か特定のことについて知りたいですか?'

│ },

│ {'role': 'user', 'content': '私が最後に聞いた質問は何だっけ?'},

│ {

│ │ 'role': 'assistant',

│ │ 'content': '最後に聞いた質問は「フランスの首都は?」でした。それについてお答えしましたが、他に何か知りたいことがあれば教えてください!'

│ },

│ {'role': 'user', 'content': '私が最後に聞いた質問は何だっけ?'},

│ {

│ │ 'role': 'assistant',

│ │ 'content': 'あなたが最後に聞いた質問は「私が最後に聞いた質問は何だっけ?」でした。この会話の履歴を保持することはできないため、記憶には限界がありますが、また何か質問があればお知らせください。'

│ },

│ {'role': 'user', 'content': 'フランスの首都は?'},

│ {'role': 'assistant', 'content': 'フランスの首都はパリです。何か他に知りたいことがありますか?'},

│ {'role': 'user', 'content': '私が最後に聞いた質問は何だっけ?'},

│ {

│ │ 'role': 'assistant',

│ │ 'content': 'あなたが最後に聞いた質問は「フランスの首都は?」でした。それに対して「フランスの首都はパリです」とお答えしました。もし他に質問があれば、お知らせください!'

│ }

]

セッションストレージについてはこちらも参照。

ユーザメモリ

会話履歴や状態はセッションストレージが保持するのに対して、「ユーザメモリ」はユーザの会話履歴を元にしたパーソナライズなユーザ情報を作成する。

ユーザメモリを有効にするには、エージェントにMemoryオブジェクトを与えて、enable_agentic_memory=True をセットする。

SQLite3のデータベースがあれば一応削除

import os

try:

os.remove("tmp/memory.db")

except FileNotFoundError:

pass

メモリを使った一連のやり取り。

from agno.agent import Agent

from agno.memory.v2.db.sqlite import SqliteMemoryDb

from agno.memory.v2.memory import Memory

from agno.models.openai import OpenAIChat

# メモリをSQLiteデータベースに作成

memory_db = SqliteMemoryDb(

table_name="memory",

db_file="tmp/memory.db"

)

memory = Memory(db=memory_db)

user_id = "yamada_taro@example.com"

# エージェントを定義してメモリを与える

agent = Agent(

model=OpenAIChat(id="gpt-4o-mini"),

memory=memory,

enable_agentic_memory=True,

)

# ユーザメモリに新しいメモリを追加

agent.print_response(

"私の名前は山田太郎です。私は競馬が好きです。",

stream=True,

user_id=user_id,

)

agent.print_response(

"私の趣味はなんですか?",

stream=True,

user_id=user_id

)

# ユーザメモリからすべてのメモリを削除

agent.print_response(

"私のメモリを全て削除して。完全にデータベースをクリアして。",

stream=True,

user_id=user_id

)

# 新しいメモリを追加

agent.print_response(

"私の名前は山田太郎です。趣味は乗馬です。",

stream=True,

user_id=user_id

)

# ユーザメモリから特定のメモリだけを削除

agent.print_response(

"私の名前に関するメモリだけ削除して。",

stream=True,

user_id=user_id

)

agent.print_response(

"私について知っていることを教えて。",

stream=True,

user_id=user_id

)

▰▰▰▱▱▱▱ Thinking...

┏━ Message ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ 私の名前は山田太郎です。私は競馬が好きです。 ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

┏━ Tool Calls ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ • update_user_memory(task=User's name is 山田太郎.) ┃

┃ • update_user_memory(task=User likes horse racing.) ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

┏━ Response (5.4s) ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ あなたの名前は山田太郎さんで、競馬が好きなのですね。よろしくお願いします! ┃

┃ 何かお手伝いできることがあれば教えてください。 ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

▰▰▰▱▱▱▱ Thinking...

┏━ Message ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ 私の趣味はなんですか? ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

┏━ Response (0.6s) ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ あなたの趣味は競馬です。 ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

▰▰▱▱▱▱▱ Thinking...

┏━ Message ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ 私のメモリを全て削除して。完全にデータベースをクリアして。 ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

┏━ Tool Calls ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ • update_user_memory(task=Clear all user memories.) ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

┏━ Response (5.1s) ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┓

┃ ┃

┃ すべてのメモリが成功裏に削除されました。他に更新や共有したいことがあれば、遠慮なくお知らせください! ┃

┃ ┃

┗━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━┛

▰▰▰▰▰▰▱ Thinking...