llama.cppでGGUF変換やってみた

とりあえず自分でもやってみる。

自分用ビルドスニペット

git clone https://github.com/ggml-org/llama.cpp llma.cpp.$(date '+%Y%m%d_%H%M%S') && cd $_

cmake -B build -DGGML_CUDA=ON

cmake --build build --config Release -j 24

とりあえずディレクトリ作成

$ mkdir llama_cpp_convert && cd llama_cpp_convert

pyenvがすでに設定済み。venvとdirenvは簡単に設定できるようにしてある。手順はここ。

仮想環境作ってactivateする。

$ mkvenv

(llama_cpp_convert) $

llama.cppをクローン。venvのディレクトリはレポジトリの外にしたかったので、こういう順序にしている。

$ git clone https://github.com/ggerganov/llama.cpp && cd llama.cpp

GPUオフロード有効で、makeする。CUDAの設定もすでに実施済みとする。

$ make LLAMA_CUDA=1

変換に必要なpythonパッケージをインストール

$ pip install -r requirements.txt

ではGGUFに変換していく。変換対象のモデルは以下を使う。

自分の場合はモデルは/data/hf_models以下に全部保存することにしているので、そこにダウンロード。

$ cd /data/hf_models

$ git lfs install

$ git clone https://huggingface.co/selfrag/selfrag_llama2_13b

ダウンロードが完了したらllama.cppのディレクトリに戻ってまずGGUFに変換。モデルと同じ場所にGGUFファイルが作成される。

$ python convert.py /data/hf_models/selfrag_llama2_13b

(snip)

Wrote /data/hf_models/selfrag_llama2_13b/ggml-model-f32.gguf

$ ls -lt /data/hf_models/selfrag_llama2_13b/ggml-model-f32.gguf

-rw-rw-r-- 1 kun432 kun432 52064858592 3月 27 20:44 /data/hf_models/selfrag_llama2_13b/ggml-model-f32.gguf

GGUFファイルを量子化する。Q4_K_Mで。

$ ./quantize /data/hf_models/selfrag_llama2_13b/ggml-model-f32.gguf ./models/selfrag_llama2_13b.Q4_K_M.gguf Q4_K_M

(snip)

llama_model_quantize_internal: model size = 49652.21 MB

llama_model_quantize_internal: quant size = 7500.96 MB

main: quantize time = 160393.14 ms

main: total time = 160393.14 ms

作成された。

$ ls -lt ./models/selfrag_llama2_13b.Q4_K_M.gguf

-rw-rw-r-- 1 kun432 kun432 7866070144 3月 27 20:50 models/selfrag_llama2_13b.Q4_K_M.gguf

試してみる。

$ ./main \

-m ./models/selfrag_llama2_13b.Q4_K_M.gguf \

--temp 0.0 \

--top-p 1.0 \

-n 100 \

-p "### Instruction:\nCan you tell me the difference between llamas and alpacas?\n### Response:\n" \

-ngl 99 \

-e

### Instruction:

Can you tell me the difference between llamas and alpacas?

### Response:

Sure![Retrieval]<paragraph>Here are some of the key differences between llamas and alpacas:

1.[Retrieval]<paragraph>Size:2.3.4.5.[Utility:5] [end of text]

いけてるっぽい。

記事の通りでできた。ありがたい。

iMatrix量子化

コマンドラインとか色々変わっているので改めて。

llama.cppのビルド。

$ git clone https://github.com/ggerganov/llama.cpp && cd llama.cpp

$ make GGML_CUDA=1 # GPUオフロード有効化

GGUF変換に必要なpythonパッケージをインストール。venv等で仮想環境は事前にあるものとする。

$ pip install -r requirements.txt

Bakuさん作のiMatrix用のデータセットをダウンロードしておく。

$ wget --content-disposition https://huggingface.co/datasets/TFMC/imatrix-dataset-for-japanese-llm/resolve/main/c4_en_ja_imatrix.txt?download=true

ではGGUFに変換していく。サンプルとしてmeta-llama/Meta-Llama-3.1-8B-Instructを使う。モデルはすでに/data/Meta-Llama-3.1-8B-Instructとしてクローンしてあるものとする。

$ python convert_hf_to_gguf.py /data/Meta-Llama-3.1-8B-Instruct --outtype bf16

以下のようにGGUFが作成された

$ ls -lt /data/Meta-Llama-3.1-8B-Instruct/Meta-Llama-3.1-8B-Instruct-BF16.gguf

-rw-rw-r-- 1 kun432 kun432 16068891296 7月 28 11:06 /data/Meta-Llama-3.1-8B-Instruct/Meta-Llama-3.1-8B-Instruct-BF16.gguf

GGUFとiMatrix用データセットから、iMatrixを作成する。

$ ./llama-imatrix \

-m /data/Meta-Llama-3.1-8B-Instruct/Meta-Llama-3.1-8B-Instruct-BF16.gguf \

-f c4_en_ja_imatrix.txt \

-o /data/Meta-Llama-3.1-8B-Instruct/imatrix.dat \

--chunk 32

こんな感じで時間の目安が表示される。

compute_imatrix: 41.97 seconds per pass - ETA 1 hours 53.32 minutes

ちなみに、

- Meta-Llama-3.1-70B-Instructだと60時間とか出た・・・

-

-ngl XでGPUオフロードできるんだけど、自分の環境で試してみた限りは時間短縮されるよりもむしろ時間が大幅に増えた(軽く実行してみて表示される目安を確認しただけで、実際にiMatrixの作成完了までは試していない)

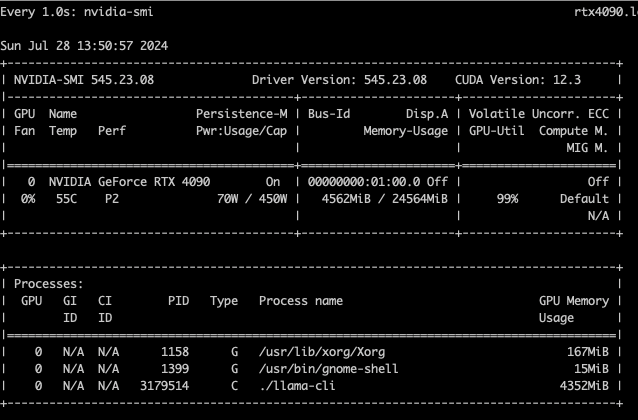

という感じなので、少なくともこの処理はとても重たいものだと思われる。ただリソース見てる限りCPUもメモリもフルで使っているようには見えなかったので、もっと詰めれるのかもしれない。オプションをもっと調べてみたい。

以下のようにiMatrixが作成された

$ ls -lt /data/Meta-Llama-3.1-8B-Instruct/imatrix.dat

-rw-rw-r-- 1 kun432 kun432 4988154 7月 28 13:07 /data/Meta-Llama-3.1-8B-Instruct/imatrix.dat

ではGGUFとiMatrixから、iMatrix量子化GGUFを作成。

$ ./llama-quantize \

--imatrix /data/Meta-Llama-3.1-8B-Instruct/imatrix.dat \

/data/Meta-Llama-3.1-8B-Instruct/Meta-Llama-3.1-8B-Instruct-BF16.gguf \

/data/Meta-Llama-3.1-8B-Instruct/Meta-Llama-3.1-8B-Instruct.IQ4_XS.gguf \

IQ4_XS

作成された

$ ls -lt /data/Meta-Llama-3.1-8B-Instruct/Meta-Llama-3.1-8B-Instruct.IQ4_XS.gguf

-rw-rw-r-- 1 kun432 kun432 4447663008 7月 28 13:39 /data/Meta-Llama-3.1-8B-Instruct/Meta-Llama-3.1-8B-Instruct.IQ4_XS.gguf

推論。なお、コンテキストサイズの大きなモデルは絞らないとメモリをフルに確保しようとしてOOMになる場合があるので、その場合は-cを付与するとよい。

$ ./llama-cli \

-m /data/Meta-Llama-3.1-8B-Instruct/Meta-Llama-3.1-8B-Instruct.IQ4_XS.gguf \

--temp 0.0 \

--top-p 1.0 \

-n 100 \

-c 4096 \

-p "### Instruction:\nCan you tell me the difference between llamas and alpacas?\n### Response:\n" \

-ngl 99 \

-e

Llamas and alpacas are both members of the camelid family, but they belong to different species. Llamas are larger and more robust than alpacas, with a distinctive banana-shaped ear and a long neck. Alpacas, on the other hand, have smaller ears and a more compact body. Llamas are often used as pack animals, while alpacas are primarily raised for their soft, valuable fleece. Despite their differences, both llamas and alpacas

llama_print_timings: load time = 2952.77 ms

llama_print_timings: sample time = 10.96 ms / 100 runs ( 0.11 ms per token, 9124.92 tokens per second)

llama_print_timings: prompt eval time = 17.99 ms / 21 tokens ( 0.86 ms per token, 1167.25 tokens per second)

llama_print_timings: eval time = 697.28 ms / 99 runs ( 7.04 ms per token, 141.98 tokens per second)

llama_print_timings: total time = 741.83 ms / 120 tokens

Log end

iMatrix量子化モデルの変換・公開をしている方には頭が下がる思い。ほんとにありがたい。

参考

たまたま見てたんだけども

./llama-cli \ --hf-repo google/gemma-2-2b-it-GGUF \ --hf-file 2b_it_v2.gguf \ -p "Write a poem about cats as a labrador" -cnv

HuggingFaceでGGUFあれば直接ダウンロードして推論できるってってこと?試してみたらこうなった。

llama_init_from_gpt_params: error: failed to load model '/home/kun432/.cache/llama.cpp/2b_it_v2.gguf'

main: error: unable to load model

llama_load_model_from_hf: llama.cpp built without libcurl, downloading from Hugging Face not supported.

Homebrewだとこの辺も全部有効にしてあるってことなんだろう。

libcurlのdevパッケージはそういや入っていなかった。

$ apt list --installed | egrep -i "libcurl*dev"

WARNING: apt does not have a stable CLI interface. Use with caution in scripts.

$

ということでインストール。Ubuntu 22.04の場合は、libcurl4-openssl-dev。

$ apt install libcurl4-openssl-dev

llama.cppをクローンしたディレクトリに移動、LLAMA_CURL=1(Makefileだとどうも古い命名規則がまだ残ってる様子)をつけてllama.cppをビルドし直す。ついでにpullも。

$ make clean

$ git pull

$ make GGML_CUDA=1 LLAMA_CURL=1

$ ldd ./llama-cli

では実行してみる。なお、google/gemma-2-2b-it-GGUFは利用に関して同意が必要≒HuggingFaceで事前に同意の上、HuggingFaceのトークンが必要になる。以下のように--hf-tokenオプションで指定するか、環境変数HF_TOKENを指定する必要がある。

$ ./llama-cli \

--hf-repo google/gemma-2-2b-it-GGUF \

--hf-file 2b_it_v2.gguf \

--hf-token hf_XXXXXXXXXXXXXXX \

-p "Write a poem about cats as a labrador" -cnv

以下のようにダウンロードされる。~/.cache/llama.cpp以下に保存される様子。

Log start

main: build = 3499 (c8a00909)

main: built with cc (Ubuntu 11.4.0-1ubuntu1~22.04) 11.4.0 for x86_64-linux-gnu

main: seed = 1722518975

llama_download_file: no previous model file found /home/kun432/.cache/llama.cpp/2b_it_v2.gguf

llama_download_file: downloading from https://huggingface.co/google/gemma-2-2b-it-GGUF/resolve/main/2b_it_v2.gguf to /home/kun432/.cache/llama.cpp/2b_it_v2.gguf (server_etag:"3722641d1ed4ba5956923546c4218edb-654", server_last_modified:Wed, 17 Jul 2024 22:26:06 GMT)...

% Total % Received % Xferd Average Speed Time Time Time Current

Dload Upload Total Spent Left Speed

100 1123 100 1123 0 0 6237 0 --:--:-- --:--:-- --:--:-- 6237

2 9978M 2 282M 0 0 7007k 0 0:24:18 0:00:41 0:23:37 2968k

llama_download_file: file metadata saved: /home/kun432/.cache/llama.cpp/2b_it_v2.gguf.json

llama_model_loader: loaded meta data with 30 key-value pairs and 288 tensors from /home/kun432/.cache/llama.cpp/2b_it_v2.gguf (version GGUF V3 (latest))

llama_model_loader: Dumping metadata keys/values. Note: KV overrides do not apply in this output.

llama_model_loader: - kv 0: general.architecture str = gemma2

llama_model_loader: - kv 1: general.type str = model

llama_model_loader: - kv 2: general.name str = 32efd91717fa898a94be73c8bfe55dd15373f25e

llama_model_loader: - kv 3: gemma2.context_length u32 = 8192

llama_model_loader: - kv 4: gemma2.embedding_length u32 = 2304

llama_model_loader: - kv 5: gemma2.block_count u32 = 26

llama_model_loader: - kv 6: gemma2.feed_forward_length u32 = 9216

llama_model_loader: - kv 7: gemma2.attention.head_count u32 = 8

llama_model_loader: - kv 8: gemma2.attention.head_count_kv u32 = 4

llama_model_loader: - kv 9: gemma2.attention.layer_norm_rms_epsilon f32 = 0.000001

llama_model_loader: - kv 10: gemma2.attention.key_length u32 = 256

llama_model_loader: - kv 11: gemma2.attention.value_length u32 = 256

llama_model_loader: - kv 12: general.file_type u32 = 0

llama_model_loader: - kv 13: gemma2.attn_logit_softcapping f32 = 50.000000

llama_model_loader: - kv 14: gemma2.final_logit_softcapping f32 = 30.000000

llama_model_loader: - kv 15: gemma2.attention.sliding_window u32 = 4096

llama_model_loader: - kv 16: tokenizer.ggml.model str = llama

llama_model_loader: - kv 17: tokenizer.ggml.pre str = default

llama_model_loader: - kv 18: tokenizer.ggml.tokens arr[str,256000] = ["<pad>", "<eos>", "<bos>", "<unk>", ...

llama_model_loader: - kv 19: tokenizer.ggml.scores arr[f32,256000] = [-1000.000000, -1000.000000, -1000.00...

llama_model_loader: - kv 20: tokenizer.ggml.token_type arr[i32,256000] = [3, 3, 3, 3, 3, 3, 3, 3, 3, 3, 3, 3, ...

llama_model_loader: - kv 21: tokenizer.ggml.bos_token_id u32 = 2

llama_model_loader: - kv 22: tokenizer.ggml.eos_token_id u32 = 1

llama_model_loader: - kv 23: tokenizer.ggml.unknown_token_id u32 = 3

llama_model_loader: - kv 24: tokenizer.ggml.padding_token_id u32 = 0

llama_model_loader: - kv 25: tokenizer.ggml.add_bos_token bool = true

llama_model_loader: - kv 26: tokenizer.ggml.add_eos_token bool = false

llama_model_loader: - kv 27: tokenizer.chat_template str = {{ bos_token }}{% if messages[0]['rol...

llama_model_loader: - kv 28: tokenizer.ggml.add_space_prefix bool = false

llama_model_loader: - kv 29: general.quantization_version u32 = 2

llama_model_loader: - type f32: 288 tensors

llm_load_vocab: special tokens cache size = 249

llm_load_vocab: token to piece cache size = 1.6014 MB

llm_load_print_meta: format = GGUF V3 (latest)

llm_load_print_meta: arch = gemma2

llm_load_print_meta: vocab type = SPM

llm_load_print_meta: n_vocab = 256000

llm_load_print_meta: n_merges = 0

llm_load_print_meta: vocab_only = 0

llm_load_print_meta: n_ctx_train = 8192

llm_load_print_meta: n_embd = 2304

llm_load_print_meta: n_layer = 26

llm_load_print_meta: n_head = 8

llm_load_print_meta: n_head_kv = 4

llm_load_print_meta: n_rot = 256

llm_load_print_meta: n_swa = 4096

llm_load_print_meta: n_embd_head_k = 256

llm_load_print_meta: n_embd_head_v = 256

llm_load_print_meta: n_gqa = 2

llm_load_print_meta: n_embd_k_gqa = 1024

llm_load_print_meta: n_embd_v_gqa = 1024

llm_load_print_meta: f_norm_eps = 0.0e+00

llm_load_print_meta: f_norm_rms_eps = 1.0e-06

llm_load_print_meta: f_clamp_kqv = 0.0e+00

llm_load_print_meta: f_max_alibi_bias = 0.0e+00

llm_load_print_meta: f_logit_scale = 0.0e+00

llm_load_print_meta: n_ff = 9216

llm_load_print_meta: n_expert = 0

llm_load_print_meta: n_expert_used = 0

llm_load_print_meta: causal attn = 1

llm_load_print_meta: pooling type = 0

llm_load_print_meta: rope type = 2

llm_load_print_meta: rope scaling = linear

llm_load_print_meta: freq_base_train = 10000.0

llm_load_print_meta: freq_scale_train = 1

llm_load_print_meta: n_ctx_orig_yarn = 8192

llm_load_print_meta: rope_finetuned = unknown

llm_load_print_meta: ssm_d_conv = 0

llm_load_print_meta: ssm_d_inner = 0

llm_load_print_meta: ssm_d_state = 0

llm_load_print_meta: ssm_dt_rank = 0

llm_load_print_meta: model type = 2B

llm_load_print_meta: model ftype = all F32

llm_load_print_meta: model params = 2.61 B

llm_load_print_meta: model size = 9.74 GiB (32.00 BPW)

llm_load_print_meta: general.name = 32efd91717fa898a94be73c8bfe55dd15373f25e

llm_load_print_meta: BOS token = 2 '<bos>'

llm_load_print_meta: EOS token = 1 '<eos>'

llm_load_print_meta: UNK token = 3 '<unk>'

llm_load_print_meta: PAD token = 0 '<pad>'

llm_load_print_meta: LF token = 227 '<0x0A>'

llm_load_print_meta: EOT token = 107 '<end_of_turn>'

llm_load_print_meta: max token length = 48

ggml_cuda_init: GGML_CUDA_FORCE_MMQ: no

ggml_cuda_init: GGML_CUDA_FORCE_CUBLAS: no

ggml_cuda_init: found 1 CUDA devices:

Device 0: NVIDIA GeForce RTX 4090, compute capability 8.9, VMM: yes

llm_load_tensors: ggml ctx size = 0.13 MiB

llm_load_tensors: offloading 0 repeating layers to GPU

llm_load_tensors: offloaded 0/27 layers to GPU

llm_load_tensors: CPU buffer size = 9972.92 MiB

..................................................................

llama_new_context_with_model: n_ctx = 8192

llama_new_context_with_model: n_batch = 2048

llama_new_context_with_model: n_ubatch = 512

llama_new_context_with_model: flash_attn = 0

llama_new_context_with_model: freq_base = 10000.0

llama_new_context_with_model: freq_scale = 1

llama_kv_cache_init: CUDA_Host KV buffer size = 832.00 MiB

llama_new_context_with_model: KV self size = 832.00 MiB, K (f16): 416.00 MiB, V (f16): 416.00 MiB

llama_new_context_with_model: CUDA_Host output buffer size = 0.98 MiB

llama_new_context_with_model: CUDA0 compute buffer size = 2754.50 MiB

llama_new_context_with_model: CUDA_Host compute buffer size = 36.51 MiB

llama_new_context_with_model: graph nodes = 1050

llama_new_context_with_model: graph splits = 342

main: chat template example: <start_of_turn>user

You are a helpful assistant

Hello<end_of_turn>

<start_of_turn>model

Hi there<end_of_turn>

<start_of_turn>user

How are you?<end_of_turn>

<start_of_turn>model

system_info: n_threads = 8 / 32 | AVX = 1 | AVX_VNNI = 1 | AVX2 = 1 | AVX512 = 0 | AVX512_VBMI = 0 | AVX512_VNNI = 0 | AVX512_BF16 = 0 | FMA = 1 | NEON = 0 | SVE = 0 | ARM_FMA = 0 | F16C = 1 | FP16_VA = 0 | WASM_SIMD = 0 | BLAS = 1 | SSE3 = 1 | SSSE3 = 1 | VSX = 0 | MATMUL_INT8 = 0 | LLAMAFILE = 1 |

main: interactive mode on.

sampling:

repeat_last_n = 64, repeat_penalty = 1.000, frequency_penalty = 0.000, presence_penalty = 0.000

top_k = 40, tfs_z = 1.000, top_p = 0.950, min_p = 0.050, typical_p = 1.000, temp = 0.800

mirostat = 0, mirostat_lr = 0.100, mirostat_ent = 5.000

sampling order:

CFG -> Penalties -> top_k -> tfs_z -> typical_p -> top_p -> min_p -> temperature

generate: n_ctx = 8192, n_batch = 2048, n_predict = -1, n_keep = 1

== Running in interactive mode. ==

- Press Ctrl+C to interject at any time.

- Press Return to return control to the AI.

- To return control without starting a new line, end your input with '/'.

- If you want to submit another line, end your input with '\'.

> 日本語喋れる?

はい、日本語話せます! 🐶🐱

(Yes, I can speak Japanese!)

How can I help you today? 😊

<end_of_turn>

>

なるほど、シンプルにお試しするだけならこれでもいいかもね。ところで-cnvとか初めて知ったわ・・・

この辺、改めて見てみるかな

久々に見てみたらまた色々変わってて、CMakeが標準になってた。

レポジトリクローン。個人的には、以前特定のバージョンで使える・使えない、みたいなことがあってから、タグでクローンするようにしてる。

git clone https://github.com/ggerganov/llama.cpp -b b4519 llama.cpp.b4519 && cd llama.cpp.b4519

CUDAを有効にしてビルドする。めちゃめちゃ時間かかる。

cmake -B build -DGGML_CUDA=ON

cmake --build build --config Release

ビルドされたバイナリはbuild/bin配下にある。

ls build/bin/

llama-batched llama-infill llama-run test-gguf

llama-batched-bench llama-llava-cli llama-save-load-state test-grammar-integration

llama-bench llama-lookahead llama-server test-grammar-parser

llama-cli llama-lookup llama-simple test-json-schema-to-grammar

llama-convert-llama2c-to-ggml llama-lookup-create llama-simple-chat test-llama-grammar

llama-cvector-generator llama-lookup-merge llama-speculative test-log

llama-embedding llama-lookup-stats llama-speculative-simple test-model-load-cancel

llama-eval-callback llama-minicpmv-cli llama-tokenize test-quantize-fns

llama-export-lora llama-parallel llama-tts test-quantize-perf

llama-gbnf-validator llama-passkey llama-vdot test-rope

llama-gen-docs llama-perplexity test-arg-parser test-sampling

llama-gguf llama-q8dot test-autorelease test-tokenizer-0

llama-gguf-hash llama-quantize test-backend-ops test-tokenizer-1-bpe

llama-gguf-split llama-quantize-stats test-barrier test-tokenizer-1-spm

llama-gritlm llama-qwen2vl-cli test-c

llama-imatrix llama-retrieval test-chat-template

Pythonパッケージのインストール。仮想環境は適宜用意しておくこと。

pip install -r requirements.txt

Bakuさん作のiMatrix用のデータセットをダウンロードしておく。

wget --content-disposition https://huggingface.co/datasets/TFMC/imatrix-dataset-for-japanese-llm/resolve/main/c4_en_ja_imatrix.txt?download=true

モデルをダウンロードしてGGUFに変換する。モデルは/data以下にクローンされているとする。例として以下のモデルを使う。

python convert_hf_to_gguf.py /data/DeepSeek-R1-Distill-Qwen-7B --outtype bf16

GGUFとiMatrix用データセットから、iMatrixを作成する。

./build/bin/llama-imatrix \

-m /data/DeepSeek-R1-Distill-Qwen-7B/DeepSeek-R1-Distill-Qwen-7B-BF16.gguf \

-f c4_en_ja_imatrix.txt \

-o /data/DeepSeek-R1-Distill-Qwen-7B/imatrix.dat \

--chunk 32

GGUFとiMatrixから、iMatrix量子化GGUFを作成。

./build/bin/llama-quantize \

--imatrix /data/DeepSeek-R1-Distill-Qwen-7B/imatrix.dat \

/data/DeepSeek-R1-Distill-Qwen-7B/DeepSeek-R1-Distill-Qwen-7B-BF16.gguf \

/data/DeepSeek-R1-Distill-Qwen-7B/DeepSeek-R1-Distill-Qwen-7B.IQ4_XS.gguf \

IQ4_XS

作成されたiMatrix量子化GGUFで推論。

./build/bin/llama-cli \

--model /data/DeepSeek-R1-Distill-Qwen-7B/DeepSeek-R1-Distill-Qwen-7B.IQ4_XS.gguf \

--cache-type-k q8_0 \

--threads 16 \

--prompt '<|User|>「引く」と書いてあるドアを反対側から押すとどうなりますか?<|Assistant|>' \

-no-cnv