論文 「NUDGE: Lightweight Non-Parametric Fine-Tuning of Embeddings for Retrieval」

ここで知った。クローズドソースにも適用可能ってのが気になった。

論文

Claude-3.5-Sonnetによる要約

どんなもの?

この論文は、k近傍(k-NN)検索による情報検索の精度を向上させる新しい手法「NUDGE」を提案しています。NUDGEは、事前学習済みの埋め込みモデルの出力を直接修正することで、データセットと検索クエリに対する検索精度を向上させます。従来の手法(事前学習モデルの微調整やアダプターモデルの学習)と比較して、NUDGEはより効率的で高精度な結果を提供します。k-NN検索は、テキストや画像の検索、および検索拡張生成(RAG)パイプラインで広く使用されている手法です。NUDGEは、埋め込みを非パラメトリックに最適化することで、データレコードの埋め込みを直接変更し、k-NN検索の精度を最大化します。

先行研究と比べてどこがすごい?

NUDGEの主な利点は、精度、効率、使いやすさの3点です。従来の手法と比較して:

- 精度:NUDGEは、NDCG@10指標で最大16.0%の精度向上を達成し、微調整なしの場合と比較して最大24.4%の向上を示しました。

- 効率:NUDGEは数分で学習を完了し、従来の手法と比較して200倍以上高速です。

- 使いやすさ:NUDGEは、モデルのパラメータにアクセスする必要がなく、クローズドソースモデルでも使用できます。

- 汎用性:テキストと画像の両方の検索タスクで効果を発揮します。

さらに、NUDGEは分布外のクエリに対しても性能低下を避け、学習済みの意味を大きく歪めることなく埋め込みを調整します。これらの特徴により、NUDGEは既存の手法を大きく上回る性能を示しています。

技術や手法の肝はどこ?

NUDGEの核心は、以下の点にあります:

- 非パラメトリックアプローチ:埋め込みを直接最適化し、モデルパラメータは変更しません。

- 制約付き最適化:埋め込みの変更に制限を設けることで、過学習を防ぎ、事前学習で獲得した意味を保持します。

- 閉形式解:NUDGE-MとNUDGE-Nという2つの主要な手法を提案し、それぞれ制約付き最適化問題の閉形式解を提供します。

- 効率的な実装:提案手法は、単一の学習および検証イテレーションと同等の計算量で実行できます。

NUDGEは、訓練クエリとその正解データレコードの類似度を最大化しながら、埋め込みの変更量を制限します。この制約により、十分な精度向上を得つつ、事前学習で獲得した意味を保持することができます。

どうやって有効だと検証した?

論文では、以下の方法で手法の有効性を検証しています:

- データセット:BEIRとKILTからの7つの標準的なテキスト検索データセット、およびCOCOとFlickrの2つの画像検索データセットを使用。

- モデル:3つのテキスト埋め込みモデル(BGE-small、GTE-large、OpenAI's text-embedding-large-3)と2つの画像埋め込みモデル(CLIP ViT-B/32、ViT-L/14)で実験。

- 評価指標:Recall@k、NDCG@k(k=10)を使用。

- ベースライン:微調整なし、アダプターモデル、事前学習モデルの微調整(PTFT)と比較。

- 実行時間の比較:GPU(Nvidia A100)とCPU(32コアIntel Broadwell)での実行時間を測定。

結果として、NUDGEは全てのデータセットとモデルで一貫して高い性能を示し、特に大規模データセットでの効率性が顕著でした。また、分布外のクエリに対する性能も評価し、NUDGEの汎化能力を実証しています。

議論はある?

論文では、以下の点について議論しています:

- 計算効率性:NUDGEは、パラメトリックアプローチと比較して大幅に少ない計算リソースで高い精度を達成できることを示しています。

- 汎化性能:分布外のクエリに対する性能評価を通じて、NUDGEの汎化能力を議論しています。特にNUDGE-Nは、分布外のクエリに対しても性能低下を最小限に抑えることができます。

- 手法の制限:NUDGEは、事前学習済みモデルの出力を直接修正するため、モデル自体の改善には寄与しない点が議論されています。

- 応用可能性:テキストと画像の両方の検索タスクでの有効性が示されており、幅広い応用が期待できます。

- 将来の研究方向:ベクトルデータベース内でのNUDGEの実装や、微調整のためのクエリセットの生成と維持などが今後の研究課題として挙げられています。

これらの議論を通じて、NUDGEの強みと限界、そして今後の発展の可能性が示されています。

次に読むべき論文は?

この研究の理解を深め、関連分野の最新動向を把握するために、以下の論文を読むことをお勧めします:

- Wayne Xin Zhao et al. (2024) "Dense text retrieval based on pretrained language models: A survey." - 事前学習済み言語モデルを用いた密なテキスト検索に関する最新のサーベイ論文。

- Patrick Lewis et al. (2020) "Retrieval-augmented generation for knowledge-intensive nlp tasks." - 検索拡張生成(RAG)に関する先駆的な論文。

- Omar Khattab and Matei Zaharia (2020) "Colbert: Efficient and effective passage search via contextualized late interaction over bert." - 効率的な密検索手法の代表例。

- Yi Tay et al. (2022) "Transformer memory as a differentiable search index." - 生成的検索のアプローチを提案した論文。

- Long Ouyang et al. (2022) "Training language models to follow instructions with human feedback." - 言語モデルの指示微調整に関する重要な論文。

これらの論文は、情報検索、言語モデル、密検索、および関連する最適化技術について幅広い視点を提供し、NUDGEの背景と潜在的な将来の方向性をより深く理解するのに役立つでしょう。

もう少し具体的に知りたいです。一般的には、文字列を埋め込みモデルに渡してベクトルを取得しますよね。ここで、モデルそのものを最適化するのがファインチューニングですよね。NUDGEの場合は、文字列を埋め込みモデルに渡して得られたベクトルを最適化する、という理解であっていますか?

はい、その理解は正確です。NUDGEの特徴をより具体的に説明しましょう。

NUDGEの具体的なアプローチ

従来の埋め込み微調整プロセス:

- 入力:文字列(テキストや画像の説明)

- プロセス:事前学習済み埋め込みモデルを通す

- 出力:埋め込みベクトル

- 微調整:モデルのパラメータを調整

NUDGEのアプローチ:

- 入力:文字列(テキストや画像の説明)

- プロセス:事前学習済み埋め込みモデルを通す(変更なし)

- 出力:埋め込みベクトル

- 微調整:出力された埋め込みベクトルを直接調整

NUDGEの具体的な手順:

- データセットの全アイテムを埋め込みモデルで変換

- 訓練クエリとその正解データの埋め込みベクトルの類似度を最大化

- 埋め込みベクトルの変更量に制約を設定(過学習防止)

- 最適化問題を解いて、各データアイテムの埋め込みベクトルを更新

NUDGEの利点:

- モデル非依存:埋め込みモデルの内部にアクセス不要

- 効率的:モデルパラメータの更新が不要

- 柔軟性:異なるモデルや閉じたソースのAPIにも適用可能

主な手法:

- NUDGE-M:埋め込みの変更量に上限を設定

- NUDGE-N:埋め込みを常に正規化し、単位球面上に制約

NUDGEは、モデルそのものではなく、モデルの出力を最適化することで、効率的かつ効果的に検索性能を向上させます。これにより、モデルの再学習やホスティングのコストを削減しつつ、特定のデータセットやクエリに対する検索精度を大幅に改善することができます。

なるほど、であればクローズドソースでも可能というのは納得です。逆に、デメリットってないでしょうか?

NUDGEにも確かにいくつかの制限やデメリットがあります。それらについて詳しく説明いたします。

NUDGEのデメリットと制限

汎化性の制限:

- 特定のデータセットに最適化:NUDGEは与えられたデータセットとクエリセットに対して最適化を行うため、新しい、未見のデータやクエリに対する汎化性能が制限される可能性があります。

- 分布外データへの対応:論文では分布外のクエリに対する性能も評価していますが、データセットが大きく変わる場合には再度最適化が必要になる可能性があります。

モデル自体の改善がない:

- 埋め込みモデルの能力に依存:NUDGEは元の埋め込みモデルの出力を調整するだけなので、モデル自体の能力を超えた改善は難しいです。

- 新しい概念の学習が困難:事前学習済みモデルが捉えていない新しい概念や関係性を学習することはできません。

メモリ要件:

- データセットサイズに比例:各データアイテムの埋め込みベクトルを個別に調整するため、大規模なデータセットの場合、調整された埋め込みを保存するための追加のメモリが必要になります。

更新の複雑さ:

- データセットの変更時の再最適化:新しいデータが追加されたり、既存のデータが変更されたりした場合、埋め込みの再最適化が必要になる可能性があります。

- インクリメンタルな更新の難しさ:論文では一括での最適化を提案しており、新しいデータに対する増分的な更新方法は明確に示されていません。

解釈可能性の課題:

- 最適化プロセスの不透明性:埋め込みベクトルの直接的な調整は、その変更がどのような意味を持つのか解釈することが難しい場合があります。

- デバッグの難しさ:性能が期待通りでない場合、問題の原因を特定することが従来の手法よりも難しい可能性があります。

計算リソースの制約:

- 大規模データセットでの初期最適化コスト:データセット全体の埋め込みを一度に最適化するため、非常に大規模なデータセットでは初期の計算コストが高くなる可能性があります。

特定のタスクへの最適化:

- 汎用性の制限:NUDGEは主にk-NN検索タスクに最適化されており、他の下流タスクへの直接的な適用が限られる可能性があります。

これらの制限は、NUDGEを適用する際に考慮すべき重要な点です。特に、データセットの特性や更新頻度、必要な汎化性能などを考慮して、NUDGEが適切な選択肢かどうかを判断する必要があります。

そのデメリットは論文中に記載されているものですか?

論文の内容を再確認し、デメリットに関する記述を精査しました。以下に、論文中で明示的に言及されているデメリットと、論文の内容から推測されるデメリットを区別して説明します。

論文中のNUDGEのデメリットと制限

論文中で明示的に言及されているデメリット:

- モデル自体の改善がない:論文では、NUDGEが事前学習済みモデルの出力を直接修正するため、モデル自体の改善には寄与しない点が議論されています。

- 特定のタスクへの最適化:NUDGEはk-NN検索タスクに特化しており、他の下流タスクへの直接的な適用については言及されていません。

論文の内容から推測されるデメリット:

- データセットの変更時の再最適化:論文では、新しいデータが追加された場合の対応について具体的な言及がありません。これは潜在的な制限となる可能性があります。

- メモリ要件:各データアイテムの埋め込みを個別に調整するアプローチは、大規模データセットでは追加のメモリが必要になる可能性があります。

- 汎化性の制限:論文では分布外のクエリに対する性能評価を行っていますが、完全に新しいデータやコンセプトに対する汎化性能については詳細な議論がありません。

論文で対処されている潜在的なデメリット:

- 過学習の防止:NUDGEは埋め込みの変更量に制約を設けることで、過学習を防ぐ工夫がされています。

- 計算効率:論文では、NUDGEが従来の手法と比較して非常に効率的であることが強調されています。

- 分布外性能:NUDGE-Nが分布外のクエリに対しても性能低下を最小限に抑えることができると報告されています。

論文で言及されていない点:

- インクリメンタルな更新方法

- 非常に大規模なデータセットでの初期最適化コスト

- 埋め込み調整の解釈可能性

論文は主にNUDGEの利点と効果に焦点を当てており、潜在的なデメリットについての詳細な議論は限られています。しかし、手法の特性から推測される制限もあり、これらは将来の研究や実際の適用時に考慮すべき重要な点となる可能性があります。

出力されたベクトルの最適化を全体データセットでやるということは、更新があった場合にどうすべきか?というところは課題になるよね。ただそれについては触れられていないということか。

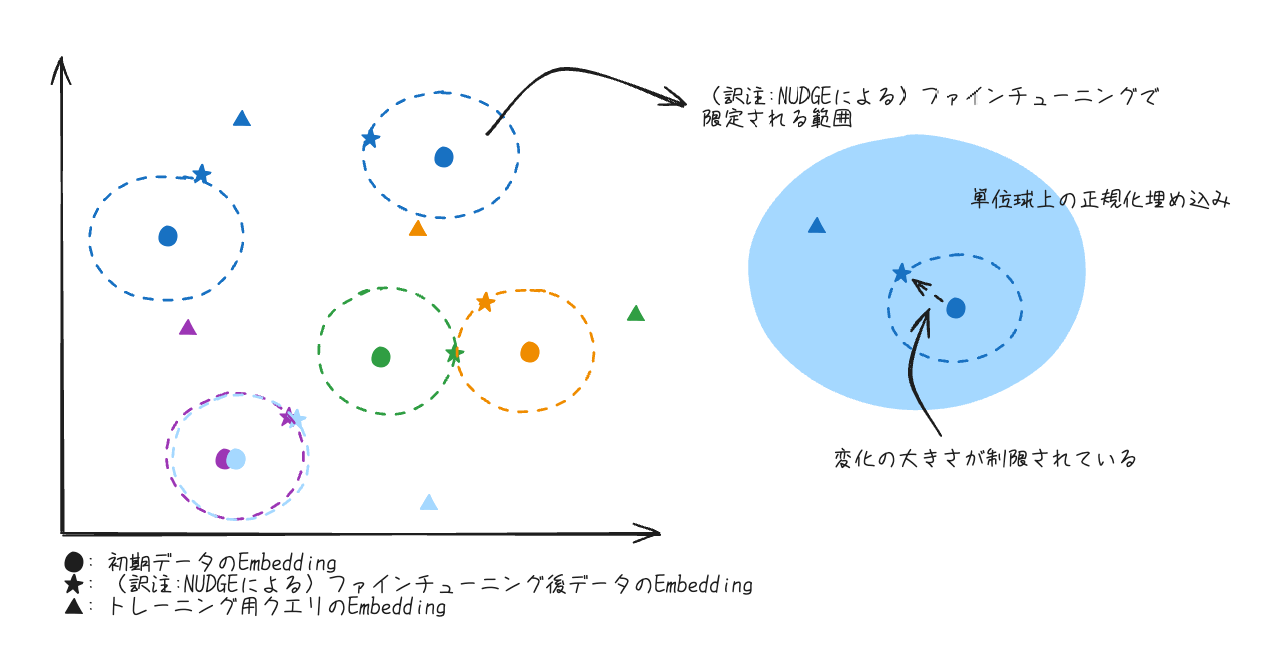

論文中の図を日本語にしてみた。おそらく、クエリとデータの類似度を近づけるようにデータのEmbeddingを一定範囲内に限定して変更するということだと思う。

図1: NUDGEは、制約された領域内の埋め込みを変更し、訓練クエリとの類似性を最大化する。クエリ。データ埋め込みは、そのデータの正解データであるクエリに基づいて色付けしている。

referred from https://arxiv.org/abs/2409.02343 and arranged/translated into Japanese by kun432

コードは公開されている

レポジトリ

あとLlamaIndexでNUDGEのnotebookが公開されている。