Learning vs Retrieval: The Role of In-Context Examples in Regression with LLMs

LLM におけるIn-Context Learning (ICL) は強力ではあるものの、十分に理解されていません。

この新しい論文では、回帰問題におけるIn-Context Learningを明示的に研究し、ICL がコンテキスト内例からの学習と内部知識の取得の両方を組み合わせて使用すると主張しています。

評価フレームワークを使用してこれを調査し、LLM、データセット、プロンプト構成間で ICL メカニズムを比較することができます。

LLM は、コンテキスト内での現実的なデータセットの回帰例から学習し、合成データに関する以前の作業をより実用的なシナリオに拡張できることが報告されています。

また、コンテキスト内学習メカニズムの理解を深める迅速なエンジニアリング手法を通じて、アプリケーションを最適化するための洞察も提供します。

Claude 3.5 Sonnetの要約

どんなもの?

この研究は、ChatGPTのような大規模な人工知能(AI)が、与えられた例から学ぶ能力「インコンテキスト学習」について調べたものです。研究者たちは、AIがこの学習をする時、単に新しい情報を覚えるだけでなく、すでに持っている知識も使っていると考えました。そこで、AIに数字を予測する課題を与え、どのようにして答えを出しているのかを詳しく調べました。この研究では、3種類の異なるAI(LLaMA 3 70B、GPT3.5、GPT4)を使って実験を行いました。

先行研究と比べてどこがすごい?

これまでの研究では、AIの学習を「新しい情報を覚える」か「既存の知識を使う」かのどちらかだと考えることが多かったです。しかし、この研究ではその両方を組み合わせていると主張しています。また、実際の生データを使ってAIの性能を測っているのも新しい点です。以前の研究では、人工的に作られたデータや簡単な分類問題を使うことが多かったのですが、この研究ではより現実的な数字予測の問題を扱っています。さらに、複数のAIを比較し、質問の仕方によってAIの答え方がどう変わるかも詳しく分析しています。

技術や手法の肝はどこ?

この研究の重要なポイントは、AIの学習方法を調べるための新しい方法を提案したことです。研究者たちは、AIへの質問の仕方、与える例の数、使う情報の種類などを変えながら、AIの答え方の変化を観察しました。特に、次の4つの質問方法を比較しました:

- 本当の名前を使う(例:年齢、身長)

- 一般的な名前を使う(例:特徴1、特徴2)

- 正解をでたらめな数字に変える

- 例を全く与えずに質問する

これらを比較することで、AIがどのように既存の知識と新しい情報を組み合わせているかを分析しました。どうやって有効だと検証した?

研究チームは、3つの異なる数字予測の問題(大学入学の可能性、保険料、中古車の価格)でAIの性能をテストしました。質問の仕方、与える例の数(0個、10個、30個、100個)、使う情報の数(1個、2個、3個)を変えながら実験を行いました。AIの予測がどれくらい正確かを、主に「平均二乗誤差」という指標で測りました。また、普通の機械学習モデルとも比較しました。実験の結果、AIが実際の数字予測の問題をうまく学習できること、そして既存の知識と新しい情報の両方を使うことで性能が向上することが分かりました。特に、本当の名前を使って質問する方法が最も良い結果を示しました。

議論はある?

研究者たちは、この研究結果について次のような議論をしています。まず、AIの学習方法を理解し制御することが、AIの実用化に重要だと主張しています。例えば、与える例の数を増やすと新しい情報からの学習が促進され、使う情報の種類を増やすと既存の知識の活用が強化されるという発見は、AIの使い方を最適化する方法を示唆しています。また、AIが学習する際に、意図せずデータの偏りを取り込んでしまう「データ汚染」の問題についても触れています。研究の限界としては、数字予測の問題だけを扱っていること、使ったデータの種類が限られていること、AIの内部の仕組みを完全には理解できていないことなどが挙げられています。

次に読むべき論文は?

この研究をさらに深く理解するために、以下の論文を読むことをおすすめします:

- Min氏らの論文(2022年):AIの学習における例の役割について再考している研究です。

- Li氏らの論文(2024年):AIが文脈から何を学ぶかについて、新しい仮説を提案しています。

- Vacareanu氏らの論文(2024年):AIの数字予測能力に焦点を当てた研究です。

- Coda-Forno氏らの論文(2023年):AIの学習能力をより広い視点から探求しています。

これらの論文を読むことで、AIの学習メカニズムについてさまざまな視点から理解を深めることができるでしょう。

レポジトリ

プロジェクトの概要

このプロジェクトでは、回帰タスクにおける大規模言語モデル(LLM)のコンテクスト内学習(ICL)能力を調査しています。LLMが内部知識をどの程度引き出すか、またコンテクスト内の例からどの程度学習するかを評価することを目的としています。この研究では、現実世界のデータセットを使用した回帰タスクに焦点を当て、コンテクスト内学習メカニズムを評価するためのフレームワークを提案しています。

プロジェクトの主な要素は以下の通りです。

- 現実的なデータセットにおける後退をLLMが実行できる能力を実証すること。

- 内部知識の検索と文脈上の例からの学習のバランスを測定すること。

- これらのメカニズムに影響を与える要因、例えば、タスクに関する事前知識や文脈上の例から得られる情報などを分析する

- メタ学習を活用し、知識の検索を促進するための迅速なエンジニアリングに関する洞察を提供します。

プロンプト設定

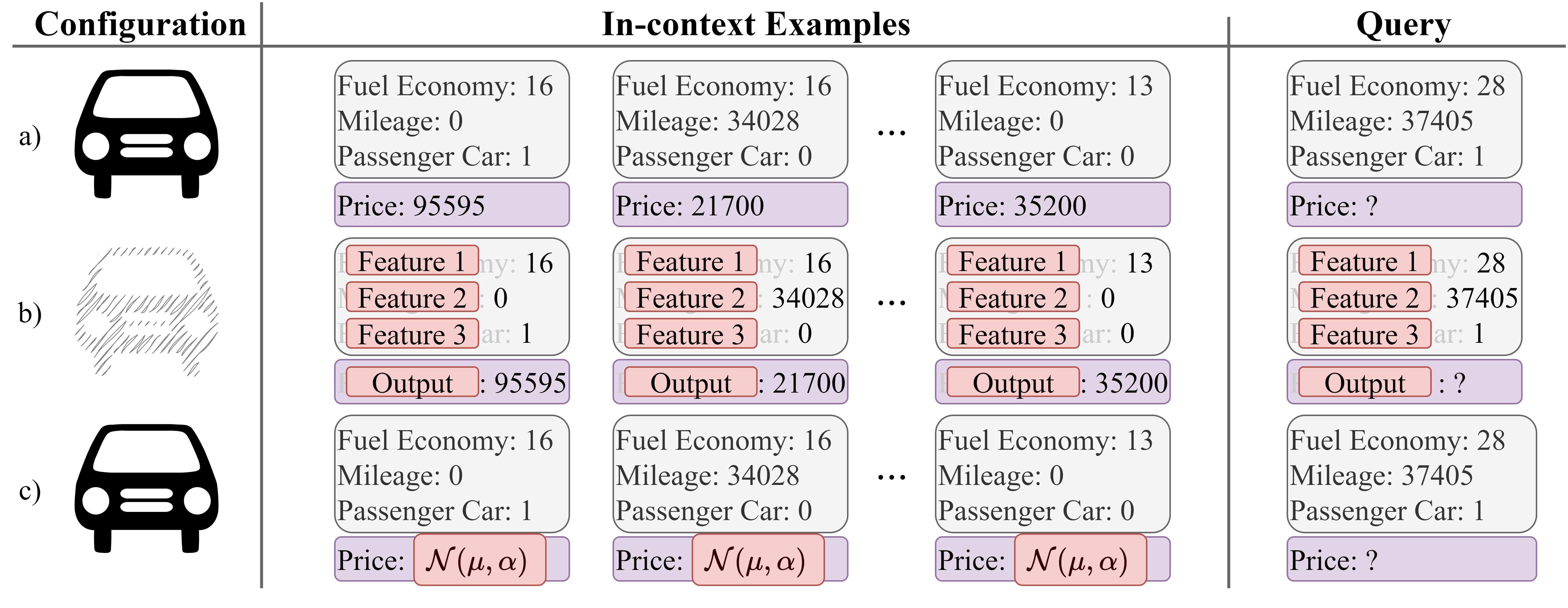

図1: 実験で使用した主なプロンプト構成の概要

refered from https://github.com/HLR/LvsR-LLM

- 名前付き特徴(構成 a):特徴とターゲット変数の実際の名前を明らかにします

- 匿名化特徴(構成 b):「特徴 #」や「出力」などの一般的な名称を使用します

- ランダム化されたグランドトゥルース(構成 c):名前付き特徴は維持しますが、グランドトゥルースをランダムな数値に置き換えます

- 直接質問回答(直接 QA):LLM に文脈に沿った例なしでターゲット変数を推定させます

データセット

このプロジェクトでは、以下のデータセットを使用します。

ちょっとコードを読んでみたいのと、日本語でも同じかを確認してみたいところ。