クロスプラットフォーム・マルチLLMプロバイダ対応のMCPクライアント「Dive」を試す

GitHubレポジトリ

Dive AI Agent 🤿 🤖

Diveは、関数呼び出し機能をサポートするあらゆるLLMとシームレスに統合するオープンソースのMCPホストデスクトップアプリケーションです。 ⬨

referred from https://github.com/OpenAgentPlatform/Dive機能 🏯

- 📊 ユニバーサルLLMサポート: ChatGPT、Anthropic、Ollamaおよび OpenAI互換モデルと互換性あり

- 🔻 クロスプラットフォーム: Windows、MacOS、Linuxで利用可能

- 🔄 モデルコンテキストプロトコル: stdioとSSEモードの両方でシームレスなMCP AIエージェント統合を実現

- 📍 多言語サポート: 繁体字中国語、簡体字中国語、英語、スペイン語に対応し、今後さらに追加予定

- ⚙️ 高度なAPI管理: 複数のAPIキーとモデル切り替えをサポート

- 🔡 カスタム指示: パーソナライズされたシステムプロンプトによるAIの動作調整

- 🔄 自動更新メカニズム: 最新のアプリケーション更新を自動的にチェックしてインストール

最近の更新(2025/3/14)

- 📍 スペイン語翻訳: スペイン語言語サポートを追加

- 🔖 拡張モデルサポート: Google GeminiとMistral AIモデルの統合を追加

今回はローカルのMacで。インストールは、インストーラを実行するだけ。2025/04/09時点の最新はv0.7.6だった。

起動するとOpenAI APIキーが求められるので入力。モデルが選択できるようになるので、選択して保存。

なお、OpenAI以外にも以下のプロバイダに対応している様子。

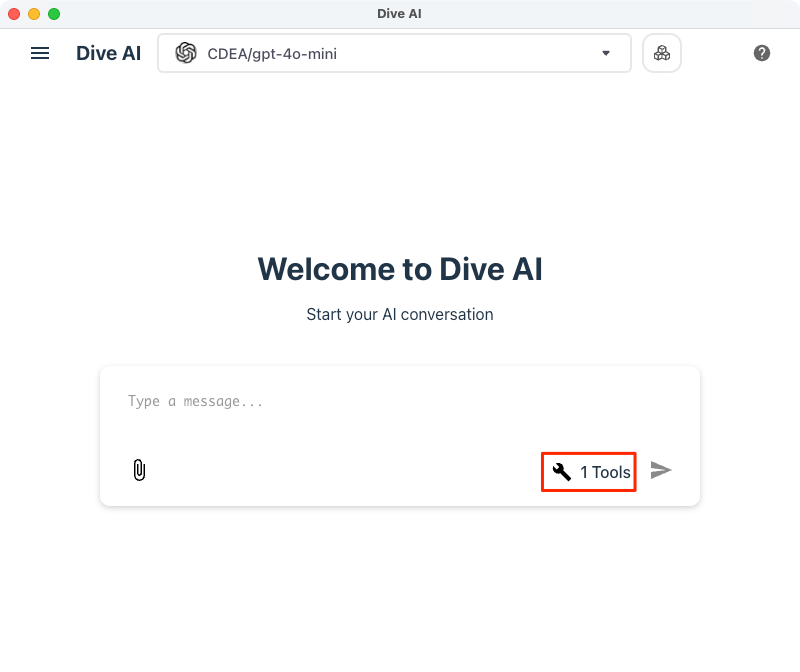

完了。既にツールのアイコンに"1"とある。これをクリック。

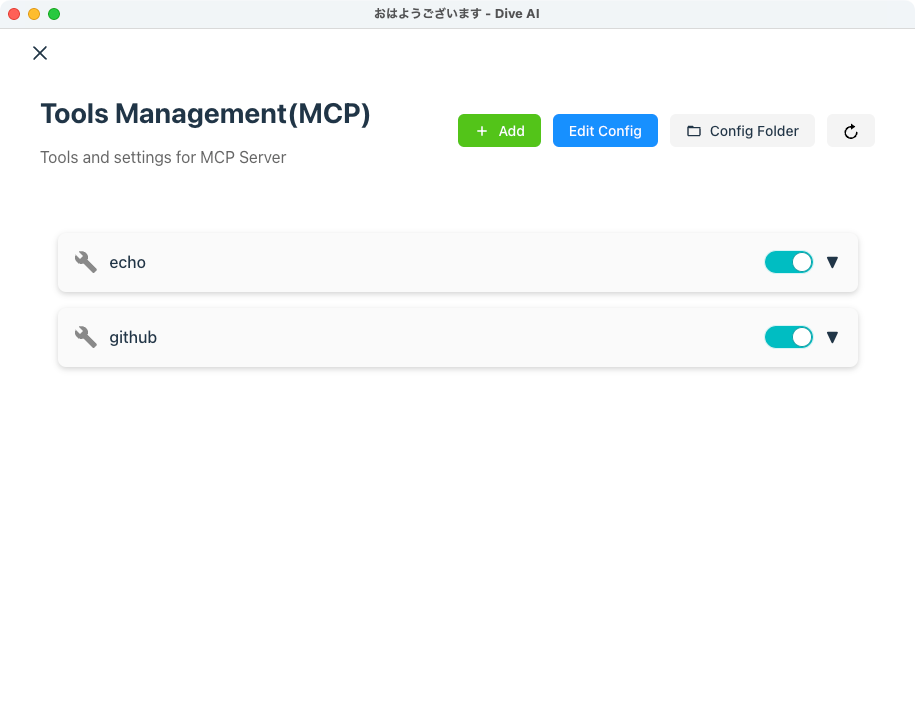

ここでMCPサーバを設定するみたい。"echo"というMCPサーバが登録されている。

ドキュメントにある通り、これはデフォルトで用意されているものらしい。

MCPヒント

システムにはデフォルトのエコーMCPサーバーが付属していますが、LLMはMCPを通じてより強力なツールにアクセスできます。(snip)

クリックするとツールの説明が表示される。名前の通り、入力をそのまま返すものかな?

一応試してみる。元の画面に戻って適当に入力。

とりあえずMCPサーバとやりとりして応答が返っているのがわかる。

GitHubのMCPサーバを追加してみる。左のメニューからツール管理画面を開く。

"Add"をクリック

設定はJSONを直接入力する。READMEを見る限り、Claude Desktopとかと同じフォーマットで良いみたい。余談だけど、このフォーマットって標準化されてるのかな?"mcpServers"になっていないので独自フォーマットなのか?とか考えてしまった。

GitHubのMCPサーバの設定を追加して保存

追加された。元々あった"echo"も残ってる。まるっとペーストしたのでechoは消えるのかな?と思ったけど。

どうやら全部のJSONは"Edit Config"で設定できるみたい。

で、"Add"の方は常に1つを登録すると。あぁ、なるほど。だから "mcpServers" ではなく "mcpServer" なのね。で、"mcpServers" としてここで登録してもよしなにやってくれると。

閑話休題。元の画面に戻ってGitHub MCPサーバが使えるか試してみる。

GitHub MCP経由で情報を参照して解凍している。

エージェント的に複数回ツールを実行したりも。

まとめ

シンプルできれいなインタフェースでよいのではなかろうか。IDE以外のクライアントとしてはClaude Desktopぐらいしか知らないけど、OpenAIやGeminiなんかが使えて、IDEのゴテゴテ感がないので、エンジニア以外の人にも使いやすいのではないかと思う。

APIキーをセットするので当然ながらLLMの料金は従量課金にはなる。Claude Desktopの場合、Claude.aiのサブスク範囲内で使えるってところはメリットだよね。