Open7

DeepSeek R1をローカルで動かしたい

ここに則って

- CUDA Toolkit 12.9をインストール

- cuDNNのインストールはスキップ

- w64devkit 2.2.0をインストール

- cudart-llama-bin-win-cuda12.4-x64.zip、llama-b5361-bin-win-cpu-x64.zipをダウンロード

- bartowski/DeepSeek-R1-Distill-Qwen-14B-GGUF をダウンロード

実行

w64devkit

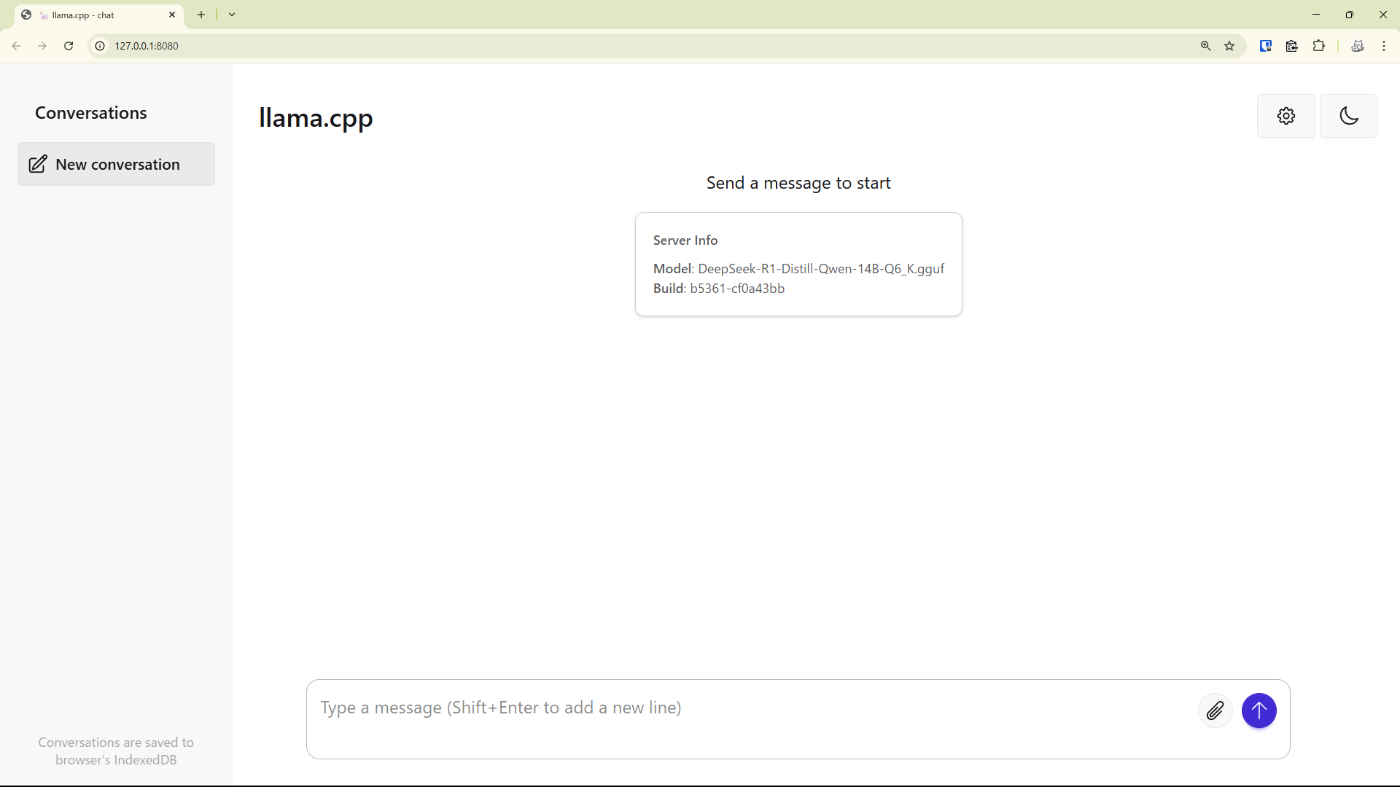

$ ./llama-server.exe -m ../models/DeepSeek-R1-Distill-Qwen-14B-Q6_K.gguf

(中略)

main: server is listening on http://127.0.0.1:8080 - starting the main loop

srv update_slots: all slots are idle

3 tok/sec.程度

load_tensors: offloading 48 repeating layers to GPU

load_tensors: offloading output layer to GPU

load_tensors: offloaded 49/49 layers to GPU

の表示はあるが、GPUのメモリ使用率は微動だにしない

CUDA Toolkit 12.4をインストールしてみる

→ さすがに12.7をアンインストールしていないからか失敗する

趣向を変え、LM Studioを試す

すぐに動いた!

deepseek-r1-distill-qwen-7bで13.94 tok/sec