「Deep Research」の精度を要約で底上げする

導入

こんにちは、株式会社ナレッジセンスの須藤英寿です。

今回は、DeepResearchの精度を底上げする手法「SLIM」について紹介します。

サマリー

DeepResearchは、検索を何度も繰り返すことで、知りたい情報を深く詳細に知ることのできる手法です。DeepResearchはその性質上、膨大な量の文章を処理する必要があります。gpt-5を含む最近のLLMはこの大量の文章を処理・理解する能力が飛躍的に伸びている一方で、検索を繰り返し、情報が増えていくことでLLMの性能は段々と低下していきます。

今回紹介する「SLIM」は、DeepResearchが検索を繰り返す過程で情報を見失う前に、そこまでの検索内容を適切な要約に変換することで、情報を見失わないまま高い精度で検索を続けられます。

課題意識

DeepResearchのコンテキスト爆発による精度低下

DeepResearchは、詳細な調査において高い性能を発揮する一方で、コンテキストの増加による精度の低下とコストの増加、そして継続の困難性が課題でした。精度を上げるために、詳細な調査をしているのにそれが逆に精度を下げている。という状態です。以前紹介した「コンテキストエンジニアリングがなぜ重要なのか」の中に、コンテキストの「圧縮」が重要と記載していますが、今回のケースはまさにこの圧縮が重要でこの圧縮の精度がDeepResearchの精度に大きな影響を与えています。

手法

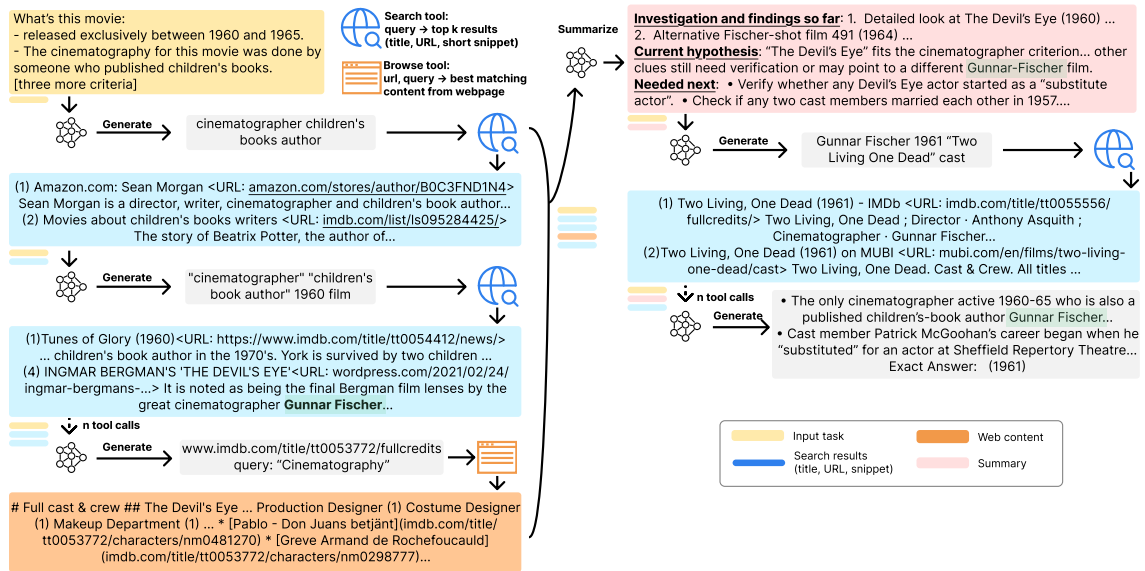

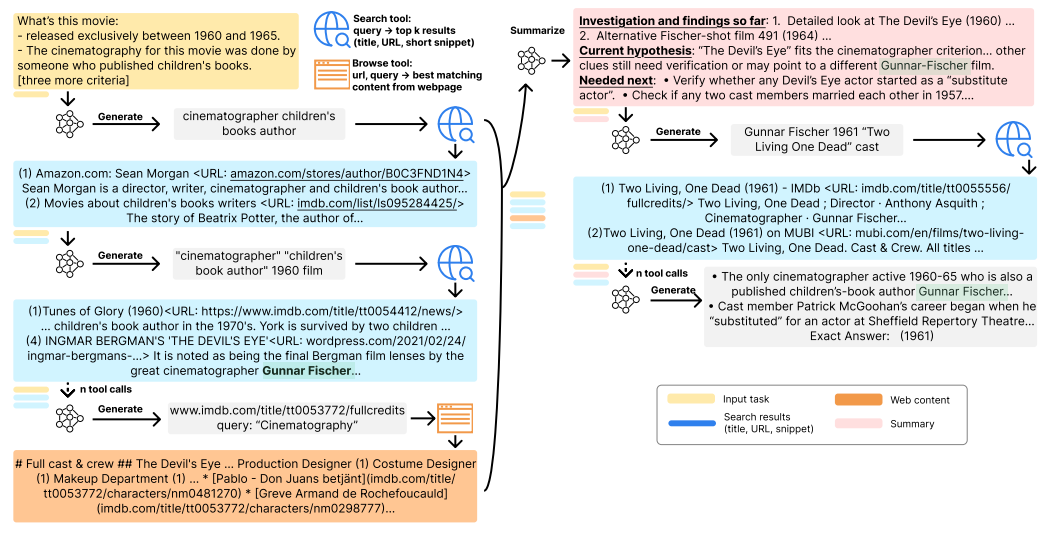

SLIMでは既存のLLMを利用しつつ以下の3つのツールを利用します。

- 検索ツール: タイトル、URL、要約のみの概要情報を取得できるツール

- 閲覧ツール: ページ全体から必要な情報を取り出すツール

- 要約モジュール: SLIMの核となる機能で、それまでの検索の履歴をLLMに要約させ、重要な情報のみを維持するツール

これらのツールをループ内で繰り返し利用することで、必要な情報を集めていきます。

要約モジュール

次に「SLIM」の核となる構成要素、要約モジュールについてもう少し詳細に見ていきます。LLMに要約して貰う場合、その観点を指示することが非常に重要になります。SLIMでは、次の検索やこれまでに検索した内容が重要になってくるため以下の観点で要約を行っています。

- これまでの発見: これまでの検索から判明した事実を要約した内容

- 現在の仮説: ユーザーの質問に対して現時点での回答の想定を記載している

- 次の予定: 次に調査すべき項目の一覧

これらの調査に必要な項目について要約することで必要十分な情報にまとめられています。

評価

各手法における精度と検索コストを比較した結果です。「T」はループの回数を表します。SLIMだけTの値が大きいものまで検証されていますが、これは他の手法では、Tを大きくするとコストが大きくなりすぎる、もしくはコンテキストの長さの限界に到達してしまうためです。また、この実験ではSLIMは50回に1回要約を実行しています。

BrowseCompの比較では、SLIMのT=150で最も高い精度を実現しており、コストもループ回数に対してかなり低いものとなっています。HLEでは、回数の増加とともに精度が上がることはなく、高い精度を実現しているものの、Grok-4よりも精度が低くなっています。

まとめ

今回は、DeepResearchの精度を底上げする手法「SLIM」について紹介しました。特筆すべき点は、要約を大胆に行うことで、コスト削減と深い探索の両立を実現している点です。一方で、これまでDeepResearch機能を提供していた身からすると、不足している点もありそうです。例えば、「20社分の情報を調査して」と言った幅広く、かつ一定の深さをもつ探索などでは、要約の過程で重要な情報が抜け落ちる可能性が非常に高いです。

要約では、観点づくりが重要という話をしました。DeepResearchに多種多様な入力が想定されることから、どれだけ質問のパターンを想定し、適切な要約観点を提供できるかが、この手法を使いこなすうえでも重要になってきそうです。

もし、DeepResearchの精度が上がらない、コストが高すぎる。などの問題が発生した場合は「SLIM」を、是非応用してみてください。

Discussion