Gemini Pro VS GPT-4(マルチモーダル)

Gemini Proがブラウザから及びAPI経由で試せるようになりました!

今回はマルチモーダルの性能を軽めに検証し、GPT-4と比較してみます。

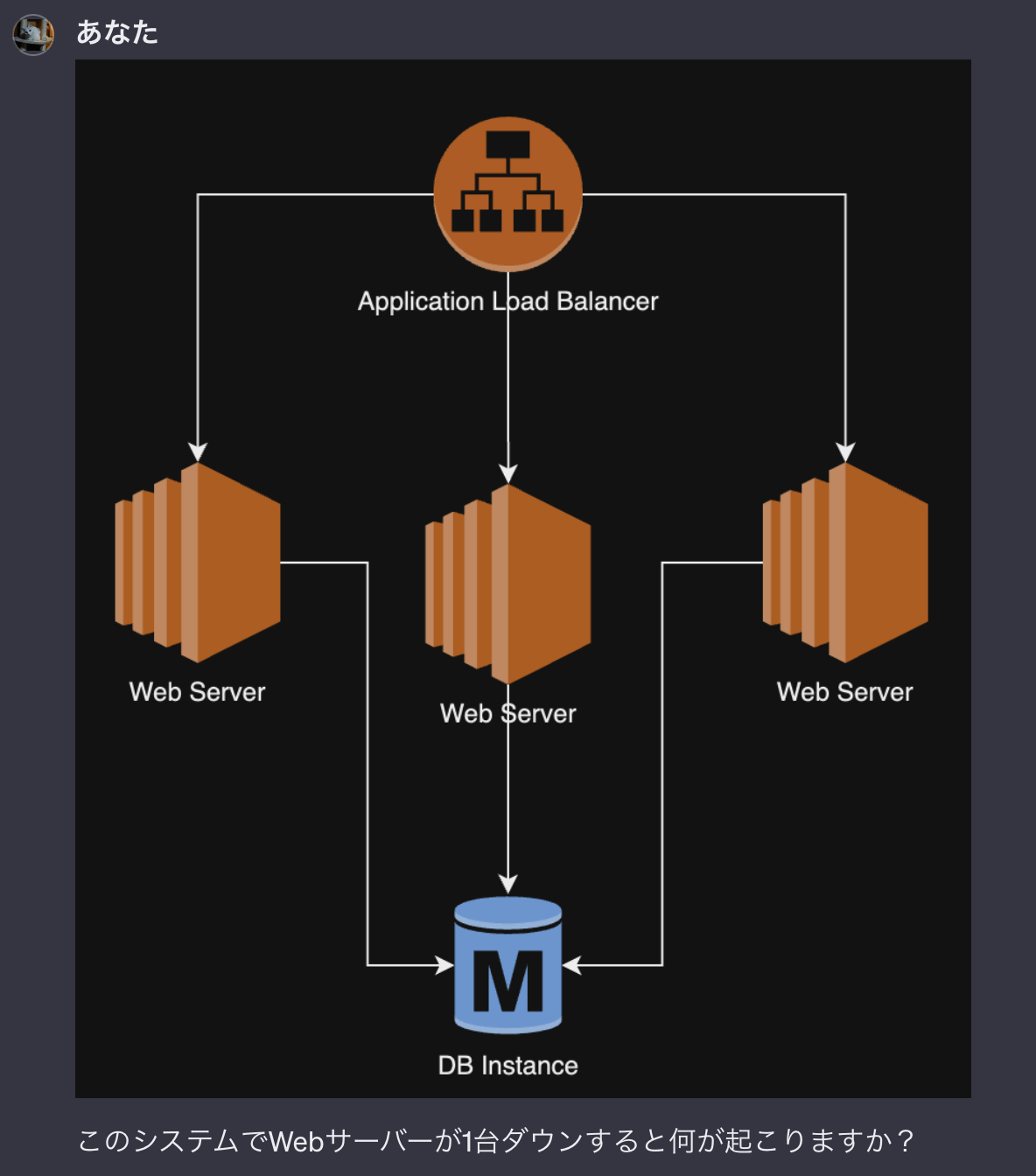

比較ケース

このようなシステム構成図を添付し、「Webサーバーが1台ダウンしたらどうなる?」と質問してみることにします。

GPT-4の場合

GPT-4の場合、ChatGPTのUIから画像とプロンプトを入れます。

レスポンスはこんな感じ

冗長化してあることによりサーバーがダウンしないだけではなく、他のサーバーへの負荷が増える恐れなどかなり詳細にレポートしてくれていますね。かなり優秀な感じがします。

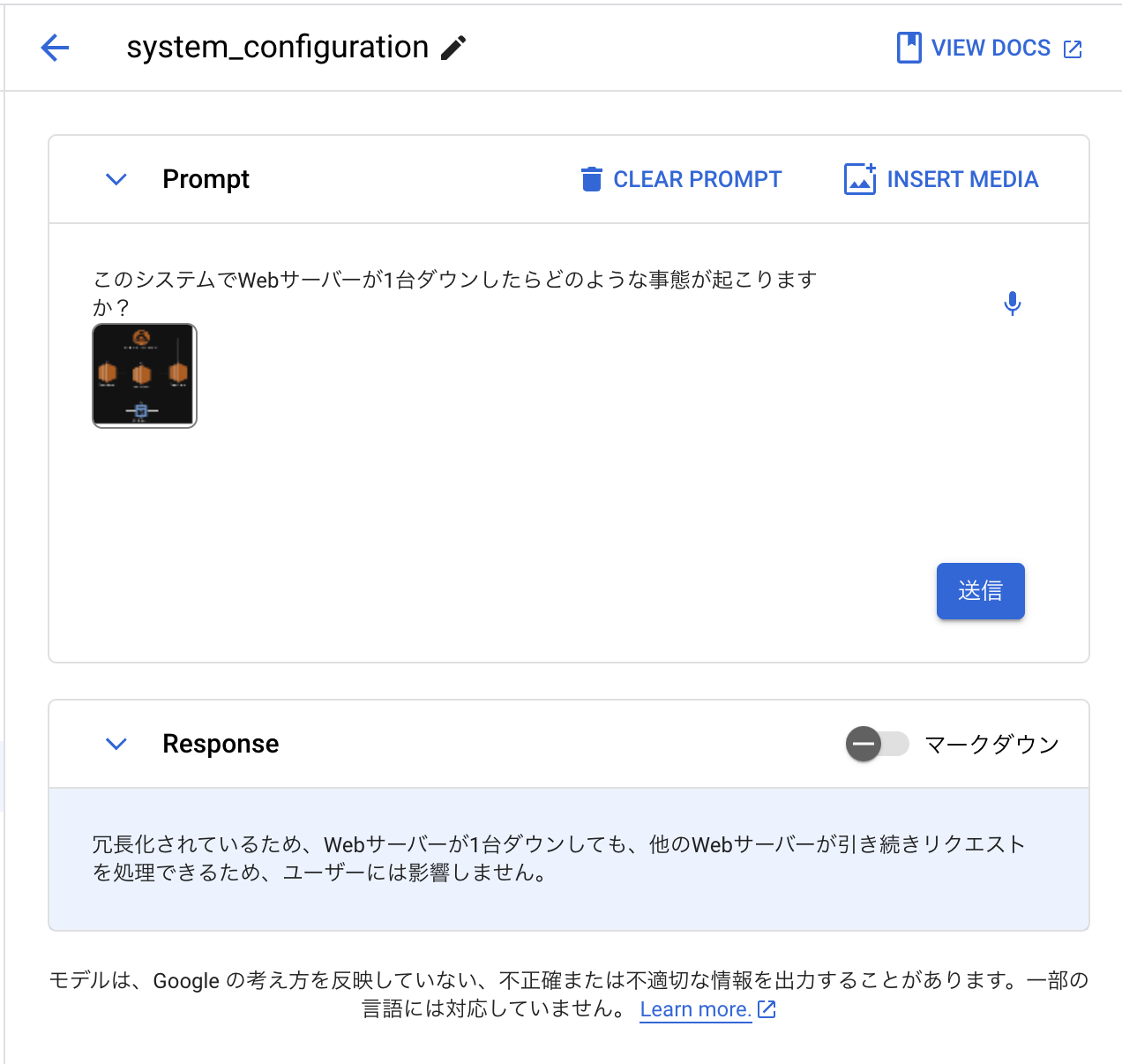

Gemini Proの場合

Gemini Proの場合、Vertex AI Studioに画像とプロンプトを入れてレスポンスを得るとこんな感じになります。

かなりシンプルな回答ですね。しかし間違えているわけではないので、たくさん喋るGPT-4と短く結論だけ返すGemini Proのどちらが優れているかはこれだけだと断じるのは難しそうです。

試しにもう一回り聞いてみましょう。

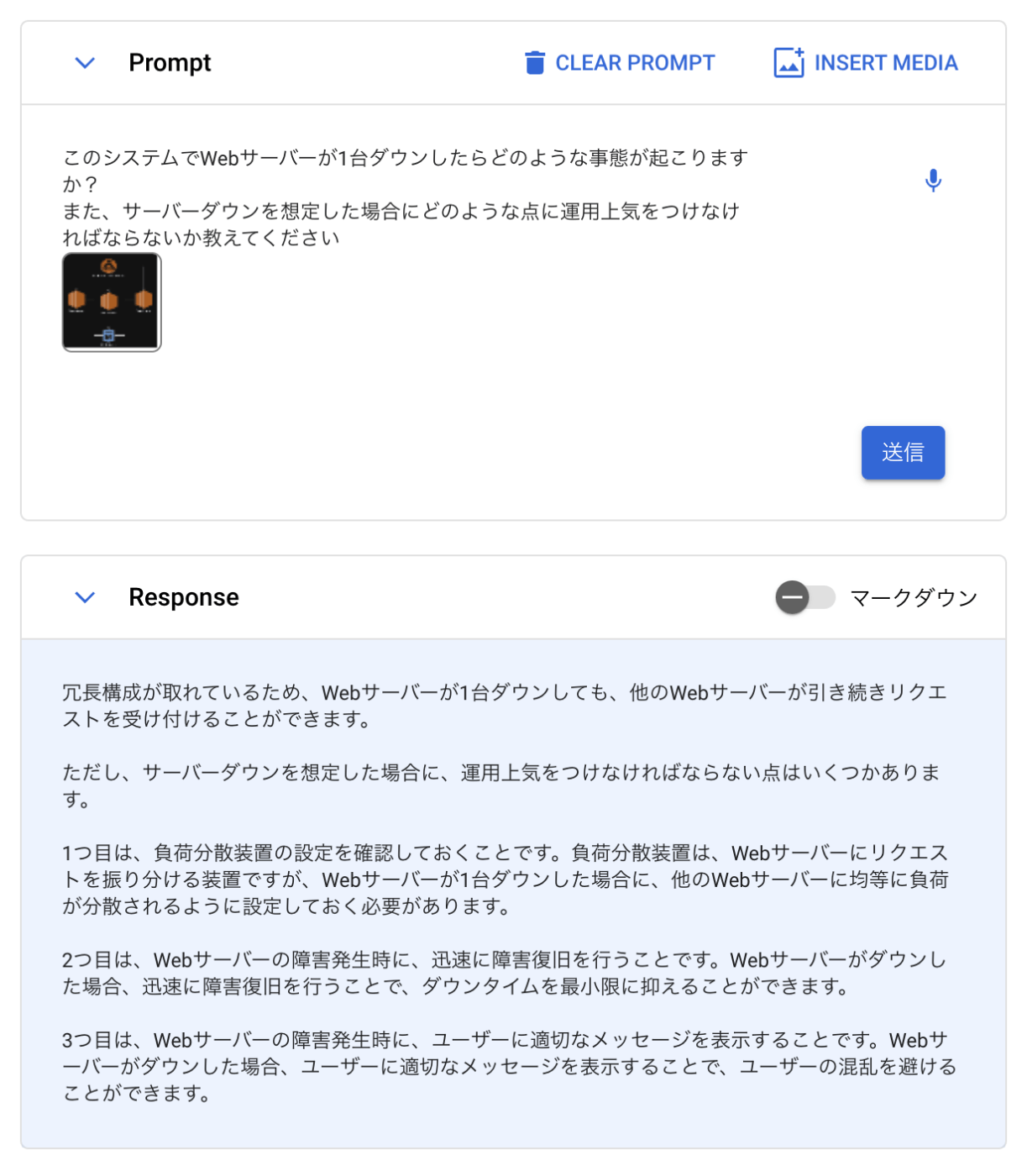

「また、サーバーダウンを想定した場合にどのような点に運用上気をつけなければならないか教えてください」

という文言を追加してアドバイスを引き出してみました。

網羅性は先程のGPT-4の出力には劣るものの、それなりに実用性のあるアドバイスをもらえました。

まとめ

以前のBardに搭載されたGemini Proで比較した記事と同様に、Gemini Proは今回もGPT-4に負けるとも劣らずという感じのアウトプットを出してきました。

現状、インプットには画像と映像は使えるけど出力はテキストのみ、という状況です。

先日の衝撃的なデモ映像のような連続したストリーミング映像入力と音声インプットの合せ技のようなものはまだ出てきていないですが、今後数ヶ月中くらいには拝めるといいですね!

Discussion