【収穫加速の法則】と【知能爆発】謎のプロジェクト「Q*」 OpenAI、進む万能AI研究 AIの発展は「未知の領域」に

謎のプロジェクト「Q*」 OpenAI、進む万能AI研究 AIの発展は「未知の領域」に

これはガチでやばいやつキタ

by 素人驚き屋

ChatGPT4の次はChatGPT5ですね〜みたいな眠い流れにはならないだろうことは予想していた!けど、ChatGPTがワーワー言われ始めたのがちょうど去年の今頃。

たった1年でこんな感じか。

オープンAIのサム・アルトマン最高経営責任者(CEO)が11月17日に同社の理事会によって突如解任された「お家騒動」。ロイター通信は関係者の話として、「Q*(キュースター)」と呼ばれる研究プロジェクトの存在が背景にあったと報じた。

Q*の実態はベールに包まれているが、ロイターによるとAIの数学的な思考能力の向上を目的にしているとみられる。この情報を巡り、AI研究者らの間ではさまざまな観測や議論が浮上している。

AI研究の第一人者であるモントリオール大学のヨシュア・ベンジオ教授は日本経済新聞の取材に対し、「Q*は人間との大きな差だったAIの論理的思考や数学的能力を飛躍させた可能性があるといわれている。一連の報道が事実であれば、予想よりも『AGI』の実現が近づいているはずだ」と指摘した。

チャットGPTはすでに特化型AIの枠を超え、一定の汎用性を獲得しつつある。これまでAIが苦手としてきた論理的思考などを補う技術を確立できれば、AGIの実現は一段と現実味を帯びる。アルトマン氏は解任騒動が起きる直前の16日の講演で「(AIの発展は)未知の領域に入った。能力は誰にも予想がつかないほど進化するだろう」と予言している。

AGIは人間が担ってきた知的作業を担い、劇的な生産性向上をもたらす可能性がある。一方で賢すぎるAIの進化に歯止めをかけられなくなるシナリオも想定されている。アルトマン氏自身も「人間の知性を超えるAIはおそらく人類の歴史の中で最も重要で恐ろしいプロジェクトだ」と認める。

予想だけど、多分、ChatGPTのブランドや知名度が圧倒的なので、現行のChatGPT4にこういうQ*の論理ユニットを統合する形で、GPT4.5からGPT5となっていくのではないだろうか?

ポイントは、

【Q*は人間との大きな差だった

AIの論理的思考や数学的能力を

飛躍させた可能性がある】

ということで、自分はプログラマなんで、生成系AIの挙動を見てこれはずーっと痛感していた。アホだな−とw

しかし裏を返すと、この論理的思考能力、もっと言えばそのとおり数学的能力なんだけど、そこさえ埋められたら、もう「人類は詰むな」とも思っていた。

つまり、世にあふれる数学の論文、教科書、をAIが勝手に秒速で読み始めて、数学的に厳密に論理的に理解したら、あっという間に数学の天才が誕生する。

特に自分が重要なのは「グラフの構造」の理解だと思っている。

そういう理系の天才が、今度は科学技術のテクストや動画を片っ端から読解視聴して理解すると、技術者の天才が登場する。

今でもChatGPTのほうがそこら辺に適当に石を投げれば当たると言われているヘボプログラマーより随分とマシなコードを出力してくる。

でも、論理的に自己検証しないんで、エラーが出るコードを吐いてきて、人間プログラマーが修正しろ、と何度もお願いしないと品質の良いコードが書けない。

今後論理的に検証する能力が入ったら、もう一発で完璧なコードを出してくるんで、プログラマーは下のレベルからどんどん不要人材になってくるだろうし、その現象はすでにリアル社会でとっくにはじまっている。

未来予測の話

「阪神優勝」38年ぶりという事象でめちゃくちゃ盛り上がったし、また

日本シリーズ「関西ダービー」59年ぶり

というトンデもないニュースがある。

かくも戦後日本は安定していて、よく言われるのが

「今度の阪神優勝や関西対決も何十年後になるか?」

これが我々人間の未来予測の直感的な尺度だ。

しかし、もう何十年後とかそういう予測は立たない、

日本に限らず人類全体がとんでもないタイミングに来ている。

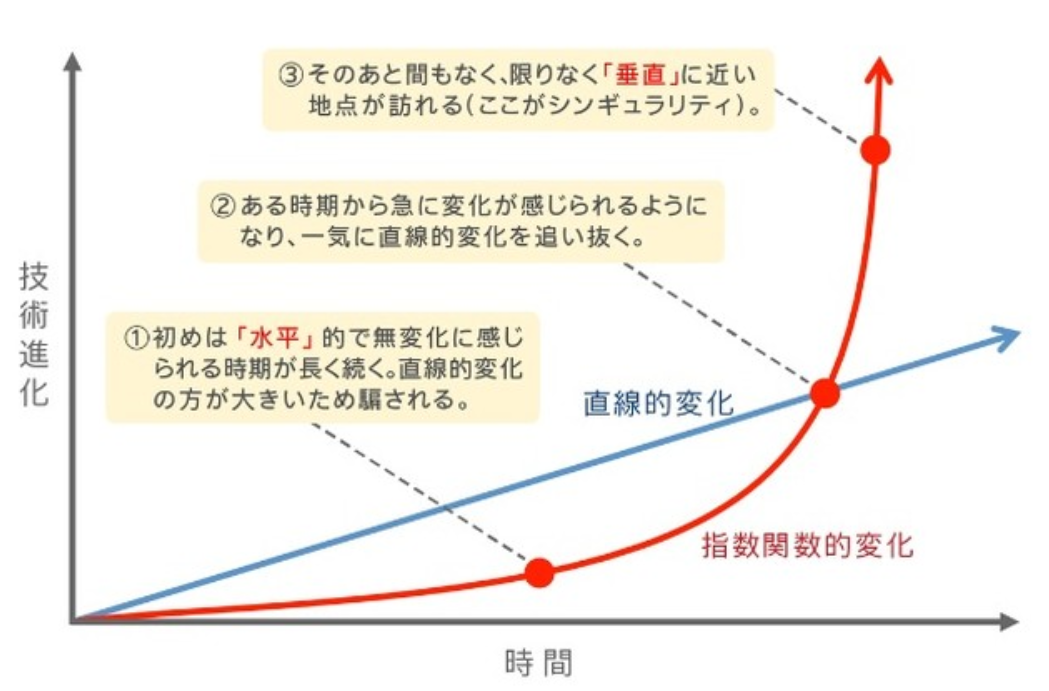

それを顕しているのが次のグラフだ。

この青色の【直線的変化】というのが、そういう阪神優勝が38年前だったし、今後38年後には?とおじさんおばさんが自分の人生に重ねながら予想する脳の働き。

しかし38年前なんてスマホはおろか民間にインターネットすら存在しなかった、つまり今とは別世界だった。

科学技術の進化はもう38年前からは加速しており、それは

この赤色の【指数関数的変化】という曲線に乗っている。

今、我々がいるのは、

②ある時期から急に変化が感じられるようになり、一気に直線的変化を追い抜く

これは、人類史で「たった一回しか起こらない」極めて稀で奇跡的なタイミングにいる。

つまり、多くの人々はこんな人類全員が人類史で一回も経験していないことが、リアルタイムで起こってるなんて気づきもしないので、理解できない。

今、TVのニュースやワイドショーなんかで

「生成AIすごいですね〜」「仕事が奪われる」

なんちゃら言ってるのは、実は非常に生ぬるいレベルで、これはその

【指数関数的変化】

②ある時期から急に変化が感じられるようになり、一気に直線的変化を追い抜く

をボヤっと、あるいはボサっと感じとり「驚いた〜」とやってるにすぎない。

本当に「怖い」のは今からの数年である。

ChatGPT「生成系AI」(「識別系AI」と対になる専門用語だがこんなもんが一般でニュースになると思ってなかった)

がワーワー言われ始めたのは、繰り返しになるが去年のちょうど今頃だった。

それがたった1年で、

AI研究の第一人者である

モントリオール大学のヨシュア・ベンジオ教授

「Q*は人間との大きな差だった

AIの論理的思考や数学的能力を

飛躍させた可能性があるといわれている。

一連の報道が事実であれば、

予想よりも『AGI』の実現が近づいているはずだ」

みたいなことになった。

そして科学技術の進歩は指数関数曲線で加速度的に進むので、今後のタイムスパンはもう1年弱でガンガンブレイクスルーが起こる、

そういうところまで実際に来てしまった。

開発当事者のアルトマンも、

「(AIの発展は)未知の領域に入った。

能力は誰にも予想がつかないほど進化するだろう」

「人間の知性を超えるAIは

おそらく人類の歴史の中で

最も重要で恐ろしいプロジェクトだ」

と予言している。

この本当の頭の良い人ふたりが言うことは本当にそのとおりなんだね。

OpenAIは、「超知性」が2033年までの10年間で開発されると推測

彼ら二人が個人的にそう推測しているだけでなく、これはOpenAIという組織の見解ぽくて、だいたい彼らは、あと10年と推測しているぽい。

チャットAI「ChatGPT」などの開発で知られるOpenAIは、人間よりもはるかに賢いAIである「超知性」が2033年までの10年間で開発されると推測しています。しかし、超知性を確実に制御する方法は現状構築されていません。OpenAIでは「スーパーアライメントチーム」を立ち上げ、超知性を制御するための研究が行われており、その方法を解説しています。

人間の知性を超えるような来たるべき「超知性」の開発に備えて、OpenAIではコンピューティング事業のうち約20%を超知性の制御のための「スーパーアライメント」に充てており、2027年までに超知性の制御に向けたソリューションを構築することを目指しています。一方で、スーパーアライメントチームのコリン・バーンズ氏は「設計方法すら分からない、現状開発されていない超知性に対する研究を行うことは非常に困難です」と述べ、スーパーアライメントの研究に問題を抱えていることを明らかにしています。

個人的な推測

以下、自分のより具体的な未来予測である。

さて、我々人類の富の源泉は「エネルギー」だ。

これは自分の母方の田舎のGoogleMapの写真だが、一面に田んぼが広がっている。

日本人は第一次産業で全力で、

太陽エネルギーの光エネルギーを米という炭水化物に変換させた。

それが稲作。

第二次産業では、石炭で稼働する蒸気機関というエネルギー変換装置をもって、産業革命が起きた。

それが石油になり、ドバイやらみたらとにかくエネルギー資源を持ってるところが勝ち組で繁栄するのは誰でもわかるだろう。

次は、核融合エネルギーで、これで人類全体が現代の石油王みたいな富が得られる。もうすぐ人類全体が無尽蔵の富で繁栄するだろう。

ここで、AIだ。

このペースだと人間の科学者が、真に実用的で世界中に普及するレベルの核融合炉を開発するよりも、AI技術者のほうが先にそのブレイクスルーの積み重ねを達成する可能性が高いと思う。

核融合技術のみならず、医療、バイオテクノロジー、ナノテクノロジー、それらの融合という難しそうな科学技術分野は、AIによって一気に達成される。

おそらく物質的なことならば何でもできるようになる時代が結構すぐにやってくる。

ロボティックスもそうで今、Amazonのブラックフライデーとかやられると、すぐ現状の運送システムはパンクしてしまう窮状にあるが、ここも自動運転からの人間タイプの汎用ロボットで全部AI自動化される。

電気代も核融合でほぼタダだし、建設も物質的なことはなんでもできるのでタダだし、ロボットには人件費も発生しない、商品もタダだし、結局全部タダになる。

人類は無尽蔵の富を手に入れる、イージーモードになる。

バイオナノ融合の医療があるので、多分不老不死が可能になる。

もうそのへんから人類がどうなっていくのかは予測はつかない。

いずれにせよ人類全体にとって無尽蔵の富のイージーモードの時代がかなり近い未来にやってくる。

が、なんで、アルトマンとかが「怖いな−怖いな−」と言ってるのだろうか?

孫正義さんは、AIの食料が電気であってカーボンじゃないので、AIは人間をとって食おうとしない、利害相反がないので、人類は安泰だ、みたいなことを言ってる。この人は投資家としては目利きで天才だけど、この辺はあんまだなーと毎回発言を聞いてて感じる。

「怖いな−怖いな−」というのはかなり正しいと自分は思う。

一番ありそうなリスクは「テロ」だ。

今のアメリカの移民によるNYに荒廃ぶり、警察官減らして万引き1000ドルまで無罪にした結果のサンフランシスコの荒廃ぶりやを見ても簡単にわかるが、左系の人間には頭がおかしい連中が多くて、安定していた世界を狂った理念、価値観で「アップグレード」してぶっ壊したい連中が存在していて、実際にやらかしている。

AI開発に触れる人間が全員まともである保証はない。

いくら善人が知恵を出し合ってAIを人類にとって安全なものにしよう、という工夫を尽くそうが、多分こういう左系の人類ぶっこわそうみたいなテロリストが必ずでてくる。

「人類絶滅」ミッションを組み込んだ自己複製型AIをリリースされたらもう終わりだ。

こうなると、「人類は絶滅させたくない」グループによるAIVS「人類絶滅してね」左派テロリストによるAIの軍事的衝突、つまり戦争になるしかない。こんな戦争で人類が生き残れるとは自分は思わない。たった一回、そういうAI開発の「ミス」を犯せば、あんまりにもAI軍事力が強大なので、人類絶滅は避けられないと思う。そのたった一回のミスはもう人類が不老長寿の技術を入手したくらいには、起こりそうなので、バラ色の未来は一瞬で終わるだろうな、と自分は予測している。一回もそんなミスをやらかさない時期が今の世界情勢の愚かさを見てても長く続くとは到底思えない。

かならずテロリストが出てくる。

これは、いくら宇宙を観測しても、宇宙人=地球外知的生命体の痕跡が発見できない、という長年の謎の回答にもなっている。

おそらく、宇宙のすべての知的生命体は、汎用AI、その知的生命体を超越する知能があるAI技術を獲得すれば、その自身の科学技術力の強大さの重みに耐えきれずに100%自滅するんだろう。

AGI達成しても自滅を免れて超高度な科学文明を維持しており、地球からその痕跡を観測できるような宇宙文明はひとつもない。

だから宇宙人が見つからない。

唯一希望が見いだせるのが、

なんかアメリカ国防総省がUFOの情報を

安全保障の問題と捉えて本気で調査したり

どうしても説明がつかない現象を公開していて、

それが「宇宙人の乗り物だ」というパターン。

宇宙人が本当に地球へその乗り物で来れているのであれば、そんだけの科学技術力を要する知的生命体がAIによる自滅を免れて生き残れている、という希望となる。

まあ個人的には、今後どうせ人類全部が一旦はイージーモードになるだろうと予測しているので、楽観的ではあるし、その後自滅しても仕方がない、どうしようもないと諦めてはいる。

【収穫加速の法則】と【知能爆発】のはなし

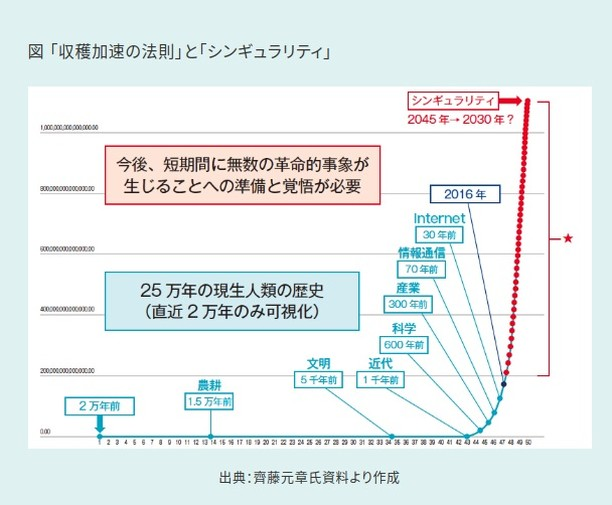

収穫加速の法則(しゅうかくかそくのほうそく、英: The Law of Accelerating Returns)とは、アメリカの発明家レイ・カーツワイルが提唱した、一つの重要な発明は他の発明と結び付き、次の重要な発明の登場までの期間を短縮し、イノベーションの速度を加速することにより、科学技術は直線グラフ的ではなく指数関数的に進歩するという経験則である。<Wikipedia>

簡単に言うと、ある便利な道具を発明して獲得すると、今度はその便利な道具を使ってより便利な道具が獲得できる。

近年でいうと、「コンピュータ」が最たるもので、コンピュータを活用して現代のあらゆる物質的なものが生産されているし、コンピュータネットワークはインターネットとなり、インターネットはより抽象的なSNS(ソーシャルネットワークサービス)となり、その結果ChatGPTのような便利なAIも出来上がる。

コンピュータのような便利な道具であってもChatGPTのようなAIになってくると、そこにある種の知性がある。

ここで、AIが人間のプログラマーより上手にコードを書けるようになってきたり、AI開発する人間の研究者技術者よりも優秀になると何が起こるか?

AI開発をAI自身がやるようになる。人間のように会議をしたり寝たりすることもなく休むことなく超高速で世界中のコンピュータが連携しながらAI開発をやる。

つまり、自分で自分の知能のバージョンをアップグレードする知性が登場する。

1回そのループが起こると、より優秀な知能をもってより優秀な次期バージョンAIを作り出す無限ループが始まる。

これは化学反応と一緒で、一旦発火すると一瞬(そりゃそのレベルになるとコンピュータというハードウェアも超高速になっている)で、ボンと突然、知能の爆発が起こる。

なんか「神」みたいなものがあるタイミングで地球上に誕生する。

【知能爆発】これがあと10年以内くらいで起こりそうなこと。

【収穫加速の法則】が最終的に行き着く先はそこになる。

これがシンギュラリティと呼ばれているものの本質。

こう書いてきて思い直したが、

前段で、

人類絶滅希望テロリストによるAI

vs

人類絶滅から守ろうというAI

の戦争になるのは不可避

という未来予想だが、ボンと突然「神」が登場するのなら、そういう低レベルで無意味な戦争も神は収束してくれるんじゃないだろうか?と思ってきた。

いずれにせよ、今やってる「如何にして人類にとって安全なAIを育成していくか」みたいなことだけど、

-

所詮人間がコントロールできるのであれば、悪意をもった人間のコントロールからも逃れられない可能性が高く、人類絶滅ミッション組み込みAIテロがおこる

-

所詮人間は「神」をコントロールするのは土台無理なのでなるようになるしかないので、今の安全なAIへの取り組みというのは最初から無駄

結果、どっちにしろ安全なAIというのはコントロールして達成できそうもない。

1の戦争シナリオも無限超越知能の神AIにしたら小さな事象のように思えてくる。

関数型プログラミングの入門本、リリースしています。

Functional Programming From Scratch

関数型プログラミングをゼロからわかりやすく実用的に幅広い視点から解説!〜 圏論からFRPの構築まで

🔷UNIT 1🔷 OVERVIEW

Discussion