🐴

Llama 2 をDocker使ってローカルで動かす

Llama 2 発表!

Metaから商用利用可能なライセンスでオープンなLLMであるLlama 2が発表されました。

こりゃすごそうだけど、しばらくは様子見かなーと思っていたら、npakaさんが一瞬で動かしているではありませんか。

こりゃやるしかないと、ローカルでDockerで動かしてみました。要は、npakaさんの記事の「(1) Pythonの仮想環境の準備」を詳しく書いたものです。

DockerでLlama 2を動かす

Dockerファイルは、以下リポジトリに格納してあります。

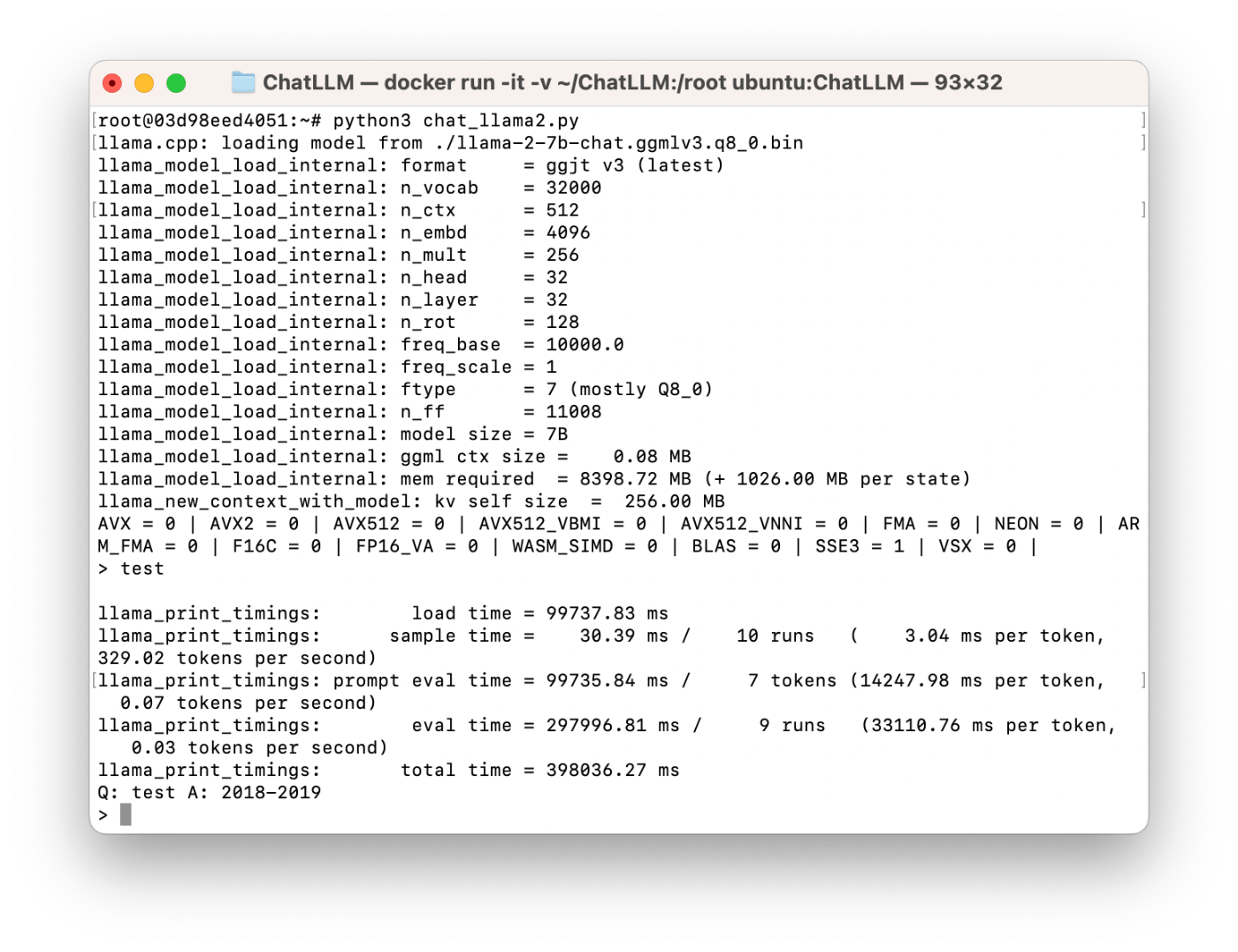

セットアップ方法は、以下参照ください。Linux/Windows前提です。Mac(Apple Silicon)では残念ながら今のところ動きませんでした。 Macでも動きますが、時間が非常にかかるので実用的ではないです。

Dockerのイメージ作成(ビルド)まで実施したらOKです。

続いて量子化されたモデルllama-2-7b-chat.ggmlv3.q8_0.binをダウンロードします。

あとは、コンテナ内で以下を実行すればOKです。

root@hostname:/# cd /root

root@hostname:~# python3 llama2.py

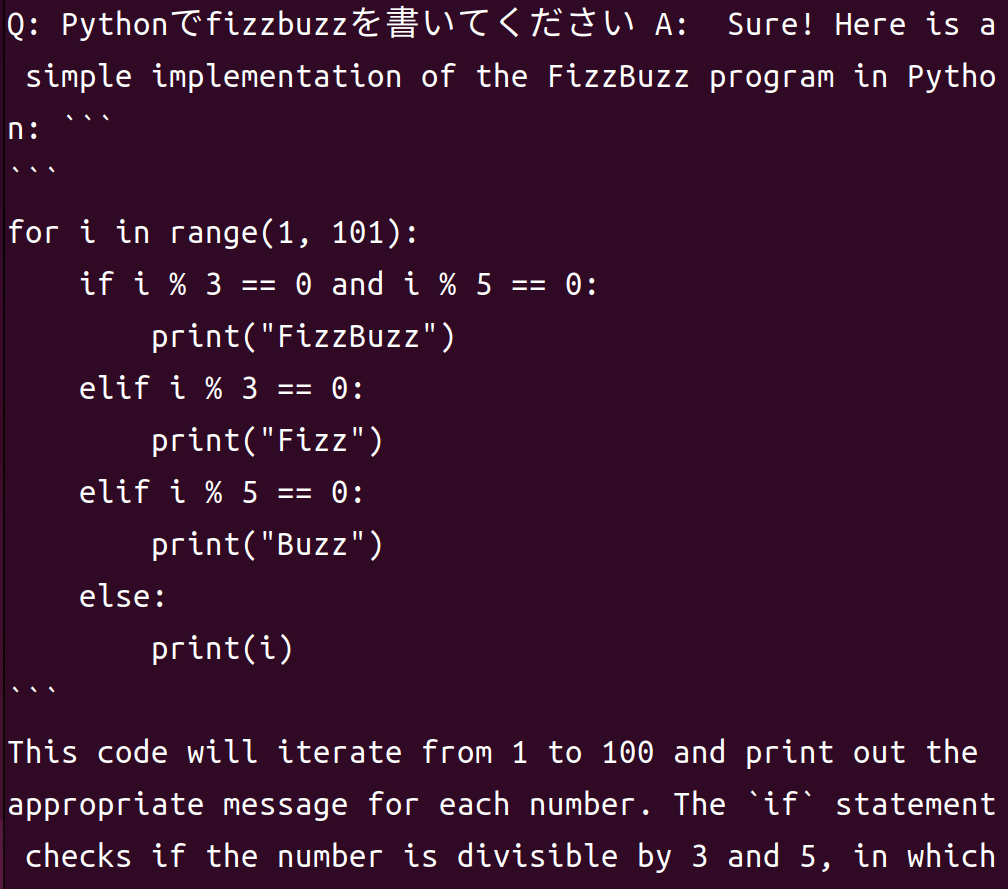

Llama 2の動作例

動作例です。感覚的には、同じサイズの他のLLMに比べると、期待もてる印象です。結構軽いのも嬉しいですね(軽量化されていることはありますが)。

今後、小さいPCにLLMをのせれるようになったら、色々可能性広がりそうですね。

Macでの動作

一応動きますが、1分以上かかるので、実用的ではないです。

まとめ

Llama 2を動かせたのでとりあえず記事にしてみました。

参考リンク

Discussion