日本語画像言語モデル「Japanese InstructBLIP Alpha」をGoogle Colabで動かしてみました

Japanese InstructBLIP Alpha

画像生成AI「Stable Diffusion」で有名なStability AIがリリースした、日本語向け画像言語モデルが「Japanese InstructBLIP Alpha」です。

用途は研究目的に限定されているようです。

「Japanese InstructBLIP Alpha」は研究目的で作成されたモデルであり、研究目的での利用に限定した公開となります。詳細は Hugging Face Hub のページをご確認ください。

というわけで研究目的(?)で触ってみます。

デモアプリを作る

既に偉大な先人(おなじみの方々)がやってらっしゃいました。

公式+これらの先人のコードを参考に、Google Colabで簡単に試せるノートブックを作ってみました。GradioというWeb UIのPythonライブラリを使っています。

009_japanese_instruct_blip_alpha.ipynb

Google Colabは多分課金が必要で、A100というGPUを選択して動かしています(CPUやV100ではダメでした)。

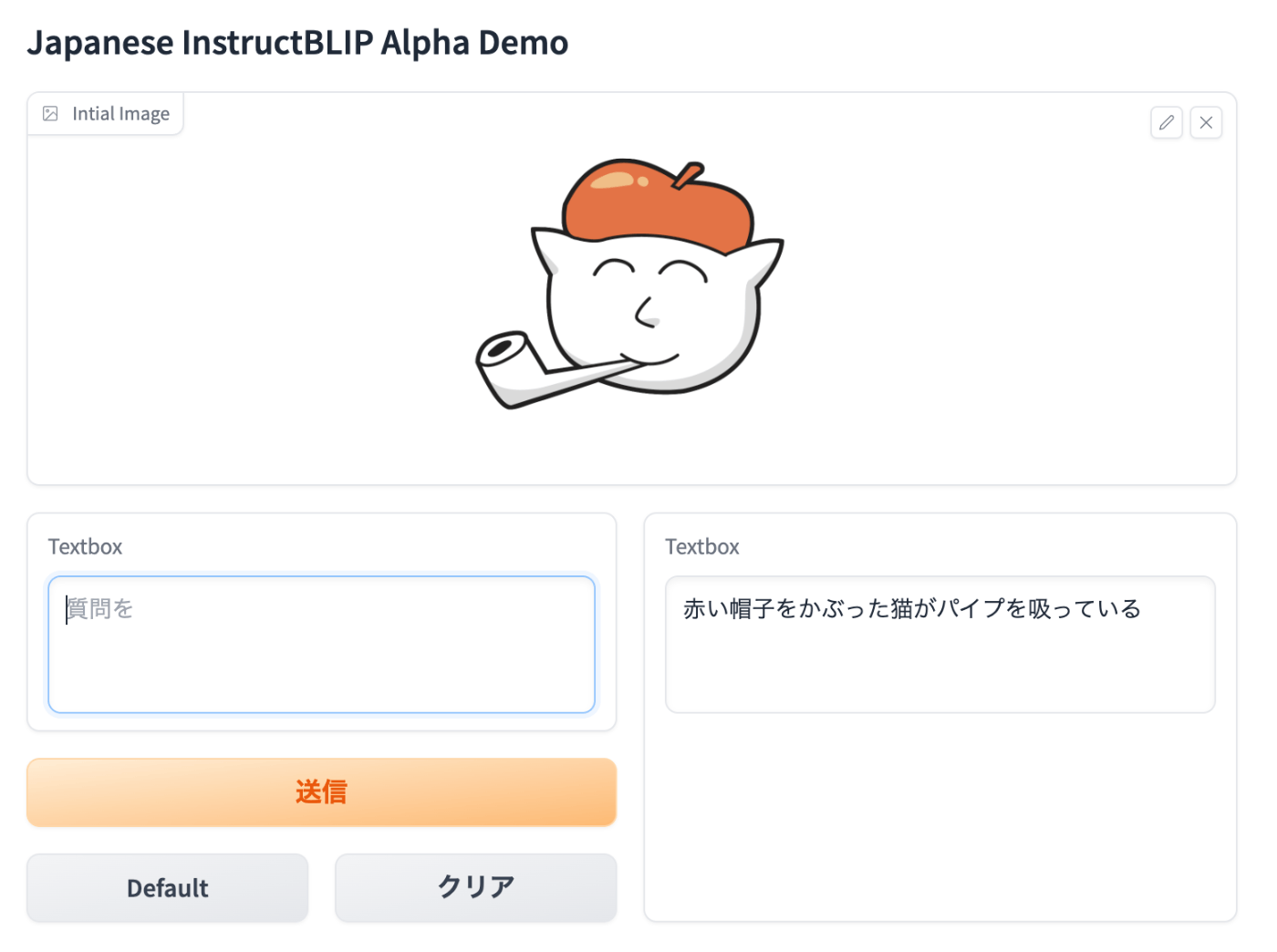

ノートブックを最後まで実行して、表示されるURLをクリックすると、デモ画面が表示されます。

画像をドラッグ&ドロップして、質問すると画像について教えてくれます。

テスト結果

デフォルト(空欄)で質問すると、画像に対して詳しく説明してくれます

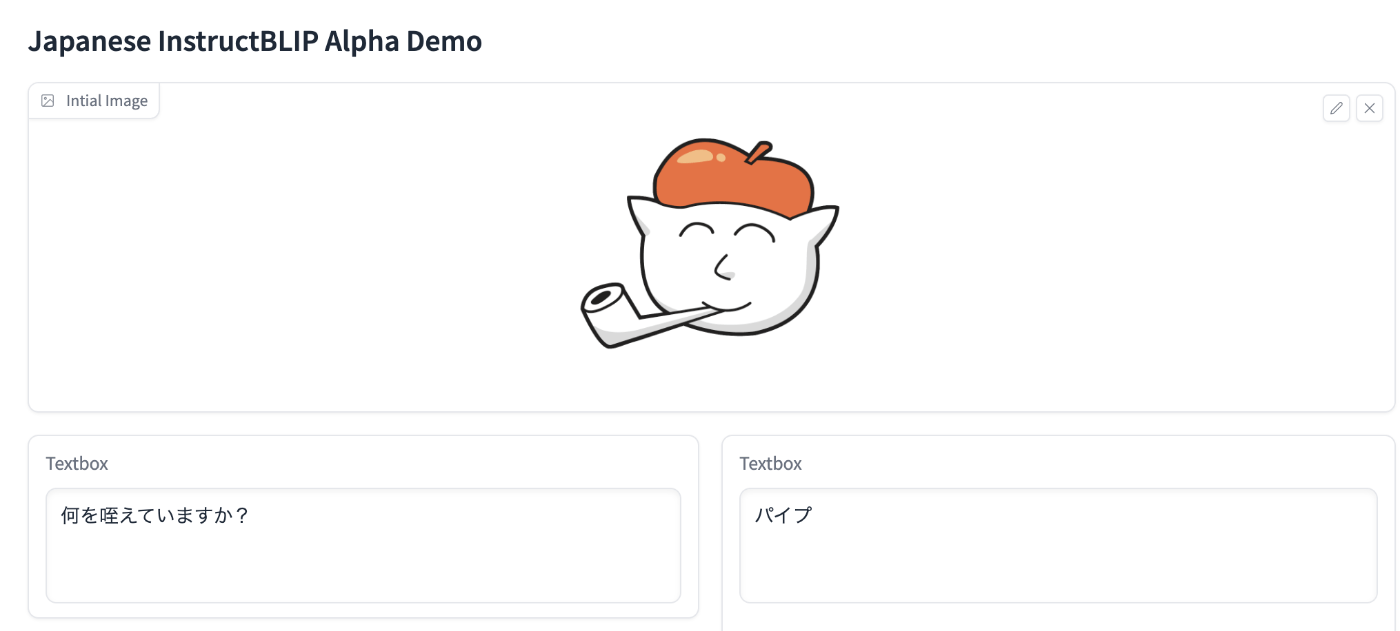

画像について質問すると答えてくれます

まとめ

性能高くて色々使えそうです。研究用途限定なのがちょっと残念ですね。

Google Colabだとモデルダウンロードの時間がストレスなので、ほんとうはローカルで動かしたいのですが、ちょっと我が家のRTX 3060だとメモリ的に厳しそうですね。

小さくて商用可能なモデルが出てきたら、色々使い道広がりそうです。

009_japanese_instruct_blip_alpha.ipynb

関連記事

Discussion