LIFE 3.0

先日、AI Safety Tokyoにて『LIFE3.0』を題材にして勉強会を行いました。以下はそのレポートです。

LIFE 3.0について

Max TegmarkはAIや宇宙物理学を専門とする研究者で、現在はFuture of Life Instituteの所長を務めています。

同研究所では、AIという強力で、場合によっては人類の存続を脅かすほどのリスクを伴う技術を、ポジティブな方向へ導くための活動を行なっています。

『LIFE3.0』は、Max Tegmarkによる著書で、AGI(汎用人工知能)のリスクについて丁寧かつ分かりやすく説明しています。

序盤は幅広い読者層に向けたAIリスク議論への導入となっており、序章ではAGI開発によって起こりうる未来のシナリオを架空の物語として描いています。これにより、AIに馴染みのない読者でも直感的にイメージしやすくなっています。

また、「記憶とは何か」「計算とは何か」といったAIの基本原理についても、分かりやすい比喩を交えながら丁寧に解説しています。こうした工夫によって、一見難解に見えるAI研究の最前線の議論を整理し、読者を自然にその議論の核心へと導いています。

後半では、議論の中心に踏み込み、AIがもたらすリスクについて具体的に論じています。雇用・兵器への悪用・セキュリティといった社会的課題にも触れながら、「AIにとって何が問題なのか」を多面的に掘り下げています。

勉強会の風景

今回の勉強会では、話を一方的に進めるだけでなく、参加者同士が考えを共有できるよう三つのワークショップを行いました。

-

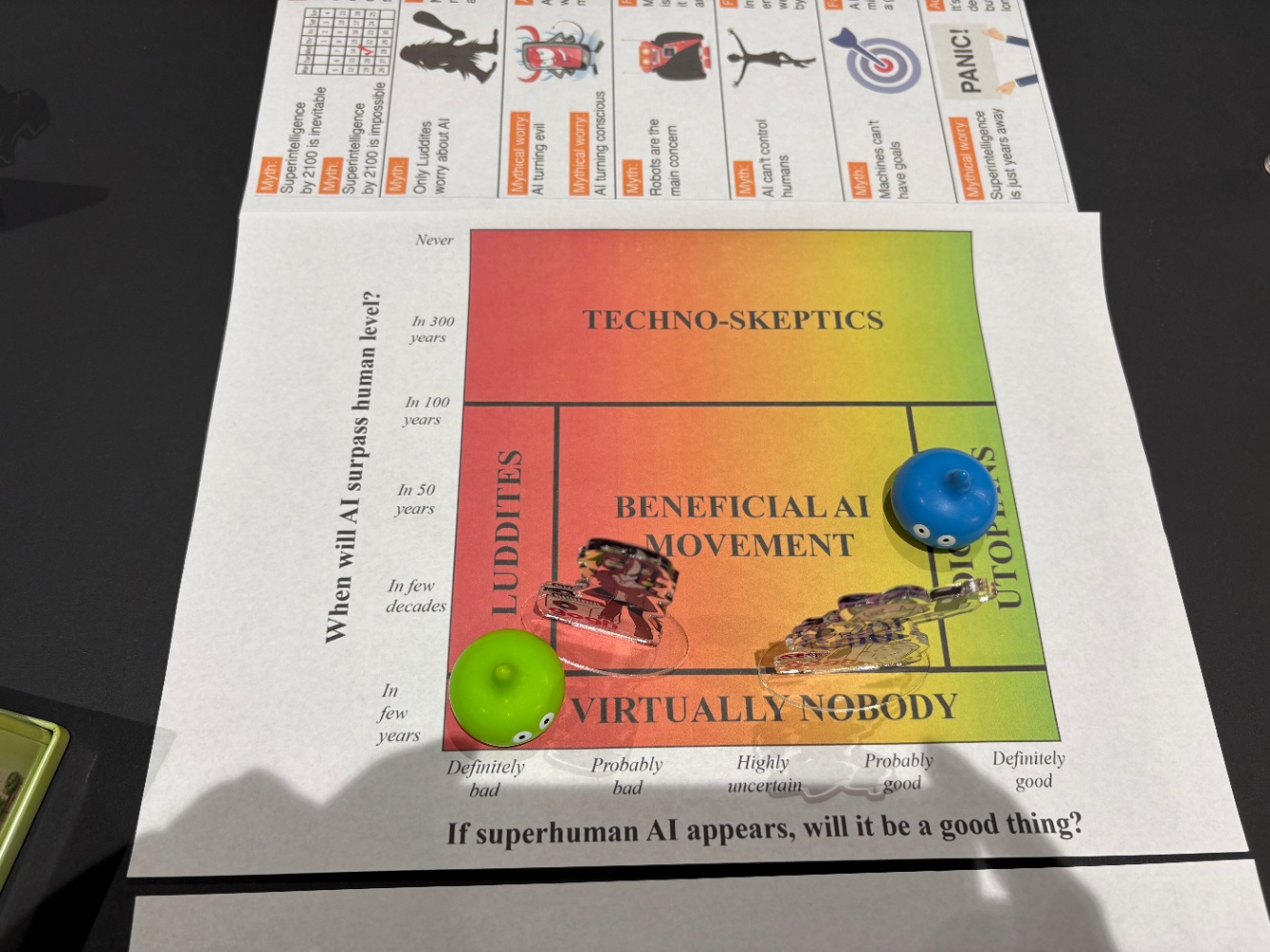

AGI予想マップ

横軸に「AGIによって起こる結果のポジティブ/ネガティブ」、縦軸に「AGIが達成される時期」をとり、参加者一人ひとりが自分の考えをマップ上に配置しました。これにより、AGIに対する見方の違いを視覚的に把握することができました。

-

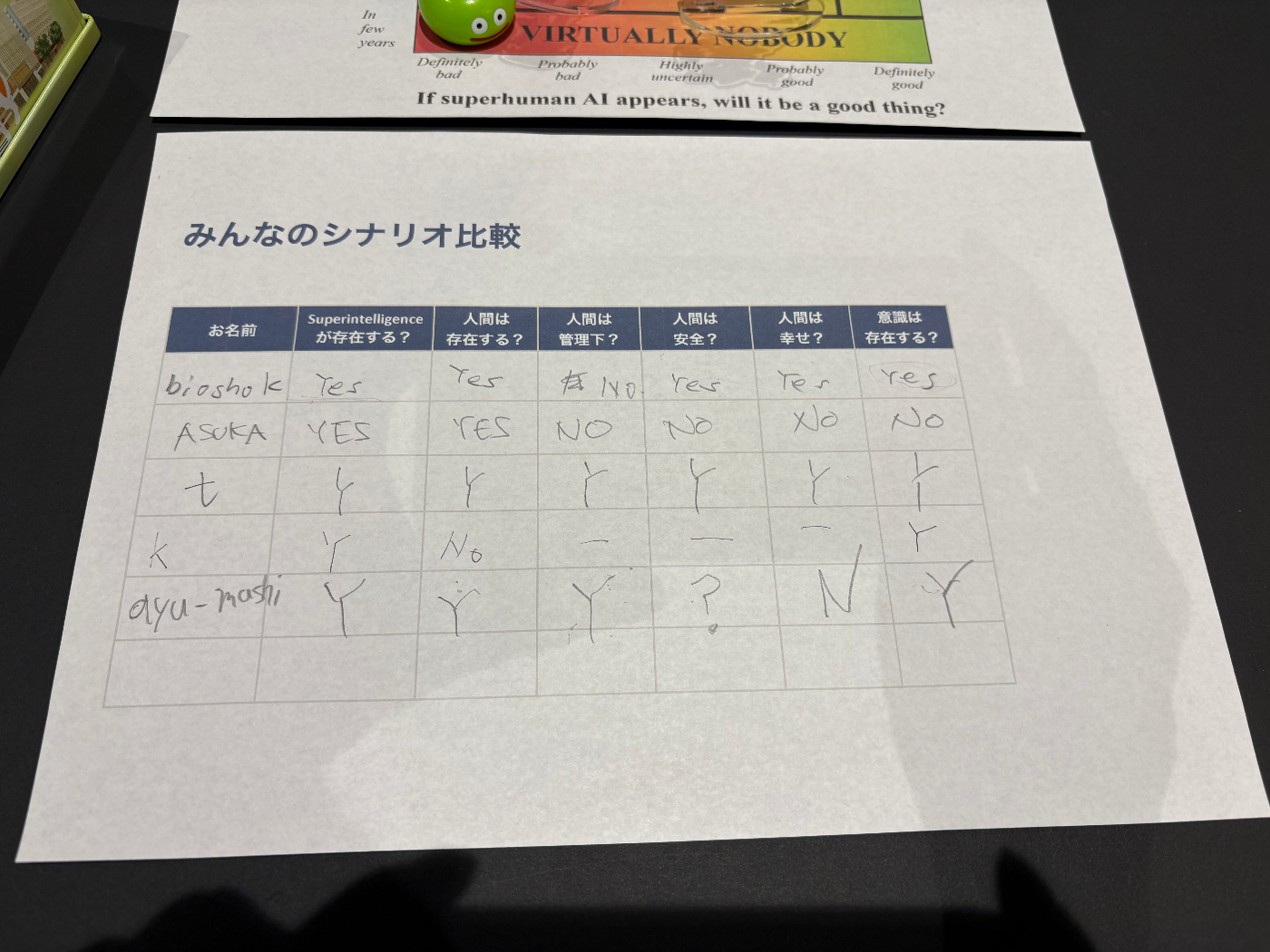

AGIシナリオ表

AGI達成後の社会がどのようになっているかについて、いくつかの設問に答え、それぞれが描くシナリオを比較しました。

AI Safety Tokyoでは、AI Safetyについて理解を深めるため、定期的に勉強会を開催しています。

AI Safetyに関心のある方は、次回の勉強会に参加してみませんか?

取り上げてほしいテーマの提案も歓迎しています!

Discussion