【AI】AWS AIF / MLA / MLSで学習したことを全てまとめる

はじめに

クラウド上で機械学習を実践するスキルを体系的に学ぶために、AWSが提供している3つの認定コース 「AIF(AI Practitioner)」「MLA(Machine Learning Associate)」「MLS(Machine Learning Specialty)」 をすべて受講・学習しました。

- AIF:AI・MLの基本概念とAWSのAIサービスを理解する入門編

- MLA:AWS上での機械学習ワークフローを学ぶ中級編

- MLS:モデル設計・最適化・運用まで深掘りする上級編

本記事では、それぞれのコースで得られた知識・理解した概念を整理します。

※全て書けていないため、随時更新

機械学習の3つの方法

教師あり学習

事前に正しいデータを大量にインプット。以降は事前にインプットしたデータのルールやパターンから正解の予測を行う。

分類

入力データをあらかじめ定義されたカテゴリーに分類する教師あり学習の手法。

回帰

入力データから連続的な数値を予測する教師あり学習の手法。

教師なし学習

ラベルのないデータからパターンや構造を見つけ出す手法。

例) ティッシュを買う人はコーラを買う人が多いなど

クラスタリング

データポイントを類似性に基づいて、グループに分類する、教師なし学習の手法。

購買履歴や年齢、性別など、似た行動パターンを持つ顧客をグループ化。

次元削減

多次元のデータを重要な情報を保持しながら低次元のデータに落とし込む手法。

高解像度の画像を低解像度にして処理を早くする。

強化学習

AIが出す推論の結果に対して、評価を繰り返し与えることで、どのような結果を出してほしいかを示し、行動を学習させる手法。

例) ロボットで掃除するときに、どのルートだと多くのゴミを取れるかなど

生成AI

基盤モデル

大量かつ多様なデータで学習され、様々なタスクに応用できる汎用的なAIモデルのこと。

基盤モデルの代表例

LLM:大規模言語モデル

大量の言語データとディープラーニング技術によって構築されたモデル。言語処理に特化したモデル。プロンプトと呼ばれる命令を出すとテキストで返信や回答を生成。

拡散モデル

画像生成に特化したモデうr。テキストから画像を生成したり、既存の画像を編集できる。

マルチモーダルモデル

テキスト、画像、動画など、複数を同時に処理できるモデル。

用語集

トークン

生成型AIモデルが操作する入力と出力の基本単位であり、単語、部分語、またはその他の言語単位を表す。

バイアス調整

既存のモデルに新しいデータを追加して微調整することでトレーニング済みモデルをゾロから作成するコストと時間を削減。

責任あるAI

潜在的なリスクや悪影響を軽減しながら、AIシステムが透明で信頼できるものであることを保証する実践と原則のこと。

生成的敵対的ネットワーク(GAN)

既存データを元に新しいデータを生成するためのモデル。

生成ネットワーク(データを生成する役割)と識別ネットワーク(生成データが本物かどうかを判断する役割)の2つのブウbんから構成される。

これにより、実際のデータに非常によく似た高品質なデータを生成することができる。

画像生成やデータ拡張、プライバシーを保護したデータ共有など、様々な用途で広く活用されている。

XGBoost

主に分類や会期のタスクに使用される勾配ブースティングアルゴリズム。

勾配とは、残差が少しでも小さくする方向のことで、XGBoostは残差を徐々に小さくするように学習を進める。

アンサンブル学習

複数モデルを学習させて多数決で予測値を出すこと。

例) ランダムに60%の正解率である分類ができるモデうが3つあるとする。このモデルを3つ使って多数決で予測すると正解率は65%弱に上がる。

アンサンブル学習に使うモデル

弱学習器

単独で使うと精度が低い学習器。(ランダムよりも多少は良いくらい)

ブースティング

直列にモデルを学習していく。

学習したモデルがうまく予測できなかった学習データに重みを附田モデルを学習するというのを繰り返していく。

残差ニューラルネットワーク

深層学習におけるニューラルネットワークアーキテクチャの一種で、主に非常に深いネットワークにおける学習困難の問題を解決するために設計。

決定木

機械学習における教師あり学習アルゴリズムの一つで、データを分類または予測するためのツリー構造のモデル。人間の意思決定プロセスを模倣しており、質問を繰り返しながら最終的な判断を下すような仕組みになっている。

線形回帰

一つの目的変数(予測したい値)と一つ以上の説明変数(予測に使うデータ)との間の線形(直線的な)関係をモデル化し、将来の値を予測すること。

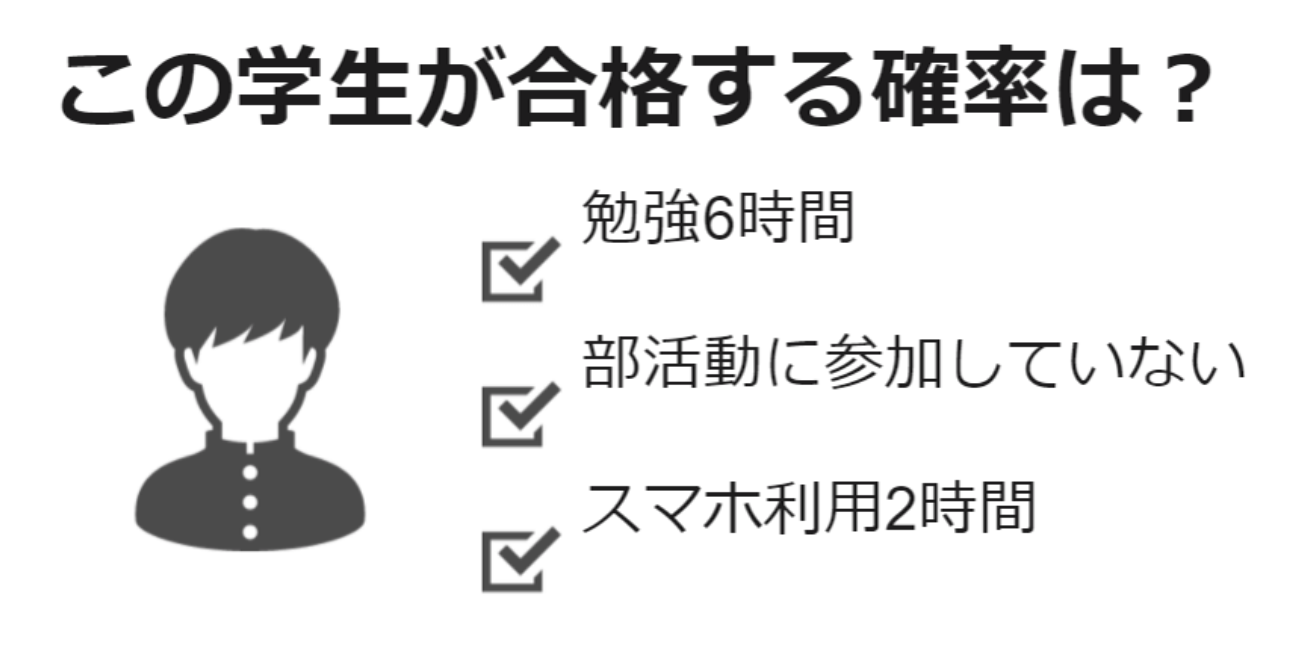

ロジスティック回帰

いくつかの要因(説明変数)から「2値の結果(目的変数)」が起こる確率を説明・予測することができる統計手法。

2値とは、試験の合格・不合格のように答えが2つしかない値のこと。

各変数に明確な重みを割り当てることが可能で、これらの重みを調整する子で予測結果に影響を与えられる。

脱獄

システムやモデルの安全機能を回避して意図的に制約された操作を行う手法。

承認付き侵入テスト

組織の承認を受けてセキュリティの脆弱性を評価する手法。

ファジング

モデルやシステムが異常入力や意図しないデータにどのように反応するかを評価うするために使用されるテスト。

特徴エンジニアリング

モデルの入力データを最適化するプロセス。トレーニングフェーズでの性能向上を目的としている。

毒性

AIモデルの出力が攻撃的、不適切、差別的、または有害な内容を含む場合に使用される表現。

盗用

生成型AIを使用して作成されたコンテンツを適切な引用や出典を明記せずに利用する行為。

幻覚

AIが事実とは異なる情報を生成する状況

探索的データ分析

新しいデータセットの特性を理解し、パターン、異常、相関を特定するための初期ステップ。この段階では、相関行列や統計情報の計算、データの視覚化を通じて、データの分布や傾向を把握する。

ハイパーパラメータ

機械学習モデルの外部で設定され、学習プロセスに影響を与えるパラメータ。

フォトリアリスティック

生成された画像やデザインが、まるで本物の写真のようにリアルに見えることを指す。生成型AIモデルが得意とする分野であり、ディティールや光の反射、影などを忠実に再現s塗ることで、人間が見ても違和感のない高品質な画像を生成。

Top K値

LLが生成するトークンの中から選択する候補すうを制限するもの。

温度

モデルの応答や多様性やランダム性を調整するためのパラメータ。

コンピュータビジョン

画像や映像を解析して意味のある情報を抽出するAI技術であり、製品検査のようなタスクに特に適している。

インテント検出

自然言語処理の分野における技術の一つで、ユーザーが発話やテキストで伝えたい「意図(インテント)」を理解し、識別するプロセス。

例) 「明日の天気はどうですか?」 -> 天気情報の確認

ベンチマークデータセット

モデルがどれだけ正確に仕事をしているかを確認するためのあらかじめ用意されたチェックリストのようなもの。

様々なケースが含まれており、「特定の人やグループに偏ったt発言をしていないか」や「差別的な内容を生成していないか」などを調べるテストが含まれている。

生成型事前訓練トランスフォーマー(GPT)

自然言語処理(NLP)分野で用いられるモデルで、自然言語を理解し、それを元に構造化されたクエリを生成する能力を持っている。

サポートベクターマシン

分類や回帰分析を目的としたモデル。

データを分類する際に、最適な境界線(ハイパープレーン)を見つける。

ROUGEスコア

AIが作った文章(生成文)が、人間が作った理想的な手本(リファレンス文)にどれだけ似ているかを測るための指標。

BERTScore

生成されたテキストとリファレンステキストの間の類似性を測定するための評価指標。テキストの意味的な一致度を高精度で評価可能。

ROC曲線下面積(AUC)スコア

主に分類タスクにおけるモデルの性能を評価する指標。

真陽性率と偽陽性率の関係を示すROC曲線の下の面積を計算。

F1スコア

制度と再現率の調和平均を計算する指標。

特に、不均衡なデータセットで有効で、微調整されたLLMの性能を判断するために重要な指標となる。

実世界知識(RWK)スコア

LLMが学習した事実や常識的な情報を実用的な文脈でどれだけ正確に活用できるかを評価するために、複数のベンチマーク(標準化されたテスト)を総合して得られるスコア。

プロビジョニングスループット

モデルが安定した推論性能を提供できるように、リソースを予約して管理する仕組み。必要なリソースを確保して、カスタムモデルを効率的に活用できる。

名付きエンティティ認識

テキストデータから固有名詞や特定のエンティティを抽出する手法。

インペインティング

画像の欠損部分を補完する技術。

バイナリ分類モデル

与えられたデータを二つの異なるクラスのどちらか一つに分類するために設計されたモデル。

センチメント分析

テキストデータから感情や意見の傾向を自動的に検出・分類する自然言語処理の一分野。

埋め込み

現実世界のオブジェクトや概念を数値表現に変換する技術。この数値表現により、AIモデルは意味的な関係やパターンを理解しやすくなり、自然言語処理のタスクにおいて高い精度を実現できる。

少数ショットプロンプト

モデルに新しいタスクを迅速に適応させる方法。

例)「入力:[文章]、出力:[要約]」のように、どのようにデータを処理し、結果を出すべきか。

CGF(Classifier Free Guidance)

生成タスクにおいて特定のプロンプトに基づいた生成物の忠実性を高める方法。このスケールを増やすことで、生成された画像が入力プロンプトに対してより具体的かつ詳細な内容を反映するようになる。

混同行列

分類モデルのパフォーマンスを評価する際に非常に有用。

この表はmモデルが正しく分類したケース(真陽性・真陰性)と誤った分類結果(偽陽性・偽陰性)をまとめて表示。

これにより、モデルがどの程度正確か、あるいはどの種類の誤りが発生しているかを把握することができる。

R2スコア(決定係数)

回帰によって導いたモデルの当てはまりの良さを表現する値で、モデルによってと即した値が実際の値とどの程度一致し知恵るかを表現する評価指標。

平均二乗誤差(MSE:Mean Squared Error)

各データに対して「予測値と正解値の差」の二乗値を計算し、その総和をデータ数で割った値を出力する関数。

モデレーションAPI

画像やテキストコンテンツを分析し、不適切な内容や特定の条件に合致するものを検出するために設計。

例) 成人向けコンテンツや暴力的な画像の排除など。

バイリンガル評価代役(BLEU)

翻訳モデルの精度を評価するために広く使用されている指標。

生成された翻訳テキストを基準となる正確な翻訳と比較し、一致度を測定。

要約評価のための想起重視代役(ROUGE)

要約モデルの性能評価に使用される指標。

生成テキストと基準テキストの間で共有される単語やフレーズの一致を測定する。

転移学習

事前学習済みのモデルを再利用し、新しい関連タスク用に適応させるための戦略。

BERT

文脈を考慮して単語やフレーズを理解し、欠落した部分を推測する能力に優れる。

コンテキストウィンドウ

基礎モデルが一度に処理できるトークンの量を指す。1つのプロンプトに含められる情報量は、ウィンドウサイズに制約される。

正確度

分類問題において、全体のデータに対する正しい予測の割合を示す評価基準。

R-squaredスコア

回帰モデルの性能を評価するために使用され、予測値が観測値にどれだけ近いかを示す。

k近傍(k-NN)

データポイントの近隣にある他のポイントのラベルに基づいて分類を行う。

部分依存プロット(PDP)

特定の特徴量がモデルの予測にどのような影響を与えるかを可視化するためのツール。

フューショット学習

事前に訓練された大規模モデルが新しいタスクに対して少量の例示データのみで適合し、高い性能を発揮する。

インコンテキスト学習

モデル自体は変更せず、プロンプトエンジニアリングを通じてモデルの動作をカスタマイズする手法。追加のトレーニングを必要としないため、一般的に最もコスト効率が高い。

深層強化学習

エージェントが環境と相互作用しながら、試行錯誤を通じて最適な行動方式を学習する手法。

エージェントは行動をとり、環境からフィードバックを受け取られることで学習を進める。

プロンプトチェーン

複雑なタスクを複数の小さなステップに分解し、それぞれのステップに対して適切なプロンプトを連鎖的に使用する技術。

Discussion