3D Gaussian Splatting 派生手法 まとめ

初めに

昨今3D分野で大注目を集めている3D gaussian splattingについて調べています.

2024/02/11に公開されたサーベイ論文「3D GAUSSIAN AS A NEW VISION ERA: A SURVEY」が,3D-GSの基本的な説明からその派生手法,応用手法に関してまとめている良いサーベイ論文でしたので,その内容を抜粋してまとめています.

- 公開年: 2024/02/11

- 組織: FudanUniversity, Nanyang Technological University

- URL: https://arxiv.org/abs/2402.07181

Abstract

- このサーベイ論文はタイトルの通り3DGaussianSplatting(3D-GS)に関するサーベイ論文です.

- 3D-GSは,NeRFとは異なり,Nerural networkに依存していないため,明示的なシーン表現と新規ビューの合成が可能なことが特徴的です.

- 3D-GSは,ロボティクス・都市マッピング・自動運転ナビゲーション・VRなど様々な分野での応用が進んでいます.

1. Introduction

3DGaussianSplattingは,高い詳細レベルで複雑なシーンを効率的にレンダリングするための強力なアプローチ.オブジェクトと表面をガウス分布の集合として表現することで,ジオメトリと外観特性の効率的かつ正確な表現を可能にしている.GaussianSplattingは,被写界深度やソフトShadowなどの様々な視覚効果のリアルなレンダリングを可能にした.

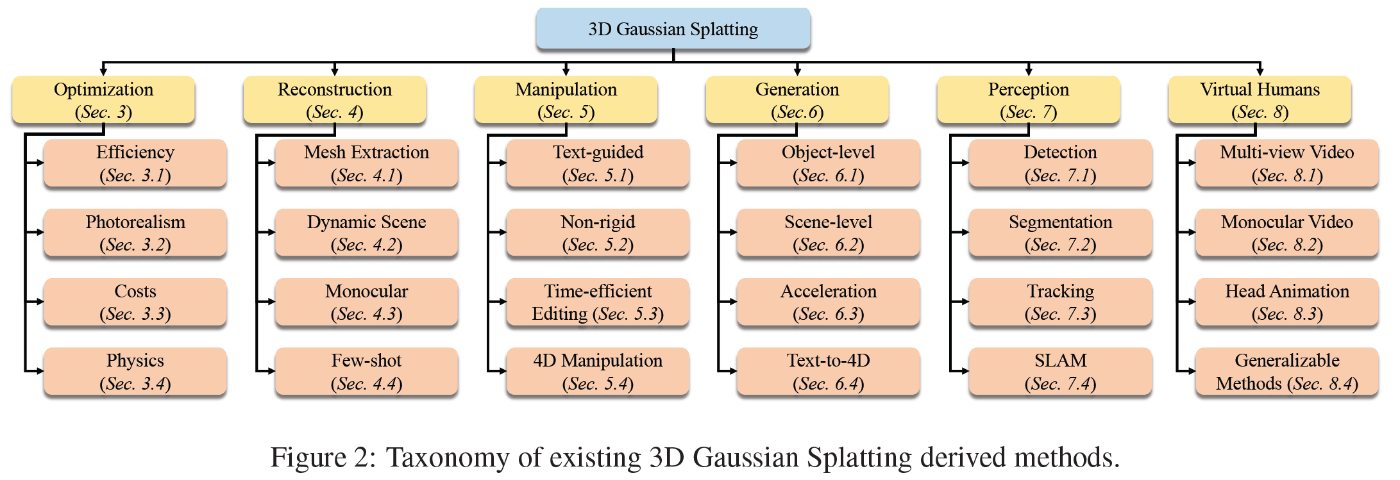

この論文の概観.

- Section2: 3D Gaussian Splattingの背景知識について紹介

- Section3: レンダリング効率,レンダリングされた画像のリアリズム・コストなど,3D-GSの最適化に関する方法を体系的にレビュー.

- Section4: メッシュ再構築の方法をレビュー

- Section5: 3D-GSを使うための技術を要約

- Section6: オブジェクトレベル・シーンレベルの視点から,3D生成方法を検討.

- Section7・8: 認識及び人間のbodyに対する応用に関して要約.

- Section9: 3D-GSの将来の方向性に関して議論.

2. Background

3D-GSは,明示的なradiance fieldベースのシーン表現手法であり,3Dガウス分布を用いてモデル化された大量の3D anisotropic ballsでradiance fieldを表現する.

それぞれのanisotropic ballは,平均

このシーン表現において,ビューのレンダリングはポイントスプラッティングによって実行.具体的には,シーン内のすべてのガウス球体が最初に2D画像平面に投影され,その色は球面調和関数パラメータから計算される.次に,最終画像の各16px × 16pxパッチに対して,ぱっちよ交差する投影されたガウスが深度順にソートされる.パッチ内のそれぞれのピクセルについて,そのピクセルを覆うすべてのガウスの不透明度と色を深度順にalpha合成して色が計算される.

上式で

💡 ポイントスプラッティングとは何か.

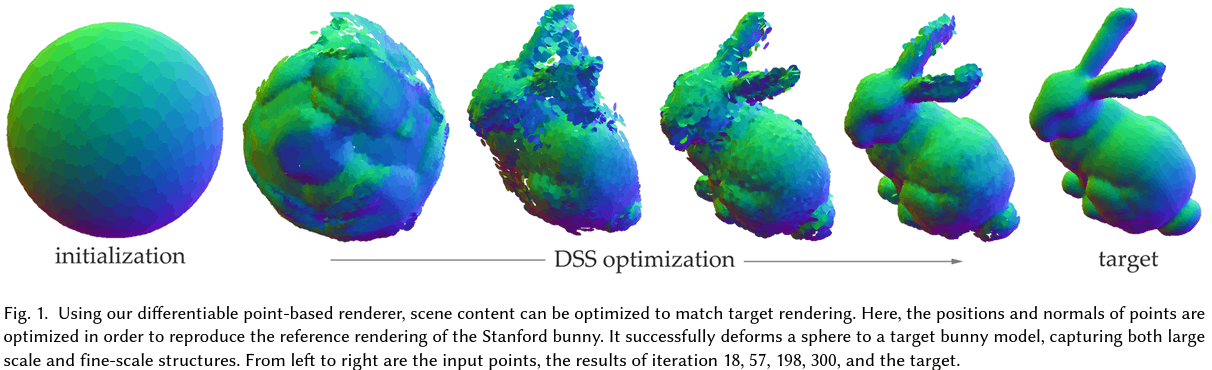

Differentiable Surface Splatting for Point-based Geometry Processing

Differentiable Surface Splatting(DSS)は,ポイントクラウドのための高忠実度微分可能レンダラー.

Differentiable Surface Splatting for Point-based Geometry Processing

3. Optimization of Gaussian Intrinsic Properties

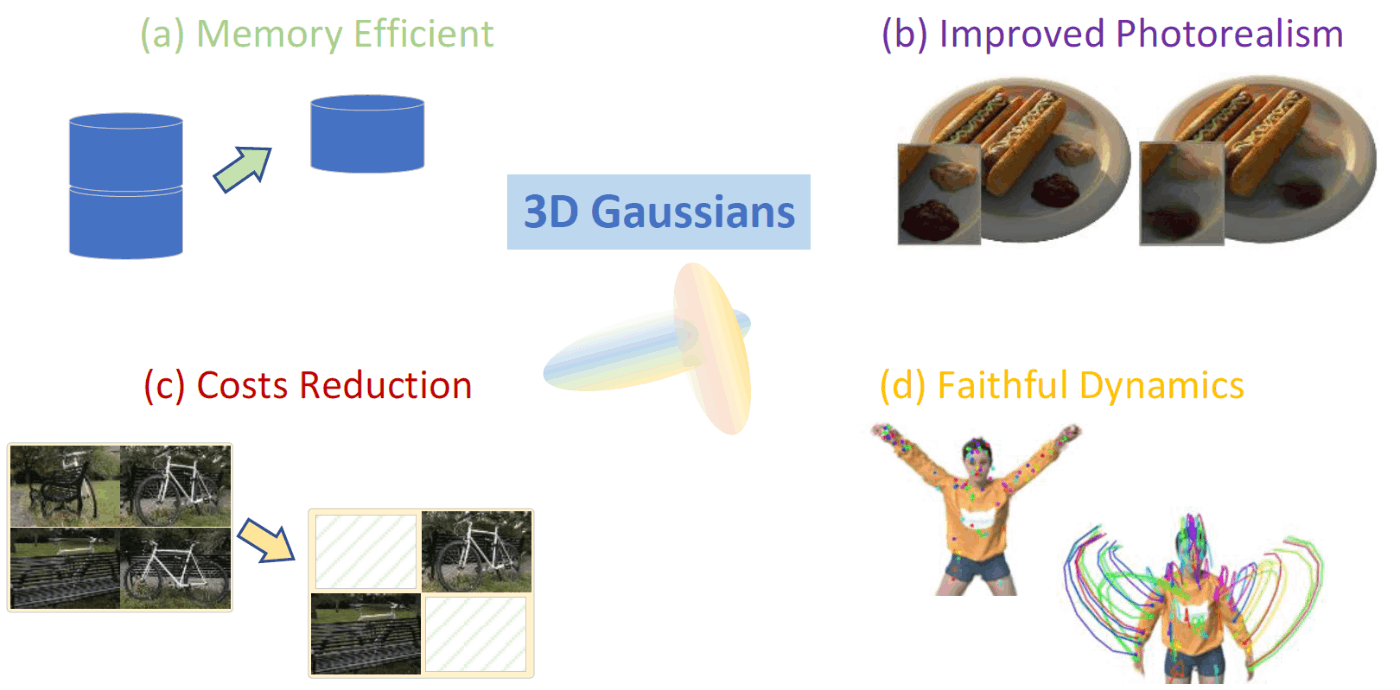

3D-GSの4つの派生研究を紹介.

3.1. 効率

一つのシーンを表現するために数百万のガウスのパラメータを必要とするが,リアルタイムレンダリングにとって品質を維持したままパラメータ数を削減することはとても重要.

- Scaffold-GS

- グリッドガイドNeRFに触発されて開発された速度とメモリ効率を改善したGS.

- CompGS

- ベクトル量子化(VQ)を採用して3Dガウスのパラメータを圧縮した研究.

- LightGaussian

- こちらも軽量化に関する研究.

3.2 Photorealism

スプラッティングプロセス中に発生する「エイリアシング問題」「アーティファクト」の解決は,レンダリングされた画像の品質とリアリティを向上させるために有効であり,さらにシーン内の販社のリアルさをさらに向上させることができる.

- Multi-scale 3d gaussian splatting for anti-aliased rendering

- Mip-splatting: Alias-free 3d gaussian splatting

- Relightable 3d gaussian: Real-time point cloud relighting with brdf decomposition and ray tracing

- フォトリアリスティックレンダリングのためのフレームワークを導入.

- 簡略化されたDisney BRDFモデルを採用

- Neilf: Neural incident light field for physically-based material estimation.

- Gaussianshader: 3d gaussian splatting with shading functions for reflective surfaces

- 鏡面特性と反射面を持つシーンのリアリズムをさらに強化.

- 光-表面の相互作用を明示的に考慮し,かなり低い時間コストで高品質のレンダリングのためにレンダリング方程式の簡略化された近似を組み込みんだ

- Gs-ir: 3d gaussian splatting for inverse rendering

- 3D-GSを逆レンダリングに導入するGS-IR

3.3. Costs / 3.4 Physics

一旦省略!

4. Reconstruction

以下の3つの応用に関する研究を紹介.

4.1 Surface Mesh Extraction

- Sugar: Surface-aligned gaussian splatting for efficient 3d mesh reconstruction

and high-quality mesh rendering.- 3Dメッシュ再構築と高品質メッシュレンダリングのためのSuGaR

- ガウスとシーンの表面との整合性を促進するための正則化項を組み込んで学習し,ポアソン再構築法を使用してこの整合性を活用し,ガウスからメッシュを抽出.

- SuGaRはガウスとメッシュの両方をガウススプラッティングレンダリングを使用して最適化するため,品質低下が課題.

- Neusg: Neural implicit surface reconstruction with 3d gaussian splatting

guidance- 高度に詳細な表面回復を実現するためにNeuSと,3D-GSを共同で最適化するNeuSG

- 複雑なディテールを持ったsurface meshを生成することができる.

4.2 Monocular and Few-shot Reconstruction

- Few-shot 3D Reconstruction

- pixelsplat: 3d gaussian splats from image pairs for scalable generalizable 3d reconstruction

- 画像ペアから3Dシーンの再構築を行う.

- Triplane meets gaussian splatting: Fast and generalizable single-view 3d reconstruction with transformers

- 明示的な点群と暗黙的なトライプレーンフィールドを組み合わせたハイブリッド表現であるTriplane-Gaussianを使用して単眼ビューからの3Dオブジェクト再構築

- pixelsplat: 3d gaussian splats from image pairs for scalable generalizable 3d reconstruction

- 単眼 3D Reconstruction

- 画像内の遠近法の関係・テクスチャ・モーションパターンの慎重な分析が鍵.

- Splatter image: Ultra-fast single-view 3d reconstruction.

- 単眼3Dオブジェクト再構築のための超高速アプローチであるSplatter Image

- 2D CNNアーキテクチャを利用して画像を効率的に処理し,各ピクセルがカラー3Dガウスで表される擬似画像を予測する

- Neural parametric gaussians for monocular non-rigid object reconstruction.

- 単眼ビデオから動的オブジェクトを再構築するためのNeural Parametric Gaussians (NPGs)

4.3 Dynamic Scene Reconstruction

3D-GSの高いレンダリング則とと解像度は,トラッキングや大規模都市シーンの再構築を含む動的シーンの再構築をサポートできる.

- Gaussian-flow: 4d reconstruction with dynamic 3d gaussian particle

- 迅速な動的3Dシーンの再構築とリアルタイムレンダリングを実現

- 静的および動的3Dシーンのセグメンテーション,編集,合成が容易になった

- Deformable 3d gaussians for high-fidelity monocular dynamic scene reconstruction

- 標準空間で学習された3Dガウスと変形フィールドを使用して単眼動的シーンをモデル化するための可変形3D-GSメソッドを提案

- 実世界のデータセットの時間補間タスクの滑らかさに対する不正確なポーズの影響を軽減するためのアニーリングスムージングトレーニングメカニズムを組み込んでいる

- Periodic vibration gaussian: Dynamic urban scene reconstruction and real-time rendering

- 複雑な幾何構造と無制限のダイナミクスを持つ大規模シーンをモデル化する課題に対処するための統一された表現モデルであるPeriodic Vibration Gaussian (PVG)

- 周期的振動ベースの時間ダイナミクスをシームレスに統合し、時間的連続性と適応制御のための革新的なメカニズムを考案

5. Manipulation

3DGSの明示的な特性(NNとは違って?)は編集タスクと非常に相性がいい.そのため,望ましい制約を適用して3Dガウスを直接操作することにより,3Dシーンを簡単に編集でき

<省略>

5.1. Text-guided Manipulation

- Text and image guided 3d avatar generation and manipulation.

- Towards high-fidelity text-guided 3d face generation and manipulation using only images

- Faceclipnerf: Text-driven 3d face manipulation using deformable neural radiance fields

- Gaussianeditor: Editing 3d gaussians delicately with text instructions.

- 3Dガウスとテキスト指示を使用した3Dシーンの精密な編集のためのGaussianEditor

5.2 Non-rigid Manipulation

非剛性オブジェクトは,形状を変えたり変形したりできるやわらかいオブジェクト.

そのため,変形と挙動のより正確な描写とともに,高い真正性を提供する.そのため,非剛性オブジェクトのリアルタイムインタラクションに対しては慎重に扱う必要がある.

- Deforming radiance fields with cages.

- Manus: Markerless hand-object grasp capture using articulated 3d gaussians

- Gart: Gaussian articulated template models

5.3 Time-efficient Editing

- Control4d: Dynamic portrait editing by learning 4d gan from 2d diffusion-based editor.

- 露出した領域のインペインティングを通じてシーンオブジェクトのインタラクティブな操作を可能にした.

5.4. 4D Manipulation

- Control4d: Dynamic portrait editing by learning 4d gan from 2d diffusion-based editor.

- Sc-gs: Sparse-controlled gaussian splatting for editable dynamic scenes.

- シーンの動きを疎制御点とMLPと組み合わせてモデル化することを提案. シーン内の動きは、疎な基底の集合からなるコンパクトな部分空間によって効果的に表現できるという理解を活用した.

- Cogs: Controllable gaussian splatting.

- 動的シーン操作のためのControllable Gaussian Splatting (CoGS)

- NeRFや他のニューラルメソッドとは異なり,CoGSは明示的な表現を利用し動的シーンのリアルタイムかつコントローラブルな操作を可能にする.CoGSの明示的な性質はレンダリング効率を高めるだけでなく,シーン要素の操作を簡素化する.

6. Generation

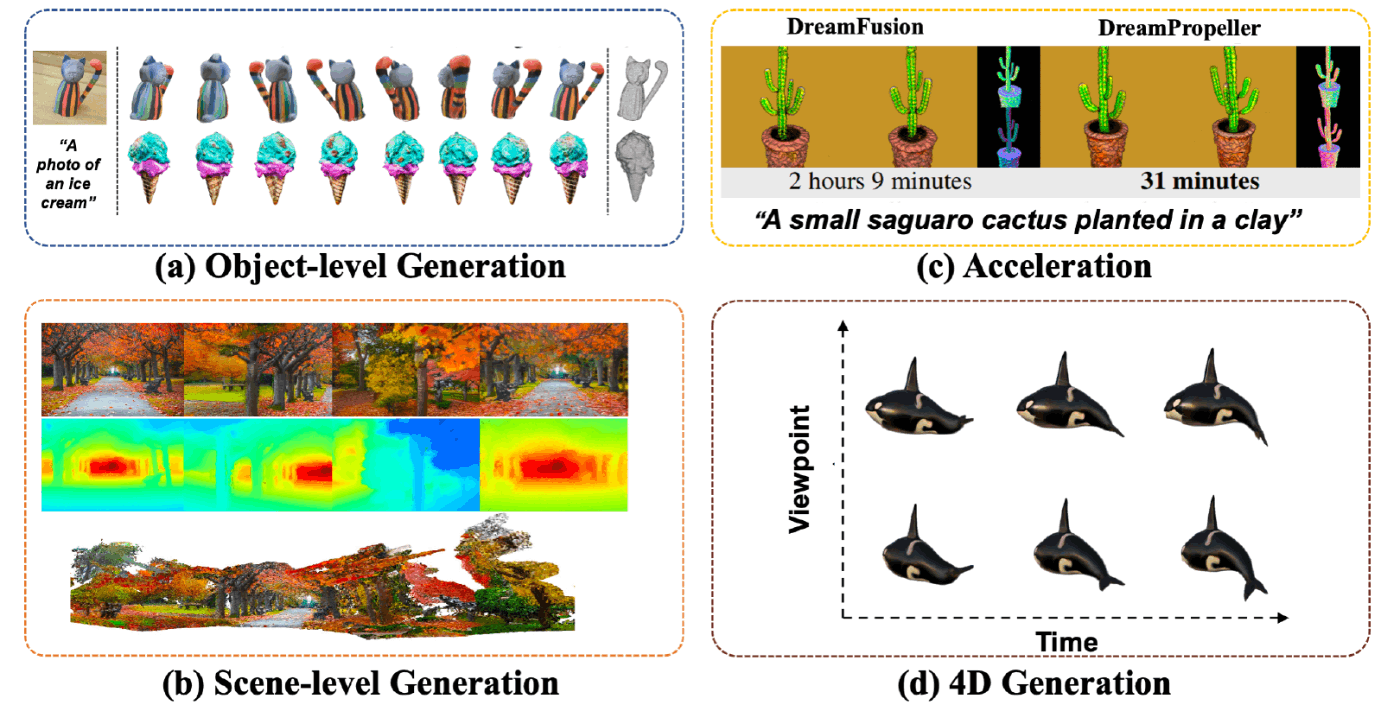

6.1 Object-level 3D Generation

- Gaussiandreamer: Fast generation from text to 3d gaussian splatting with point cloud priors

- 3D diffusion modelと3D GSを組み合わせた手法.

- 大規模なシーンを生成することは苦手.

- Text-to-3d using gaussian splatting

- 通常のSDS損失と,追加の3Dポイントクラウド拡散事前知識を使って生成をガイド祖,Janus問題を緩和することを提案.最初にカスタマイズされた形状またはテキストからポイントクラウドへの拡散モデルPoint-Eから3Dガウスを初期化し,ジオメトリ最適化ステージで2Dおよび3D SDS損失の組み合わせで表現を最適化する.外観の精緻化ステージでは,コンパクトネスベースの密度増加戦略が繰り返し実施され,ジオメトリの連続性を向上させ忠実度を改善.

💡 janus problem

- Re-imagine the negative prompt algorithm: Transform 2d diffusion into 3d, alleviate janus problem and beyond.

6.2. Scene-level 3D Generation

- Cg3d: Compositional generation for text-to-3d via gaussian splatting

- テキスト入力のみから物理的にリアルなシーンを形成するためにスケーラブルな3Dアセットを合成的に生成する

- シーン内の各オブジェクトをガウスのセットで表現し,オブジェクトを回転・平行移動・スケールなどの相互作用パラメータを持つ合成座標に変換

- LucidDreamer

- テキスト・RGB・RGBDなど様々なタイプの入力からドメインフリーで高品質な3Dシーンを作成することを提案

- 最初に点群を初期化し,その後DreamingとAlignmentプロセスを通じて点群を精緻化し,ガウススプラットの最適化のためのSfMポイントを形成.Dreamingプロセスは、部分的に投影された画像を完成させて新しい3Dポイントを作成し,それらを3D空間に持ち上げる一方でAlignmentプロセスは新しい3Dポイントを既存の点群にシームレスに接続する.

- Text2Immersion

- テキストプロンプトから一貫して没入感のあるフォトリアリスティックなシーンを2段階の3Dガウス最適化で生成

6.3. 3D Generation Acceleration

DreamGaussianは単一ビュー画像からわずか2分で高品質のテクスチャメッシュを生成できる.

6.4 Text-to-4D Generation

- Align your gaussians: Text-to-4d with dynamic 3d gaussians and composed diffusion models

- Gaussian Splattingを用いた,4D生成.

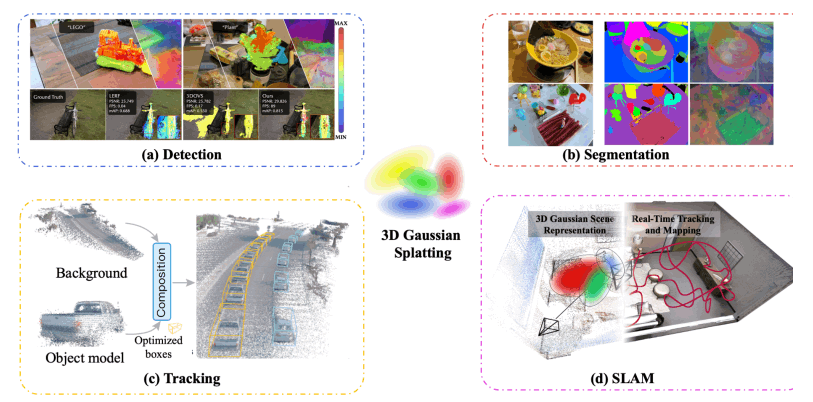

7. Perception

7.1 Detection

- Language Embedded 3D Gaussians

- Foundation Model Embedded Gaussian Splatting (FMGS)

- Multi-Resolution Hash Encodings (MHE)

7.2. Segmentation

-

Gaussian Grouping

- オープンワールドの3Dシーンに対して,再構築とsegmentationを同時に行う.

-

Segment Any 3D Gaussians (SAGA)

- インタラクティブな3Dシーンセグメンテーションのために,SAMを統合した.

7.3 Tracking

- DrivingGaussian

- 運転シーンの再構築をするための3D-GS.

最後に

自分の興味はだいたい7章くらいまでだったのでここで一旦ストップしました.

今後飛ばした部分なども追記していくかもしれません.

この論文自体,3D-GSの応用手法を考えている人にとってかなり有用な論文だと思いました.

気になったからはぜひ原文も読んでみてください.

Discussion