2025年のmacOSにおけるローカルLLM開発に必要な7つのツール

Large Language Models (LLM)をローカルで実行する能力は、AI開発を大きく変革しました。特にmacOSを使用している私たちにとって、プライバシー、コスト管理、オフライン機能が無比の利点をもたらします。しかし、2025年にこの力を最大限に活用するためには、モデルファイルだけでは不十分で、強力なツールキットが必要です。AI駆動のアプリケーションを構築するにせよ、プロンプトを微調整するにせよ、**Retrieval Augmented Generation (RAG)**を試すにせよ、適切なローカルセットアップが重要です。

クラウドAPIに依存し続けるのはもうやめましょう。さあ、今年、macOS上でローカルLLM開発ワークフローを強化するために必要な7つの必須ツールについて詳しく見ていきましょう。これらは、より効率的、強力、そして楽しい開発を実現します。

1. ローカルLLMへのゲートウェイ

どんなツールか:

これは、最新のオープンソースLLM(例えば、Llama 3、Mistral、Gemma 2、Phi-3など)を直接ローカルでダウンロード、設定、実行するためのオープンソースツールです。コマンドラインインターフェースとローカルAPIエンドポイントを提供します。

重要な理由:

これにより、ローカルでLLMを簡単に試すことができます。モデル管理の複雑さを抽象化し、異なるモデルを迅速に切り替えることができます。AI開発者にとっては、ほとんどのローカルLLM作業の基盤となります。

ワークフローへの影響:

数分で強力なローカルLLMのプロンプトを開始できます。異なるモデルのアーキテクチャやサイズを迅速にテストできます。ローカルAPIを使用して、カスタムアプリケーションとのシームレスな統合が可能です。

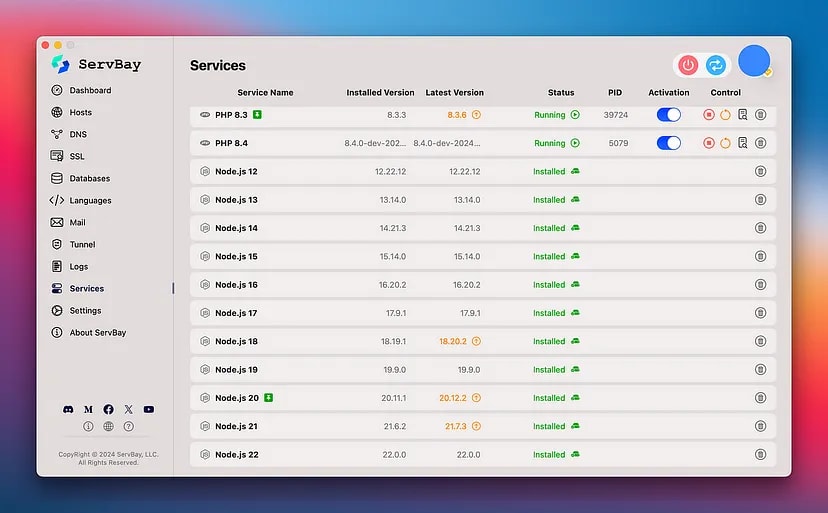

2. 統合ローカル開発環境

どんなツールか:

ローカルでのLLMモデルの実行を管理するためのオールインワンのローカル開発環境です。Python、Node.js、PostgreSQL、MySQL、Webサーバー(Nginx、Caddy)など、多くの開発ツールを一元管理できるGUIを提供します。

重要な理由:

AIアプリケーションは単独で存在することはほとんどなく、バックエンドのPython(Flask/Django)やNode.js API、さらにはRAGのためのデータベースが必要です。これにより、サービスがバージョン間で衝突することなく、簡単に管理できます。

ワークフローへの影響:

ワンクリックでのセットアップ、異なるバージョンのPHP、Python、Node.jsを簡単に切り替えることができ、データベース管理が可能です。ローカルAIスタックのコントロールパネルとして機能します。

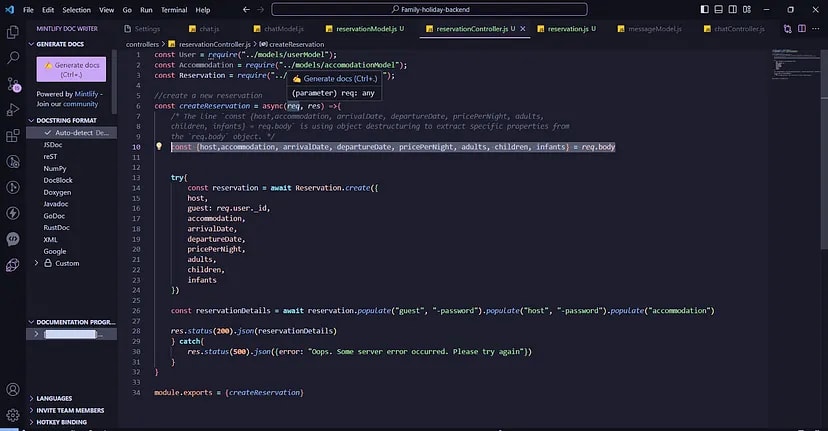

3. VS Code + AI拡張機能:あなたのコーディングコックピット

どんなツールか:

Visual Studio Codeは高速で柔軟性があり、AI開発に不可欠な拡張機能が豊富です。GitHub Copilotや、LangChainやLlamaIndexなどのフレームワークツールキットが含まれます。

重要な理由:

PythonやJavaScriptでローカルLLMとやり取りするためのコードを書くこと、AIアプリのフロントエンドを作成すること、または複雑なプロンプトを設計するすべての作業がここで行われます。

ワークフローへの影響:

コード開発が速くなり、品質が向上し、LLMの機能をプロジェクトに統合しやすくなります。

4. インタラクティブLLMプレイグラウンド

どんなツールか:

CLI経由でモデルを実行するツールに加えて、LibreChatやLobeChatなどの使いやすいチャットベースのインターフェースでローカルで実行しているLLMと対話できます。

重要な理由:

迅速なプロンプトエンジニアリング、モデルの反応のテスト、そしてコードを使わずに対話できる専用UIは非常に貴重です。

ワークフローへの影響:

プロンプトの反復やモデルの評価が大幅に速くなり、LLMの機能を示すのが簡単になります。

5. RAG用ローカルベクトルストア

どんなツールか:

**Retrieval Augmented Generation (RAG)**を構築するために必要なベクトルデータベース。軽量でローカルで開発が簡単に行えるオープンソースオプションが存在します。

重要な理由:

これにより、LLMに特定のプライベートデータを与えることができ、ローカルでベクトルDBを使用して知識ベースをプライベートに保ちます。

ワークフローへの影響:

RAGパイプラインをローカルで開発し、テストできます。異なる埋め込み戦略や文書の分割を実験し、クラウドベースのDBに依存することなく開発できます。

6. ローカルLLM APIのマスタリング

どんなツールか:

ローカルLLM(通常はlocalhost:11434で提供されるAPI)とやり取りするために、BrunoやPostmanなどのツールを使用します。

重要な理由:

ローカルAPIとのインタラクションを構造化し、プロンプトやパラメータを自動的にテストできます。

ワークフローへの影響:

ローカルLLM APIとのインタラクションを効率的にデバッグし、テストを自動化することができます。

7. AIプロジェクトのバージョン管理

どんなツールか:

GitやGitHub、GitLabなどのバージョン管理ツールを使い、コードだけでなくプロンプトやモデル設定、データセットなども管理します。

重要な理由:

AIの再現性は重要であり、プロンプトやパラメータ、コードをバージョン管理することが実験の追跡、以前のバージョンへの復元、チーム内での共同作業に役立ちます。

ワークフローへの影響:

実験の安全ネットとなり、AIプロジェクトでのチームワークを促進し、プロンプトやモデル設定の進化を記録します。

2025年、MacでのローカルLLM開発は非常に力強いものとなります。Ollamaを使用してモデルを直接扱い、ServBayを使って開発環境を管理することで、AI開発を効率的かつプライベートに行うことが可能です。

このツールキットを使えば、アイデアからAI駆動のアプリケーションへの移行が迅速に行え、すべてのデータが安全で、ワークフローがスムーズに進行します。

ローカルLLM開発で使用しているツールは何ですか? コメントでシェアしてください!

Discussion