OpenAIのFine-tuningについて調べる

Fine-tuningの説明。By Bing

Fine-tuningについて、高校生にもわかるように説明します。

Fine-tuningとは、機械学習の一種で、すでに学習済みのモデルを新しいデータに合わせて調整することです¹²⁴。

例えば、あなたが顔写真を生成するモデルを作りたいとします。しかし、顔写真をたくさん集めるのは大変です。そこで、すでに顔写真をたくさん学習したモデルがあるとします。このモデルは一般的な顔写真を生成できますが、あなたが好きな芸能人やキャラクターの顔写真は生成できません。

そこで、Fine-tuningを使います。あなたは、好きな芸能人やキャラクターの顔写真を少しだけ集めます。そして、学習済みのモデルにそのデータを追加して再学習します。すると、モデルは新しいデータに合わせて調整されて、好きな芸能人やキャラクターの顔写真も生成できるようになります。

Fine-tuningのメリットは、新しいデータが少なくても良いことです。すでに学習済みのモデルがあれば、その知識を活用して新しいタスクに対応できます。Fine-tuningの難しさは、どのくらい調整するかを決めることです。調整しすぎると元の知識が失われてしまいますし⁵ 調整しなさすぎると新しいタスクに対応できません。

以上がFine-tuningの説明です。

ソース: Bing との会話 2023/3/12(1) Fine-Tuning in Machine Learning - Metaphysic.ai. https://metaphysic.ai/fine-tuning-in-machine-learning/ アクセス日時 2023/3/12.

(2) Fine-Tuning in Machine Learning - Metaphysic.ai. https://metaphysic.ai/fine-tuning-in-machine-learning/ アクセス日時 2023/3/12.

(3) Fine-tuning (machine learning) - Wikipedia. https://en.wikipedia.org/wiki/Fine-tuning_(machine_learning) アクセス日時 2023/3/12.

(4) [2202.10054] Fine-Tuning can Distort Pretrained Features .... https://arxiv.org/abs/2202.10054 アクセス日時 2023/3/12.

(5) What is Fine Tuning in Machine Learning? - reason.town. https://reason.town/what-is-fine-tuning-in-machine-learning/ アクセス日時 2023/3/12.

ファインチューニングを行うことで、APIで利用できるモデルをより多く利用することができます。

- プロンプトデザインよりも高品質な結果が得られる

- プロンプトに収まりきらないほどの例題をトレーニングする能力

- プロンプトの短縮によるトークンの節約

- 低レイテンシーリクエスト

GPT-3は、インターネット上にある膨大な量のテキストを対象に事前学習を行っています。GPT-3は、インターネット上の膨大なテキストを対象に学習済みで、数個の例文が与えられただけで、何をしようとしているのか直感的に理解し、もっともらしい完了文を生成することが可能です。これを "数撃ちゃ当たる学習 "と呼ぶ。

ファインチューニングは、プロンプトに収まらないほど多くの例で学習することで、数発学習を改善し、様々なタスクでより良い結果を得ることができます。モデルのファインチューニングが完了すると、プロンプトで例を提供する必要がなくなります。これにより、コストを削減し、より低レイテンシーのリクエストを可能にします。

ファインチューニングは、高いレベルで次のようなステップを踏みます。

- トレーニングデータの作成とアップロード

- 微調整された新しいモデルをトレーニングする

- 微調整されたモデルを使う

ファインチューンドモデルのトレーニングや使用料の請求方法については、価格ページをご覧ください。

価格

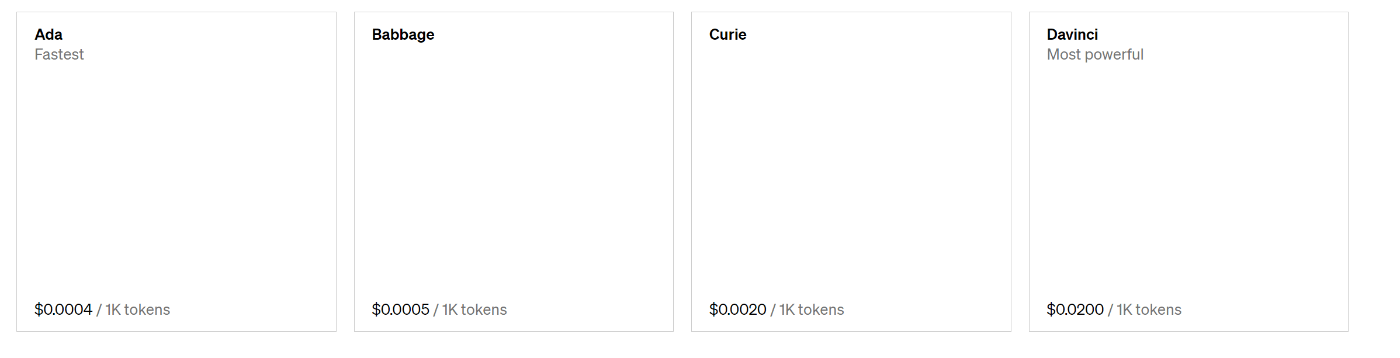

Language models

複数のモデルがあり、それぞれ機能と価格帯が異なる。価格は1,000トークンあたりの価格です。トークンは言葉の断片と考えることができ、1,000トークンは約750ワードに相当します。この段落は35トークンです。

Chat

ChatGPTのモデルは対話に最適化されています。gpt-3.5-turboの性能はInstruct Davinciに匹敵します。

gpt-3.5-turbo $0.002 / 1K tokens

InstructGPT

インストラクターモデルは、1回転の指示に従うように最適化されています。Adaは最速のモデルで、Davinciは最もパワフルなモデルです。

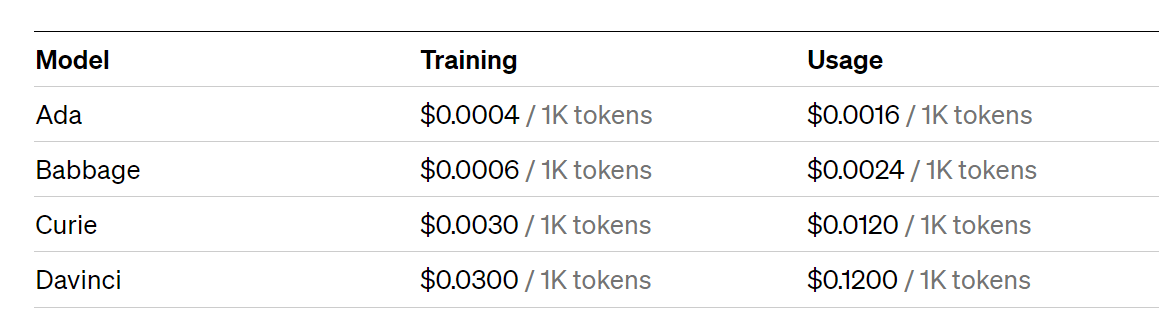

Fine-tuning models

ベースモデルをお客様のトレーニングデータで微調整することで、独自のカスタムモデルを作成することができます。モデルを微調整した後は、そのモデルへのリクエストで使用したトークンに対してのみ課金されます。

Embedding models

エンベッディングを利用して、高度な検索、クラスタリング、トピックモデリング、分類機能を構築することができます。

fine-tunedが可能なモデルとは?

現在、Fine-tuningが可能なのは、以下のベースモデルのみです:Davinci、Curie、Babbage、およびAda。これらは、トレーニング後のインストラクション(例えばtext-davinci-003のようなもの)がないオリジナルモデルです。また、ファインチューニングしたモデルにデータを追加していくファインチューニングを、一からやり直すことなく継続することが可能です。