Datadog Inferred ServicesによるLLM APIの監視

LLM API監視におけるDatadog Inferred Services活用法

株式会社IVRyでAIエンジニアとして働いているMoriyaです。

弊社は、電話上で動くAI自動音声サービスを提供しています。ECSで動くApplicationからLLM APIを呼び、sidecarとしてDatadog Agentを使っています。

弊社のようにLLM APIをリアルタイムで扱うサービスでは、latencyやerrorの把握が重要です。

弊社では、色々なLLM API監視ツールを試しましたが、いろいろな課題がありました。本記事では、これらの課題を解決するために、Datadog Inferred Servicesを利用する方法について解説します。

他のツールの課題感

-

多様なAPIを監視する際の限界

LLM APIを簡易に監視する方法の1つとして、Datadog LLM observabilityが挙げられます。Datadog LLM observabilityを使うと、OpenAI API、Gemini APIをかなり容易に監視できます(参考)。しかしながら、Datadog LLM observabilityが非対応のAPIは監視できない、といった点は、課題感として挙げられます。 -

litellm経由での呼び出し時の問題

litellmのように、LLM APIをwrapするライブラリを使用していると、うまく監視できないケースが多数あります。例えば、OpenLITを使うと、Gemini APIなど、様々なAPIを監視できます。しかし、litellm経由でGeminiを呼ぶ際は、litellmとしてラベリングされてしまいます。そのため、それぞれのAPIの状況を把握できません。 -

導入の手間

OpenTelemetryをDatadogで監視しようとすると設定が複雑だったりと、導入自体が複雑なツールも存在し、初期設定や運用が煩雑になる場合があります。 -

LLM APIのinput・outputは見れなくても良い

弊サービスにおいては、LLM APIのlatency・errorが確認できれば、LLM APIのinput・outputを見れなくても不都合は無いと感じていました。

Datadog Inferred Servicesとは

Datadog Inferred Servicesは、直接計測していないデータベースやサードパーティAPIなどとの依存関係を、外部へのリクエストを分析することで自動的に検知してくれる機能です。これにより、サービス間の依存関係とmetricsを包括的に把握することが可能です。この機能を使うと、LLM APIのlatencyなどを簡単に取得できます。

APIごとにlatencyなどを確認できます。

Datadog Inferred Serviceの良いところ

-

シンプルなON/OFF操作

すでにDatadogを利用している場合、Agentの設定をONにするだけで、対象のAPIから発生する外部トラフィックの監視が自動で行われます。 -

全ての外部トラフィックを監視できる

あらゆるLLM API、そして、LLM APIに限らず、外部へのリクエスト全般を網羅的に監視できるので、簡易的にLLM APIを監視したい場合に非常に有用です。 -

アラートも簡単に設定できる

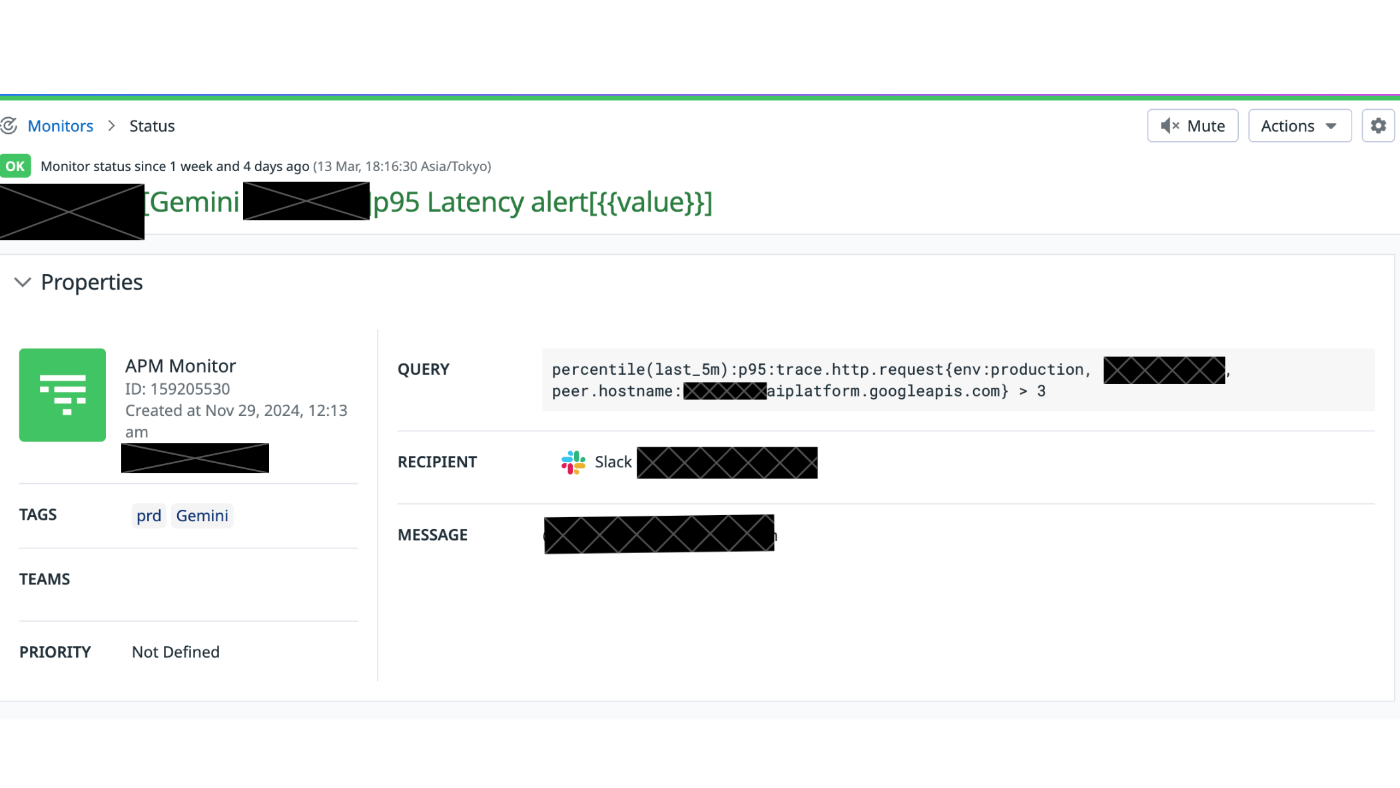

Datadogで集計しているmetricsなので、モニタリングアラートも簡単に設定できます。

実際、Datadog inferred servicesを使ったLLM APIの監視を行っていたことで発覚した問題も何件かありました。

今月の頭には、弊サービスが依存する外部APIがエラーを返しており、AIの応答に異常が起きていたのですが、エラー監視をしていたおかげで早期発覚することができました。

Datadog Inferred Serviceの欠点

-

API pathが同一だとモデルの区別ができない

唯一の欠点として、API pathが同一だとモデルの区別がつかない点が挙げられます。弊社では、この点を解決できる監視方法を試行錯誤しています。

まとめ

LLM APIのlatencyやerrorをシンプルに監視したい場合、Datadog Inferred Serviceは非常に有効なツールです。

- あらゆるAPIを監視できる、litellmによるラップ問題、導入の手間といった課題を解消

- 必要最低限の監視項目に絞ったシンプルな設定が可能

これにより、運用負荷を軽減し、問題発生時の迅速な対応が実現できます。ぜひDatadog Inferred Servicesを活用し、LLM APIの監視体制を強化しましょう。

最後に

IVRyでの開発に興味がある方は、以下のページを閲覧してみてください!

LLM APIを使ったプロダクト開発に興味がある方は、ぜひカジュアル面談などを申し込んでください。

Discussion