Google Antigravityをさわってみたよ、すごいよ

はじめに

うおー、Googleからやっと、やっと、エディタ出た!出ましたよ!うおー

と、初っ端から、うおうお言ってますが、みなさまこんにちは。

今回の記事の内容は、

待望のGoogleエディタ「Google Antigravity」でましたね!

そんな、Antigravityを遅ればせながら、うおー、触ってみたぜ!という記事になります。

実際にさらりと触っただけなので、書いている以外に無限の可能性があると思いますが、

個人的に「これがすごいぞ!」なポイントを3つご紹介していきます。GoGo!

Google Antigravityとは

まずは、Google Antigravityの概要です。

Google Antigravityは、Googleが新たに発表したエージェントファーストな開発プラットフォームです。現在、パブリックプレビューです。

従来のIDEと何が違うの?ってところをさっくり話すと、

従来のIDEは「人がコードを書く場所」でしたが、Antigravityは「エージェントがタスクを実行し、人が監督・協働する場所」という設計思想で作られています。

要するに、あちこちで頑張って働いてくれているAIたちを見守りやすい作りになってます。

また、ベースはVS Codeから作られていて、Windows、macOS、Linuxに対応しています。

エンジニアならVS Codeは、親の顔よりも見ていると思うので、Google Antigravityもすぐ馴染みます。実家です。

というか、Antigravityっていう名前はどういう願いが込められてるんですかね、Antigravityで我々エンジニアも宇宙進出しちゃいなヨ!ってことなんですかね。

Google Antigravity公式:

対応モデル

さて、一番気になるであろう、対応モデルから。

現在、以下のモデルが選択できます。

- Gemini 3 Pro (high)

- Gemini 3 Pro (low)

- Claude Sonnet 4.5

- Claude Sonnet 4.5 (thinking)

- Claude Opus 4.5 (thinking)

- GPT-OSS

Antigravityと同日に発表されて、すでにとても話題になっているGemini 3はもちろん、AnthropicのClaudeやOpenAIのモデルも使えます。

追加モデル

また、上記の対応モデルは、我々人間からの指示を聞いてもらう際に選択するモデルですが、

エージェントが内部的に使用するモデルには、以下もあるそうです。

- Nano Banana Pro

- Gemini 2.5 Pro UI Checkpoint

- Gemini 2.5 Flash

- Gemini 2.5 Flash Lite

つまり、エージェントが与えられたタスクに対して、

エージェントが自分で「あーこのタスクならこのモデルがよさそう」という具合に自動で使用してくれるモデル、ということですね。

公式ドキュメント:

プラン

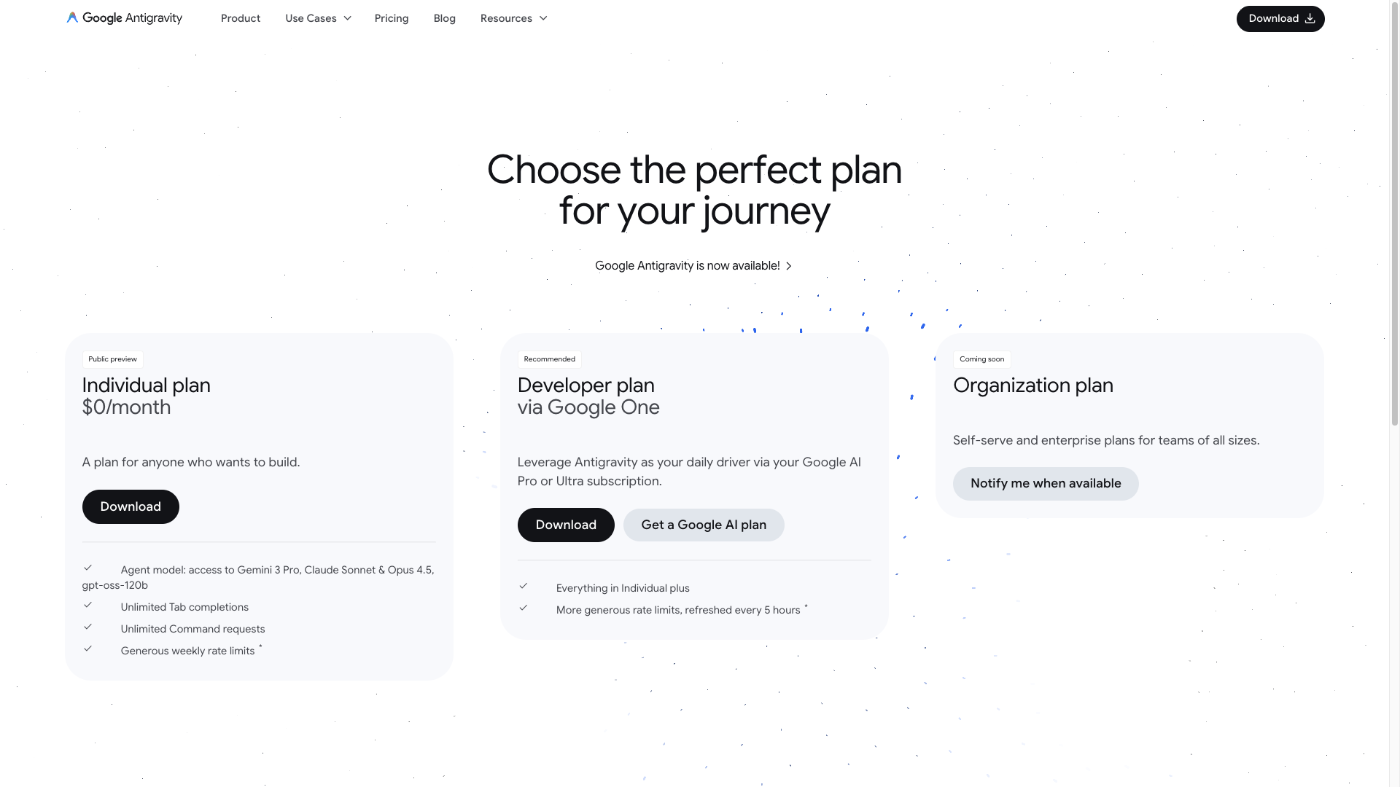

現在、Antigravityには3つのプランが用意されています。

- Individual plan:誰でも無料で使えるプラン

- Developer plan via Google One:Google AIのサブスクリプション経由で課金するプラン

- Organization plan:チーム向けプラン(まだ利用開始できず)

画像引用元:

私は、無料プランで使ってみてますが、無料プランでも結構自由に使えます。

まずは誰でも無料で試せるので、気になる方はぜひ!

MCP

最近は、猫も杓子もMCPですが、

当然、MCPにもバッチリ対応しています。

しかも、サポートされているMCPサーバというものもあり、

エディタビューからポチッとするだけですぐ使えます。設定ファイルをあれこれする必要なし。便利ですね。

どんなMCPサーバがサポートされているか気になる方は、公式ドキュメントを見てみてください!

公式ドキュメント:

個人的に「これがすごいぞ!」なポイント3つ

ということで、

ここからは、個人的に触ってみて特に「これがすごいぞ!」と思ったポイントを3つに絞ってお伝えしていきます。

お品書き

- ビューが2つ

- ブラウザ統合

- アーティファクト

1. ビューが2つ

まず、起動してみて一番最初に気づくであろう、AntigravityのUI(ウィンドウ)。

従来のIDEとは異なり、Antigravityには2つの独立したビューが用意されています。

今までは、当然人間オンリーが使いやすいエディタでしたが、

Antigravityは、エージェントと人間と一緒に働くこと前提とした設計で作られているので、2つのビューがあるってわけですね。

そう、いわゆる、AI駆動開発、エージェント駆動開発、向けにIDE作成しました!ってこと。

エージェント マネージャー ビュー:

エージェントを管理するためのビューです。要するに、AIたちの作業を一覧で見守る画面ですね。

複数のエージェントを同時に走らせて、それぞれ違うタスクをやってもらって、その様子を見守ることができます。

ここで「こういうの作って」って大まかに指示を出して、エージェントの進み具合や成果物(後で説明するアーティファクトとか)を確認する感じ。

公式ドキュメント:

エディター ビュー:

いつものVS Codeっぽい、コードを書いたり編集したりするビューです。

ワークスペースのフォルダや、エージェントが作ったファイルが表示されて、自分で直接いじったり、コードの途中でエージェントに「ここ直して」って指示出したりできます。

VS Codeベースなので、VS Codeの拡張機能もそのまま使えます。うれしいがすぎる。

公式ドキュメント:

さて、ここから、声を大にして叫びたいこと、それは、

\管理とコードが分離されてて、めちゃくちゃ使いやすい/

そう。この2つのビューが別ウィンドウになっていることで、

管理に必要なもの(タスク進捗、アーティファクト確認など)とコード周りのもの(ファイル編集、実装)がスッキリ分かれます。

最初は、2つのビュー、そうなんだあ、くらいに思ってたんですが、これが想像以上に見やすくて感動しました。

そもそも、従来のCursorやClaude Codeは、「エディタの横にチャット欄がくっついている」形式ですよね。

これ、使っていてちょこちょこ思っていたのが

質問とコードがぐちゃぐちゃになって、全体のフローが見えづらい...時があるなあ。

たとえば、

あなた:「このコード動かして」

AI:「はい、こういうコードにしました」(コード全文表示)

あなた:「あ、でもここ違う」

AI:「修正しました」(また全文表示)

そして翌る日。

「あれ、どんな流れで作ったんだっけ?」「あれ、結局どこでどう修正したんだっけ?」と振り返ろうとすると、長大なチャット履歴をスクロールして探すことになります。

もちろん、AIに要約して、というのも使用していますが、純粋に自分の目で流れを追いたい時ありますよね。ありますよ...ね?

あれ、Antigravityのエディタ側にもチャット欄ついてるじゃん?と思われるかもしれません

が、ご安心あれ、このチャット欄、エージェントマネージャー側と連動してます。

つまり、マネージャーとしての仕事で完結するなら、大きいエージェントマネージャービューで。

コード弄りつつやりとりしたいなら、エディタのチャット欄で。

という使い分けができます。

使ってみると感じるかと思いますが、本当に作業しやすいですよ。ぜひ、使ってみてください。

また、Antigravityでは、エージェントマネージャー側で複数のプロジェクト(エディタ側)を一括管理できます。

そのためプロジェクトAとBを並行して進めて、マネージャー視点で両方の進捗を確認する、みたいなことも簡単です。

特にマイクロサービスアーキテクチャの場合には、複数を進めるっていうのは恩恵が大きそうですよね。

そして、まさにAIの指揮官!ですね。カッコイイ。シビレル、アコガレル。

2. ブラウザ統合

続きまして、すごいぞ!ポイントは、エディターとブラウザのシームレスな連携が可能、というところです。

エージェントがIDE内部からWebブラウザ(Chrome)を直接操作して、Webアプリの動作確認やUI調整を自律的に実行できます。

使ってみて嬉しかったポイントはざっくり以下

- 人間がスクショ撮って貼り付ける手間がない(ブラウザとの行き来不要)

- 画面に対して直接範囲を指定できる

- 動作している動画も撮ってくれる

- Nano Banana Proで高品質なフロントエンド作成

従来のIDEより、フロントエンドにも強いのがAntigravityの魅力の1つですね。

ところで、ブラウザ統合と聞くと、Chrome DevTools MCPでいいのでは?と思うかもしれませんが、

IDEに統合されていて個人的に嬉しい一番のポイントは 「画面に対して直接範囲を指定できる」 ことだと感じています。

直接範囲指定については、Gemini Canvasの「選択して質問」をイメージしていただけるとわかりやすいと思います。

その範囲指定を1つの画面に対していくつもあれこれ指示できます。

ただし、Gemini Canvasとは違い、範囲指定する対象は、Antigravityが自動で撮ってくれたスクショに対して指定を行います。

個人的に最初の印象では、直接Chromeに対して範囲指定するのかな?と思っていたのですが、

スクショに対して選択することも、むしろ、スクショという証跡が残ったり、IDE内で完結できるという点が便利でした。

なんなら表示しているブラウザは、完全にAIが見る用みたいになってますね。恐るべし。

また、Nano Banana Proも内部的に組み込まれているようなので、

画面の画像部分に対して、画像を差し替えてもらう(= Nano Banana Proに生成してもらう)というようなことができるのも嬉しいですね!

そして、こちらはささやかな嬉しさかもしれないですが、当然Antigravityではデフォルトでブラウザに統合されているので、プロジェクトごとにブラウザ用の設定は不要です。

(初回のみChrome側の設定が必要です)

公式ドキュメント:

3. アーティファクト

ここがすごいぞ!ポイント、ラストは「アーティファクト」です。

最初は、アーティファクト??なんぞや??遺物??とハテナだらけだったんですが、

要するに、エージェントが作業する過程で作成してくれるアウトプット(コード以外の成果物)ですね。

- タスクリスト(Task List)

- 実装計画(Implementation Plan)

- ウォークスルー(Walkthrough)

- スクリーンショット(Screenshots)

- ブラウザ記録(Browser Recordings)

- ナレッジ(Knowledge)

公式ドキュメント:

カタカナ、ヨコモジ、だらけでイメージしにくいと思うので、サクッと概要を説明します。

タスクリスト:

エージェントが設計などを実行可能なステップに分解したもの。「何をするか」一覧。

実装計画:

AIがコードがコードを書き始める前の実装計画書(アーキテクチャロードマップ)。

これをユーザがレビューして承認したりします。

ウォークスルー:

エージェントが完了した作業を示すレポート。実装手順の説明や、何をしたかの記録。

スクリーンショット:

画面キャプチャ。動作確認時や、AIとやりとりする際に作成します。

※こちらは「2. ブラウザ統合」の初回設定が必要そうです

ブラウザ記録:

ブラウザを動かしている動画。エージェントが機能をテストして「ちゃんと動いている」を確認するための証跡。

※こちらは「2. ブラウザ統合」の初回設定が必要そうです

ナレッジ:

過去の作業から学習した、よく使用するスニペットやアーキテクチャパターン、ユーザーの好みを記憶。エージェント自身が勝手に学んで賢くなっていきます。

...と、この説明だけだと、ふうん、なるほどなあ、だけで終わってしまいそうなので、

ここで、私が良いなあと感じたポイントをば。

まず最初のポイントとして、これらのアーティファクトを勝手に作ってくれます。

アプリを作り始める最初のやりとり(要件定義、設計)や、その後、設計に沿ってAIがアプリを作成する、各フェーズにあったものをちょこちょこ作成してくれます。

また、作成する際にも、上書き、ではなく、一つ前の状態のファイルに追記した新しいファイルをどんどん作ってくれます。

ですので、たとえば、「タスクリスト」をいったん、途中のとある状態に戻したい、なんて時も、そのファイルをAIに指定してお願いする。なんてこともできますね。

所謂、バージョン管理システムである恩恵のようなものが得られそうだなあ、と感じてます。

(DBのスナップショットみたいなイメージ)

別のケースとして、たとえば、フロントエンドのテストなんかも捗りそうですね。

「スクリーンショット」や「ブラウザ記録」も自動で保管しておいてくれるので

「あれ、このバグどうやって修正したんだっけ?」と思ったときや、

「えぇ...テストの時は動いてたよなあ...?」なんて時にも、見返せますよね。

ちなみに、今回、試しにゼロからアプリ開発してみた際に、

アーティファクトの作成フローは、概ねこんな感じでした。

「実装計画」--ユーザがOKなら-->「タスクリスト」--作成が完了したら-->「ウォークスルー」

「スクリーンショット」「ブラウザ記録」は、初回のアプリ開発が終わってからの修正のやりとりで作成してくれました。

これは、妄想ですが、一連のフローに加えるには、テストのやり方などを指定してあげるとうまくいくのかもしれませんね。多分。

「ナレッジ」は、今回のようにちょこっと試しただけでは、作成してくれませんでした。

きちんとパターンをみて学習してくれるようで安心ですね。

そして、アーティファクトに話を戻して、もう一つのポイントは、

Antigravityが「アーティファクト」として、事前に作成物の種類を定めてくれているという点も嬉しいですね。

というのも、当然、CursorやClaude Codeでも、プロンプトで「スクリーンショット撮って」「計画書を作って」と依頼すればやってくれます。

ですが、毎回頼む必要があるし、独自の設定が必要だったりします。

また、プロジェクトごとに、設定にばらつきがあったり認識齟齬がでやすい、つらい。

とはいえ、現在はパブリックプレビューなので、今後、ベースを維持しつつ、

もしかしたら、アーティファクトも今後自分でカスタマイズできるようになったりするのかも?しれませんね。わくわく

さいごに

さて、Google Antigravity、いかがでしたでしょうか?

めちゃくちゃ文字文字したブログでしたが...Antigravityの素敵度が伝わればうれしいです。

私は、触ってみて、これ、開発フローが、また変わるな!とめちゃくちゃワクワクしています。

特に印象的だったのは、「エージェントマネージャー」という別ウィンドウの存在。

チャット欄ぐちゃぐちゃ問題(勝手に私がぐちゃぐちゃにしてるだけ)が軽減されて、それぞれのフェーズでやりたいことに集中できるのが、最高でした。

まだパブリックプレビューなので、これからどう進化するかも楽しみですね。

個人的に一番期待しているのは、Vertex AIとの連携強化。

VertexAIのモデルを使用できるようになったら...きっと、私を含め多くの開発者がしあわせになることでしょう。たのしみに寝て待ちましょう。

そして、Google Antigravity、無料で試せるので、みなさまもぜひ触ってみてください!とぶぞ。

公式サイト:

Discussion