🌐

インテル® Xeon® プロセッサーによる大規模言語モデル (LLM) パフォーマンスの加速化

【開発と活用を推進するインテルの AI】

インテルはクラウドからデータセンター、エッジにおいて、あらゆる場所での AI 活用を目指す、ソフトウェアやハードウェアでの AI 開発、さらには AI ソリューションへの活用を動画で解説するWebサイトを公開しています。

<AI 活用を動画で学ぶ>

インテルのエキスパートたちが、ソフトウェアやハードウェア、AI ソリューションに関してのノウハウを動画で解説。今回ご紹介するのは、「推論 / エッジ推論」

学習によって作成された推論モデルのエッジへの実装や、効率的な推論の実行など、推論に関して紹介します。

タイトル:

インテル® Xeon® プロセッサーによる大規模言語モデル (LLM) パフォーマンスの加速化

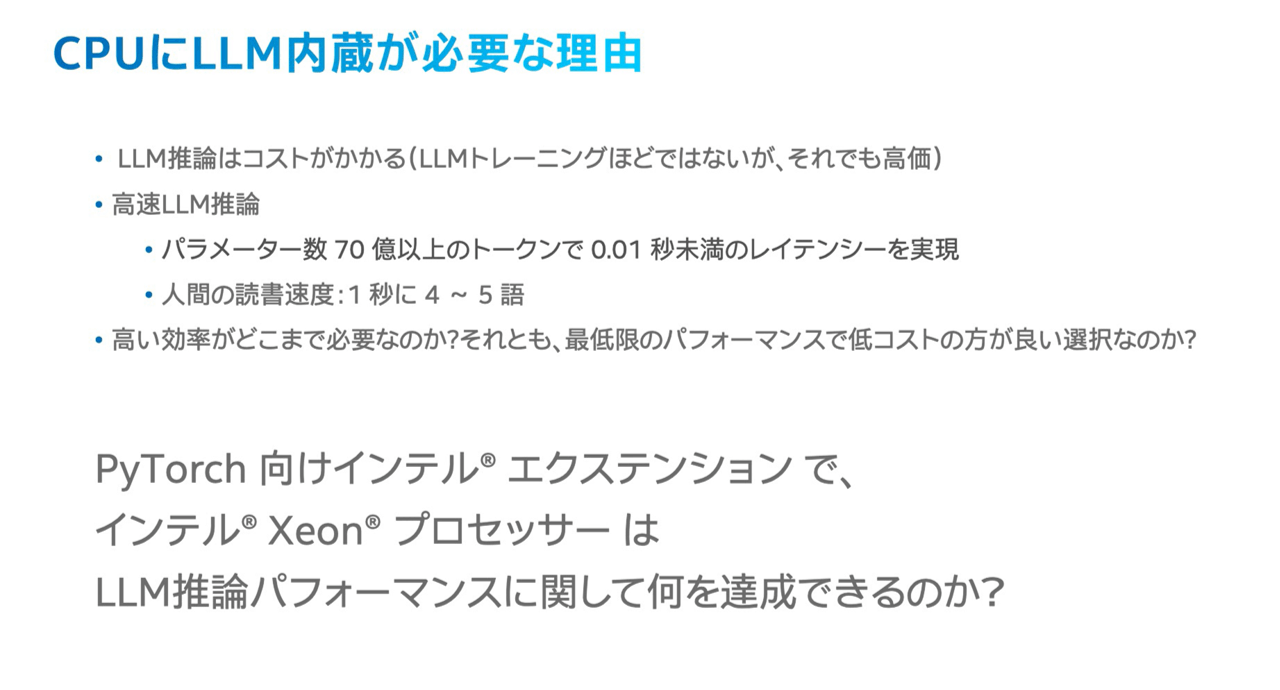

大規模言語モデル (LLM) の用途全てにおいて高価な GPU が唯一の選択肢なのでしょうか?用途やコストによっては汎用的なインテル® Xeon® プロセッサーがバランスの良さで最適な選択肢になります。このセッションでは、インテル® Xeon® プロセッサーでの LLM 運用を実現するために有効な、PyTorch 向けインテル® エクステンションがサポートしている LLM 向けの最適化について紹介します。

是非この機会にAI Everywhere を実現するインテルのソリューションをご覧ください!

Discussion