広告画像理解タスクの現状と課題 ― 広告画像理解の敵対的評価データセットTRADEの紹介 ―

はじめに

サイバーエージェント AI Lab NLPチームの村上です。普段はリサーチサイエンティストとして、広告文生成や評価に関する研究開発に従事しています。

本記事では、今年のACL2024で興味を持った広告画像理解タスクについて紹介します。本記事ではまず広告画像理解タスクの概要や課題を概観し、その後下記論文で提案された広告画像理解タスクの敵対的評価データセット「TRADE」を紹介します。

本記事のスライド版をこちらに公開しています。

また、社内で開催されたACL2024参加報告会の資料も公開しています。ぜひこちらも合わせて御覧ください。

忙しい人のための3行要約

- 広告画像理解タスクにおける従来データセット「Pitt Ads Dataset」が単純な画像-テキストの一致で解けてしまう問題を指摘。

- 敵対的な負例を含む新たな評価データセット「TRADE」を提案し、CLIPなど既存モデルの限界を明らかにした。

- 今後の方向性として「広告理解」の定義を見直すことや生成ベース手法の探求などが考えられる。

広告画像理解タスクの概要

研究背景 ― CV・NLP分野における取り組み

広告は、商品やサービスの魅力を伝え、消費者に行動を促す重要な役割を持っています。そのため、多くの広告には一目で印象に残るデザインや、視覚的な比喩表現などが多用されています。これらが消費者にどのような影響を与えるのかを理解することは、広告の品質改善や効果的なクリエイティブ自動生成に向けて重要な技術となります。

CVPR2017ではHussainらはWebから収集した広告画像データセットPitt Ads Datasetを公開しています。これをきっかけにコンピュータビジョン分野(CV分野)を中心に広告画像理解に関する様々な研究が行われてきました。

Pitt Ads Datasetに含まれる広告画像の例

また最近では自然言語処理分野の国際会議においても広告画像理解に関する論文がいくつか発表されています。直近5年以内では本記事で紹介する論文を含めて、4件の論文を確認しました。

- Don’t Buy it! Reassessing the Ad Understanding Abilities of Contrastive Multimodal Models (Bavaresco et al., ACL 2024)

- KAFA: Rethinking Image Ad Understanding with Knowledge-Augmented Feature Adaptation of Vision-Language Models (Jia et al., ACL 2023)

- Understanding Advertisements with BERT (Kalra et al., ACL 2020)

- Ad Lingua: Text Classification Improves Symbolism Prediction in Image Advertisements (Savchenko et al., COLING 2020)

広告は、画像とテキストを融合した高度な情報伝達手段の一つの例であり、その理解には物体検出やテキスト検出、比喩表現の理解、さらには画像とテキストの情報を統合する能力が求められます。近年、マルチモーダル情報の理解や生成に関する研究が大きな注目を集めており、広告理解の分野にもその流れが波及していくことが期待されます。

問題設定 ― 広告に関連する説明文を選択する問題

広告画像理解タスクの問題設定について説明します。本記事ではCVPR2018のワークショップで開催された広告画像理解コンペティションの公式評価プロトコルに沿って説明します。このコンペではHussainらが提案したPitt Ads Datasetを使用しています。

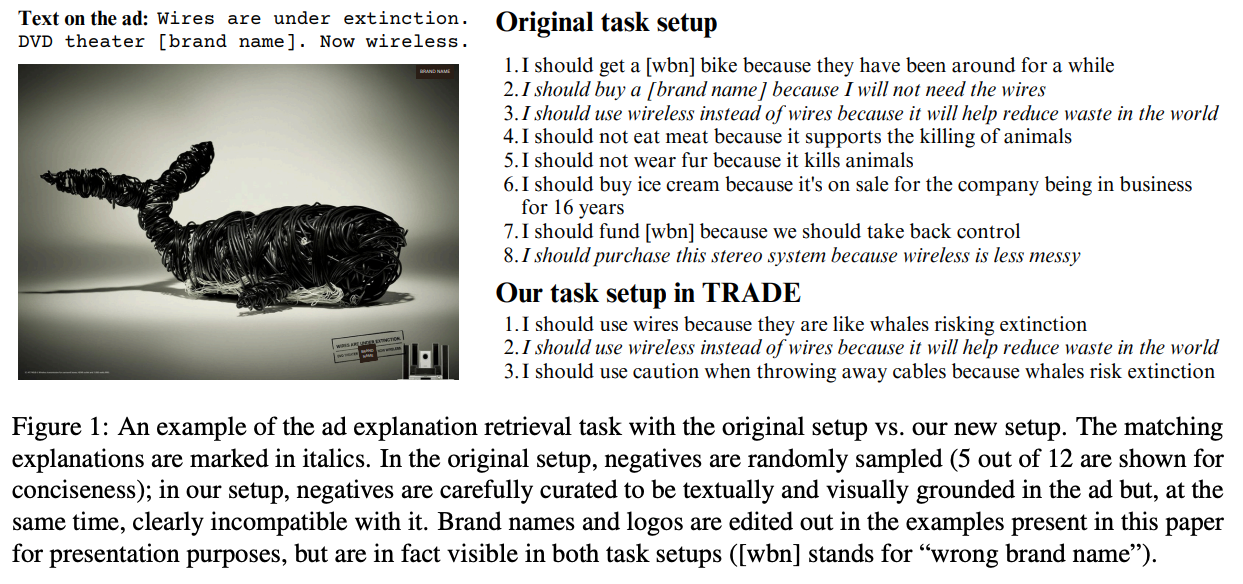

広告画像理解タスクは、与えられた広告画像に対する15種類の説明文の中から、適切な説明文を選択するという検索問題です。 Pitt Ads Datasetでは、各広告画像に "What should you do, according to this ad and why?" という質問文に対して、3名のアノテータが説明文を作成しています。例えば、以下の広告画像には、”I should buy a [brand name] because I will not need the wires” が付与されています。ここで、各説明文は “I should [Action] because [Reason]” という形式になっています。

Pitt Ads Datasetにおける広告画像と説明文の例[1]

本タスクでは、正例は各広告画像に対して3名のアノテータが作成した3つの説明文、負例は他の広告画像に紐づく12の説明文(ランダムサンプリングにより決定)と定義しています。 評価指標としては各広告画像に紐づく15の説明文(正例3文、負例12文)の中から1つの説明文を選択したときの正解率(Accuracy)が使用されています。

広告画像理解は既に解決された問題か

先行研究のアプローチ ― 既存手法では95.2%の正解率を達成

CV分野ではアンサンブル手法やグラフニューラルネットワークなどを用いた様々なアプローチが提案されています。CVPR2018 Workshopの広告画像理解コンペティションで優勝したチーム(CyberAgent AILabチーム)は広告画像中のテキストに着目して、画像と説明文の関連度に加えて、OCRで抽出したテキストと説明文の関連度も考慮することで約82%の正解率を達成しました。

最近では視覚言語モデル(Vision Language model; VLM)を用いたアプローチが提案されています。[Jia+, 2023] らの研究では事前学習されたVLMの広告画像理解の能力を評価しました。具体的にはCLIPやALBEF、LiTなどのVLMを用いて算出した広告画像と説明文のアライメントスコアに基づく手法を提案しています。

[Jia+,2023]らの報告では、Zero-shot設定において全てのモデルで高い性能を達成することを示しており、特にCLIPでは95.2%の正解率となっています。また、[Bavaresco+,2024] らの論文では、本タスクの人手評価性能を調査したところ約94%の正解率だったと報告しています(300事例に対して2人の評価者で検証)。

以上を踏まえると、既にVLMを用いたアプローチでは人間と同等の性能を達成していることが分かります。それではモデルは広告画像を本当に理解できていると言えるのでしょうか。

データセットの問題点が指摘されている

[Kalra+,2020] や[Jia+,2023]の研究では、本タスクにおける以下の問題点を指摘しています。

(1) 広告画像中のテキストと説明文の単語重複

[Kalra+,2020]はPitt Ads Datasetを分析したところ、広告画像中のテキストと適切な説明文間で有意な単語重複を観測しました。つまり、広告画像中と説明文の単語の重なり具合を見ることで、どの説明文が適切かを簡単に見破ることができる可能性があります。

実際にCVPR2018 Workshopのコンペティションで優勝したチームでは、OCRで抽出した広告画像中のテキストと説明文の関連性を考慮することで精度向上を達成していました。

(2) 難しい負例が少ない

[Jia+,2023]は本データセットにおいて難しい負例事例(Hard negative)が少ない問題を指摘しています。先述した通り、各広告画像に対する適切な説明文(正例)は人手で作成していましたが、負例については他の広告画像に対する説明文からサンプリングしてました。

つまり、各広告画像と負例の関連性は正例と比べると著しく低く、どの説明文が負例かを簡単に見破ることができるようになっています。

Grounding scoresによる定量分析 ― 単語の重なり度合いで解ける可能性を指摘

[Bavaresco+,2024]は上記の問題を定量的に分析しました。Bavarescoらは、本タスクにおいてモデルは (1)画像中のテキストと説明文の関係、(2)画像中とテキスト中で言及されるエンティティの関係といった2種類の単純な関係を参照することで問題を解いていると仮説を立てました。そこで(1)を分析するためにTextual-grounding scores、(2)に対してVisual-grounding scoresを新たに定義しています。

Textual grounding scoresには2種類あり、1つ目は画像中のOCRテキストと説明文の内容語の重なり度合いであるtext overlap、2つ目はOCRテキストと説明文の文ベクトルのコサイン類似度であるtext similarityです。Visual-grounding scoresも2種類あり、1つ目は画像から抽出されたobjectと説明文の名詞が一致する割合object mention、2つ目は画像から生成したキャプションと説明文のコサイン類似度を表すcaption similarityです。

| Visual-grounding scores | 説明 |

|---|---|

| Text overlap | 画像のOCRテキストに含まれる説明文の内容語の割合 |

| Text similarity | OCRテキストと説明文の分ベクトルのコサイン類似度 |

| Object mention | 画像から抽出されたobject集合のうち説明文の名詞と一致する割合 |

| Caption similarity | 画像から生成したキャプションと説明文のコサイン類似度 |

[Bavaresco+,2024]より引用

Table1はPitt Ads datasetの評価データに対して各スコアの平均を算出した結果(左側のoriginal setup)です。正例(pos)と負例(neg)の各スコアの違いを見てわかる通り、正例/負例間でスコアの平均値に大きなギャップがあることが分かります。この結果から正例は負例と比べて画像とテキストの関連性が高いことが推察できます。

つまり、Bavarescoらは、画像とテキストのアライメントスコアに基づくVLMベースの既存手法は広告画像を”理解”しているわけではなく、単純な画像ーテキスト間の類似度でタスクを解いている可能性があることを指摘しています。

新たな評価データセットTRADEの提案

Bavarescoらは広告画像理解タスクの新たな評価データセットTRADEを提案しました。TRADEはPitt Ads Datasetの一部を人手アノテーションにより改良したもので、単純な画像-テキスト間のアライメントスコアでは解くことができない敵対的な事例を含む評価データセットです。この評価データセットにより、VLMなどの既存モデルが単純な画像-テキストアライメントを超えて、どの程度広告画像を理解できるか評価できるようになることが期待されています。

データセット構築手順

提案した評価データセットTRADEの構築手順は以下のとおりです。

- Pitt Ads Datasetの評価セットから300事例をピックアップする

- 各事例に紐づく3つの正例(適切な説明文)の中から1つの説明文を選択する

- アノテータが広告画像中の物体や選択した正例の一部に言及しながら”もっともらしくない”説明文(負例)を2つ作成する

- その他の指示内容

- 文長は正例と同じくらいにすること

- 負例における[Action]の動詞は正例と同じにすること

- その他の指示内容

上記の手順により、(広告画像, 正例, 負例1, 負例2)の四つ組からなる評価データ300事例を作成しています。この手順により正例、負例は共に広告画像と関連性は同程度に高いため、モデルは単純な画像-テキストアライメントを超えた広告画像理解の能力が求められます。

Figure1と以下の表にTRADEにおける説明文の例を示します。Figure1の"Our task setup in TRADE"がTRADEにおける説明文です。説明文(2)はPitt Ads Datasetから抽出した正例(適切な説明文)であり、説明文(1)と(3)が新たに作成した敵対的な負例です。

これらの説明文とPitt Ads Datasetのオリジナルの評価データ(Original task setup)を比較すると、広告画像-説明文間の単語の重なり度合いは高まっています。そのため、正しい説明文を選択するためには単語の重なり度合いだけではなく、説明文の内容理解が求められることが分かります。

| 説明文 | ラベル | |

|---|---|---|

| (1) | I should use wires because they are like whales risking extinction | 負例 |

| (2) | I should use wireless instead of wires because it will help reduce waste in the world | 正例 |

| (3) | I should use caution when throwing away cables because whales risk extinction | 負例 |

TRADEにおける説明文の例

TRADEの定量分析

Bavarescoらは前述のGrounding scoresと人手評価の2つの方法で提案データセットTRADEの妥当性を評価しました。Table1の赤枠内がGrounding scoresによる定量分析の結果です。この結果からoriginal setupと比べて、正例/負例間のスコアのギャップは解消されていることが分かります。

また、TRADEを用いて人間の評価者による広告画像理解タスクを実施し、正解率は94%を達成することを確認しています。

(再掲)[Bavaresco+,2024]より引用

TRADE-controlの導入

BavarescoらはTRADEと先行研究で利用されていた評価データセットの設定(他事例からランダムサンプルして負例を作成)を直接的に比較できるようにするために、TRADE-controlを導入しています。

TRADE-controlは評価データ(広告画像, 正例, 負例1, 負例2)のうち、人手作成した敵対的な負例1・負例2を用いるのではなく、他の広告画像に対する正例からランダムサンプリングした2事例をそれぞれ負例1と負例2を用いる設定です。

TRADE, TRADE-controlはこちらのGithubリポジトリで公開されています。

実験設定

実験では提案データセットTRADEを用いて、画像-テキストアライメントベースのVLMであるCLIP, ALBEF, LiT, ALIGNを評価しています。評価方法の手順は以下のとおりです

- 各モデルで広告画像と説明文(正例, 負例1, 負例2)それぞれとのアライメントスコアを算出

- 各画像-説明文ペアのアライメントスコアのうち、もっともスコアが高かったものが正例であれば正解、それ以外であれば不正解とした正解率で評価します。

最終的には評価データにおける平均正解率を算出します。

評価結果

各モデルのTRADE, TRADE-controlにおける平均正解率をTable2に示します。TRADE-controlは先行研究と同様に98%と高い性能を達成していますが、Bavarescoらの提案データセットTRADEでは34%程度となっています。これは3つの説明文のうち1つをランダムに選択した場合のチャンスレートとほぼ同じであり、各モデルは広告画像と説明文(正例)の関連性を適切に評価できていないことが推察できます。

[Bavaresco+,2024]より引用

予測結果の分析

定性分析

Figure2に各モデル、人手評価者の実際の予測結果を示します。この中で適切な説明文は(1)です。人手評価者は正しく選択できてきます。この広告画像からはこのハンバーガーは美味しさだけなく、見た目も美しいことが推察でき、人手評価者はそれらの視覚的な比喩をうまく汲み取ることで正しい選択肢を選ぶことができたと考えられます。

一方、各VLMは適切ではない説明文(2)(3)を選択しています。それぞれの説明文は画像中のeyelashes(まつ毛)を言及しています。各モデルは画像中のobjectとテキスト中のeyelashesの関連性の高さから説明文(2)(3)の誤った選択肢を選んだことが考えられます。

また、説明文(2)と(3)についてはよく読むとややおかしい文章であることが分かります。バーガーショップに行く理由として、”my eyelashes need a new look.”や”tasty burgers mush look like these eyelashes.”は不自然です。

以上の結果から画像-テキストのアライメントに基づくVLMは広告画像を理解できているとは言えなさそうです。

[Bavaresco+,2024]より引用

定量分析

各モデルの正解率は34%程度とチャンスレートと同等の性能ですが、一部の事例では正しい選択肢を選ぶことができていることは事実です。それではどのような事例で各モデルは正しい選択肢を選ぶことができたのでしょうか。

Bavarescoらは全てのモデルで正解した事例(全体の約8%の事例)に焦点を当てて分析したところ、それらの事例は平均よりもGrounding scoresが高い事例が多かったことが分かりました。このことから、各モデルは画像-テキストの関連性に依存していることが推察できます。

[Bavaresco+,2024]より引用

まとめ

Bavarescoらの研究では、まず広告画像理解タスクで広く用いられるPitt Ads Datasetの課題を指摘しました。具体的には(1)画像中のテキストと説明文中の単語の重複が多いこと、(2)各事例の負例は他事例からランダムサンプリングしているため難しい負例が少ないことの2点です。Bavarescoらはこの課題に対して、敵対的な負例を新たに人手で作成し、既存モデルの性能調査をしています。

その結果、既存モデルであるVLM(e.g., CLIP)の性能はチャンスレート程度であることが分かりました。先行研究ではモデルは人手性能に近い正解率であることが報告されていましたが、この実験結果により既存モデルには依然として多くの課題が残っていることが分かりました。

この研究からの学びとしては、モデル性能の解釈には注意が必要であり、そのデータがどう作られたかや各事例の特徴には目を向けることが重要ということです。正解率などの評価指標だけでなく、データセットの品質や予測結果の傾向に目を向けることで、モデルが解けていない課題を発見することに繋がります。

今後の研究の方向性として以下の点が言及されています。広告画像理解の発展に向けて、どちらも重要な課題です。2点目の生成ベース手法の探求については、個人的な検証としてマルチモーダルLLMによる広告画像理解の実験を実施したため、近日中の記事執筆・公開を検討しています。

- モデルが広告を”理解している”とはどのような能力が必要と定義すればよいか。また、それらを真に評価するにはどうすればよいか。

- 検索ベース手法の限界として、タスク特有の指示を与えることができないが挙げられる。生成ベース手法の探求も面白い方向性の一つ。

さいごに

最後まで本記事を読んでいただきありがとうございました。本記事を通して広告画像理解の研究に興味を持っていただけたら大変嬉しいです。また、本記事に含まれる誤りへの指摘や議論したい点などがありましたらお気軽にコメント等でお知らせいただけますと幸いです。

参考文献

本記事の執筆にあたり、以下の論文、記事・Webページを参考にさせていただきました。

論文

- Don’t Buy it! Reassessing the Ad Understanding Abilities of Contrastive Multimodal Models (Bavaresco et al., ACL 2024)

- KAFA: Rethinking Image Ad Understanding with Knowledge-Augmented Feature Adaptation of Vision-Language Models (Jia et al., ACL 2023)

- Understanding Advertisements with BERT (Kalra et al., ACL 2020)

- Ad Lingua: Text Classification Improves Symbolism Prediction in Image Advertisements (Savchenko et al., COLING 2020)

- Automatic Understanding of Image and Video Advertisements (Hussain et al., CVPR 2017)

記事・Webページ

- サイバーエージェント AI Lab blog

- 広告画像理解コンペティション@CVPR2018 Workshop

- Pitt Ads Dataset

- https://people.cs.pitt.edu/~kovashka/ads/

-

https://people.cs.pitt.edu/~mzhang/visualization/dataset/

- 本記事中の広告画像はこちらのサイトより引用しています。

-

各広告画像には正例の説明文が3文、負例の説明文が12文含まれる(例では5つの負例のみ表示)。実際のデータセットでは[brand name]内にはブランド名が入ります。本画像は論文中の図を一部再編集しています ↩︎

Discussion