🦜

【Colaboratory】gemma3を使ってみる

自分用の備忘録ですが、よかったら参照ください。

躓きポイントは以下の通り(筆者は1時間ほど溶かしました...)

- HuggingFaceのTokenの権限設定

- gemma3の利用規約に同意する

0 前提

- HuggingFaceのアカウントは持っているとする

- モデルはgemma3-4b-itを使用(画像とテキスト入力がしたかったため)

- 環境はGoogle Colaboratoryを使用

HuggingFaceのgemma3-4b-itのページで公開されているので、それを使用

1. HuggingFaceでtokenの生成

- HuggingFaceにログインする

- 右上の自分のアイコンをクリック -> 【Access_Token】をクリック

- 【Create_new_token】をクリック

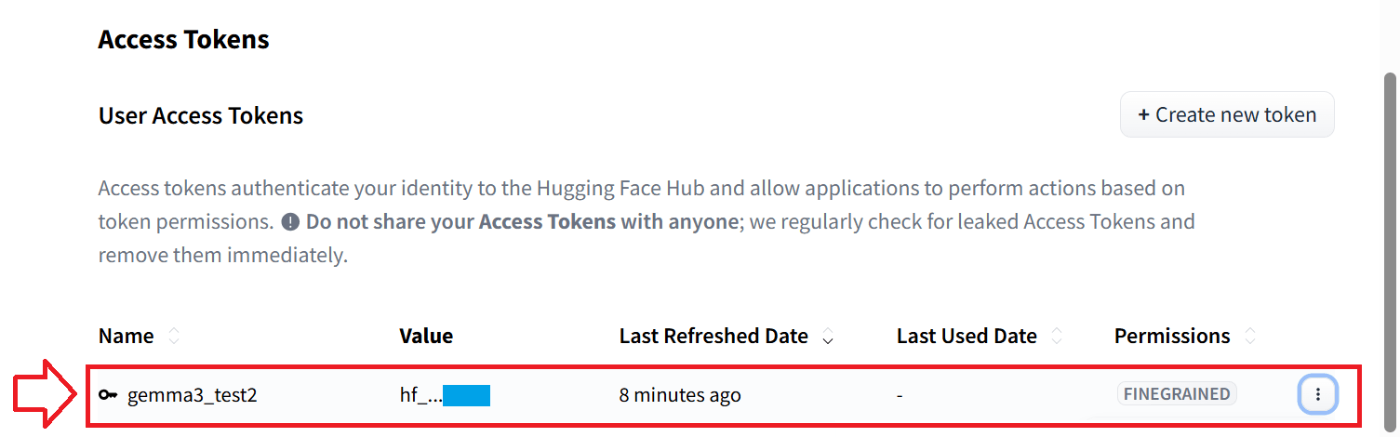

- Token type:Fine-grained

- Token name:任意の名前を指定(画像中では「gemma3_text2」)

- User permissions(【ユーザ名】)

- Repsitories

- Read access to contents of all repos under your personal namespace

- Read access to contents of all public gated repos you can access

上記以外は未指定

- Repsitories

- 一番下にある【Create token】をクリック

- 生成されると、Save your Access Token」のpop upが表示されるため

右側のCopyをクリックして、厳重に管理してください - Access Tokenの一覧に先ほど作成したTokenが表示されていればOK

詳細(画像付き説明)

1. HuggingFaceにログインする

2. 右上の自分のアイコンをクリック -> 【Access_Token】をクリック

3. 【Create_new_token】をクリック

4. Tokenのpermission設定(例)

5. 一番下にある【Create token】をクリック

tokenが表示される

6. Tokenが正常に作成されたかの確認

Nameが4で記入した名前のTokenが一覧表にあることを確認する

2. Gemma3の利用許可(規約に同意)

Hugging Faceのgemma3の公式サイトへアクセスします

- 【Acknowledge license】をクリック

- 【Authorize】をクリック

- 利用規約を熟読し、同意できる場合は【Accept】をクリック

- 「Gated model You have been granted access to this model」の表記に代わっていればOK

詳細(画像付き説明)

1. 【Acknowledge license】をクリック

2. 【Authorize】をクリック

3. 利用規約を熟読し、同意できる場合は【Accept】をクリック

4. 「Gated model You have been granted access to this model」の表記に代わっていればOK

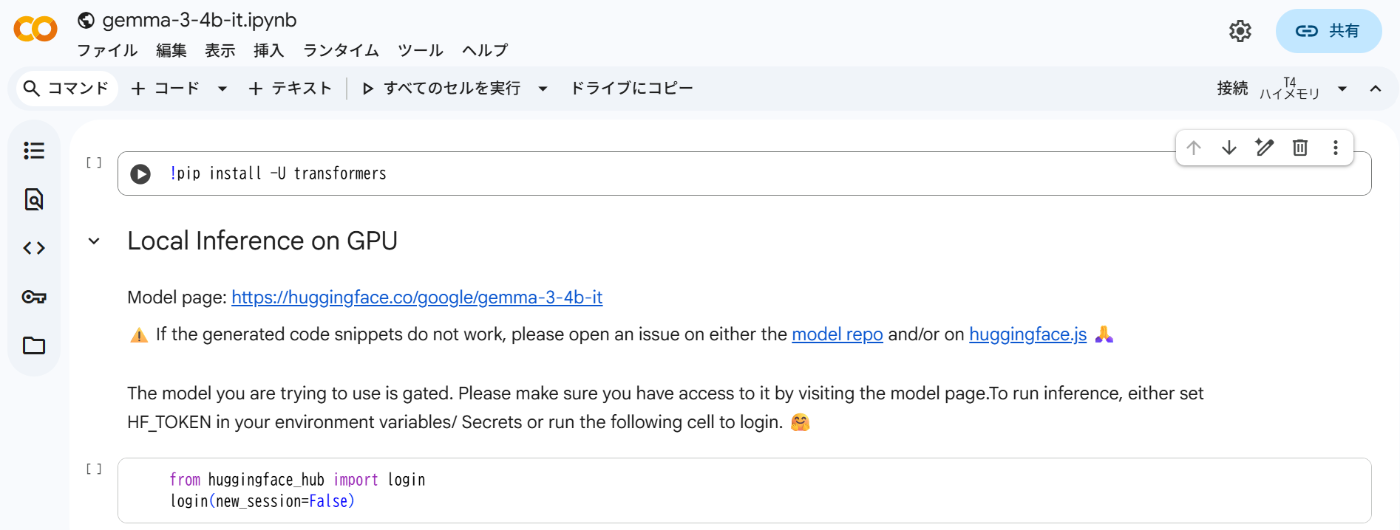

3. 公式のコードでテスト

- 【Use this model】 -> 【Google Colab】をクリック

- 上から順番に実行していく

- Hugging Faceのloginのコードブロックでは、以下の操作が必要

- Token:Access Tokenをコピペ

- Add token as git credential?:任意

- 【login】をクリック

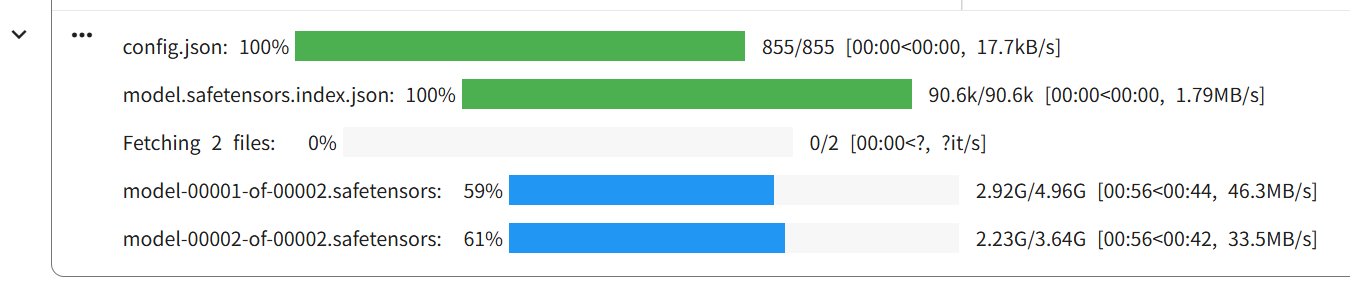

- あとは自動でモデルのダウンロードなどが始まり、推論結果が表示される

- 推論結果が表示される

なお、生成テキストのみ抽出したい場合、pipeの返値を変数で受けて参照すればOK

ret = pipe(text=messages) # ここで返値をretに格納する

ret[0]["generated_text"][-1]["content"] # list -> dict -> list -> dictの順に参照するとstr型の文字列として参照できる

詳細(画像付き説明)

1. 【Use this model】 -> 【Google Colab】をクリック

2. 上から順番に実行していく

警告は、プログラム内容に問題がないことを確認して、OKをクリック

3. Hugging Faceのloginのコードブロックでは、以下の操作が必要

login画面が埋め込みで表示される

4. あとは自動でモデルのダウンロードなどが始まり、推論結果が表示される

gemma3-4b-itの場合、2分割されて合計は8.6GB程度のサイズ

5. 推論結果が表示される

参考(GPUメモリ使用量)

gemma3-4b-itでの推論実行時に計測して、GPU使用量のpeakは10.6GBでした

localで使用する際の参考にでもどうぞ

google Colaboratoryの場合、起動時にストレージが初期化されるため、

毎回モデルのダウンロードが必要

local PCの場合、モデルファイルがキャッシュされるため、2回目以降はHuggingFaceのアカウントログイン・モデルのダウンロードはされません

4. まとめ

- gemma3-4b-itをgoogle Colaboratory上で試す手順についてまとめた

HuggingFaceのgemma3公式からgoogle Colaboratory上で動作するnotebookに飛べるので、

GPUを持っていない人でも簡単に試せて便利だと感じた - 一方、初心者が試すには、HuggingFaceのTokenの権限設定、およびLLMモデル自体の利用規約の同意方法が分かりづらかった(知ってる前提で省略している記事が多い)

- gemma3-4b-itはテキスト・画像の入力が可能なので、かなり使い勝手が良いと思う

gemma3n-E4B-itについては音声や動画の入力が可能であるため、そっちの使い方も別の記事でまとめようと思う

Discussion