音声認識APIについて調べる

音声認識をする中で、話者分離が一番難しいらしい

Speaker diarization

Speaker diarization

Claudeちゃん回答

スピーカーダイアリゼーション(Speaker Diarization)について

スピーカーダイアリゼーション(話者ダイアリゼーション)とは、音声録音から「誰がいつ話したか」を特定するプロセスです。複数の話者が含まれる音声データを分析し、各発話セグメントを適切な話者に割り当てる技術です。

基本概念

スピーカーダイアリゼーションは主に以下のステップで構成されています:

- 音声セグメンテーション: 音声を話者の切り替わりに基づいてセグメントに分割

- 話者クラスタリング: 類似した音声特徴を持つセグメントをグループ化

- 話者識別: 各クラスターを特定の話者に関連付け(オプション)

主な用途

- 会議・ミーティングの文字起こし

- コールセンターの会話分析

- 放送コンテンツの索引付け

- 法廷記録の自動化

- マルチスピーカーインタビューの処理

技術的アプローチ

現代のスピーカーダイアリゼーションシステムでは、以下のような技術が使用されています:

- MFCC (Mel-Frequency Cepstral Coefficients): 音声特徴量の抽出

- i-vector/x-vector: 話者の音声特徴を低次元ベクトルで表現

- ディープラーニングモデル: 話者埋め込み(speaker embeddings)の生成

- クラスタリングアルゴリズム: 階層的クラスタリングなど

課題

- 話者の重複(オーバーラップ発話)の処理

- 遠距離マイクでの録音品質

- 話者数の事前把握が困難

- 背景ノイズや残響の影響

- 短い発話の正確な分類

最近の進展

最新のスピーカーダイアリゼーションシステムでは、エンドツーエンドのディープラーニングアプローチが採用され、従来の多段階パイプラインよりも高い精度を実現しています。自己教師あり学習や話者適応技術の進歩により、実世界の複雑な音声環境にも対応できるようになってきています。

評価指標

- DER (Diarization Error Rate): 話者ダイアリゼーションの主要な評価指標

- JER (Jaccard Error Rate): 話者の重複を考慮した評価指標

スピーカーダイアリゼーションは音声認識、自然言語処理、会話分析などの分野と密接に関連しており、音声インターフェースの高度化に重要な役割を果たしています。

なるほど、

これまでの技術だと、話者が重複していた場合、どちらか一方しか採用できないみたい

なので最近は、End-to-End Neural Diarization (EEND)がいいらしい

https://ys0510.hatenablog.com/entry/2023/12/17/123212

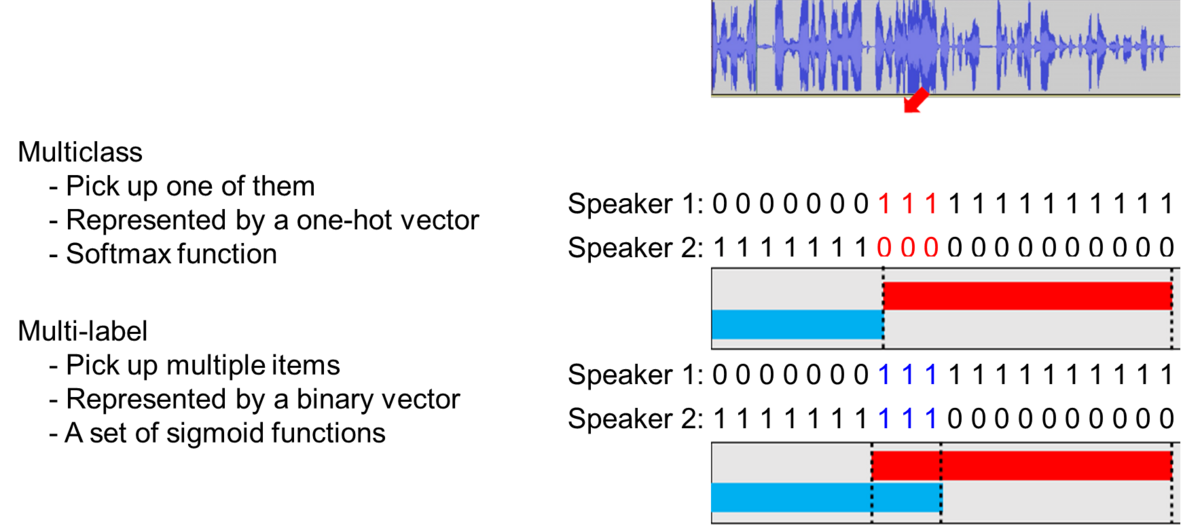

マルチクラス

マルチクラスアプローチでは、最終層にSoftmax関数を採用しており、必ずどれか1つのクラスが選択されます。

そのため、オーバーラップした発話には対応することができませんが、ImageNetのような、画像のクラス分類(dog or cat or horse) のように、重複することがないタスクに適しています。

マルチラベル

一方、マルチラベルアプローチでは、最終層にSigmoid関数を使用することで、複数のクラスが同時にアクティブになることできます。

から引用

これらを提供しているAPIやサービスはあるのか、Claudeに調べてもらった

エンドツーエンドのスピーカーダイアリゼーションを提供するAPIとサービス

エンドツーエンドのスピーカーダイアリゼーション技術を提供している主要なAPIやサービスについて調査します。

エンドツーエンドのスピーカーダイアリゼーションを提供するAPIとサービス

現在、いくつかの主要なAPIとサービスがエンドツーエンドのスピーカーダイアリゼーション機能を提供しています:

商用API/サービス

-

AssemblyAI: 高精度のスピーカーダイアリゼーションAPIを提供し、複数の話者を検出して各話者の発言内容を特定。テスト結果では業界最低の2.9%のエラー率を達成。REST APIを通じて簡単に統合可能。Source Source

-

Google Cloud Speech-to-Text: スピーカーダイアリゼーション機能を備えた音声認識サービスを提供。音声サンプル内の異なる話者を区別し、各発話に話者タグを付与。[1]

-

Microsoft Azure Speech Service: リアルタイムダイアリゼーション機能を提供し、会話内の複数の参加者の音声を認識。Source

-

Deepgram: APIを通じてスピーカーダイアリゼーション機能を提供し、各単語に話者IDを付与。Source

オープンソースフレームワーク

-

NVIDIA NeMo: エンドツーエンドのスピーカーダイアリゼーションモデルを含む音声処理フレームワーク。単一のニューラルネットワークで生の音声信号から話者ラベルを予測。Source

-

ESPnet: 音声認識、話者ダイアリゼーションなど様々なエンドツーエンド音声処理タスクをサポートするオープンソースツールキット。Source

-

FunASR: 基本的なエンドツーエンド音声処理フレームワークで、話者検証、話者ダイアリゼーション、マルチ話者ASRなどの機能を提供。Source

これらのサービスは、会議の文字起こし、コールセンター分析、メディアコンテンツのインデックス作成など、様々な用途に活用できます。

OpenAIのWhisperは話者分離には対応していない

Azure “Speech Service”

音声認識の精度が非常に高く、特に専門用語や技術用語が多い場合でも正確に文字起こしが可能です。

Google Cloud “Speech-to-Text”

リアルタイムでの音声認識が可能で、会議やライブイベントなどで即座に文字起こしが必要な場合に非常に便利です。

この辺が魅力的やな

プロダクトの要件に合わせて選択するのがよさそう

Azure Speech Serviceにおける話者分離(ダイアリゼーション)の結果形式

Azure Speech Serviceにおける話者分離(ダイアリゼーション)の結果形式

Azure Speech Serviceの話者分離(ダイアリゼーション)機能を使用すると、音声認識結果には話者情報が含まれて返されます。結果の形式は、リアルタイム処理とバッチ処理で若干異なります。

リアルタイムダイアリゼーションの結果形式

リアルタイムダイアリゼーションでは、認識結果に話者IDが付与されます。話者IDは会話の参加者ごとに割り当てられる一般的な識別子(Speaker 1, Speaker 2など)です。サービスは会話中に異なる話者を検出すると、それぞれに識別子を割り当てます。[1]

リアルタイム認識の結果は、以下のような形式で返されます:

TRANSCRIBING: Text=Hello, this is Speaker 1 speaking.

RECOGNIZED: SpeakerId=1, Text=Hello, this is Speaker 1 speaking.

TRANSCRIBING: Text=And now Speaker 2 is responding.

RECOGNIZED: SpeakerId=2, Text=And now Speaker 2 is responding.

バッチダイアリゼーションの結果形式

バッチ処理の場合、結果はJSON形式で返されます。各発話セグメントには、話者ID、開始時間、終了時間、認識されたテキストなどの情報が含まれます。

バッチ処理の結果の例:

{

"recognizedPhrases": [

{

"recognitionStatus": "Success",

"speaker": 1,

"channel": 0,

"offset": "PT0.07S",

"duration": "PT1.59S",

"offsetInTicks": 700000,

"durationInTicks": 15900000,

"nBest": [

{

"confidence": 0.9,

"speaker": 1,

"lexical": "hello this is speaker one",

"itn": "hello this is speaker one",

"maskedITN": "hello this is speaker one",

"display": "Hello, this is Speaker 1."

}

]

},

{

"recognitionStatus": "Success",

"speaker": 2,

"channel": 0,

"offset": "PT2.31S",

"duration": "PT1.74S",

"offsetInTicks": 23100000,

"durationInTicks": 17400000,

"nBest": [

{

"confidence": 0.85,

"speaker": 2,

"lexical": "and now speaker two is responding",

"itn": "and now speaker two is responding",

"maskedITN": "and now speaker two is responding",

"display": "And now Speaker 2 is responding."

}

]

}

]

}

主な特徴

- 話者ID: 各発話に対して話者識別子(数値)が割り当てられます

- 時間情報: 各発話の開始時間と継続時間が含まれます

- チャンネル情報: マルチチャンネル録音の場合、どのチャンネルからの音声かも識別されます

- 信頼度スコア: 認識結果の信頼度も含まれます

Azure Speech Serviceのダイアリゼーション機能は、会議のトランスクリプション、コールセンターの会話分析、インタビューの文字起こしなど、複数の話者を含む音声コンテンツの処理に特に有用です。[2]

主要な話者分離(スピーカーダイアリゼーション)サービスの料金比較

主要な話者分離(スピーカーダイアリゼーション)サービスの価格比較

各サービスプロバイダーの話者分離機能の価格を比較します。価格は2025年3月現在のものです。

AssemblyAI

AssemblyAIの話者ダイアリゼーション機能は、基本的な音声認識サービスに含まれています:

- 基本料金: 音声処理時間1分あたり$0.00025(約¥0.04)

- 特徴: 話者ダイアリゼーション、カスタムスペルと語彙、不適切表現フィルタリングなどが含まれる

- 無料枠: 新規ユーザーには5時間の無料音声処理が提供される

- スタートアップ割引: スタートアップ企業向けのクレジットと割引価格あり Source

Microsoft Azure Speech Service

Azureの話者ダイアリゼーション機能は、バッチ処理の音声認識サービスに追加機能として含まれています:

- バッチ処理: $0.36/時間(約¥54/時間)

- リアルタイム処理: $1.00/時間(約¥150/時間)

- 追加機能: ダイアリゼーションはバッチ音声認識に含まれる追加機能

- 無料枠: 月間5時間の無料音声処理(F0無料枠) Source

Google Cloud Speech-to-Text

Google Cloudの話者ダイアリゼーション機能は音声認識サービスの一部として提供:

- 標準モデル: $0.016/分(約¥2.4/分)

- 拡張モデル: $0.024/分(約¥3.6/分)

- 追加料金: 話者ダイアリゼーション機能に追加料金はなし

- 無料枠: 毎月60分間の無料音声処理 Source

AWS Transcribe

Amazon Transcribeの話者ダイアリゼーション機能:

- ティア1: 最初の250,000分まで$0.024/分(約¥3.6/分)

- ティア2: 250,000分以上は$0.015/分(約¥2.25/分)

- 最大話者数: 最大30人の話者を識別可能

- 無料枠: AWS無料利用枠として毎月60分間の無料音声処理 Source

Deepgram

Deepgramの話者ダイアリゼーション機能:

- スターター: $0.0044/分(約¥0.66/分)から

- エンハンスト: $0.0125/分(約¥1.88/分)から

- ノバ: $0.0200/分(約¥3.0/分)から

- エンタープライズプラン: 年間$4,000-10,000(約¥60万-150万)のプリペイドクレジット

- 特徴: 30以上の言語、話者ダイアリゼーション、スマートフォーマット、自動言語検出を含む [1]

比較ポイント

- 最も経済的: 処理量が多い場合、AssemblyAIが最も低コスト

- 精度と機能: Deepgramは高精度と多機能を謳っているが、価格も比較的高め

- エンタープライズ向け: AzureとAWSは大規模企業向けの包括的なサービスを提供

- 無料試用: ほとんどのサービスが無料枠を提供しており、小規模プロジェクトでは無料で利用可能

各サービスは価格だけでなく、精度、対応言語、APIの使いやすさ、他のサービスとの統合性なども考慮して選択することをお勧めします。Source