RAGからみたLlama 4がRAGに与える影響

Llama 4がリリース

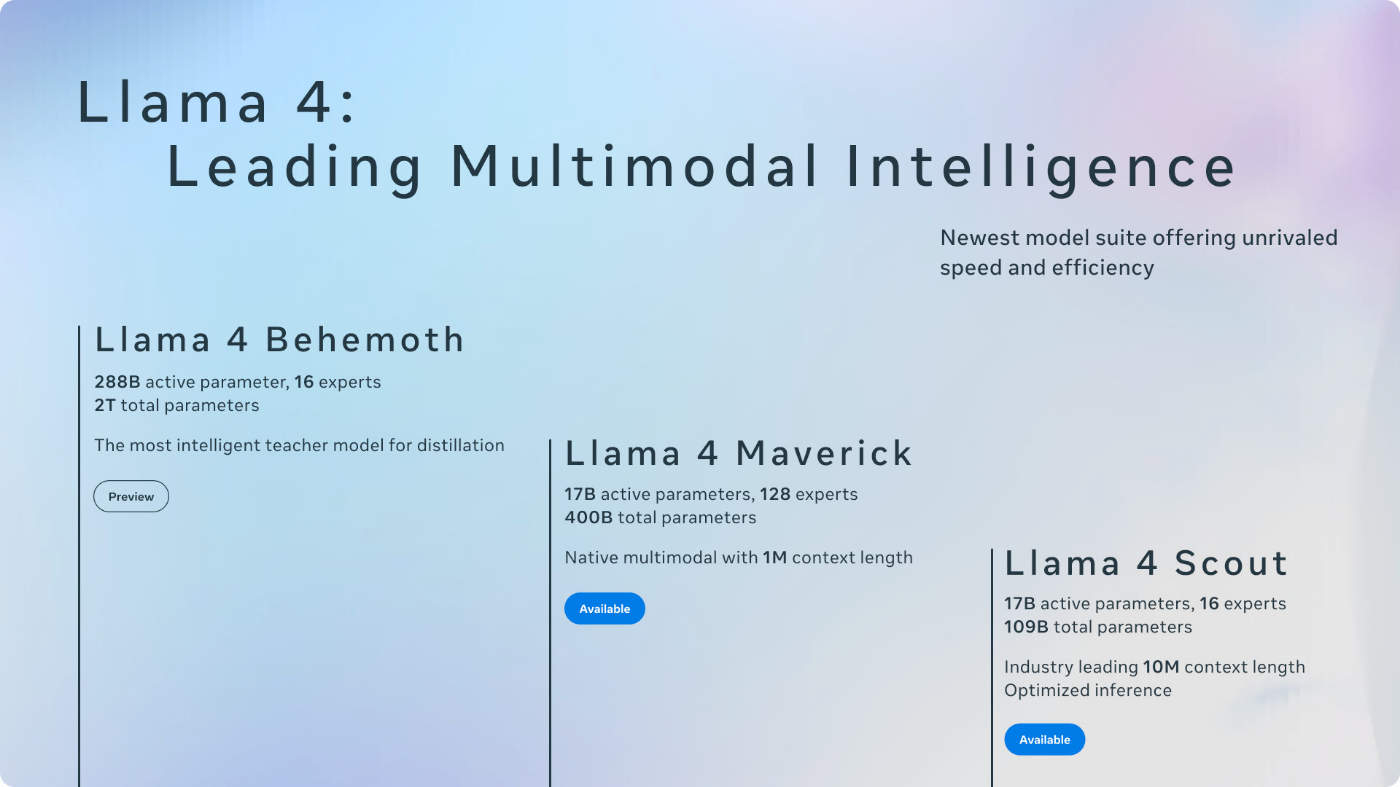

本日、Llamaの最新版4がMetaからリリースされました。本記事はLlama 4がRAGに与える影響に関する記事です。まだ実際に動かして確認していないので、その辺に転がっている情報を拾ってきて書き殴っている内容です。

Meta公式の記事:

日本語で解説している記事:

Llama 4の何が凄いのか?

あくまでもRAGでLLMを利用する観点からだけですが、Llama 4で気になっている凄い点は以下です。

トークン数が10M (1000万)!

Llama3は128Kだったので、Llama 4では約10倍のトークンを入力可能です。仮に1ページ1000トークンとすると、1万ページのドキュメントをそのまま入力しても処理してくれそうです。

ネイティブマルチモーダル

テキスト、画像、動画データなどを同一モデルで処理可能であるため、Llama 3.2 Vision みたいなこれまでのような派生はなくなりそうです。

1xH100で動くほどに軽量?

Llama 4 Scoutは、推論用に最適化され、内部的に16のエキスパートを持つトータル109Bパラメータのモデルです。そして、NVIDIA H100 1基で動作可能とのことです。

ただし、109BパラメータもあるのでVRAMがその2倍の200GB前後はないと動かせないと思われるため、やはりGPU 1基で動かすにはVRAMがボトルネックになりそうな気がします(4bitなどに量子化したモデルであれば動かせると思います)。

Macでも快適に動く(ただし量子化は必要)

Llama 4 Maverick 17B 400BのQ4(4bit量子化)モデルをMacで動かしているポストを見つけました。

このサイズ(Q4だけど)でむっちゃ普通に動いている用に思います。ただ、メモリはQ4であっても220GB以上消費しているので、やはりボトルネックはVRAMになりそうです。

RAGに与える影響

これまではLLMに入力出来るトークン数の制約などから、文章をいかに上手に区切ってデータベース化して、該当する部分を効率的に検索してLLMに入力するということをやってきました。

今回、Llama 4のようにLLMに10Mトークンもそのまま入力出来るとなると、愚直に考えれば今までやってきたことをもうやらずに必要なドキュメントそのまま入力すれば良くね?ってなりますね。

マルチモータルなのも嬉しくて、画像認識用に別のLLMを用意してあれこれとかしなくても良いですし、本当にドキュメントそのまま入力しちゃえな世界になるかもしれません(精度が出なくて結局あれこれやる必要があるなどは安易に予想できますが)。

とりあえず早くLlama 4を試してみたいですね。

Discussion