【ChatGPT】GPT-4 Turboを使ってみた

はじめに

この記事では、最近 OpenAI から発表された GPT-4 Turbo を使って精度と処理速度の検証結果をまとめています。執筆時点(2023 年 12 月)では、 Azure 上で preview 版として利用できるので、AzureOpenAI (以下AOAI)を用いて検証していきます。

※AOAIのリージョン設定はスウェーデン中部にしています。

※APIバージョンは2023-07-01-previewを利用してます。

GPT-4 Turbo とは

ひとことでいうと、「学習データを拡張し、速度を早くした GPT‐4」 です。

ChatGPT の学習データは2021 年 9 月までに限定されているという点がネックでした。

時代の流れや変化が凄まじいこのご時世、その制限は非常に大きな課題です。

GPT-4 Turbo では2023 年 4 月までのデータが学習されています。

プロンプトのトークン容量も拡張されています。

GPT-4 はこれまで最大 32k まででしたが、GPT-4 Turbo は最大 128k までプロンプトを入力可能です。

300 ページの本 1 冊分の単語を入れられるようです。すごい。

トークンあたりの料金も安くなっているようです。(Azureの公式ドキュメントにはまだ記載がなかったので具体的な金額は割愛します。)

とはいえ 128k もプロンプトを入れたら、1 回の呼び出しでかかる料金はだいぶ高くつきますね。

検証 1:最新情報が取れるかどうか

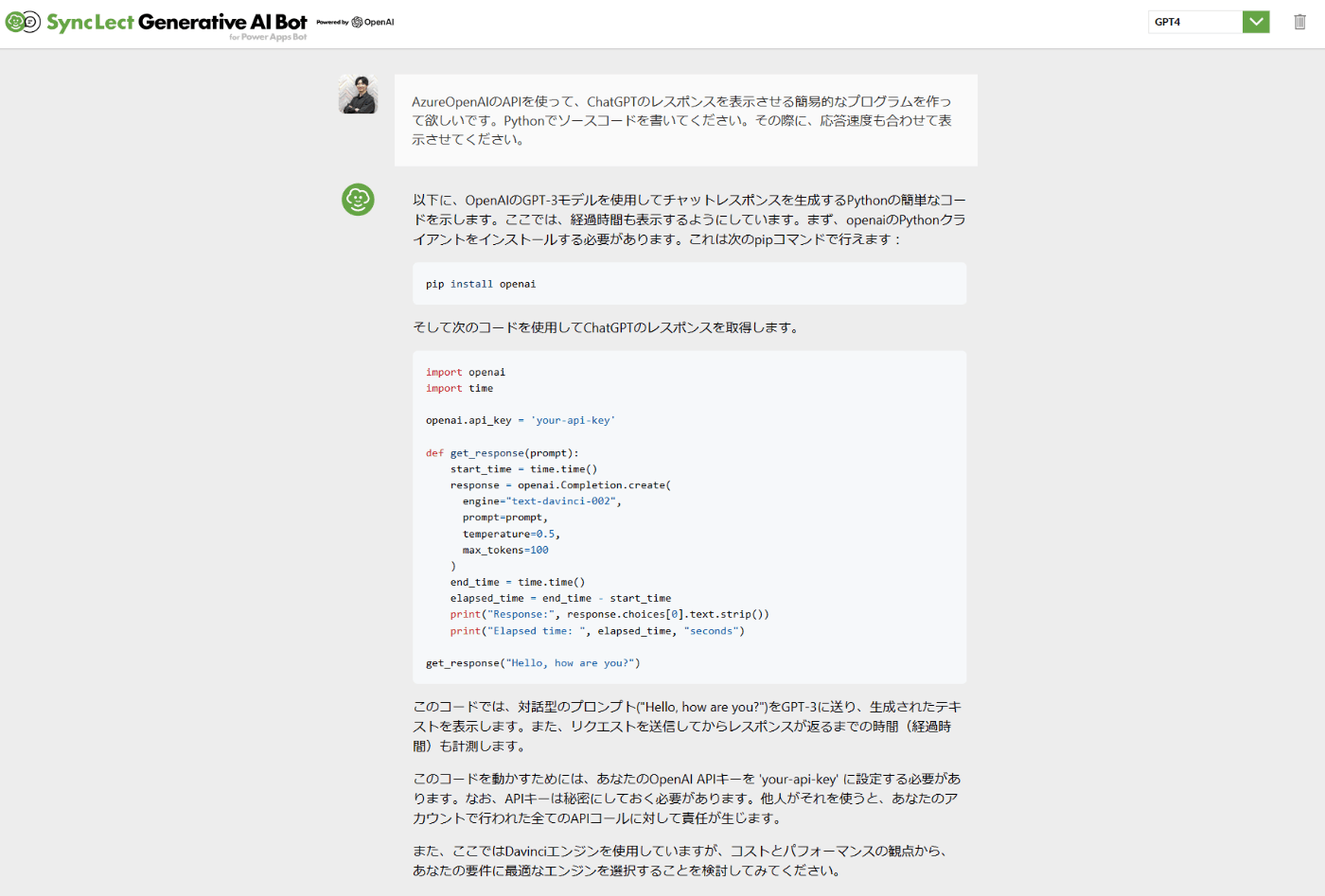

新しい情報を取得できるかどうかを検証するために、AOAI の API を使って ChatGPT のレスポンスを取得するプログラムを作るように指示をしました。ついでに次の検証で処理速度を測りたいのでそのプログラムも合わせて作ってもらいました。

AOAI を使ったプログラムを作ることができるか

いい感じに答えてくれていますね。

主要ニュースなどに答えられるか

2023 年は微妙でしたが、2022 年は答えてくれました。内容も合っています。少なくとも 2021 年以降の情報は学習されている事はわかります。

ちなみに、今回検証に使用したツールは

株式会社ヘッドウォータースが提供している

SyncLect Generative AI(読み方:シンクレクトジーエーアイ)と、その簡易版の AI チャットボットです。

Azure を使ったセキュアな環境で、最短 1 日でChatGPTを導入することが可能です。(toB向け)

検証 2:処理速度がどれくらい速いか

簡単に作ったプログラムを元に、平均処理時間の比較をしたいと思います。

全てのトークンの合計が ~500 トークン、5,000~10,000 トークンの2パターンを検証してみます。各トークン量につき、「同じ質問を 10 回 繰り返して、その平均処理時間を算出する」という流れを 3 セット行います。3 セットの平均も出して速度を比較していきます。

※質問とその回答は内容が長すぎるため割愛します。

~500 トークン

| # | GPT-4 | GPT-4 Turbo |

|---|---|---|

| 1 | 10.330 seconds | 19.388 seconds |

| 2 | 9.888 seconds | 22.219 seconds |

| 3 | 9.977 seconds | 22.011 seconds |

| 平均 | 10.065 seconds | 21.206 seconds |

5,000~10,000 トークン

| # | GPT-4 | GPT-4 Turbo |

|---|---|---|

| 1 | 17.545 seconds | 26.542 seconds |

| 2 | 20.262 seconds | 23.325 seconds |

| 3 | 19.671 seconds | 20.023 seconds |

| 平均 | 19.159 seconds | 23.296 seconds |

結論

今回検証した GPT-4 Turbo は、学習データが 2023 年 4 月まで拡張されているようでした。

速度に関しては、速くなっていないどころかむしろ遅くなってるようです。

原因として考えられるのは以下の3つかなと考察しています。

- preview版であるためSLAが設定されていない

- 物理的にデータセンターが遠い(日本←→スウェーデン中部)

- GPT-4 Turboを利用できるリージョンが限られているため、サーバーに負荷がかかっている

速度検証するには時期尚早だったみたいです。

GA(General Availability)されたときに改めて検証してみたいと思います。

最後までご覧いただきありがとうございました。

Discussion