FramePackで動画生成してみた

記事執筆のきっかけ

Googleのおすすめ記事に、『lllyasviel氏が画期的な動画生成AIをGitHubリポジトリで公開』という記事が目につき、出力された動画を見るとクオリティが高かったので、これは試さねばと思い立ちました。

lllyasviel氏といえば、画像生成AI界隈ではとても著名な方で、Stable Diffusionの拡張機能であるControlNetの開発などで知られています。

ひとまず結果

Twitterですでにかなりの数の動画生成結果が公開されていますが、中でもフィギュア系のクオリティが高いなと感じて、題材は家にあったフィギュアにしてみました。

zennが.mp4対応していないため、gifでしか見せられないのが残念です😿

導入手順

要求されるPCのスペック

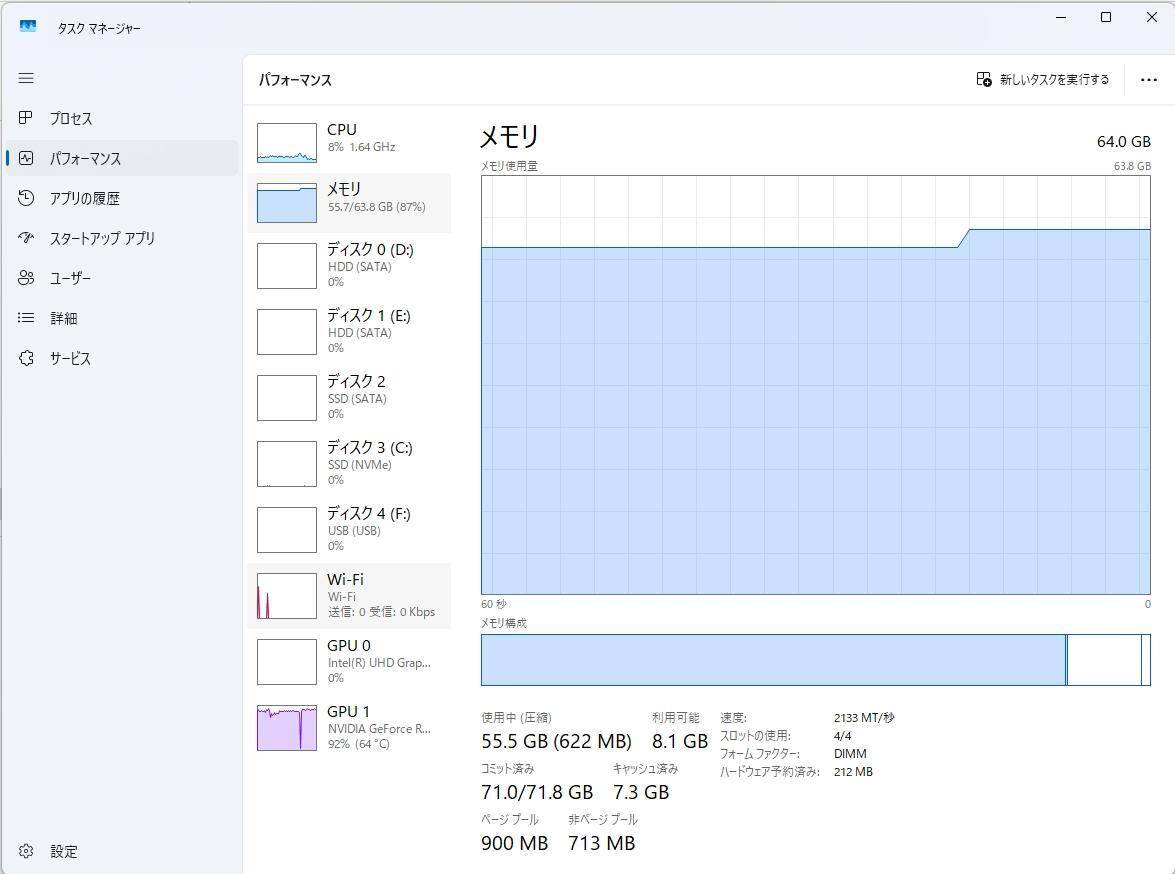

自分は、以下のスペックで実行できました。

FramePackはVRAMの容量が少なくても生成できるような仕組みがあり、GPUはRTX4090のようなハイエンドGPUでなくても動きます。自分は今回NVIDIAのRTX3060(VRAM=12GB)を使用しました。最低でも6GBあれば良いとのこと。

ただし、RAMはかなりの容量が必要で、推奨は64GBかと思われます。実際に動かしたときのタスクマネージャー画面を確認すると、55GB消費していました。

また、ダウンロードするモデルもかなり大きくて30GB以上のディスクの空きが必要です。

インストール

基本的には公式のGithubリポジトリに記載された通り実施すればよろしいかと。

現在はワンクリックパッケージが提供されており、Windows環境だとそれをダウンロードしてupdate.batを実行すればOK。

実行手順

GUIの起動

以下のコマンドで起動します(確かupdate.batでもそのまま起動してたかと思います。)

python demo_gradio.py

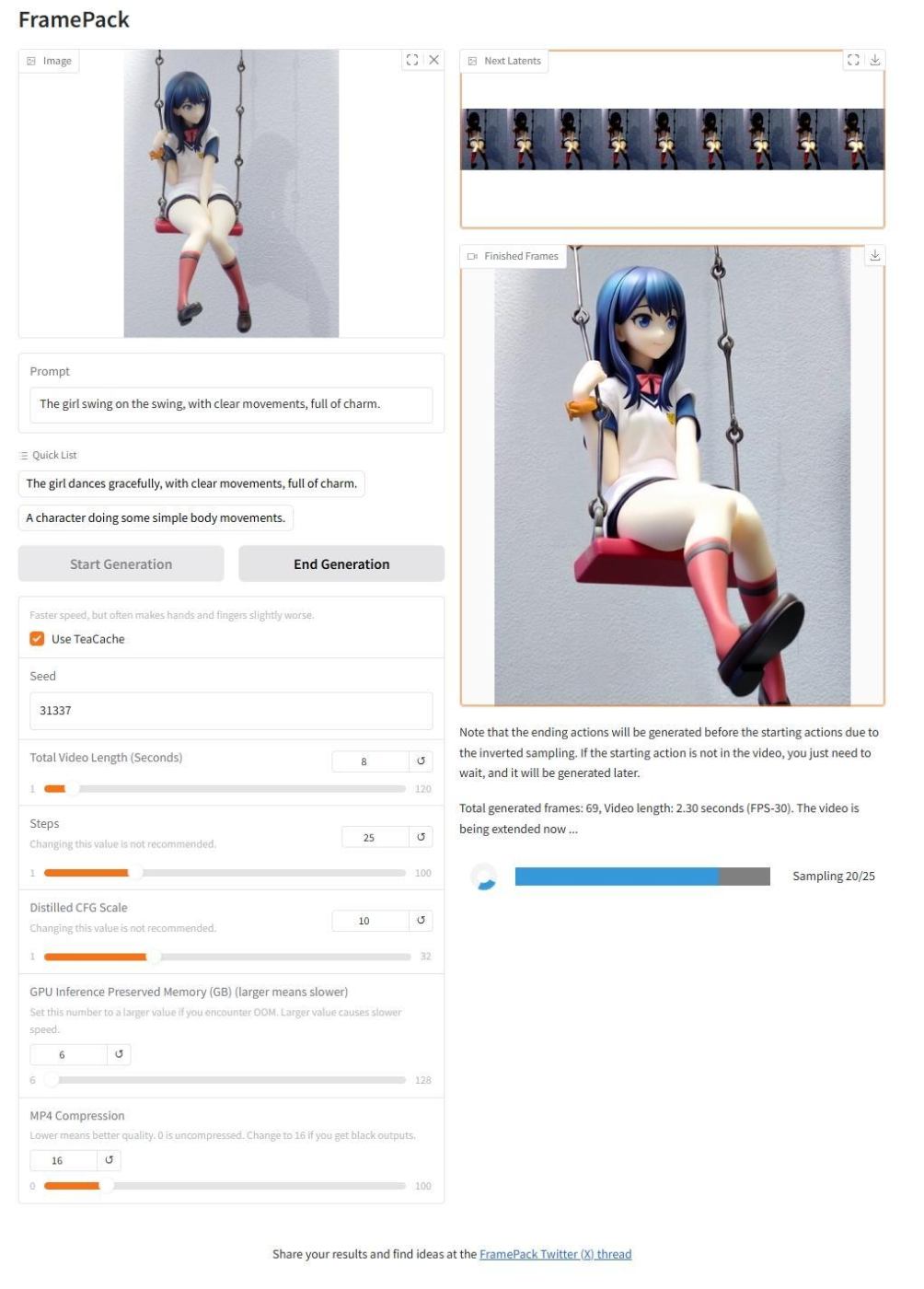

画像と各種設定、および生成実行

画面左側で、入力の元絵画像を1枚ドラッグ&ドロップして、プロンプトを入力し、動画の時間を設定して、「Start Generation」をクリックすればOK。

入力した画像

実行中のGUI画面

他にも、設定パラメータがありますが、基本デフォルトを推奨します。

プロンプトは、GUI上にサンプルもあるので手っ取り早く生成したい人はそちらを入力すれば良いかと。

生成開始すると、右画面に途中結果が表示されます。失敗しているかどうか生成途中でわかるので、便利です。

生成時間ですが、1秒(30fps)につき、RTX3060だと5分~10分ほどかかります。

※使用した画像のサイズは、512×683、512×512の2種類です。

所感

それまで、高スペックPCを持つ人にしか許されなかった動画生成ですが、そのハードルがグッと下がった印象を受けました。

また、生成される動画のクオリティも高く、破綻が少なかったのが画期的だなと感じました。

調べてみると、フレームを時間とは逆行して生成し(逆時間順序生成)、初期段階で最後の1フレームを生成し、両方向からの一貫性を保証する仕組みがあるそうです(早期確立エンドポイント)。

特にフィギュアが動いた時は魔法がかかったかのようにイキイキして動いたので、とても面白いです!!これなら、クリエイティブ分野においても結構実用性高く使えるのではないかと思います。

Discussion