🔥

[Snowflake Summit2025 参加記] 統合プラットフォームとしてのオーケストレーション

はじめに

2025年のSnowflake Summitで開催されたセッション「Future-Proofing Your Data Team: Embracing DataOps and Modern Best Practices」に参加しました。このセッションでは、現代のデータチームがパイプライン構築者から戦略的なビジネス推進者へと進化していく中で必要となるDataOpsのアプローチについて詳しく解説されました。

スピーカー紹介

Steven Hillion - SVP, Data and AI, Astronomer

- Apache Airflowプロジェクトへの主要貢献者(全貢献の50-60%)

- Astronomerでデータエンジニアリングチームとデータサイエンスチームを統括

- 月間数百万のタスクをSnowflakeで実行する大規模データ環境を運営

- 数万のAirflowチームの利用パターンを観察・分析

セッション内容

1. データチームが直面する現代の課題

セッションでは「データチームは一般的に幸せではない」という言葉から始まりました。その理由として以下の課題を挙げています:

技術環境の断片化

- 様々で複雑な技術スタック

- データサイエンス・機械学習チームでの技術選択の無秩序

- 組織内チーム間での技術的不統一

プラットフォーム運用の複雑さ

- 自社開発フレームワークやオープンソースフレームワーク(Airflowなど)の維持

- インフラ運用・保守などの本来のビジネス価値を生まない作業への多大な労力投入

リソースとスキルの制約

- データエンジニアの過負荷

- データチームをサポートチケット対応部門として扱う誤った認識

- ソフトウェアエンジニアリングの規律に基づいた運用の欠如

可視性の欠如

- データエコシステム全体の健全性を把握できない

- 航空管制やDevOpsダッシュボードのような包括的な監視体制の不在

2. オーケストレーションがDataOpsの基盤である理由

そういった課題の解決策として、「オーケストレーション(特にAirflowのようなフレームワーク)こそがDataOpsの基盤である」という主張が展開されました。

※DataOpsとは?

また、データチームが「幸せではない」状況を打破するために、オーケストレーションが重要な役割を果たす理由として、以下の点が挙げられました:

統合プラットフォームとしての役割を担うため

- すべてのデータを一つのシステムで統一管理することは現実的ではないため、複数の異なるシステム間をつなぐ橋渡し役として機能

- 様々な技術やツールを共通のオーケストレーション基盤で一元管理

- Airflowは約500のインテグレーション(Snowflake、Spark、SageMaker、Fivetranなど)を提供

チーム間コラボレーションの促進するため

- 共通フレームワークでの運用により、チーム間の連携が向上

- DAG(有向非循環グラフ)のグラフとしてデータ環境を構築

- ガバナンスと可観測性が自然に実現される

3. Airflowでのパイプラインの実装事例

MLパイプラインの構成

- 特徴量の生成のパイプライン、モデルの再学習のパイプライン、推論のパイプラインを管理

- slackへのアラート通知も管理

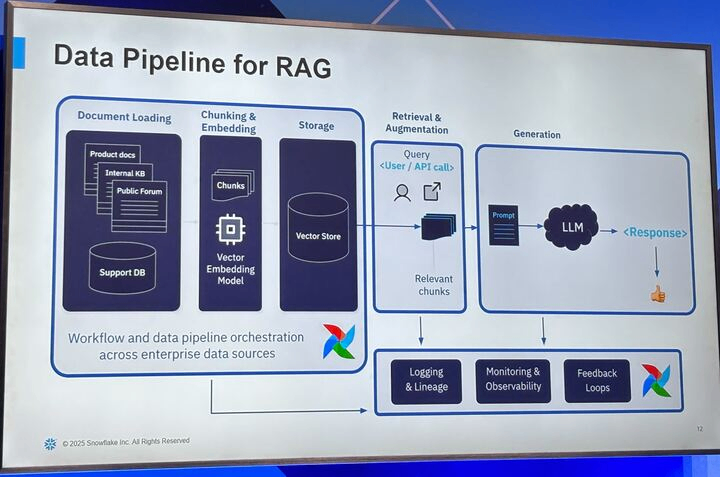

生成AI(RAG)のパイプラインの構成

- ChunkingやEmbeddingなどの処理も依存関係を持たせて実行

- LLMの出力のFeedbackなどの処理もまとめて管理

- 生成AIに関連する新しい技術であっても一元管理することができる

まとめ・感想

実際にセッション参加者に「これらのDataOpsの原則を遵守している」と感じるデータチームの人を尋ねたところ、ほとんど手が上がってませんでした。組織内チーム間での技術的不統一は多くの企業で共通する課題なのかと思います。技術的な統一よりも、まずは共通のオーケストレーション基盤から始めることが現実的な解決策となるとの主張で、弊社もデータ加工のパイプラインをpythonからdbtへの移行した際に同様なアプローチを(たまたま?)とっていて、うまく移行が進んだので納得感がありました。

現実的で実践可能なDataOpsアプローチを提示した非常にためになる内容でした。

Discussion