音声の多様な情報を引き出し、機械に伝えるためのパラ言語認識〜意図態度認識・感情認識で何ができるようになるのか〜

はじめに:機械が人の発話を理解するためには意図・態度・感情の認識が必須

近年、流暢な会話調の文章を自動的に生成する技術が登場し、人と日常会話が可能な機械が実現することに期待が高まっています。テキストを入出力としたチャットでは、すでに機械が流暢な応答をしてくれるようになったのは皆さんも実感なさっていると思います。

一方で、人と機械が音声で対話することを考えてみましょう。音声には、テキスト(言語情報)では表現することができない、多種多様な声のニュアンス(パラ言語情報)が含まれています。テキストにすれば全く同じ内容であっても、例えば声色の違いによって、伝えている意味が正反対になることすらあるのです。そのため、音声で人と円滑に会話を行うことができる機械を実現するためには、音声に含まれる多様なパラ言語情報を機械が認識するための技術が欠かせません。

そこで本記事では、パラ言語情報の認識技術の中でも特に重要な意図・態度認識と感情認識について紹介します[1]。これらの機能を備えることで、人と機械とのやりとりの齟齬が減り、機械に対する信頼と安心感が高まり、円滑でストレスのない会話が可能になります。また、機械と心の通った会話を行えているように感じさせて、親密感を高めることもできるでしょう。

対話における意図・態度・感情の役割

対話における意図・態度・感情は、話し手の意思や状態を伝えることで、聞き手に何らかの応答を促す役割があります。この節で詳しく説明していきます。

「意図・態度」とは、話し手が意識的に伝えようとする要求や、察してほしい話し手の内的な意思を聞き手に伝えるものです[2]。「感情」とは、話し手の内的な情動状態を聞き手に伝えるものです[3]。

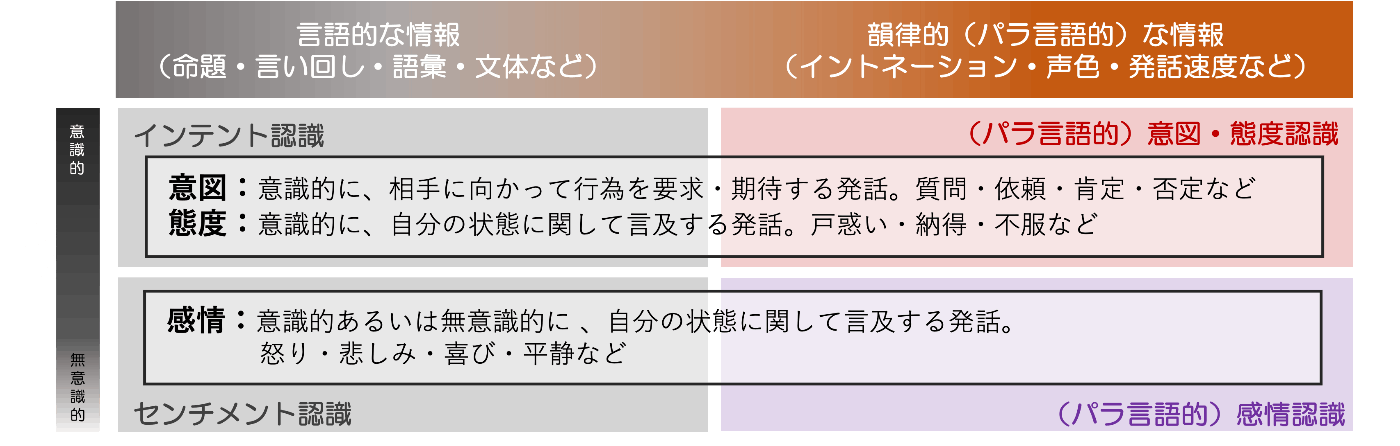

音声には言語的な情報だけでなく、声質・声の高さ・発話速度・音量といった韻律的な情報も含まれています。言語的・韻律的な情報のどちらにも話し手の意図・態度・感情を伝える機能があります。従来の音声対話システムでは、主に言語的な情報のみを扱ってきました。言語的な情報から話し手の意図・態度を推定する技術をインテント認識と呼び、また言語的な情報から話し手の感情を推定する技術をセンチメント認識と呼びます。いっぽう、近年の音声対話システムでは、韻律的な情報を扱うことが盛んに試みられています。これが本稿で扱うパラ言語認識の技術です。この関係を図1にまとめました。

図1 意図・態度・感情を扱うためのパラ言語認識技術

(文献 [1] より一部を抜粋した上で、変更を加えています)

人同士の会話では、言語的な情報が伝える情報はさほど多くなく、人は意図・態度・感情のかなりの部分をパラ言語を使って表現していると考えられています。また、皮肉発話のように、言語的な情報からは話し手の本心はわからず、韻律的な情報に本心があらわれる場合もあります [2]。

例えば「悲しみ」の感情を伝えることを想像してみてください。悲しみの思いを文章にして伝えるのは大変だし、はっきり言葉にしなくても悲しみの気持ちを察してほしい、と思うこともあるのではないでしょうか。人同士であれば、例えばゆっくりした話し方や、沈んだ声色、下向きの音調から、あなたの悲しみを相手に伝えることができます。

「考え中」の態度を伝えたい場合はどうでしょうか。「今私は考え中である」という態度を文章にして考えるのは面倒で、手間がかかると思う場合もあるでしょう。いっぽう、パラ言語では発話の末尾を伸ばしたり、平坦な音調を使ったりすることで、次の言葉を考えているのだ、という内部状態を容易に相手に伝えることができます。

このように、言葉にするよりも韻律的・パラ言語的な情報での表現の方が直感的で、自然だと感じられる対話の状況は多くあります。言語情報しか理解できない機械と会話するのは、まるで日常会話をテキストチャットのみで行うようなもので、誤解やすれ違いが起こることは当然といえます。パラ言語情報による意図・態度認識と感情認識を機械に組み込むことで初めて、円滑でストレスのない対話が実現できるのです。次の節では、意図・態度・感情を理解できる機械が、実際にどのようなことができるかをみていきます。

意図・態度・感情認識技術を組み込んだ音声対話システム

従来の音声対話システムでは、音声認識によって文字起こしされたテキストのみを使って後続の自然言語理解の処理を実行していました。しかし音声認識の過程で、音声の持つパラ言語情報はほとんど失われてしまいます[4]。いっぽう、音声認識に加えて意図・態度認識器と感情認識器を用いることで、音声の持つ情報をもれなく機械が扱うことができます。

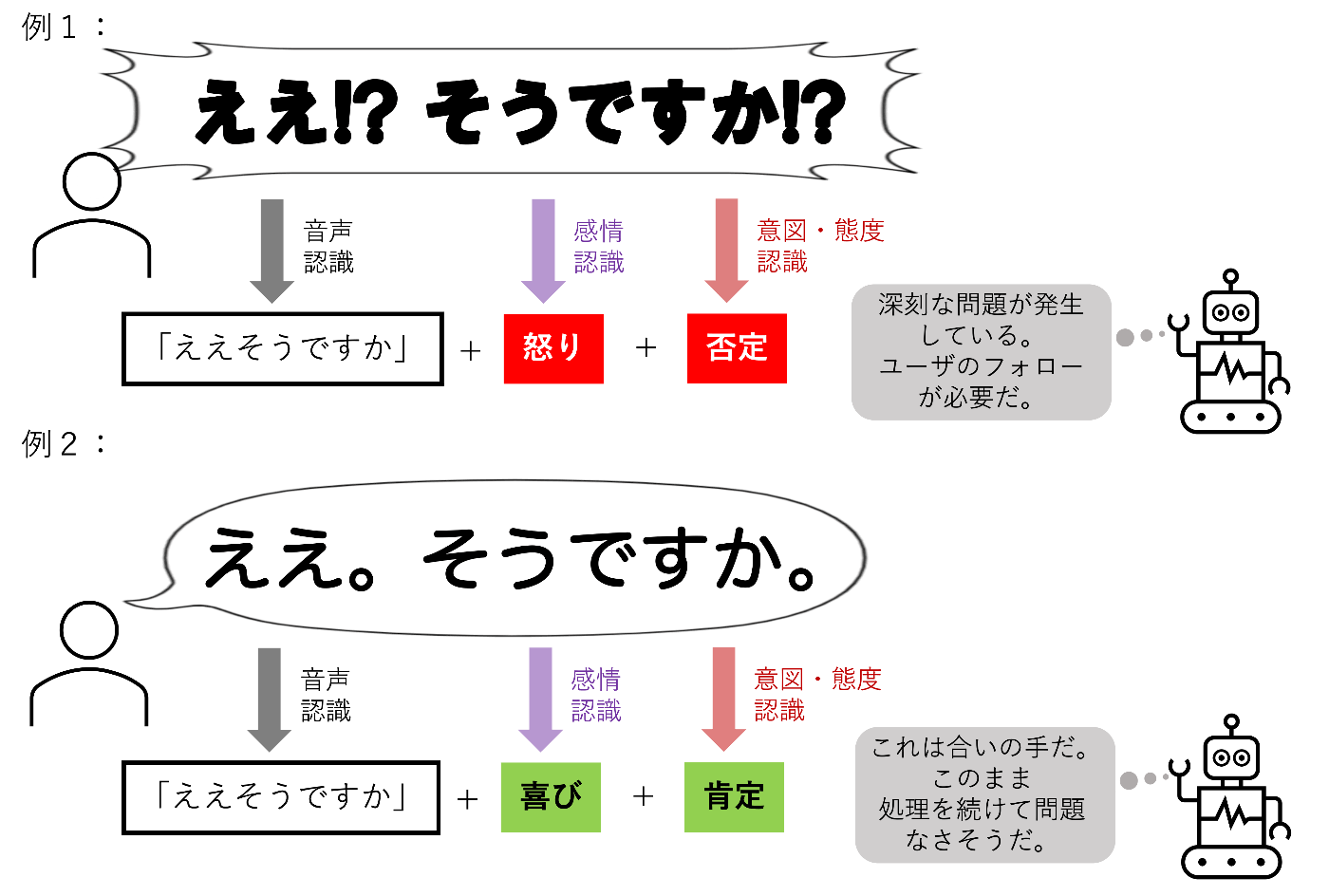

図2は、意図・態度認識と感情認識の機能を組み込んだ音声対話システムのイメージ図です。図2の例1と例2では、いずれも音声認識の結果は「ええそうですか」であり、従来の対話システムではユーザの発話の違いは理解できません。いっぽう、意図・態度認識が可能な機械は、例1が否定的、例2が肯定的なニュアンスで話されていることを理解できます。したがって例1の場合のみ、機械からユーザへの何らかのフォローアップが必要である、と判断することができます。さらに感情認識が可能な機械であれば、例1のユーザは怒っており、緊急かつ丁寧なフォローアップが必要なことも判断できるでしょう。

図2 意図・態度認識と感情認識機能を備えた音声対話システム

このように、意図・態度認識と感情認識は、音声対話システムがユーザと円滑なコミュニケーションを行うための必須のモジュールとして機能します。各モジュールの違いは以下の通りです。

- 意図・態度認識は、ユーザが対話システムにやってほしいこと(意図)や、察してほしいと考えていること(態度)を認識します。

- 感情認識は、ユーザが対話システムに理解していてほしいと期待しているユーザの内的な感情状態を認識します[5]。

これらの認識器は組み合わせても使っても、別々に使っても問題ありません。次以降のセクションでは、実際に意図・態度認識と感情認識が何を認識していて、機械との対話にどのような効果がもたらされるのかを紹介します。

意図・態度認識で可能になること

このセクションではパラ言語による意図・態度認識技術について説明します。

意図・態度認識では、ユーザが音調(イントネーション)などのパラ言語を使って表出した意図・態度を推定します。これによって、音声対話システムがユーザの意図・態度に基づいて適切な応答や振る舞いを決定することができるようになります。

音声対話システムの応答決定のために特に重要となる4つの意図・態度クラスを以下に示します。

| クラス | パラ言語の例 | ユーザの意図 | ユーザの態度 | システムの応答 |

|---|---|---|---|---|

| 肯定 | 下降音調 | 「そのまま続けて」 | 賛成である、満足である | 現在のアクションを続行、次に進む |

| 否定 | 上昇音調 | 「やめて」「一旦止めて」 | 反対である、不満がある | 現在のアクションをキャンセル、指示を求める |

| 疑問 | 上昇音調 | 「詳しく教えて」「もう一度教えて」 | 理解できない | 質問に回答、前の発話を言い直す |

| 考え中 | 平坦音調 | 「待って」 | 懸念がある、迷いがある | 指示を待つ、追加情報を提示 |

人はこれらのパラ言語を発話したり理解したりすることが比較的容易にできます [3]が、意図・態度認識器を持たない従来の音声対話システムはユーザのパラ言語発話を理解できず、適切な応答を行うことができません。結果として、対話の齟齬が発生したり、ユーザに何度も言い直しを要求したりすることになります。このようなシステムのユーザは、パラ言語を使わずに、文法的に正しい(すなわち、言語情報のみを使った)話し方で、システムに自分の意図・態度を伝えることを学習する必要があるでしょう[6]。結果として、対話の円滑さが著しく低下することになります。

いっぽう、音声対話システムが意図・態度認識器を持つ場合、ユーザが言語情報・パラ言語情報のいずれかで表出した意図・態度を、システムは漏れなく理解することができます。これによって人とシステムの円滑でストレスのない対話が実現できます。

感情認識で可能になること

このセクションではパラ言語による感情認識技術について説明します[7]。

感情認識では、ユーザが声の大きさや声色などのパラ言語を使って表出した感情を推定します[8]。これによって、音声対話システムがユーザの感情に基づいて適切な応答や振る舞いを決定することができるようになります。

代表的な感情のクラスと、それに対する音声対話システムの応答例を以下に示します。

| クラス | パラ言語の例 | ユーザの感情 | システムの応答 |

|---|---|---|---|

| 喜び | 上向きの音調 | 肯定的で高揚した気分 | 現在のアクションを続行、共感的発話を行う |

| 悲しみ | 下向きの音調 | 否定的で落ち込んだ気分 | 現在のアクションを中断、ユーザへのフォローを行う |

| 怒り | 急激に変化する音調 | 否定的で攻撃的な気分 | 現在のアクションを中断、ユーザへのフォローを行う |

| 嫌悪 | 下向きの音調 | 不快感に基づく否定的な気分 | 現在のアクションを中断、ユーザへのフォローを行う |

| 平静 | 通常の音調 | 特に何の感情も持たない状態 | 現在のアクションを続行 |

感情認識器を持たない従来の音声対話システムは、ユーザの感情状態を理解できません。これによって、例えば怒っているユーザに適切なフォローアップを提供できなかったり、悲しんでいるユーザに不適切な情報を提供するなどして、ユーザを失望させ、システムに対する信頼と安心感を損なう可能性がありえます。

いっぽう、音声対話システムがユーザの感情状態を理解できれば、ポジティブな感情や平静感情のときは処理を継続する一方で、ネガティブな感情が検知されたときは処理をいったん中断し、ユーザへのフォローアップを行うなどして、システムに対する安心感を獲得することができるでしょう。あるいは、システムが適切なタイミングで共感的発話を行うことで、システムに対するユーザの親密感を高めることもできるかもしれません[9]。

フェアリーデバイセズが提供するパラ言語認識技術

フェアリーデバイセズでは、意図・態度認識器 mimi®︎ AIR (Attitudes and Intentions Recognition) と、感情認識器 mimi®︎ EMO (EMOtion recognition) を提供しています[10]。音声対話システムの要件に応じて、柔軟にmimi®︎ AIR および mimi®︎ EMO を使用した機能追加が可能です。以下に事例を示します。

- 音声対話システムの対話制御モジュールが自作の場合:音声認識の認識結果に加えて、新たにmimi®︎ AIR や mimi®︎ EMO の出力結果を受け付けるように、対話制御モジュールの入出力をカスタマイズすることが有効です。

- 音声対話システムの対話制御モジュールに既存のものを使用する場合:対話制御モジュールの入出力をカスタマイズできない場合でも、mimi®︎ AIR や mimi®︎ EMO の結果を反映するように、入力テキストのプロンプトを工夫することができます。

mimi®︎ AIR で正確な意図・態度を推定するためには、発話の終端(話し手が話し終わったタイミングの音声)を正確に切り出して入力することが重要です[11]。そのため、一問一答対話であれば発話区間検出器、雑談対話であればターン終端検出器との併用が有用です。mimi®︎ EMO では、発話の終端の正確な切り出しは必須ではありませんが、数秒以上の長い音声を入力することが重要です[12]。

おわりに:音声の多様な情報を扱える機械の実現のために

パラ言語による意図・態度認識や感情認識を音声対話システムに組み込むことで、どのようなことが可能になるかを紹介しました。

音声認識のみを搭載した従来の音声対話システムは、音声の情報のごく一部しか扱えていませんでした。そのため、仮に音声認識を完璧に行えたとしても、それだけでは人が音声に込めた情報を正しく理解することは不可能です。いっぽう、パラ言語情報を扱うことのできる音声対話システムは、ユーザとのやりとりの齟齬が減り、ユーザの機械に対する信頼と安心感が高まり、円滑でストレスのない会話が可能になります。今後の音声対話システムにおいては、パラ言語情報の認識は「あるとうれしい」機能ですらなく、なければユーザに著しい不便とストレスを強いることになる、あるべき必須の機能になることでしょう。

この記事で紹介した内容は、パラ言語を使った音声情報処理技術の一部にすぎません。パラ言語情報は話し手・聞き手双方のさまざまな対話の調整の機能も担っています。対話において人がどのような情報を使い、どのような種類の調整をおこなっているのかは、別の記事で詳しく紹介します。

参考文献

[1] 森 大毅, 粕谷 英樹, 前川 喜久雄, 日本音響学会 (編集), "音響サイエンスシリーズ12 音声は何を伝えているか 感情・パラ言語情報・個人性の音声科学," コロナ社, (2014).

[2] L. Zhongjie, Z. Bin, Z. Gaoyan, D. Jianwu, "Brain Network Features Differentiate Intentions from Different Emotional Expressions of the Same Text", Proceedings of the IEEE International Conference on Acoustics, Speech, and Signal Processing (ICASSP), (2023).

[3] 石井カルロス寿憲, "(招待講演)対話音声に伴うパラ言語・非言語情報の抽出および表出", 日本音響学会春季研究発表会, (2019).

[4] I. Kuramoto, J. Baba, K. Ogawa, Y. Yoshikawa, T. Kawabata and H. Ishiguro, "Conversational Agents to Suppress Customer Anger in Text-based Customer-support Conversations", Proceedings of the 6th International Conference on Human-Agent Interaction, (2018).

[5] Y. Sato and K. Miyazawa, "Statistical quality estimation for partially subjective classification tasks through crowdsourcing," Language Resources and Evaluation, vol. 57, pp. 31–56, (2007).

-

円滑な会話の実現のためにパラ言語情報が果たす役割には、例えば発話順番の制御や応答のタイミングの制御なども含まれますが、これらは今後の別の記事で取り扱います。 ↩︎

-

意図と態度の違いは明確には線引きできない一方で、「聞き手に対して、意図的に特定のメッセージを伝えている」という点はどちらも共通しています。そのため、ここでは「意図・態度」としてまとめて扱っています。 ↩︎

-

感情には話し手が意識して表出した感情(メッセージ)と、話し手が無意識的に表出した感情があります。パラ言語情報としての「感情」は、意識的に表出された感情のみを指しますが、本稿では厳密にはこれらを区別しません。 ↩︎

-

不完全ながらもパラ言語情報を文字に書き起こすことは可能です。例えば、疑問のイントネーションを「?」で出力する音声認識器もあります。笑い声は文字に書き起こすことができますが、話し手がどのような笑い方をしたのかまでは伝えきれません。感情を顔文字にするなど、他にもさまざまな文字化の方法があります。 ↩︎

-

実際の対話では、相手に自分の感情状態をどこまで正しく理解していてほしいと期待するかはケースバイケースであり、複雑な関係性に基づいて決まります。さらに相手が機械の場合、どの程度の共感的応答を期待するかは人それぞれであり、全く期待しない人から、人と同等に期待する人まで様々です。したがって、機械が自分の声から自分の感情状態を推定できるということを喜ぶ人もいれば、拒否反応を示す人もいるということは留意しておく必要があります。 ↩︎

-

既存の音声対話システム(カーナビゲーションシステムやスマートスピーカー等)のユーザは、パラ言語を使わない話し方をすでに習得しているといえます。これらのシステムに話しかけるときは、かなりかしこまった、かたくるしい、文法的に正しい話し方をしているはずです。 ↩︎

-

ここではパラ言語で表現された感情を推定する技術について述べています。自然言語処理の一種であるテキスト感情認識(センチメント分析)とは異なることに注意してください。テキスト感情認識では、音声認識の結果のみを使って話し手の感情を予測するので、パラ言語の感情を認識することはできません。 ↩︎

-

図1に示したように、「感情」は相手に察してほしい自分の状態(衝動や気分など)への言及です。「態度」は文化や言語による違いが大きいですが、「感情」はより文化普遍的で、生理的なメカニズムに基づいた内部状態であると考えられています。 ↩︎

-

音声対話システムの共感的発話に対するユーザの反応には個人差があるといわれています。特にネガティブな感情(怒りなど)に対して共感を示すシステムへの評価は、好き嫌いがはっきり分かれる傾向があるようです [4]。ポジティブな感情への共感は比較的リスクが少ないといえます。 ↩︎

-

フェアリーデバイセズのパラ言語認識モデルの研究開発に関しては、パラ言語認識の実用化のための半教師ありドメイン適応 や、文献 [5] でも詳しく報告しています。 ↩︎

-

日本語では発話の終端の音節のイントネーション(境界音調)に、パラ言語による意図・態度が特にあらわれます。 ↩︎

-

感情は意図・態度に比べて、発話全体のパラ言語情報にその特徴があらわれます。 ↩︎

Discussion