社内でAI駆動開発ツールの使用調査したら、たった1週間で『Claude Code』一択になっていた話

こんにちは!株式会社エクスプラザでリードエンジニアをやっている@Unsuです。

今回の記事では、社内でどんなAI開発ツールを使ってAI駆動開発をしているかをまとめてみました。

記事を書いたきっかけ

最近、チーム内で「最近これ便利なんですよ」とか「これはまだ限界あるなー」といった話が聞こえるようになり、そしてみんなそれぞれツール選びの違いが多く、これは一度まとめて記事にしてみても面白そうだと思い、社内でアンケートを実施してみました。

1回目のアンケートでは、いろんなツールを使い分ける実態や、それぞれの評価理由などが見えてきました。

その様子を記事としてまとめようと執筆を進めていたのですが、

1週間ほど経ち、「あれ?もしかして、みんな同じツール使ってない?」という違和感から、同じメンバーに再度アンケートを実施したところ、全然違う結果が出ていました。

今回は、その様子を記事にして見ました。

アンケート項目

まずアンケートは、以下の観点について、それぞれの開発チームメンバーに回答してもらいました:

- 実務で使用したことのあるAI開発ツール(複数回答可)

- 最近一番多く使っているツール

- そのツールを選ぶ理由

- AIと人手によるコーディングの比率

- AIを使ってうまくいったエピソード

- まだ限界だと感じる部分

1回目アンケート

1回目のアンケートは5月末に実施しました。

この時はちょうど、

- Claude CodeをGithub Actionsで回せる https://github.com/anthropics/claude-code-action

- Claude CodeのVSCode系IDE Extension(拡張機能)

が発表された次の日でした。

その1回目の結果をおさらいしてみると、こんな感じでした。

実務で使ったことのあるAI開発ツール

みなさん、今の会社で実務で使ったことあるよーというツールは結構いろんなものが入ってました。

- Cursor(5人)

- Claude Code(5人)

- Devin(4人)

- Windsurf(4人)

- OpenAI Codex(4人)

- VSCode Copilot(3人)

- Roo Code(1人)

- Zed(1人)

- IntelliJ Junie(1人)

- Cline(1人)

最近一番多く使っているツールとその理由

Cursorが40%ほど、Claude Codeが40%ほど、Devinが20%ほどでした。

それぞれ、理由としては:

- Cursor

- 会社の補助があるため

- 使い方に慣れていて、指示のコツを掴んでいて一番使いやすい

- Claude Code

- IDEに依存せずターミナル内で完結できるところが結構良い

- 新しいツールを色々試したいから最近使い始めた

- Intellijとの相性が良かった

- Devin

- プロジェクトキャッチアップ時にDevin Searchが整理された説明と該当コードを見やすく表示してくれる、ドメイン知識をつかむのにいろいろ役立つ。

特に、Claude Codeは「新しいものを試したいから」などの理由が見られていて、Cursorは使い方が慣れていたり、そもそも社員全員に支給していることから利用手続きにあたって楽だったりと、かなりバラバラな理由になっていました。

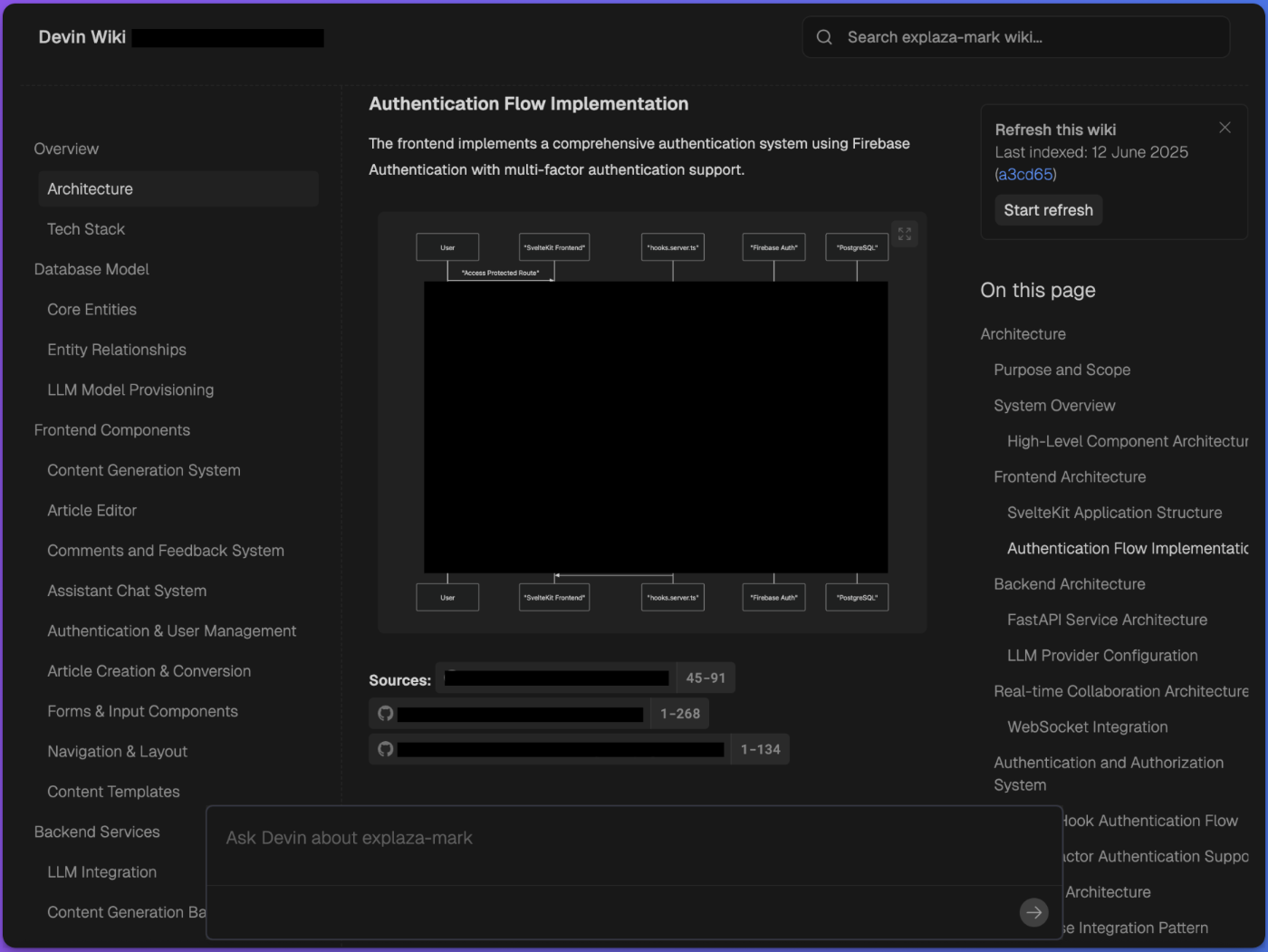

また、Devinに対しては入社した手のメンバーから「Devin Wiki」「Devin Search」がドメイン知識の習得に楽だったという意見もいただきました。

(社内のプロジェクトに対して自動で生成されたDevin Wiki)

ツールの使い分けやってますか?

次に聞いたのは、どういう時にどのツールを使うかなど、使い分けをしているかについてでした。

- 「コード把握にはDevin Search、開発作業にはCursor、非同期で調査や作業を進めさせたい時はDevinを使ってる」

- 「1ヶ月前は、開発全般をCursorで、長い調査が伴うが小さい修正が必要なバグ対応等はDevinやCodexに任せてます」

モデルの使い分けやってますか?

- プロジェクト全体の調査やドキュメント作成はGemini Pro 2.5 Preview 05-06、コードはClaude Sonnetを使っている

- 常に一番新しいものを使っている。けど、なんとなくドキュメント作成の仕事はgemini, コードはclaudeを使うことが多い。アウトプットに差を感じる

- あまり使い分けできておらず…!とりあえずClaude Sonnetの最新使っておけ状態になっています。

- 特にしていない、、、基本的に一番いいモデルを使うようにはしています。

- Opus 4にフルベット

Opus 4をすでに活用している方もいて、使ってからではの意見を持っている方もいました。

AIコーディング比率は半々くらい

1回目アンケートでは、AIコーディングの割合についても現場ごとにかなり幅がある様子が見られました。

主な回答を見てみると、

- 「手とAIの割合が9:1」「手8:AI2」みたいに、まだ手動コーディングが多いと回答した人もいる

- 「5:5」で“ちょうど半々”くらいという人もいる

- 一方で、「AI8割」「AI9割」といったように、TAB補完や自動補完もフル活用して“もう大半をAIに任せてる”という人もいる

「まだ手でやってる!」派から「もうAIに全任せ!」派まで、結構バラバラで、AIの使い方や浸透度合いが違うところが見えますね。

このように、1回目のアンケートでは多様なツール・使い分けのケースが見られましたが、

その状況が、わずか1週間で一変することになりました。

2回目アンケートで見えた「急激な変化」

1回目のアンケートから1週間後、同じメンバーに再度アンケートを実施しました。

一番多く使っているツール、「Claude Code」への急速な集約

2回目のアンケートでは、全員が「Claude Code」を最も多く使っていると回答。使われているのはCLIを始め、アンケートの1週間前に発表されたClaude CodeのIDE Extension、Github Actionsバージョンも。

使ってる理由を聞いてみると、

- 調査・計画・実装を一貫して自動化できる

- 開発進行が賢くなった実感

- 以前使っていたCursorでの自分のマニュアルな役割をClaude Codeがほぼ代替

- Github Actionsは非同期での調査や開発タスクに便利

なぜこれほど急速にClaude Codeに集約されたのか?

現場からは

- 最新のIDE ExtensionがVSCode系IDEやIntelliJにスムーズに組み込めて、日々の作業スピードが一気に上がった

- CLIだけでなくGitHub Actions対応も進んで、“やっと本当にAIでCI/CDを回せる”ようになった

- 切り替えに迷いがなかった

といった声が出ていました。

特に“他ツールだと部分的にしか自動化できなかった工程”も、Claude Code一つで「相談→実装→レビュー→マージ」まで一貫してAI任せにできるようになったことで、現場へのインパクトが爆発的に大きかったのかなと思います。

コーディングのAI活用割合の爆増

AIによるコーディングの比率も、圧倒的に増えました。

平均値としては、1回目のAI活用比率"39%"から"91.6%"まで、爆上がりでした。

1回目で半々と答えた人がAI8割になったと教えてくれたり、

すでにAIで8割活用していた人は主な作業はAIコーディング9.5割、手作業は0.5割(細かいデバッグや動作確認のみ)になったと答えてくれるなど、

これはClaude Codeの登場に対する大きな影響かもしれないですね。

AI駆動開発で「便利」と感じたこと

1回目、2回目を通してAI駆動開発での便利さについても聞いて見て、いくつか印象的だった回答をピックアップして見ました。

複雑なドメインの調査に頼れる

複数コンポーネントにまたがるモノレポでの処理フロー調査をAIに任せたら、コンポーネントをまたいだ流れも自動で調査してくれたという声がありました。

モノレポみたいな大規模なコード構成でも、AIを使うことで“どこで何が呼ばれているか”を一気に追えるようになったという声が多かったです。今まで手作業で追っていた人たちには、かなりありがたい仕事ですね。

事前調査・計画・Todoタスク分離・順次実行を自律的に任せられる

これは自分の話ですが、Cursorではいつもセッションを始めるとき、事前にAIに状況を把握させて、その後タスクのことを伝えて、それをいくつかのGithub Issues単位で計画・分離し、一つずつの分離されたセッションで実行させていました。こうしないと、長くなる一つのSessionで迷い始め、結果的には不完全なタスク遂行で終わってしまうことが多かったからです。

そうやって試行錯誤して掴んだコツが、Claude Codeを使うと自動的に一部は担えられている気がして、より支持が楽になったと感じました。

非同期で開発が任せられる

これは1回目・2回目通して出て体験で、CodexやClaude Code Github actionsを使って、PCを開いてなくても開発が進められる体験をしたことが便利だったと複数の人が意見をくれました。

特に、電車の中でGithubにつながっているClaude CodeとPR準備の作業ができたとエピソードを寄せてくれたのは興味深かったですね。

MCPを活用して、より精度の良い成果物に

"Context7 mcp経由で最新かつ信頼性の高いドキュメント情報をClaude Codeに提供でき、精度の良い開発ができる"という感想もありました。

AIが自律的に最新の技術ドキュメントを参照しながら実装を進めてくれる便利MCPですね。

まだ難しいと感じる部分・課題

一方で、まだ難しい・限界だと感じる部分についてもいくつか意見が寄せられました。

- ざっくりした指示ではAIが迷うことがあり、適切な指示のコツが必要

- プロダクションコードなど品質を意識する必要がある場面では、自分が生成されたコードの良し悪しを判断したり、AIの実行計画がおかしいときにツッコミを入れられるくらいスキルを持っていることが前提かな、とは感じています。

- TerraformまわりはProviderのバージョンを考慮してくれなかったり、少しセキュリティを考慮してなかったりと、ちゃんと見ないとなぁって感じはあります。

ここでは「AIがどれだけ賢くなっても、結局は“使いこなす側”の人間の方の力量や知見が要になる」という空気が伝わってきました。とくに品質やセキュリティ、複雑なインフラ領域では、AIのアウトプットを鵜呑みにせず、最終的な責任やチェックは人が担う体制がまだまだ必要という雰囲気ですね。

2回目のアンケートでは、Claude Codeへの急速な集約やAIコーディング比率の圧倒的な高さがとても印象的でした。

一方で、「どう指示を出すか」や「AIのコードをどこまで信用するか」、「インフラ・セキュリティのチェックはどこまで自分でやるか」といった、現場ならではの悩みや工夫もまだまだリアルに残っているのがわかりました。

まとめ

Claude Codeがチームに導入されてから、AI駆動開発に対する雰囲気がガラッと変わったなと感じます。

以前は「AIより自分で書いた方が速い」「複雑なタスクはまだAIには難しい」と感じる人も多かったのですが、今では「バグ調査や面倒な作業はAIに任せる」「実装はAIに任せて自分はレビューに集中しよう」という前向きな空気に変わりました。AIと一緒に働くことで、開発スピードも着実に上がってきたと実感しています。

これからAI駆動開発を試したい方は、Claude CodeでもChatGPTでもCursorでも、とにかくたくさん話しかけて、色々と試してみてください。質問や指示を少し変えたり工夫しながら、トライ&エラーで“自分なりのコツ”を掴んでみてください。

この記事が、AI駆動開発に挑戦したい方や自分のチームで広めたい方への参考になれたら嬉しいです。

最後まで読んでいただきありがとうございました。

「プロダクトの力で、豊かな暮らしをつくる」をミッションに、法人向けに生成AIのPoC、コンサルティング〜開発を支援する事業を展開しております。 エンジニア募集しています。カジュアル面談応募はこちらから: herp.careers/careers/companies/explaza

Discussion