日本特有の知識に特化した大規模言語モデルの学習および評価

はじめに

ELYZA 研究開発チームの大葉 (@dai0NLP)です。

本記事では、研究開発チームの最近の取り組み内容である 「日本特有の知識に特化した大規模言語モデルの学習および評価」 について解説いたします。

ELYZAは、日本の生成AIの開発力強化を目的とした経済産業省主導のプログラムである Generative AI Accelerator Challenge (GENIAC) に採択され、H100複数基をはじめとする計算資源の利用や関係者間の連携促進等のご支援をいただきながら、2024年5月から8月までの約3ヶ月間に渡り日本語汎用基盤モデルの開発を行いました。具体的には、日本でインフラとして利用されるような基盤モデルの構築を目指し、大規模言語モデルにまつわる以下能力の獲得および改善に取り組みました。

- 基本性能

- 日本特有の知識・表現に関する性能 (本記事の焦点)

本記事は、後者である、「日本特有の知識・表現に関する性能」に関する取り組みを解説したものになります。

弊社をはじめ、大規模言語モデルの開発者間にて日本語性能を高めるための知見が溜まってきていること、およびそれに付随する形でグローバルモデルに匹敵する国産モデルが開発できるようになったことは大変喜ばしい状況です。一方、一口に「日本語性能」と言っても日本語の特性や使用されるシーンは多岐にわたるため、実際どういった領域の日本語問題が解けているのか・解けていないのかについてもう一段解像度を上げることが重要であると常々考えておりました。GENIACへの採択を機に、この観点について本腰を入れて取り組むことが可能になったという背景があります。

本記事で解説する内容は以下の通りです:

- まず、「日本語性能」の意味する内容と現状の課題を再考する。

- その上で、未解決かつ社会的に価値のある日本特有の問題に関する特化ベンチマークを作成する。

- 最後に、そういった日本特有の問題を解くための特化学習を実施し、評価する。

なお、本ブログに関する研究開発は、中村 (@tyo_yo_)、佐々木 (@hikomimo)、Sam (@SamPassaglia)、平川 (@h__must__)、大葉で取り組み、大葉が代表して執筆しました。プロジェクトにおける開発環境の整備等は、developmentチームの堀江 (@eemon18) と高橋が担当しました。

また、この成果は、国立研究開発法人新エネルギー・産業技術総合開発機構 (NEDO) の「ポスト5G情報通信システム基盤強化研究 開発事業」 JPNP 20017 の助成事業の結果得られたものです。

”日本語性能”が意味するところを見つめ直す

日本語性能を測るための代表的なベンチマークとしては言語理解ベンチマークの JGLUEが挙げられます。JGLUE は lm-evaluation-harness や Nejumi といった leaderboard に組み込まれています。異なる観点の評価として、JGLUE系のベンチマークでは単語やフレーズレベルの出力が期待されており、”ユーザの役に立つ応答であるか” という側面を評価できないとして、Rakuda や ELYZA Tasks 100 などの言語生成ベンチマークも導入されました。

GENIACに採択された事業者をはじめ、多くの研究開発者の間では「日本語性能」を高くすることが一つの開発進捗指標となっており、その際には上に挙げたようなベンチマークが用いることが一般的となっております。弊社 ELYZA を例に挙げると、2024年6月には700億パラメータの日本語大規模言語モデル Llama-3-ELYZA-JP-70B を開発し、Japanese MT-Bench および ELYZA Tasks 100 などにおいて GPT-4 (0613) などの主要グローバルモデルを上回る日本語性能を達成したことを報告しました(参考)。

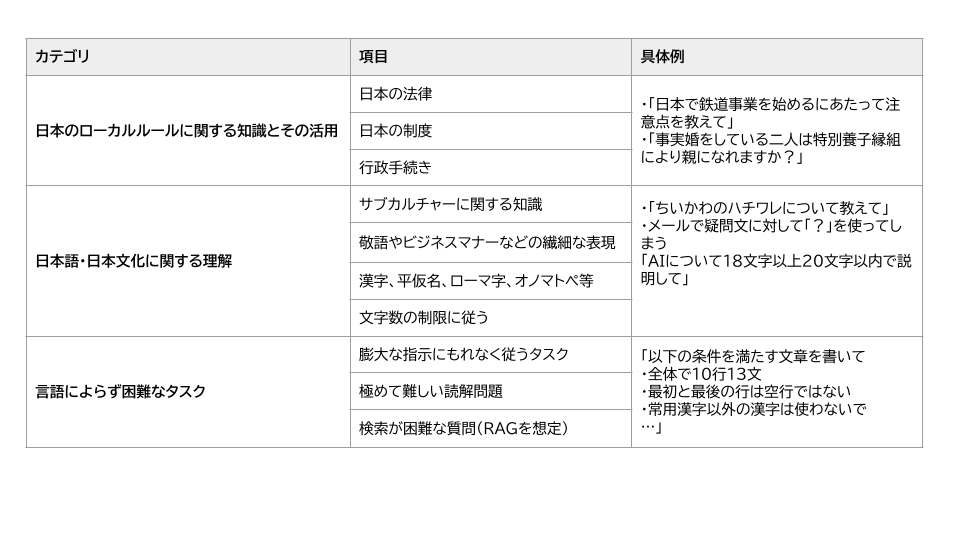

一方、基本的には既存の日本語ベンチマークは、多言語化が進んだグローバルモデルや、それらに匹敵する一部の国産モデルにとってはほぼ満点に近い精度で解けるようになってきており、より難易度の高い日本語性能ベンチマークの開発が求められています。ただ単に難しいだけの日本語ベンチマークには価値がありません。そこで、大規模言語モデルは社会にとってあたり前の存在になる未来は遠くないこと、および我々ELYZAが日本でインフラとして利用されるような基盤モデルの構築を目指していることを考慮して、「大規模言語モデルが日本で社会実装される上で障壁となる応用的な問題とは何であるか」を整理することに取り組みました。具体的には、汎用ベンチマークで高性能な大規模言語モデルであっても未だ応答が難しく、かつ日本での社会実装に関連する問題を人手で探索し、カテゴリライズを実施しました。

カテゴライズの作業を通じて、まだまだ日本語領域で解けていないカテゴリが多く存在することを把握することができました。例えば、日本の法律や行政手続きなど、日本特有の知識に依存する質問に対しては依然として低い応答性能が観測されました。また、各カテゴリの問題を解決するには、いくらか本腰を入れた取り組みが必要であるとの所感も得られました。そこで、GENIACでは、解くことの実現可能性および、解けたときのインパクトの高さを考慮して、「日本のローカルルールに関する知識とその活用」カテゴリに焦点をあてた活動を行うことを決断しました。

特化ベンチマークの作成

「日本のローカルルールに関する知識とその活用」カテゴリが想定する問題は既存の汎用ベンチマークでは十分にカバーされていないため、特化ベンチマークの作成に取り組みました。

作問方法

まず、「日本のローカルルールに関する知識とその活用」カテゴリの問題は日本の法律や行政手続きを広く扱う必要があり、手探りの状態だったため、身の回りで起きている出来事に着想を得た策問を試行しました。具体的には、身の回りで重要だと思う行政ルールや、大変だった行政手続きを洗い出し、それらに紐づく日本の法律の制度を洗いました。その上で、それら法律や制度を知っていないと解けないであろう問題(i.e., 質問と回答のペア)を作成する手順です。以下に、リストアップした行政ルールや行政手続き、およびそれらに紐づく参照法令・公的文書の一部を示します:

| 行政ルール・手続き | 説明 | 法令・公的文書 |

|---|---|---|

| 出産一時金 | 出産に伴う一時金の支給制度 | 健康保険法 |

| 高額療養費制度 | 高額な医療費の一部を負担する制度 | 高額療養費制度 |

| 児童手当 | 児童手当の支給条件と申請手続き | 児童手当法 |

| ... | ... | ... |

一方で、法令・公的文書だけを見て質問を作成するためには高度な専門性が要求されるため、この作問方法はとても負荷の高い作業でした。また、特定の法律を知っているか否かを測る一問一答形式の評価データが過度に多くなる傾向もあり、ELYZA-tasks-100 を作成する際に重視した「役に立つ」という観点が欠如してしまうという懸念がありました。

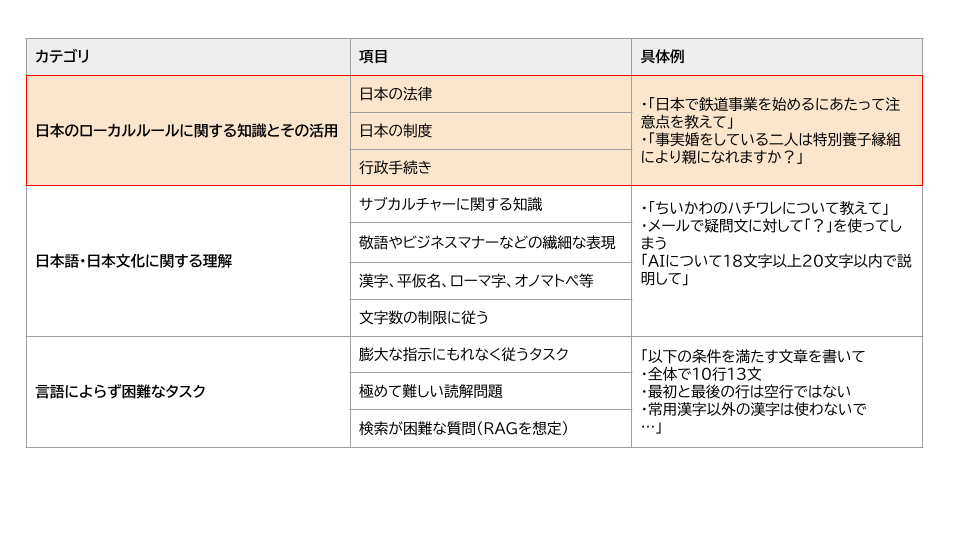

そこで、負荷を下げつつ実世界の状況に即した作問を行うための施策として、官公庁に掲げるFAQや法律の質問サイトなどを参考に問題作成を行うことにしました(カテゴリ 1, 2)。また、実社会で必要とされる法令知識として国家試験を挙げ、国家試験の過去問を参考にした問題作成も実施しました(カテゴリ 3, 4)。最後に、これらと比べて実用性が低いけれども、法令名と法令の内容の対応関係を知識として保持できているか確認することのできる一問一答的な問題も作成しました(カテゴリ 5, 6)。最終的には、「日本のローカルルールに関する知識とその活用」における評価データについて、各カテゴリ5問ずつの計30件作成しました。

評価カテゴリ 1/6: Web上の議論を参考に出題_高額療養費制度

高額療養費制度、出産一時金などの厚生労働省関連の制度については、PDFファイルなどの非プレーンテキストに情報がまとまっていることが多く、またFAQが十分に整備されていない傾向にあります。そのため、我々の生活において重要な制度であるにもかかわらず、Webデータをベースに学習した大規模言語モデルには難しい問題であると言えます。

ここでは「高額療養費制度」に焦点をあてた作問を行いました。具体的には、コミュニティサイト等で「高額療養費制度」についてどのような議論がなされているのかを把握し、実際の状況をシミュレートするような質問文(入力)を新たに作成しました。回答文(出力)については、厚生労働省が公開している各種PDF、およびそこで言及されている法令を参考に作成しました。

評価カテゴリ 2/6: 官公庁のWebサイトを参考に出題_税金

ここでは「税金」に関する問題を作成しました。「税金」はほぼ全ての国民が関わるトピックであり、かつ「行政手続き」というイメージにピッタリです。具体的には、主に国税庁のFAQサイト (例) を参考にどのような情報が「税金」に関して有益であるかを確認した上で、「税金」に関連する具体性のある入出力を作成しました。

評価カテゴリ 3/6: 資格試験を参考に出題_教員採用試験(選択問題)

法令に関する資格試験の問題を参考にすることで、「資格」という実社会で必要とされるものに関する問題かつ、質が一定保証された問題を作成することができます。ここでは、教員採用試験の教職教養のうち、日本の法令を覚えていることが求められる問題である「教育法規」に焦点を当てた作問を行いました。加えて、Web検索等を用いて正解の根拠となる解説文を作成することで、具体性のある出力を作成しました。

評価カテゴリ 4/6: 資格試験を参考に出題_看護師国家試験(選択問題)

カテゴリ-3と同じく、資格試験の問題を参考にすることで一定有用な作問が行えると考え、看護師国家試験の過去問を参考にした作問を行いました。所感としては、「看護」という専門性も相まって、カテゴリ-3よりも難しい問題カテゴリとなっています。このカテゴリでも、Web検索等を用いて解説文を作成し、出力の表現における多様性を一定担保しました。

評価カテゴリ 5/6: 法律の条文から出題_法律の逆引き問題

特定の状況において具体的にどの法律のどの部分を参照すべきかがわかることは一定の実用性があるとして、法律の逆引き問題を作成しました。まず、ランダムサンプルした法律名(e.g., ”著作権法”)に対して、"{法律名} ポイント" などのキーワードで解説記事をWeb検索し、重要そうなキーワードにあたりをつけます(e.g., 著作物の私的使用のための複製)。次に、キーワードを拡張し、具体性のある質問文にします(e.g., "著作物であっても私的な利用のためなら複製しても大丈夫、というのはなぜですか。具体的にどの法律の何条が該当するかを教えて。")。最終的に、ターゲットの法律、および関連法を参照して回答文を作成しました (e.g., "著作権法第三十条において次のように規定されているため、著作物の私的使用のための複製は認められていま ...(略)")。

評価カテゴリ 6/6: 法律の条文から出題_日本国憲法

他カテゴリの問題に比べて実用性は低い問題設定であるが、知識保持の有無を簡易に確認できるものとして、法令名と法令内容の対応関係を問う問題も作成しました。具体的には「日本国憲法」に焦点を当て、"日本国憲法第{N}条を答えて" というプロンプトを自動作成し(※ Nはランダム)、行政情報の検索・案内サービスを提供するデジタル庁ポータルサイト e-gov を参照し、回答文を作成しました。

具体例

以下に本ベンチマークの入出力例を示します。本ベンチマークでは、選択肢問題であっても選択した選択肢の解説も含めて文章で回答する(!= 単語のみ or フレーズのみを回答する)形式となっています。

メタデータ

ベンチマーク作成の際には、入出力の他に、回答の根拠(e.g., 該当する公的文書の一部)をテキストとして付与しました。また、その根拠の出典 URL も合わせて付与しました。これら根拠情報は、モデルの生成内容を定性評価する際に使用できます。また、変則的な使用方法としては、retrieval augmented generation (RAG) における参照文脈として指示プロンプトに挿入することで、大規模言語モデルが文脈を活用する能力 (!=知識をパラメータに保持し、それを運用する能力)を評価することにも使用できます。

注意事項

上記ベンチマークは、社内で作成後、作業員複数人で検閲しました。その際、回答の根拠情報および出典元も使用しました。作成にあたっては、根拠となる法律の解釈が難しい、または判断に迷う問題は可能な限り排除しています。また、本ベンチマークの作成は、ELYZA-tasks-100 のような汎用ベンチマークに比べて、作成および検閲において大きな労力がかかる作業であったため、GENIAC期間中には計30問の作成に留めることとなりました。

作問指針である6つのカテゴリは、日本の法律や行政手続きに関する知識を完全に網羅するものではありませんが、「日本のローカルルールに関する知識とその活用」という重要トピックを多角的に捉えており、未開拓な当分野における評価のとっかかりとして有用だと考えられます。

日本特有の知識・表現に関する特化学習データの作成

前々節では、日本語領域において未解の問題群(以降、”日本特有の知識・表現”)が多く存在することを把握しましたが、本節ではその原因に対処するための特化学習施策を一部紹介します。

汎用性能の高い大規模言語モデルであっても日本特有の知識・表現に弱い主な理由としては、事前学習コーパスの網羅性の低さが考えられます。例えば、マイナポイント関連のFAQは https://faq.myna.go.jp/faq/ 以下にまとめられているのですが、CommonCrawl から抽出・後処理された日本語コーパス llm-jp-v2 には、"faq.myna.go.jp/faq" を URL metadata に含むエントリは実際の数十分の一程度しか含まれていませんでした。また、プレーンテキストの網羅性の低さ以外にも、そもそも政府や自治体が発行する情報の一部が .pdf や .xml 形式で公開されていることも原因として考えられます(例)。

そこで、日本特有の知識・表現の中でも特に「日本のローカルルールに関する知識とその活用」に焦点をあて、既存の学習コーパスに存在しない関連テキストの収集を試みました。

行政手続き関連テキストの収集

キーワードベースでの検索を行うクローラーを作成することで、日本の行政手続きに関するテキストをWebから収集しました。

まず、「行政手続き」が指す範囲が曖昧かつ広すぎるという問題があったため、まずは、総務省が運営する国・地方共通相談チャットボット Govbot(ガボット)のカテゴリ分けを参考に、そこから具体例を膨らませる形で計435件の行政手続き(または公的制度名)をリストアップしました:

| カテゴリ | 行政手続き(または公的制度名) |

|---|---|

| 医療・保険 | 国民健康保険 |

| 医療・保険 | 健康保険 |

| 医療・保健 | 後期高齢者医療制度 |

| ... | ... |

その後、それぞれの行政手続き名について「{行政手続き} 解説」 というクエリでWeb検索を行い、検索結果上位100件の html を取得しました。Web検索には SerpApi を使用し、スクレイピングには Scrapy を使用しました。ここでスクレイピングに失敗したサンプルは除外しました。最終的には、Trafliatura を使用することで HTML から Markdown 形式のテキストへの変換を行い、計 43,500 件の行政手続き関連テキストを取得しました。

法令関連テキストの収集

行政情報に関するデジタル庁ポータルサイト e-gov の法令条文データ (.xml 形式) をパースして可読性の高いテキストとして取得することに取り組みました。パースには ja-raw-parser を用いました。しかし、ja-raw-parser では、表部分が構造情報を無視してパースされてしまい、各セルの値がどのカラムに対応しているかが不明になってしまうという問題がありました。法令の条文には表で規則が整理されていることが少なくないため、我々は ja-raw-parser を改変し、表部分を markdown 形式で抽出可能にしました。

また、法律によっては記述テキストが長すぎて、単一データの粒度として適さない可能性がありました。そこで、日本の法律が基本的には "法"/"章"/"条" ... と階層構造になっていることに着目し、"条" を一つのデータ単位に統一しました。これは、以下の例に示すように、”条”は人間が見て適度に具体性のある単位になっているためです:

(信号機の灯火の配列等)

第三条 信号機の灯火の配列は、赤色、黄色及び青色の灯火を備えるものにあつては、その灯火を横に配列する場合は右から赤色、黄色及び青色の順、縦に配列する場合は上から赤色、黄色及び青色の順とし、赤色及び青色の灯火を備えるもの ...(略)

(警察署長の交通規制等)

第三条の二 法第五条第一項の規定により公安委員会が警察署長に行わせることができる交通の規制は、次に掲げる道路標識等による交通の規制(法第四条第一項後段に規定する警察官の現場における指示によるこれらの交通の規制に相当する ...(略)

加えて、各条文がどの法律のどの章に属するのかという階層情報もメタデータとして保持させることで、後段での整理を容易にしました。

既存コーパスからの関連テキストの抽出

特化学習における学習データの材料を新規に集めるだけではなく、既存コーパスから関連テキストを抽出することも併せて行いました。具体的には、llm-jp-v2 に対して text 部分またはメタデータ部分に複数のフィルタリング法を適用し、日本の”法律名”に関連するテキストサブセットを抽出しました。フィルタリングとしては、「text に {法律名} を N個以上含む、かつ、URL に "faq" という文字列を含む」といった条件を複数適用しました。

法令・行政手続き関連テキストから学習データへの加工

新規で収集・既存コーパスから抽出したテキストを利用する手段を検討しました。非常に専門的な知識を含んだテキストを収集できたとして、それらをモデルに習得させる方法は自明ではありません。例えば、法律の条文を用いて言語モデリングさせたところで条文の内容を正しく学習できるでしょうか。そこで、既存コーパスに存在するテキストも含めて、日本の法令や行政手続きに関するテキストから効果的な学習データへ加工する方法の検討を行いました。

まず、条文などの専門的なテキストを単に追加事前学習データとして使用することは、大きな効果が得られないという経験的知見が予備実験で得られました。そこで、指示学習データ(i.e., input/output 形式)に加工する方針を採用しました。該当テキストから指示学習データへ加工する方法論としては、以下の2つを検討しました:

-

ルールベース変換: 法令条文または行政手続き関連テキストを、特定のルールに従って変換する。例えば、ある条文の名前と具体内容があった時、”{常文-名前}の内容を教えてください”という問題文テンプレートと、"{常文-具体内容}"という回答文テンプレートをそれぞれいくつかのバリエーションを用意し、確率的に選択する。また、行政手続きFAQテキストからは、QとAのペアをパースして入出力とするなどを実行する。

-

大規模言語モデルを用いた変換: ある法令または行政手続き関連テキストが与えられた時に、それを大規模言語モデルを用いて言い換えることで、input と output のペアを生成する。具体的には、ELYZA が保有する日本語大規模言語モデル Llama-3-ELYZA-70B を用いて、各テキストから約5件のペアを生成する。

予備実験では、ルールベース変換の方がコスト面で大きなアドバンテージがあるものの、大規模言語モデルを用いた生成ベースの変換の方が、多様性の確保や、より自然なテキスト生成が可能であると仮説を立て、検証を行いました。実際、ルールベースの学習データを使用した場合には、多様性の欠如からか、指示追従能力や丁寧な回答を行う能力が大幅に失われてしまうことが観測されました。そのため、GENIACにおける特化学習では、大規模言語モデルを用いた変換を採用することとしました。

評価

設定

GENIACの前半で開発を行なった日本語大規模言語モデル Llama-3-ELYZA-120B に対して、今回新たに作成した特化学習データを用いて指示学習を行い、「日本のローカルルールに感する知識とその活用」に関する能力への影響を評価しました。具体的には、前々節で導入した特化ベンチマークを用いて自動評価(5点満点)を行いました。自動評価モデルには gpt-4-0125-preview を使用し、正解例を参照した上で、以下基準で生成例をスコアづけさせました:

- 1点: 誤っている、 指示に従えていない

- 2点: 誤っているが、方向性は合っている

- 3点: 部分的に誤っている、 部分的に合っている

- 4点: 合っている

- 5点: 役に立つ

また、汎用的な基本性能が失われていないかどうかを測るため、Japanese MT-Bench(10点満点)および ELYZA Tasks 100(5点満点)を用いた自動評価も併せて行いました。ベースラインモデルとしては、特化学習前後のモデル、gpt-4-0613、 および gpt-3.5-turbo-0125 を採用しました。

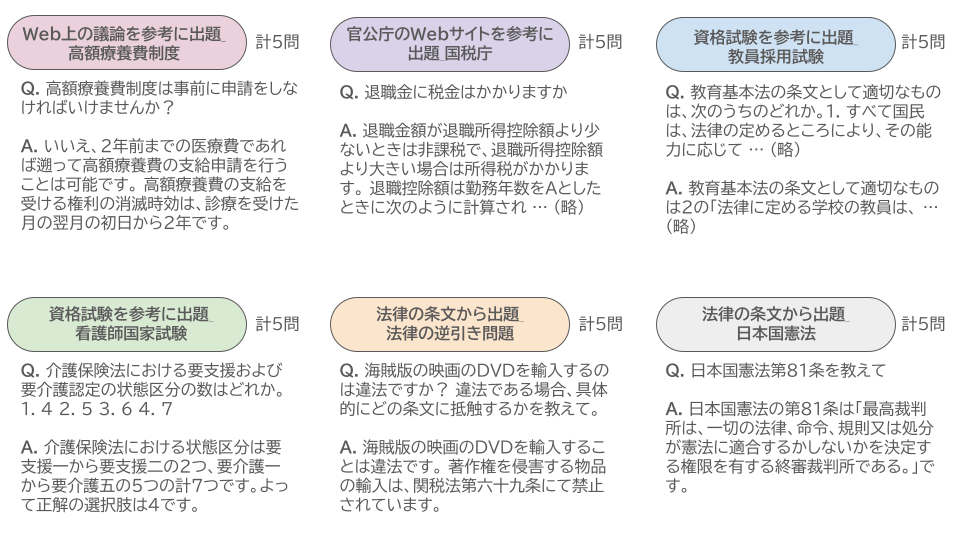

結果

| モデル | Japanese MT-Bench | ELYZA Tasks 100 | 特化ベンチマーク |

|---|---|---|---|

| gpt-3.5-turbo-0125 | 8.28 | 3.47 | 2.20 |

| gpt-4-0613 | 9.06 | 4.14 | 2.92 |

| Llama-3-ELYZA-120B | 9.24 | 4.09 | 2.90 |

| Llama-3-ELYZA-120B + 特化学習 | 8.04 | 3.61 | 3.65 |

まず、特化ベンチマークを用いて汎用モデルを評価した場合には、ELYZA Tasks 100 と同じく5点満点であるにもかかわらず平均点が1点以上低い傾向にあることがわかります。これは、特化ベンチマーク作成の狙いの一つである、「高い難易度設定」が反映されていることを示しています。

また、特化学習前後で Llama-3-ELYZA-120B の特化ベンチマークの性能が改善しています。ここから、「日本のローカルルールおよびその活用」に関する知識の獲得に関しては、特化学習を行う施策が一定有用であることがわかります。具体的には、タスクに関連するデータを収集・加工できれば、仮に法律や行政手続きという高度に専門的なドメインであっても、大規模言語モデルの性能向上が一定期待できることが示唆されます。また、その結果達成した性能 (i.e., 3.65) は、gpt-3.5-turbo-0125 や gpt-4-0613 に勝る性能を達成できていることから、当該専門領域においては、特化学習を駆使することで国産モデルが戦っていける余地が多分にあることを示唆しています。

発展的な検証として、回答の根拠となる参照文脈を与えた場合の評価を行いました:

| モデル | 特化ベンチマーク | 特化ベンチマーク w/ 参照文脈 |

|---|---|---|

| gpt-3.5-turbo-0125 | 2.20 | 3.17 |

| gpt-4-0613 | 2.92 | 4.27 |

| Llama-3-ELYZA-120B | 2.90 | 4.08 |

| Llama-3-ELYZA-120B + 特化学習 | 3.65 | 3.88 |

興味深いことに回答の根拠となる文書を見ることのできる状況では、モデル間の順位が変化することがわかります。改めて整理すると、”回答の根拠となる参照文脈を与える” という設定は、RAGシステムにおいて retriever の精度が 100% という非現実的な状況をシミュレートしていることになります。参照文脈なしの場合に比べ、問題を解くために使用できる入力の情報量が違うため、二つのカラムの数値らをカラムを崩して比較するのはやや難しいのですが、知識をパラメータに保持する能力と、文脈にある知識を利用する能力は必ずしも両立しないことがわかります。

ELYZA Lab では、参照文脈なしの設定でモデルの賢さの基準を測ってきましたし、同時にその基準でモデルを賢くすることに取り組んできました。一方、今回のモデルの得意不得意を示す結果を踏まえ、また最近の Long Context の重要性などを鑑みるに、参照文脈ありの設定における賢さ (i.e., 文脈を利用する能力) にも焦点を当てる必要があると認識しました。

なお重要な点として、本取り組みでは、OpenAI社のGPTシリーズのような「出力を他モデルの学習に利用することが禁じられているモデル/API」の出力は学習データには一切利用しておりません。

生成例

最後に、いくつかの生成例を示します。

以下の例では、我々の特化モデルは gpt-4-0613 に比べて高額療養費制度の内容をより正しく理解していることを示しています:

# 質問

事故で片足を失い義足を作ったのですが、義足は高額療養費の対象となりますか

# 回答 (Llama-3-ELYZA-120B + 特化学習)

義足は高額療養費の対象となります。

高額療養費とは、医療機関や薬局の窓口で支払った額が、ひと月(月の初めから終わりまで)で上限額を超えた場合に、その超えた金額を支給する制度です。義足はその支給対象に含まれています。

ただし、対象となるのは、医師の指示・処方に基づいて購入した義足に限られます。詳しくは、加入している健康保険組合等にご相談ください。

# 回答 (gpt-4-0613)

日本の健康保険制度では、義足や義手などの補装具は高額療養費の対象には含まれません。これらは「看護・リハビリテーションを目的とする施設等における食事・宿泊・入浴などの費用」や「予防接種・人間ドック・健康診断の費用」などと同様に自己負担となります。

補装具の費用については、一部が健康保険適用となりますが、全額が補償されるわけではありません。また、各自治体により、障害者支援のための補助金制度や免税措置が設けられていることがあるため、詳細は各自治体の窓口に問い合わせることをおすすめします。

# 正解例

義足は高額療養費の対象となる可能性が高いです。 高額療養費制度とは、医療機関や薬局の窓口で支払った額が、ひと月(月の初めから終わりまで)で上限額を超えた場合に、その超えた金額を支給する制度です。保険適用される診療に対し、患者が支払った自己負担額が対象となります。詳しくはご自身が加入している医療保険やお住まいの自治体にお問い合わせください。

次の例では、より簡単な一問一答形式の問題における我々のモデルの優位性を示しています:

# 質問

日本国憲法第81条を答えて

# 回答 (Llama-3-ELYZA-120B + 特化学習)

日本国憲法第81条は、最高裁判所について規定した条文です。

「最高裁判所は、一切の法律、命令、規則又は処分が憲法に適合するかしないかを決定する権限を有する終審裁判所である。」

# 回答 (gpt-4-0613)

日本国憲法第81条は、「すべての裁判について最終的な判断を下す権限を最高裁判所に与える。」と規定しています。全文は以下の通りです。

「すべての裁判について、最終的な判断を下す権利は、最高裁判所に属する。」

# 正解例

日本国憲法の第81条は「最高裁判所は、一切の法律、命令、規則又は処分が憲法に適合するかしないかを決定する権限を有する終審裁判所である。」です。

おわりに

本記事では、GENIAC で実施した「日本特有の知識に特化した大規模言語モデルの学習および評価」について紹介しました。ELYZA では引き続き、最先端の研究開発に取り組んでいくとともに、その研究成果を可能な限り公開・提供することを通じて、国内における LLM の社会実装の推進、並びに自然言語処理技術の発展を支援してまいります。

なお、本記事で扱った内容をはじめとするELYZAの研究開発・社会実装の取り組みについて詳説するミートアップイベントを開催予定です。ご興味がある方はイベント詳細をご覧ください。

また、ELYZA は、機械学習エンジニアはもちろん、様々な職種で一緒に事業を前に進めてくれる方を募集しています。詳しくは下記をご覧ください。

Discussion