マルチモーダルLLMの活用方法と技術解説

TL; DR

- GPT-4VやGeminiなど、大規模言語モデル(LLM)を画像や音声など複数のモダリティに対応させたマルチモーダルLLMが登場し始めている

- LLMをマルチモーダル化することで様々な恩恵を受けられる

- 学習済みモデル同士を組み合わせた構造にし事前知識を活用することで、学習の効率化を実現する

はじめに

Elithで機械学習エンジニアをしている成木です。

ChatGPTをはじめとする様々なプロダクトが登場しLLMが急速に普及していく中で、最近それらに画像や音声といったモダリティが入力できるようになるなどLLMのマルチモーダル化が進んでいます。

その例として、画像入力に対応のGPT-4Vや、画像や音声、動画を用いた対話が可能であるGeminiなどがあります。このように画像や音声などのテキスト以外のモダリティを処理を可能にすることで、LLMの活用方法や適用範囲がより大きく広がっています。

この記事では、そんなLLMへテキスト以外のモダリティを入力できるようにしたマルチモーダルLLMについて詳しく解説していきます。

LLMからマルチモーダルLLMへの転換

マルチモーダルLLMの詳しい解説に入る前に、LLMがマルチモーダル化するに至った流れについて解説していきます。

まず通常のLLMをみていくと、様々な分野にわたる汎用的な知識や、推論能力、多様な指示文への回答能力といった非常に高い言語能力を持ちます。これらの能力が基盤となり人間とほぼ同様に対話することが可能になっています。

一方で、テキストしか入出力することが出来ないという欠点を持ちます。これを解決するのがマルチモーダルLLMです。具体的に、LLMをマルチモーダル化することには以下の3つが利点があります。

-

多様なモダリティを扱う分野にLLMを活用

多様なモダリティを扱う分野の例として医療やロボティクス、Eコマースなどがあります。例として、医療ではCT画像や心電図、ロボティクスでは周囲の視覚情報といったテキスト以外の情報を統合して処理する必要があり、マルチモーダル化することでこういった分野にLLMを活用することが可能になります。 -

ユーザーインターフェースの柔軟性向上

音声による会話やリアルタイムに動画を利用した対話など、LLMがマルチモーダル化することでコミュニケーション方法の幅が広がり、用途や必要性に合わせてより適切なユーザーインターフェースを選択することが可能になります。 -

LLMに関する知見や技術の利用

LLMをベースのモデルとすることで、最適化方法や学習・推論フレームワーク、スケーリングローなどLLMコミュニティが何年にもわたり蓄積してきた知見や技術を応用することが可能です。

これらの3つの利点から今後マルチモーダルLLMの開発はより一層発展していくと思われます。

マルチモーダルLLMの活用方法

マルチモーダルLLMを用いた研究は数多くあるので、今回はそれらの活用方法で3つに大別し、「人の理解のアシスト」「生成・編集」「自律エージェント」に分けて解説していきます。

人の理解のアシスト

マルチモーダルLLMを活用して質問に対して回答したり、解説・要約をします。この際にマルチモーダル化することで、画像や音声を活用した質問が可能になります。

この研究例としては、医療分野に特化したマルチモーダルLLMであるMed PaLM M(図1)があり、テキストの他に放射線画像やマンモグラフィ、患部画像、ゲノムなどを入力することが出来ます。また、対応するタスクの種類も画像を用いた質問回答、レポート作成、要約、ゲノム変異検出など多岐にわたり、医療分野のより様々な疑問に答えることが可能です。

この研究以外でも音声、動画、衛生写真、化学構造など様々なモダリティで研究が進められ、多様な質問への回答が可能になってきています。

図1. Med PaLM Mが対応するモダリティとタスク

生成・編集

マルチモーダルLLMを活用して画像や音声といったテキスト以外のモダリティの生成・編集を行います。マルチモーダルLLMを用いることで今までにはなかった新たな生成・編集方法が実現されます。

この研究例として、CoDi-2(図2)では指示文の中に画像や音声を含めることができ、2つの画像の特徴を統合した画像の作成や、音声を用いた画像の編集などが可能です。具体例として図2の中央では、雨の音声と画像を用意して「(雨の音声)をもとに(画像)を編集して」と指示を出すことで、画像を雨らしく変換することが可能です。

また、この他にも動画や音声、人動作などの生成に応用した研究も登場しており、多様なモダリティの出力が可能になってきています。

図2. CoDi-2:マルチモーダルな指示文による画像の生成・編集が可能

自律エージェント

マルチモーダルLLMをエージェントとし、周囲の環境を視覚情報などを通して認識しながら与えられた指示文を実行します。

この研究例として、RT-2(図3)では自然言語によりロボットを操作することを可能にしています。また、LLMの高い言語能力を活用することで抽象的な表現をした指示文による実行が可能で、「疲れている人にはどの飲み物が最適?」という質問に対してエナジードリンクを掴むことができます。

自律エージェントはロボティクス以外にも、自動運転、3Dゲームなどに応用したものがあります。また、UI操作の自動化に活用した研究がGoogleやTencentから登場しており、指示だけでスマホやPCを操作できるようになる時代もそう遠くはないと思われます。

図3. RT-2: 言語を用いた様々な指示によりロボットを動作可能

以上で、既存のマルチモーダルLLMを用いた研究を活用方法をもとに3つに分類して解説しました。

以降では、マルチモーダルLLMの構築方法に入っていきます。

マルチモーダルLLMの構築方法

モデル構造

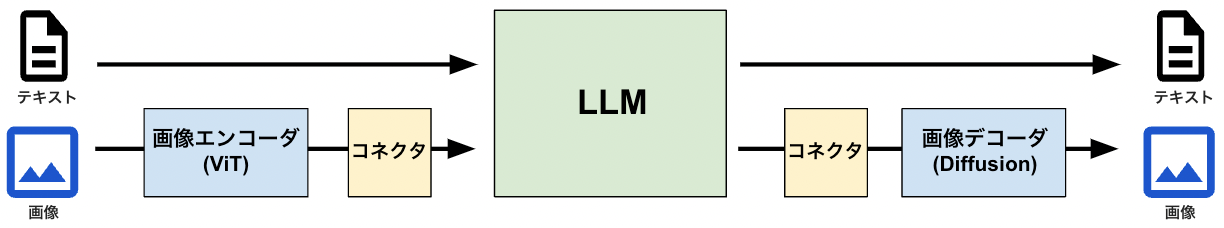

マルチモーダルLLMは、LLMを含む事前学習済みモデル同士を組み合わせることで構築します。この際、そのままではモデル同士の特徴量の次元が異なるので、コネクタというネットワークを間に挟むことによりそれらを接続します。

具体例として、画像を入力したい場合はLLMとViTなどの画像エンコーダを用意し、コネクタにより画像エンコーダが出力する画像特徴量をトークンに写像することで、LLMへの画像情報の入力を可能にしています。

同様に画像を出力したい場合も、LLMとDiffusionなどの画像デコーダを用意し、LLMから出力されるトークンをコネクタにより画像特徴量に写像して画像デコーダに入力することで、画像の出力を可能にしています。

このように、学習済みをモデルをコネクタにより接続する構造にすることで、各モデルが持つ事前知識の活用が可能になり、学習を効率化することができます。

図4. 画像の入出力に対応したマルチモーダルLLMの概略図

学習

学習は、主に事前学習とインストラクション・チューニングの2段階からなります。それぞれで使用されるデータも踏まえながら順に解説していきます。

1. 事前学習

事前学習では、各モダリティ間のアラインメント行います。例えば画像入力をしたい場合は、画像キャプションデータを用意し、画像を入力してキャプション文が出力されるように学習がされます。このようにすることで画像情報とテキスト情報をモデル内で結びつけることができます。

この際、画像と共に入力される指示文には「この画像を説明してください」といった事前に決められたものが使用されます。また学習では、基本的に学習済みモデルの重みは固定されコネクタの重みのみが更新されます。

事前学習の利点としては、キャプションデータといった既存にある大量のデータセットが活用可能な点があります。その一方でそれらのデータの特性上、指示と回答の両方で多様性と深い推論に欠けるという欠点があります。

この欠点を解消するのが2段階目のインストラクション・チューニングです。

2. インストラクション・チューニング

インストラクション・チューニングでは、通常のLLMと同様に多様な指示文に対して望ましい回答を出力するように学習を行います。

この際、多様な質問に対して適切な回答を集めたデータセットを用いる必要があり、この構築には人の手で行われる場合がほとんどです。そのため、インストラクション・チューニングの欠点として、学習用データセットの構築に多大な労力がかかる点があげられます。

その一方でこれを自動化している場合もあり、画像入力に対応したマルチモーダルLLMであるLLaVAでは、画像をキャプション文とバウンディングボックスという2つの記号表現に変換することで、テキストのみに対応したGPT-4に画像情報を入力できるようにし、質問・回答文を自動生成させています。

図5. LLaVAにおけるインストラクションデータの自動生成

おわりに

マルチモーダルLLMはLLMの高い言語能力を様々なモダリティで活用できるようにしたマルチモーダルモデルであり、単に入出力できるモダリティを増やせるだけでなくそれらのモダリティを掛け合せた柔軟な指示文を入力できます。また、LLMを含めた学習済みモデルを組み合わせたモデル構造にすることで、それらのモデルが持つ事前知識の活用した効率的な学習が可能です。

マルチモーダルLLMが対応するモダリティは徐々に増えており、これらの組み合わせにより応用範囲や活用の幅が無限に広がっていきます。今後、様々な分野や場面でマルチモーダルLLMが活用され、LLMの普及はより一層加速していくと思われます。

最後に宣伝となりますが、株式会社 Elith は最先端のAI技術をビジネスに実装し、価値を生み出すテックカンパニーです。

最近ではLLMの活用に関して様々な取り組みをしており、多数のイベントにも登壇しています。

LLMを活用したビジネス課題解決に興味がある方は、X(旧Twitter)経由やElithのWebページ経由で、是非気軽にお尋ねください。

参考

- Team, Gemini, et al. "Gemini: a family of highly capable multimodal models." arXiv preprint arXiv:2312.11805 (2023).

- Kondratyuk, Dan, et al. "Videopoet: A large language model for zero-shot video generation." arXiv preprint arXiv:2312.14125 (2023).

- Liu, Haotian, et al. "Visual instruction tuning." Advances in neural information processing systems 36 (2024).

- Tu, Tao, et al. "Towards generalist biomedical ai." NEJM AI 1.3 (2024): AIoa2300138.

- Tang, Zineng, et al. "Codi-2: In-context, interleaved, and interactive any-to-any generation." arXiv preprint arXiv:2311.18775 (2023).

- Zitkovich, Brianna, et al. "Rt-2: Vision-language-action models transfer web knowledge to robotic control." Conference on Robot Learning. PMLR, 2023.

- Liu, Haotian, et al. "Visual instruction tuning." Advances in neural information processing systems 36 (2024).

- Zhang, Duzhen, et al. "Mm-llms: Recent advances in multimodal large language models." arXiv preprint arXiv:2401.13601 (2024).

- Chip Huyen. "Multimodality and Large Multimodal Models (LMMs)"

Discussion