[UnrealEngine]自分の顔面をリアルな3Dモデルにできる、Metahumanで逆バ美肉してみた

はじめに 「逆バ美肉」への道

UnrealEngineで、実在の人間に近いアバターが作成でき、iphoneで簡単にフェイシャルキャプチャできるというMetahumanを試してみます

バ美肉を「バーチャル美少女受肉」というならば、まさにこれは逆路線

バーチャルに自身のリアルを受肉させに行きます。

自分の顔を晒さないと、Metahumanの良さが伝わらないこのもどかしさの中、執筆していきます

参考リンク

Metahuman って?

早い話がこんな感じ

iPhoneのアプリで自身の顔を撮影することで、めちゃリアルな顔3Dモデルが作成できるUnrealengineの最新機能です

作成した顔モデルを使って、リアルタイムで映画スタジオレベルの表情トラッキングがリアルタイムできます。

逆バーチャル美少女「逆バ美肉」ができるんですよ、「逆バ美肉」!!

みんなもやるっきゃない!

というわけで、MetaHumanを作成していきましょう

使用ツール

・UnrealEngine5.2

・Live Link Face(App store)

・iPhoneX以上(FaceID対応のiPhone または iPad)

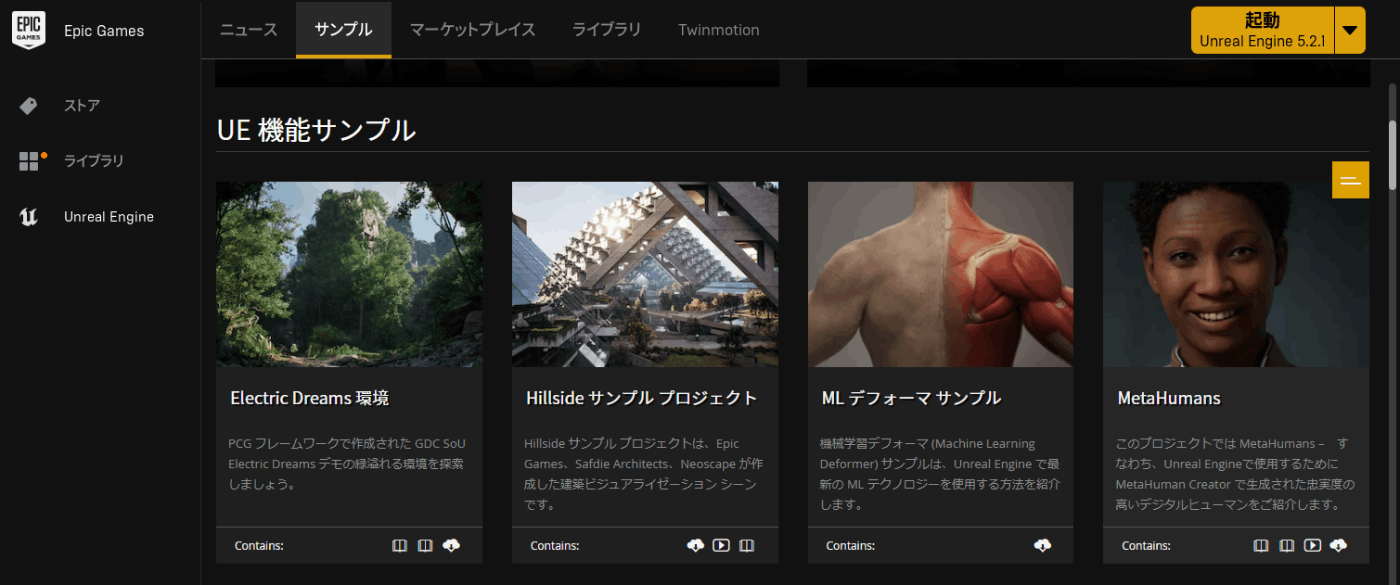

UnrealEngineにMetahumanサンプルプロジェクトを導入

まずはUnrealEngineに、MetahumanプラグインまたはMetahumanサンプルプロジェクトを導入します。

プラグインでの作成も可能ですが、サンプルプロジェクトでの制作のほうが非常に簡易なため、今回はサンプルプロジェクトを使用して解説をしていきます。

EpicGamesLauncherを開ます。

サンプルタブから、MetaHumansサンプルプロジェクトを開き、プロジェクトを作成します。

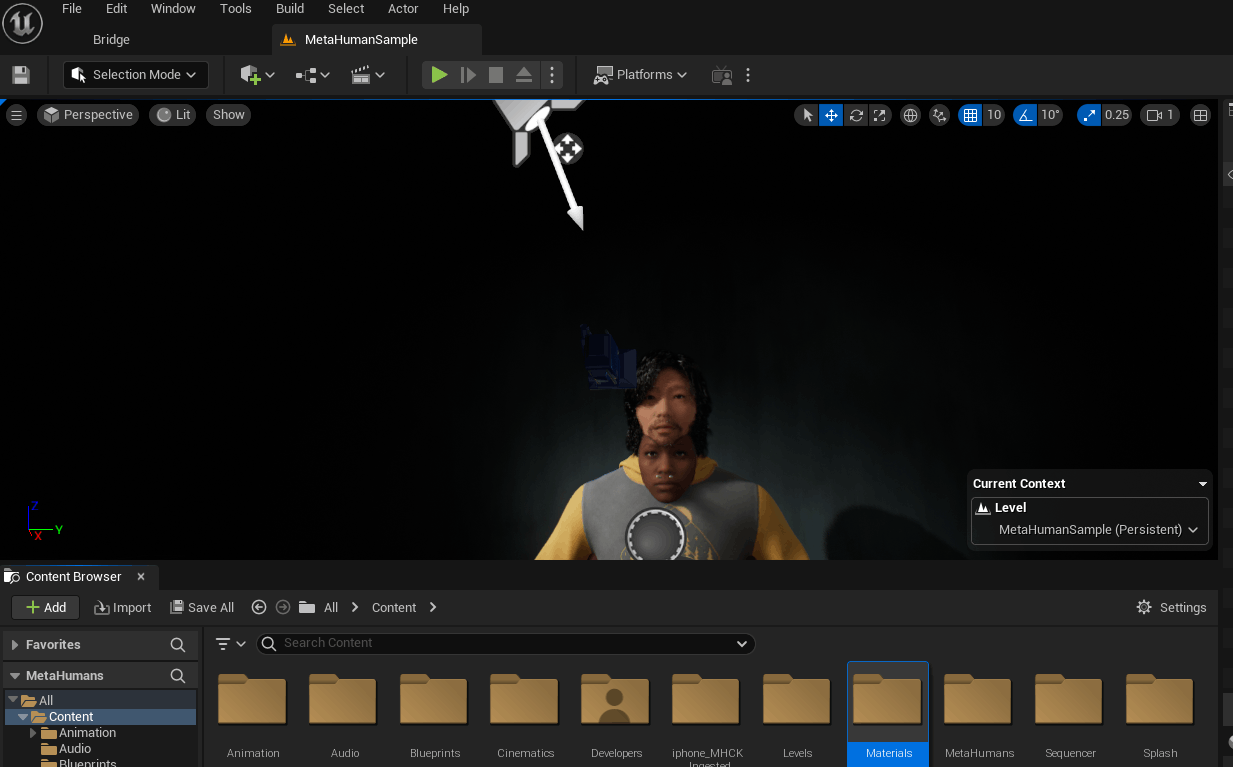

サンプルプロジェクトを開くと、このような怪異の現場のような状況になりますが問題ありません。

エディターのプレイボタンを押すと、MetaHumanが喋り始めます。すっげぇリアルなのでチェケラ

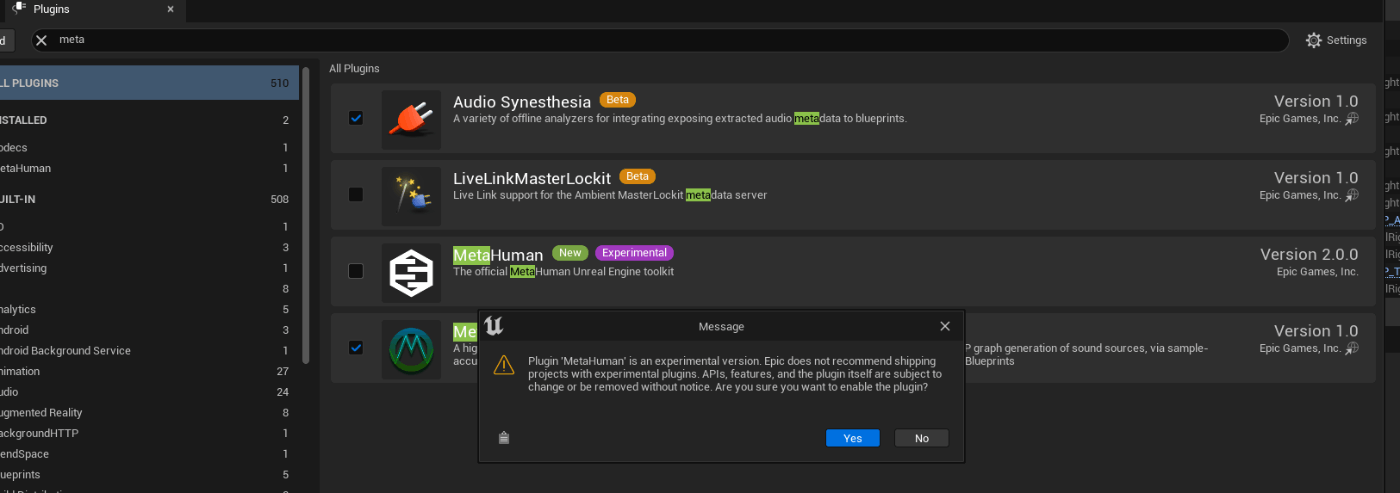

UnrealEngineにMetahumanプラグインを導入

プラグインを以下のリンクから導入します

先程サンプルプロジェクトを作成したときと同じUnrealEnginenoバージョンでエンジンにインストールしてください

Metahumanのサンプルプロジェクトを開きます。

EditからPluguinsを選択し、「Metahuman」と入力し、Pluginを適用。なにか言われますが、無視してOK。

再起動で適応されます

Live Link Faceのインストール

つぎに、iPhoneのアプリである「Live Link Face」をインストールします

FaceIDにも使用される、前面カメラの深度センサ(だったはず)で表情を繊細に読み取り、3Dモデル作成やリアルタイムでの表情トラッキングに使用できます。

FaceID対応の端末が必須となります(iPhoneX以上 XRはダメ)

顔面キャプチャ動画の作成

Live Link Faceがインストールできたので、顔の3Dモデル作成のために動画を撮影します。

iPhoneのLive Link Facewoを開くと「キャプチャモードを選択」と案内が出ます。

「MetaHuman Animator」を選択し、撮影します。

歯も含めた高精度のモデル作成にはいくつかポイントが有るのでそちらも記しておきます

撮影のポイント

・口を軽く閉め、リラックスした表情で開始

・ゆっくりと左右を向く

・イー の表情で口を大きく開き歯を出す

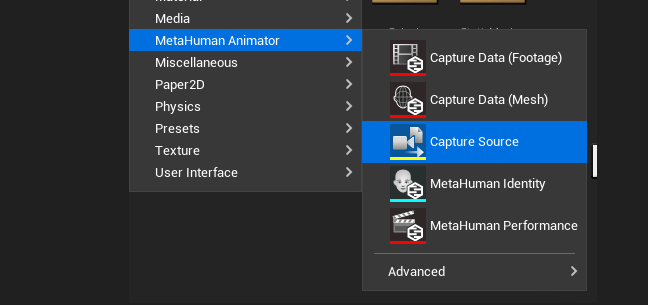

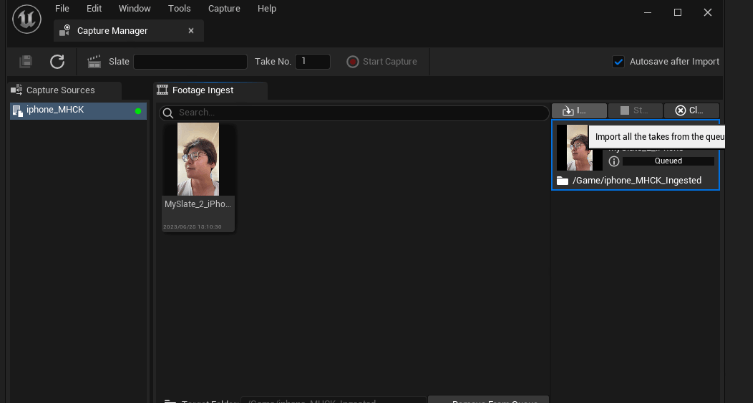

キャプチャ動画をUnrealEngineにインポート

撮影した動画を、先程作成したMetahumanサンプルプロジェクトにインポートします。

エディタ内のコンテントフォルダに動画をドラッグドロップ。

コンテントフォルダを右クリックし、「MetaHuman Animator」から「Capture Source」をクリック

先程インポートしたiPhoneの動画データが読み込まれます。

動画を選択し、右側にある「Add to Queue」をクリック。

深度データなどを含めたデータが作成されます

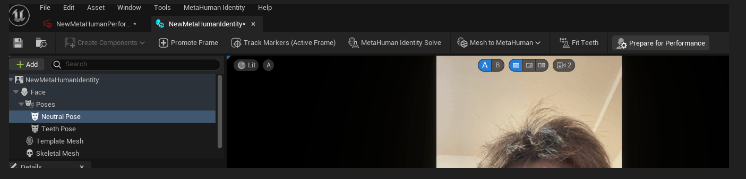

MetaHumanの作成

動画データから、Metahumanを作成していきます

コンテントフォルダを右クリックし、→Metahuman → Metahuman Identityをクリックします

+CrreateComponent→From Footageをクリックすると、先程制作した動画データが表示されるので

そちらをクリックします。しばらくすろと動画が読み込まれます。

エディター下部にタイムラインが作成されます。ここから、表情パターンを選択してMetahumanを作成していきます。

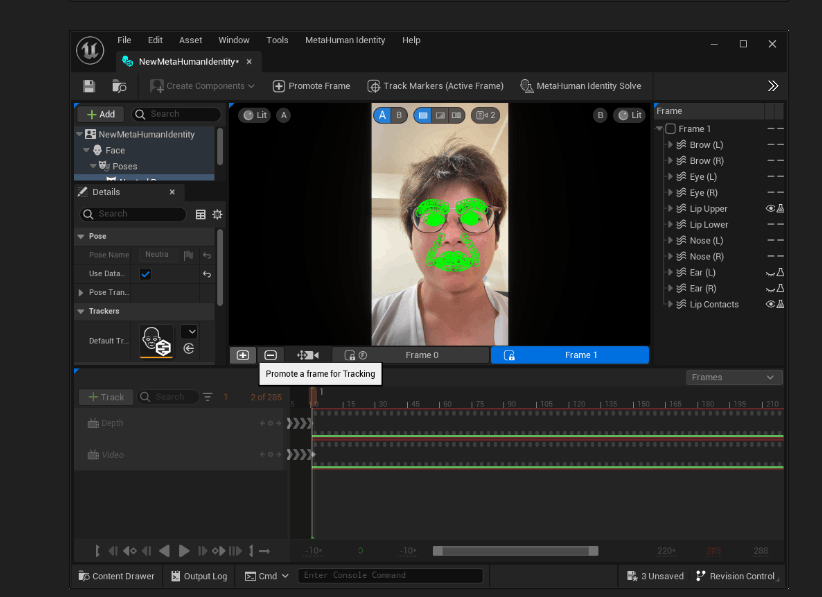

まずはじめに、正面を向きリラックスした表情のシーンまで移動し、「+ボタン」をクリックします。

すると、正面の表情として認識され、顔に緑の点線が映り込むようになります。

(ほうれい線のように見えてショックでした、まだ若いのに)

つぎに、左右の表情も追加します。

先程押した 「+ボタン」の2つ右横にあるカメラアイコンをクリック します。すると、またタイムラインが操作できるようになります。

まず、右を向いた表情で+ボタンをクリック。その後カメラアイコンをクリックしてタイムラインを移動できるようにし、左を向いた表情で再度+ボタンを押します。

これで、正面と左右の表情を追加できました。

つぎに、右上にある 「Metahuman Identify solve」 をクリックすると、Metahuman作成のための最適化?(レンダリング?)が行われます。

MetahumanIdentify solve が完了すると、Metahumanの下地となる表情筋が作成されます

「俺ってこんな顔してたのか・・・」とショックを受ける人が多いと思います。乗り越えましょう

最後の仕上げに 「Prepare for Performance」

この動作が完了するまで非常に長い時間がかかりますので、優雅にティータイムでもしながら見守りましょう(完了まで2時間かかりました)

書きかけですが今日はココまでとします!!!!!!!

#書きかけ

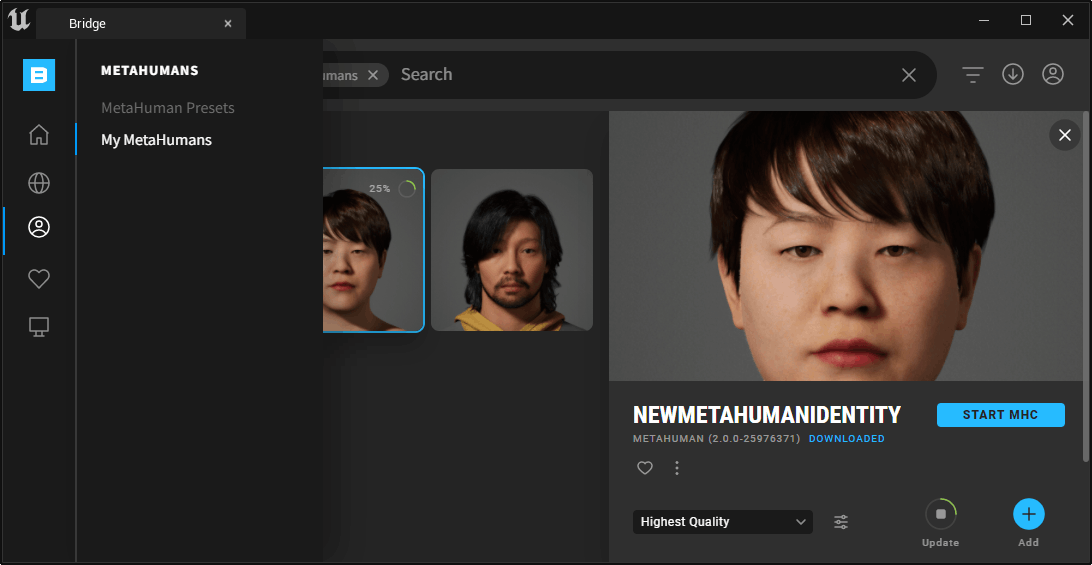

ブラウザでMetahumanAnimaatorを開き、顔の設定

完了すると、QuixelのMymetahumanに自分のMetahumanが作成される

これを+AddすればOK

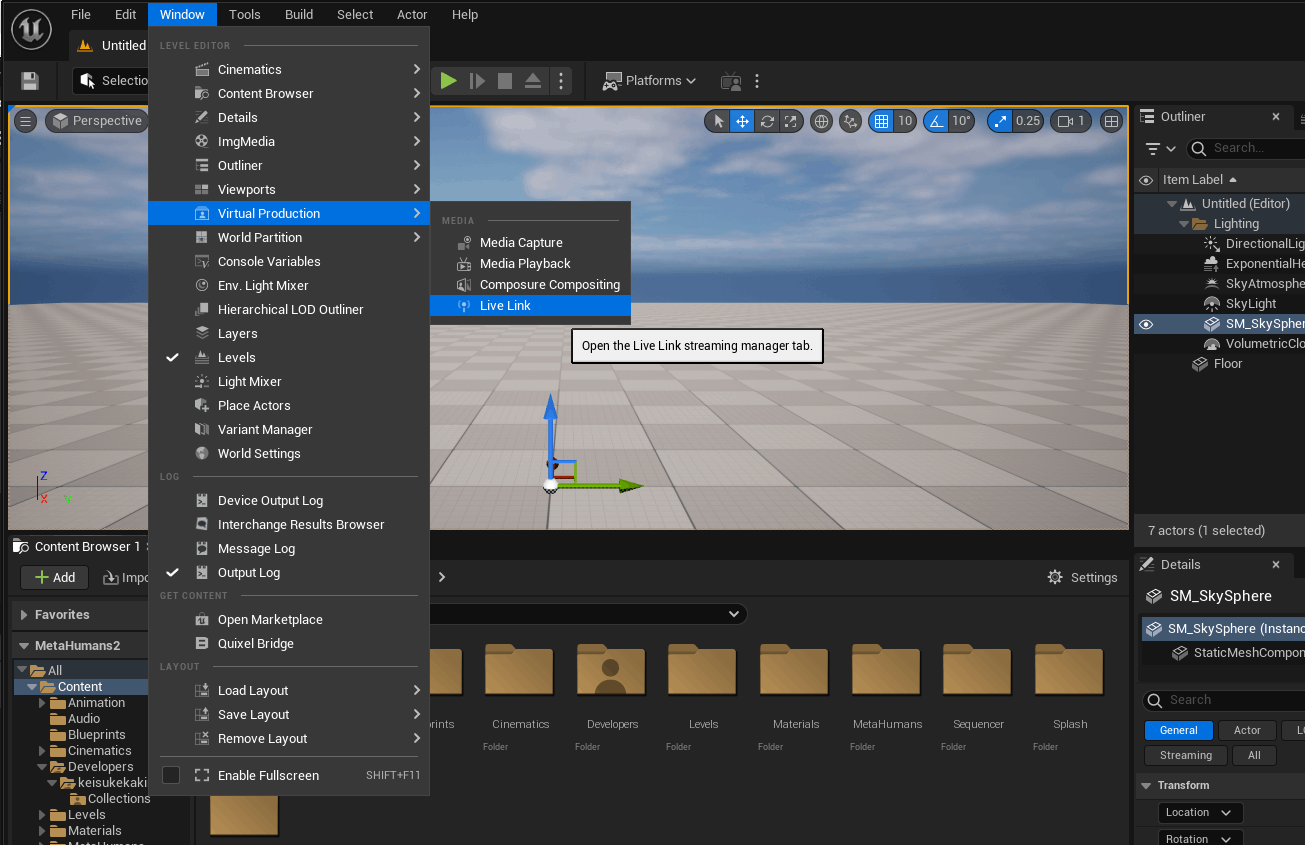

Windowsと同一のWifiに接続し、ローカルIPを調べる

Livelinkアプリの設定でローカルIPを入力

Discussion