画像から動画生成できるすげーやつ!Stable-Video-Diffusion を使ってみた

はじめに

男もすなる生成AIなるものを、プログラム初心者もやってみる

というわけで、最近話題の動画が作れる生成AI「Stable-Video-Diffusion」を触ってみたので、備忘録としてZennにまとめようと思います。

Stable-Video-Diffusionとは

画像生成に使われるStableDiffusionに対し、動画生成に特化したものがStableVideoDiffusion です。

画像を入力するだけで、その画像を元に動画が作成されるようです。すごい

どういうふうに動画になるのか全然わからないので、とりあえず触ってみます

まだまだGithubが怖いお年頃、git clone難しいな人間の私ですが、

ありがたいことに、Huggingfaceでブラウザからすぐに使えるようになっていました。早速使っていきます

とりあえず使ってみる

上記のHuggingfaceを開き、お試ししてみました

画面したのExampleから、美女を見て振り返る漢ミームを選択し、Generateをクリック

すると、1分強のレンダリングを経て、動画が生成されました。

すごい、特に何も指定せずとも、手前の女性が歩いていくようになっています、すごい!!

パラメータについて

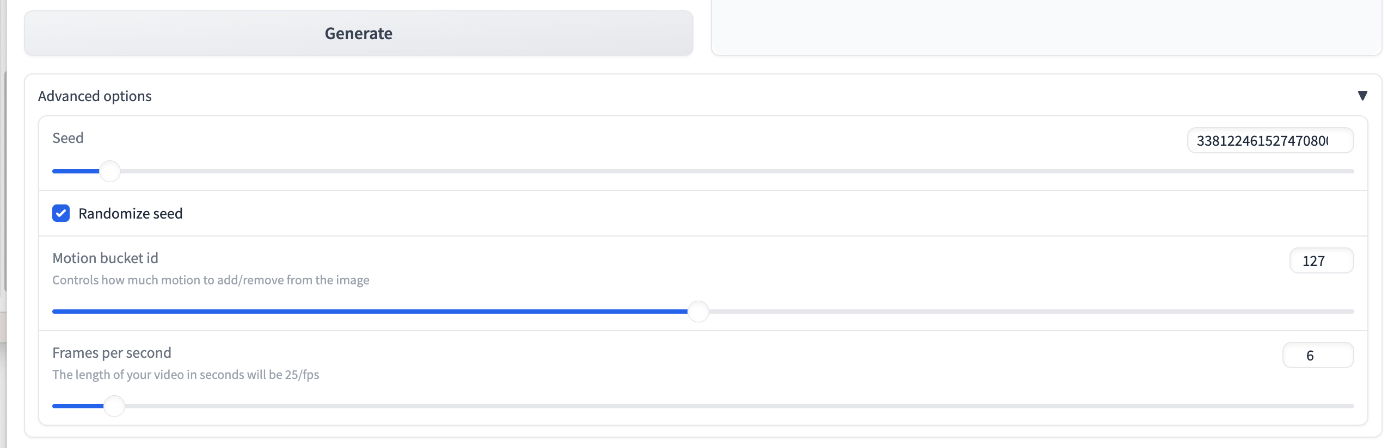

特に指定せずとも、いい感じの動画が作成されましたが、Huggingfaceをよくみると、パラメーターの入力欄のようなものがあります。これらについて調べてみました

Seed

Seedは擬似的な乱数であり、スタート地点の座標的な意味合い。

スタート地点が異なる値になると、生成されるものも大きく変わる・・・らしい

参考(:https://scrapbox.io/nishio/Stable_Diffusionのシードとプロンプトの関係)

試しにSeed値を大きく動かしてみた。ちょっと変わったかな・・?

予想より非常に難しい概念で早速面食らってしまった

Motion bucked id

Controls how much motion to add/remove from the image

数値を小さくするほど動きが小さく、大きくすると動きが大きくなるようです。

Frames per second

The length of your video in seconds will be 25/fps

1秒ごとのフレーム数。5~30フレームの間で指定できる。高いほどヌルヌルな映像になる

まとめ

Huggingface上のサンプルでは、Seed値の変更で出力を変えられるが、プロンプトで出力変更することはできないようだ。

ComfyUIなるものを使えば、UnrealEngineでおなじみのノードを使って可視化しながら、ワークフローを形成できるため、より多彩な出力ができるとのこと。次はComfyを使って、ローカルで挑戦してみたい

Discussion