gpt-ossを動かす

gpt-ossとは

GPT-OSSは、OpenAIが2025年8月に公開したオープンソースの大規模言語モデル(LLM)シリーズです。主に以下の特徴を持ちます。

-

オープンウェイト/Apache 2.0ライセンス

モデルの重み(パラメータ)がオープンソースとして公開されており、商用・非商用を問わずApache 2.0ライセンスの下で自由に利用・改変・再配布が可能です (Cinco Días)。 -

2つのモデルサイズ

- gpt-oss-120b:約1170億パラメータを持ち、1枚の80 GB GPU(例:NVIDIA H100)で高度な推論が可能。

- gpt-oss-20b:約210億パラメータで、16 GB GPU環境下でも動作し、ローカルやエッジ用途に適しています (Hugging Face)。

-

Mixture-of-Experts (MoE) アーキテクチャ

従来のTransformerにMoEレイヤーを組み合わせ、各入力トークンあたりの「アクティブパラメータ数」を削減。計算コストを抑えながら高い性能を実現しています (Cinco Días)。 -

オンデバイス/ローカル推論

クラウドAPIを経由せずにローカルマシン上でモデルを起動できるため、センシティブなデータを外部に送信せずに処理可能。プライバシーやセキュリティ要件が厳しい環境でも利用しやすくなっています (OpenAI)。 -

透明性とカスタマイズ性

トレーニングデータの概要やベンチマーク結果、サンプルコードが公開されており、必要に応じてファインチューニングや組み込みが可能です。

使用方法

前提条件

- macOS(Intel/M1・M2)もしくは Homebrew が動作する Linux

1. Ollama のインストール

brew install ollama

-

brew install

Homebrew は macOS/Linux 向けのパッケージマネージャです。installサブコマンドで指定したソフトウェアを公式リポジトリからダウンロードし、必要な依存関係ごとまとめてインストールします。 -

ollama

Ollama はローカル環境で LLM をダウンロード・起動・管理できる CLI ツールです。モデルの取得(pull)や実行(run)、ステータス管理をシンプルなコマンドで行えます。

2. Ollama サービスの起動

brew services start ollama

-

brew services

Homebrew の拡張コマンドで、macOS の launchd(バックグラウンドサービス)や Linux の systemd と連携し、インストール済みアプリをデーモン(常駐サービス)として管理します。 -

start ollama

Ollama のバックグラウンドデーモンを起動し、以降のモデルダウンロードや実行コマンドを待ち受ける状態にします。毎回手動で起動せずとも、macOS 起動時に自動で Ollama が立ち上がるようになります。

3. GPT-OSS モデルの実行

ollama run gpt-oss

-

ollama run

Ollama に対して「指定モデルを起動して対話インターフェースを立ち上げてほしい」と依頼するコマンドです。 -

gpt-oss

OpenAI が Hugging Face 上で公開しているオープンソース版 GPT モデル。Ollama はモデル名のみで自動的にローカルキャッシュを参照し、未取得であればリモートからダウンロードします。

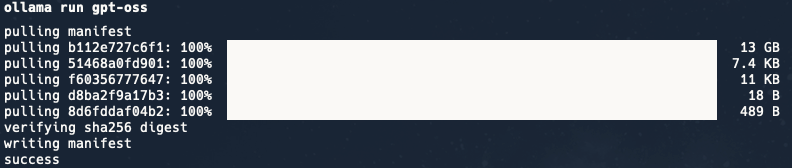

実行例:

$ ollama run gpt-oss

実際に動かしてみた結果

4. 応用・Tips

-

モデルのバージョン指定

ollama run gpt-oss:20bのようにコロン以下でサイズやバージョンを指定可能。 -

モデル一覧の確認

ollama listローカルにダウンロード済みのモデルとバージョンを一覧表示します。

-

ログの確認や停止

ollama logs gpt-oss ollama stop gpt-ossデバッグやリソース解放に便利です。

なぜローカルLLMなのか?

プライバシーとデータ保護

ローカルで推論を完結できるため、機密性の高い顧客データや社内情報を外部クラウドに送信せずに処理できます。特に医療機関や金融機関など、厳格なコンプライアンス要件がある環境で有効です

運用コストの低減

APIの従量課金(トークン単位)が不要になり、ハードウェア投資のみで推論コストを抑制できます。

カスタマイズ性と制御性

Apache 2.0ライセンスのもとモデル重みが公開されており、ファインチューニングやプラグインによる機能拡張が自由に行えます。独自データで微調整したり、企業独自のツールチェーンに統合したりできる点が大きな強みです

具体的な実践例

社内ナレッジベースQAボット

FAISSなどのベクトル検索と組み合わせ、社内ドキュメントをローカルに配置。オフラインでもFAQ応答やドキュメント要約が可能です

オフラインコードアシスタント(VSCode拡張)

gpt-ossをローカルで立ち上げ、社外秘コードの補完・リファクタリング提案を高速レスポンスで提供。APIキー不要でセキュアです

医療レポート自動要約

電子カルテや検査結果データを病院内サーバーに置き、外部送信なしで要約・翻訳。厳しい個人情報保護規制をクリアできます

エッジデバイス音声アシスタント

gpt-oss-20bをIoTデバイスに載せ、製造現場や屋外拠点でのオフライン音声操作を実現。単体の16GBデバイスで動作可能

出張先向け執筆支援ツール

ネットワークが使えない環境で、ノートアプリに組み込んでプロンプト補助や校正をローカル完結で提供

まとめ

- brew install ollama で CLI を導入

- brew services start ollama で常駐デーモンを起動

- ollama run gpt-oss でローカルモデルにアクセス

これらの手順を実行すれば、手軽にオフライン環境で LLM と対話したり、自作アプリに組み込んだりできます。

参考

Discussion